Im Zentrum jedes erfolgreichen KI -Agenten liegt eine wesentliche Fähigkeit: Aufforderung (oder „schnelle Engineering“). Es ist die Methode, LLMs zu unterrichten, um Aufgaben durch das sorgfältige Entwerfen des Eingabentextes auszuführen.

Schnelltechnik ist die Entwicklung der Eingaben für die erste Textual content-to-Textual content-NLP-Modelle (2018). Zu dieser Zeit konzentrierten sich die Entwickler in der Regel mehr auf die Modellierungsseite und das Function Engineering. Nach der Erstellung großer GPT-Modelle (2022) haben wir alle hauptsächlich vorgeborene Werkzeuge verwendet, sodass sich der Fokus auf die Eingangsformatierung verschoben hat. Daher die Disziplin „immediate Engineering“ wurde geboren und jetzt (2025) ist es zu einer Mischung aus Kunst und Wissenschaft gereift, da NLP die Grenze zwischen Code und Eingabeaufforderung verwischt.

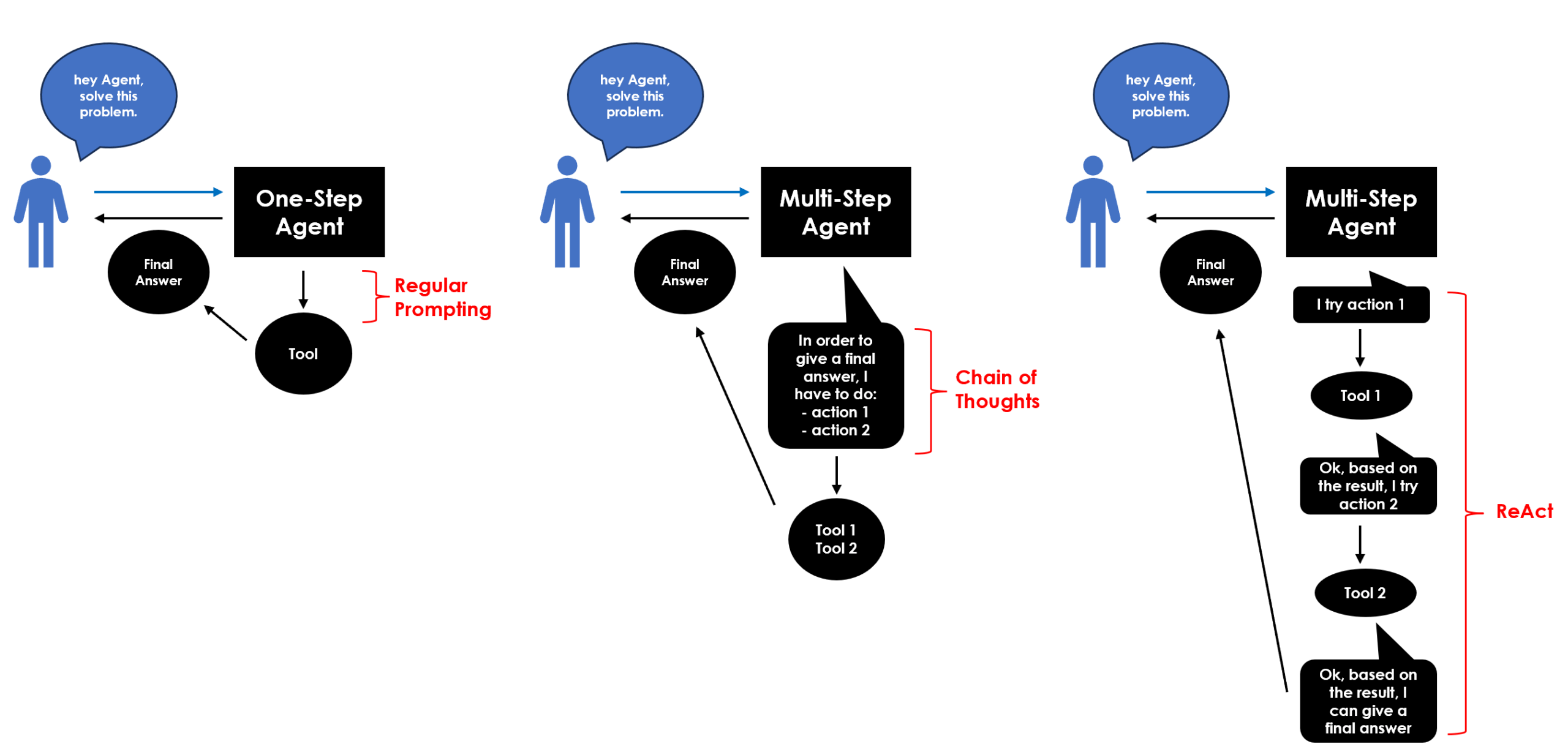

Verschiedene Arten von Anlaufstechniken erzeugen verschiedene Arten von Agenten. Jede Methode verbessert eine bestimmte Fähigkeit: Logik, Planung, Speicher, Genauigkeit und Werkzeugintegration. Lassen Sie uns alle mit einem sehr einfachen Beispiel sehen.

## setup

import ollama

llm = "qwen2.5"

## query

q = "What's 30 multiplied by 10?"Haupttechniken

1) „Reguläre “Aufforderung – Stellen Sie einfach eine Frage und erhalten Sie eine einfache Antwort. Auch als „Null-Shot“ bezeichnet, fordert es speziell, wenn dem Modell eine Aufgabe ohne vorherige Beispiele für die Lösung von Vorlagen erhalten wird. Diese grundlegende Technik ist für die Auseinandersetzung für One-Step-Agenten Dadurch wird die Aufgabe ohne Zwischenunterhalt ausgeführt, insbesondere frühe Modelle.

response = ollama.chat(mannequin=llm, messages=(

{'position':'consumer', 'content material':q}

))

print(response('message')('content material'))

2) Reagieren (Grund+Akt) – Eine Kombination aus Argumentation und Handlung. Das Modell überlegt nicht nur ein Drawback, sondern ergriffen auch Maßnahmen aufgrund seiner Argumentation. Es ist additionally interaktiver, da das Modell zwischen den Argumentationsschritten und -aktionen wechselt und seinen Ansatz iterativ verfeinert. Grundsätzlich ist es eine Schleife der Gedankenbeobachtung. Verwendet für kompliziertere Aufgabenwie die Suche im Web und das Treffen von Entscheidungen basierend auf den Ergebnis Mehrstufige Agenten Das führt eine Reihe von Argumentationsschritten und -aktionen aus, um zu einem Endergebnis zu gelangen. Sie können komplexe Aufgaben in kleinere, überschaubare Teile zerlegen, die sich schrittweise aufeinander aufbauen.

Persönlich magazine ich React -Agenten sehr, da ich sie dem Menschen ähnlicher finde, weil sie „herumfinden“ und es herausfinden “, genau wie wir.

immediate = '''

To unravel the duty, you could plan ahead to proceed in a collection of steps, in a cycle of 'Thought:', 'Motion:', and 'Commentary:' sequences.

At every step, within the 'Thought:' sequence, you need to first clarify your reasoning in the direction of fixing the duty, then the instruments that you simply wish to use.

Then within the 'Motion:' sequence, you shold use certainly one of your instruments.

Throughout every intermediate step, you need to use 'Commentary:' subject to avoid wasting no matter essential data you'll use as enter for the subsequent step.

'''

response = ollama.chat(mannequin=llm, messages=(

{'position':'consumer', 'content material':q+" "+immediate}

))

print(response('message')('content material'))

3) Gedächtniskette (COT) – Ein Argumentationsmuster, bei dem der Prozess zur Erreichung einer Schlussfolgerung erzeugt wird. Das Modell wird dazu gedrängt, „laut zu denken“, indem er explizit die logischen Schritte ausstellt, die zur endgültigen Antwort führen. Grundsätzlich ist es ein Plan ohne Suggestions. COT ist am häufigsten für verwendet für Fortgeschrittene Aufgabenwie die Lösung eines mathematischen Issues, das Schritt-für-Schritt-Argumentation benötigt und normalerweise für die Auseinandersetzung für Mehrstufige Agenten.

immediate = '''Let’s suppose step-by-step.'''

response = ollama.chat(mannequin=llm, messages=(

{'position':'consumer', 'content material':q+" "+immediate}

))

print(response('message')('content material'))

Kinderbettverlängerungen

Aus der Method stammte mehrere andere neue Ansätze.

4) Reflexion Aufforderung Dies fügt eine iterative Selbstprüfung oder Selbstkorrekturphase über dem anfänglichen COT-Argumentation hinzu, in dem das Modell seine eigenen Ausgänge überprüft und kritisiert (Erkennung von Fehlern, Identifizierung von Lücken und Verbesserungen).

cot_answer = response('message')('content material')

response = ollama.chat(mannequin=llm, messages=(

{'position':'consumer', 'content material': f'''Right here was your authentic reply:nn{cot_answer}nn

Now replicate on whether or not it was appropriate or if it was the perfect strategy.

If not, appropriate your reasoning and reply.'''}

))

print(response('message')('content material'))

5) Gedach der Gedanke (TOT) Das verallgemeinert das COT in einen Baum und untersucht mehrere Argumentationsketten gleichzeitig.

num_branches = 3

immediate = f'''

You'll consider a number of reasoning paths (thought branches). For every path, write your reasoning and ultimate reply.

After exploring {num_branches} totally different ideas, decide the perfect ultimate reply and clarify why.

'''

response = ollama.chat(mannequin=llm, messages=(

{'position':'consumer', 'content material': f"Process: {q} n{immediate}"}

))

print(response('message')('content material'))

6) Graph -Of -Gedanke (Obtained) Das verallgemeinert COT in ein Diagramm, unter Berücksichtigung auch miteinander verbundener Zweige.

class GoT:

def __init__(self, query):

self.query = query

self.nodes = {} # node_id: textual content

self.edges = () # (from_node, to_node, relation)

self.counter = 1

def add_node(self, textual content):

node_id = f"Thought{self.counter}"

self.nodes(node_id) = textual content

self.counter += 1

return node_id

def add_edge(self, from_node, to_node, relation):

self.edges.append((from_node, to_node, relation))

def present(self):

print("n--- Present Ideas ---")

for node_id, textual content in self.nodes.gadgets():

print(f"{node_id}: {textual content}n")

print("--- Connections ---")

for f, t, r in self.edges:

print(f"{f} --({r})--> {t}")

print("n")

def expand_thought(self, node_id):

immediate = f"""

You might be reasoning in regards to the job: {self.query}

Here's a earlier thought node ({node_id}):"""{self.nodes(node_id)}"""

Please present a refinement, an alternate viewpoint, or a associated thought that connects to this node.

Label your new thought clearly, and clarify its relation to the earlier one.

"""

response = ollama.chat(mannequin=llm, messages=({'position':'consumer', 'content material':immediate}))

return response('message')('content material')

## Begin Graph

g = GoT(q)

## Get preliminary thought

response = ollama.chat(mannequin=llm, messages=(

{'position':'consumer', 'content material':q}

))

n1 = g.add_node(response('message')('content material'))

## Broaden preliminary thought with some refinements

refinements = 1

for _ in vary(refinements):

enlargement = g.expand_thought(n1)

n_new = g.add_node(enlargement)

g.add_edge(n1, n_new, "enlargement")

g.present()

## Remaining Reply

immediate = f'''

Listed here are the reasoning ideas thus far:

{chr(10).be a part of((f"{ok}: {v}" for ok,v in g.nodes.gadgets()))}

Primarily based on these, choose the perfect reasoning and ultimate reply for the duty: {q}

Clarify your selection.

'''

response = ollama.chat(mannequin=llm, messages=(

{'position':'consumer', 'content material':q}

))

print(response('message')('content material'))

7) Programm -Of -Gedanke (Pot) Dies ist auf die Programmierung spezialisiert, bei denen die Argumentation über ausführbare Code -Snippets stattfindet.

import re

def extract_python_code(textual content):

match = re.search(r"```python(.*?)```", textual content, re.DOTALL)

if match:

return match.group(1).strip()

return None

def sandbox_exec(code):

## Create a minimal sandbox with security limitation

allowed_builtins = {'abs', 'min', 'max', 'pow', 'spherical'}

safe_globals = {ok: __builtins__.__dict__(ok) for ok in allowed_builtins if ok in __builtins__.__dict__}

safe_locals = {}

exec(code, safe_globals, safe_locals)

return safe_locals.get('end result', None)

immediate = '''

Write a brief Python program that calculates the reply and assigns it to a variable named 'end result'.

Return solely the code enclosed in triple backticks with 'python' (```python ... ```).

'''

response = ollama.chat(mannequin=llm, messages=(

{'position':'consumer', 'content material': f"Process: {q} n{immediate}"}

))

print(response('message')('content material'))

sandbox_exec(code=extract_python_code(textual content=response('message')('content material')))

Abschluss

Dieser Artikel conflict ein Tutorial für Zusammenfesseln Sie alle wichtigen Aufforderungstechniken für AI -Agenten. Es gibt keine einzige „beste“ Aufforderungstechnik, da sie stark von der Aufgabe und der Komplexität der erforderlichen Argumentation abhängt.

Zum Beispiel einfache Aufgaben wie Zusammenfassung und Übersetzungwerden Eassiy mit einer Null-Schuss-/regelmäßigen Aufforderung durchgeführt, während COT intestine für intestine funktioniert für Mathematik und Logik Aufgaben. Auf der anderen Seite, Agenten mit Werkzeugen werden normalerweise mit dem React -Modus erstellt. Darüber hinaus ist Reflexion am besten geeignet, wenn das Lernen aus Fehlern oder Iterationen die Ergebnisse verbessert, wie Spiele.

Bezüglich Vielseitigkeit Für komplexe Aufgaben, Pot ist der wahre Gewinner, weil er ausschließlich auf der Erzeugung und Ausführung von Code basiert. In der Tat kommen Topfagenten näher zu Menschen ersetzen In mehreren Büro -Taks.

Ich glaube, dass in naher Zukunft die Aufforderung nicht nur darum geht, „das, was Sie dem Modell sagen“, sondern eine interaktive Schleife zwischen menschlicher Absicht, Maschinenbekenntnis und externer Aktion zu orchestrieren.

Voller Code für diesen Artikel: Github

Ich hoffe es hat dir gefallen! Wenden Sie sich an mich, um mich für Fragen und Suggestions zu kontaktieren oder einfach Ihre interessanten Projekte zu teilen.

👉 Lassen Sie uns eine Verbindung herstellen 👈

(Alle Bilder stammen vom Autor, sofern nicht anders notiert)