IBM -Forscher haben zusammen mit ETH Zürich eine neue Klasse von enthüllt Analog Basis -Modelle (AFMs) Entwickelt, um die Lücke zwischen großen Sprachmodellen (LLMs) und) und zu überbrücken Analog In-Reminiscence Computing (AIMC) {Hardware}. AIMC hat seit langem einen radikalen Effizienzsprung versprochen-modellige Modelle mit einer Milliarde Parametern in einem Fußabdruck, der für eingebettete oder Kantengeräte klein genug ist-droht den dichten nichtflüchtigen Speicher (NVM), der Speicher und Berechnung kombiniert. Die Achilles-Ferse der Technologie warfare jedoch Rauschen: Die Durchführung von Matrixvektor-Multiplikationen direkt in NVM-Geräten ergibt nicht deterministische Fehler, die off-the-Shelf-Modelle verkrüppelten.

Warum ist analoges Laptop für LLMs von Bedeutung?

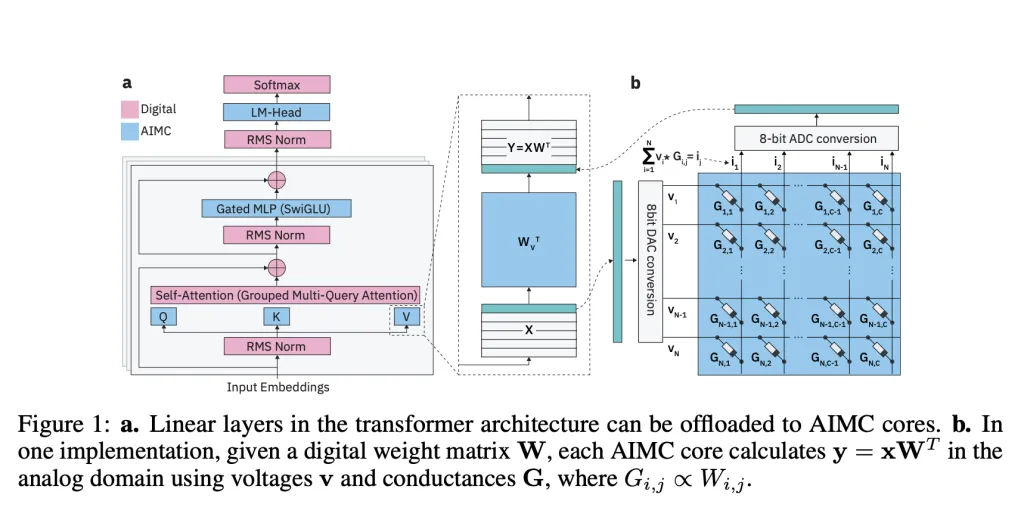

Im Gegensatz zu GPUs oder TPUs, die Daten zwischen Speicher- und Berechnungseinheiten übertragen, führt AIMC Matrix-Vektor-Multiplikationen direkt in Speicherarrays durch. Dieses Design beseitigt den von Neumann -Engpass und liefert large Verbesserungen des Durchsatz- und Stromversorgungseffizienz. Frühere Studien zeigten, dass das Kombinieren von AIMC mit 3D NVM Und Expertenmischung (MOE) Architekturen könnten grundsätzlich Billionen-Parameter-Modelle für Kompaktbeschleuniger unterstützen. Dies könnte die KI von Basis-Scale-KI für Geräte weit über die Datenzentren übereinstimmen.

Was macht aus Analoges In-Reminiscence-Computing (AIMC) in der Praxis so schwer zu verwenden?

Die größte Barriere ist Lärm. AIMC -Berechnungen leiden unter Variabilität der Geräte, DAC/ADC -Quantisierung und Laufzeitschwankungen, die die Modellgenauigkeit abbauen. Im Gegensatz zur Quantisierung von GPUs – wo Fehler deterministisch und überschaubar sind – ist ein Alalog -Rauschen stochastisch und unvorhersehbar. Frühere Untersuchungen fanden Möglichkeiten, kleine Netzwerke wie CNNs und RNNs (<100m -Parameter) anzupassen, um ein solches Rauschen zu tolerieren, aber LLMs mit Milliarden von Parametern brachen konsistent unter AIMC -Einschränkungen ab.

Wie befassen sich analoge Fundamentmodelle mit dem Rauschproblem?

Das IBM -Group führt vor Analoge Fundamentmodelledie {Hardware}-bewusstes Coaching integrieren, um LLMs für die analoge Ausführung vorzubereiten. Ihre Pipeline verwendet:

- Geräuschinjektion Während des Trainings zur Simulation von AIMC -Zufälligkeit.

- Iteratives Gewichtsausschnitt Verteilungen innerhalb von Gerätegrenzen zu stabilisieren.

- Gelernte statische Eingangs-/Ausgangsquantisierungsbereiche ausgerichtet mit echten {Hardware} -Einschränkungen.

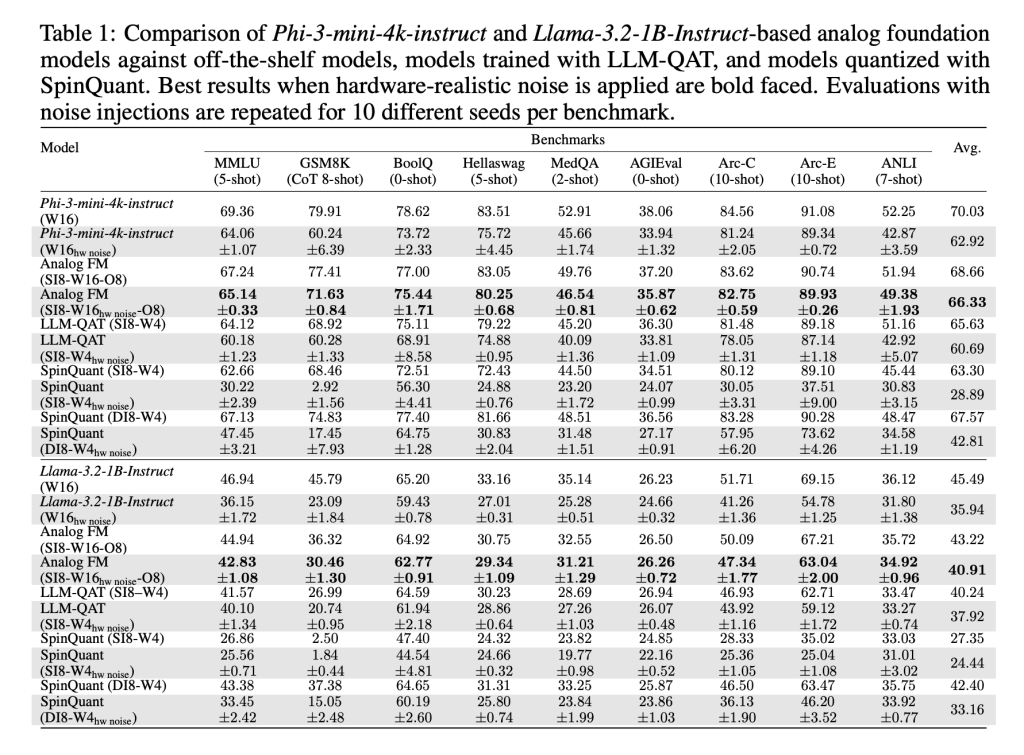

- Destillation von vorgeborenen LLMs Verwendung von 20B -Token von synthetischen Daten.

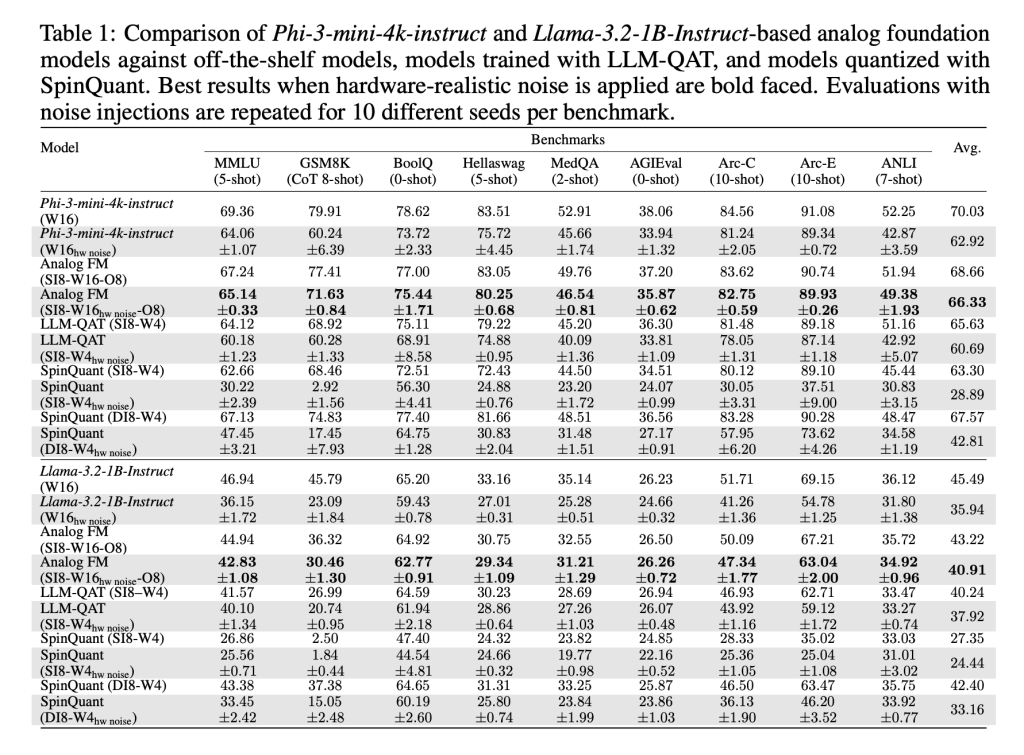

Diese Methoden, implementiert mit Aihwkit leuchtenderlauben Modelle wie PHI-3-Mini-4K-Instruktur Und LAMA-3.2-1B-ISTRUCT aufrechterhalten Leistung vergleichbar mit gewichtsquantisierter 4-Bit / Aktivierung 8-Bit-Basislinien unter analogem Rauschen. Bei Bewertungen über Argumentation und sachliche Benchmarks übertraf AFMs sowohl das quantisierungsbewusste Coaching (QAT) als auch die Quantisierung nach dem Coaching (Spinquant).

Funktionieren diese Modelle nur für analoge {Hardware}?

Nein. Ein unerwartetes Ergebnis ist, dass AFMs auch stark abschneiden Digitale {Hardware} mit niedriger Präzision. Da AFMs geschult sind, um Geräusche und Ausschnitte zu tolerieren, verarbeiten sie eine einfache Quantisierung nach dem Coaching mit rund-zu-nearsten (RTN) besser als vorhandene Methoden. Dies macht sie nicht nur für AIMC -Beschleuniger, sondern auch für {Hardware} für digitale Inferenz von Rohstoffen nützlich.

Kann Leistungsleistung mit mehr Berechnung zum Inferenzzeit skalieren?

Ja. Die Forscher getestet TEST-Zeit-Berechnungskalierung Im Math-500-Benchmark generieren Sie mehrere Antworten professional Abfrage und wählen Sie das Beste über ein Belohnungsmodell aus. AFMs zeigten ein besseres Skalierungsverhalten als QAT -Modelle, wobei Genauigkeitslücken schrumpfen, da mehr Inferenzberechnung zugewiesen wurde. Dies steht im Einklang mit den Stärken von AIMC-einer Low-Energy-Inferenz mit hohem Durchsatz und nicht dem Coaching.

Wie wirkt es sich auf die Zukunft der analogen In-Reminiscence Computing (AIMC) aus?

Das Forschungsteam bietet die erste systematische Demonstration, dass große LLMs ohne katastrophalen Genauigkeitsverlust an AIMC -{Hardware} angepasst werden können. Während das Coaching von AFMs ressourcenlastig ist und die Überlegungsaufgaben wie GSM8K immer noch Genauigkeitslücken zeigen, sind die Ergebnisse ein Meilenstein. Die Kombination von Energieeffizienz, Robustheit gegenüber Rauschen und Kreuzkompatibilität mit digitaler {Hardware} macht AFMs zu einer vielversprechenden Richtung für skalierende Fundamentmodelle jenseits der GPU -Grenzen.

Zusammenfassung

Die Einführung von analogen Grundmodellen ist ein kritischer Meilenstein für die Skalierung von LLMs über die Grenzen digitaler Beschleuniger hinaus. Indem das Forschungsteam die Modelle für das unvorhersehbare Rauschen des analogen In-Reminiscence-Computing sturdy machen, zeigt es, dass AIMC von einem theoretischen Versprechen auf eine praktische Plattform wechseln kann. Während die Schulungskosten hoch bleiben und die Benchmarks der Begründung weiterhin Lücken aufweisen, schafft diese Arbeit einen Weg zu energieeffizienten großen Modellen, die auf kompakten {Hardware} laufen

Schauen Sie sich das an PAPIER Und Github -Seite. Fühlen Sie sich frei, unsere zu überprüfen Github -Seite für Tutorials, Codes und Notizbücher. Fühlen Sie sich auch frei, uns zu folgen Twitter Und vergessen Sie nicht, sich unserer anzuschließen 100k+ ml Subreddit und abonnieren Unser Publication.

Asif Razzaq ist der CEO von Marktechpost Media Inc. Sein jüngstes Bestreben ist die Einführung einer Medienplattform für künstliche Intelligenz, Marktechpost, die sich durch die ausführliche Berichterstattung über maschinelles Lernen und Deep-Studying-Nachrichten auszeichnet, die von einem breiten Publikum technisch intestine und leicht verständlich sind. Die Plattform verfügt über über 2 Millionen monatliche Ansichten und veranschaulicht ihre Beliebtheit des Publikums.