Während sich das Gebiet der künstlichen Intelligenz verändert und sich weiterentwickelt, haben sich die Datensätze des großen Sprachmodells (LLM) als das Fundament der Transformationsingovation herausgestellt. Unabhängig davon, ob Sie feinabstimmende GPT-Modelle, den Aufbau domänenspezifischer KI-Assistenten oder die Durchführung detaillierter Forschung, Qualitätsdatensätze können der Unterschied zwischen Erfolg und Misserfolg sein. Heute werden wir tief in eine der robustesten Repositorys von Github von LLM-Datensätzen eintauchen, die die Artwork und Weise verändert, wie Entwickler über Coaching und Feinabstimmung nachdenken.

Warum ist die Datenqualität mehr denn je wichtig?

Die KI -Group hat eine wichtige Lektion gelernt: Daten sind das neue Gold. Wenn Rechenleistung und Modellarchitekturen sind die auffälligen Schlagzeilen, dann bestimmen die Trainings- und Feinabstimmungsdatensätze die reale Leistung Ihrer KI-Systeme. Daten, die nicht von guter Qualität sind, führen zu Halluzinationen, voreingenommenen Ausgängen und unregelmäßigem Modellverhalten. Dies führt wiederum zur vollständigen Entgleisung eines gesamten Projekts.

Der Mlabonne/LLM-Datensätze Repository ist zum wichtigsten Ziel für Entwickler geworden, die nach normalisierten, qualitativ hochwertigen Datensätzen für die Verwendung in nicht trinkeren Anwendungen suchen. Dies ist nicht nur ein weiteres Beispiel für eine zufällige Sammlung von Datensätzen. Dies ist eine sorgfältig kuratierte Bibliothek, in der drei wichtige Funktionen hergestellt werden, die gute Datensätze von großartigen unterscheiden.

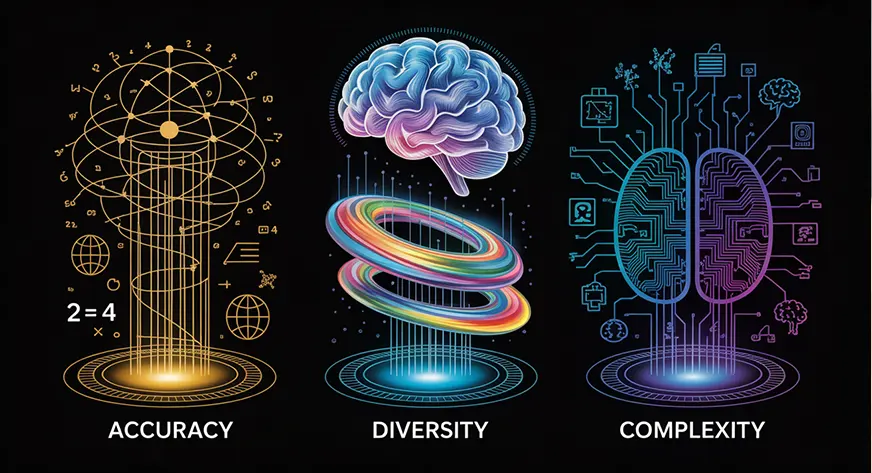

Die drei außergewöhnlichen Säulen von LLM -Datensätzen

Genauigkeit: Die Grundlage für vertrauenswürdige KI

Jedes Beispiel in einem hochwertigen Datensatz muss sachlich korrekt sein und sich auf die entsprechende Anweisung beziehen. Dies bedeutet, dass wertvolle Validierungs-Workflows wie einen mathematischen Löser für numerische Probleme oder Unit-Assessments für einen codebasierten Datensatz vorhanden sind. Es spielt keine Rolle, wie komplex die Modellarchitektur ist. Ohne Genauigkeit wird die Ausgabe immer irreführend sein.

Vielfalt: Das Spektrum des menschlichen Wissens

Ein wirklich nützlicher Datensatz verfügt über eine breite Palette von Anwendungsfällen, sodass Ihr Modell nicht in Situationen außerhalb der Verteilung trifft. Ein vielfältiger Datensatz bietet eine bessere Verallgemeinerung, mit der Ihre KI -Systeme unerwartete Abfragen besser umgehen können. Dies ist besonders für allgemeine Sprachmodelle related, die in verschiedenen Bereichen intestine abschneiden sollten.

Komplexität: Über einfache Frage-Antwortenpaarungen hinaus

Zu den modernen Datensätzen gehören komplexe Argumentationstechniken, wie z. B. Aufforderungstrategien, bei denen Modelle ein schrittweise Argumentation und Erläuterungen mit Rechtfertigungen durchführen müssen. Diese Komplexität ist in menschlichen AIs erforderlich, die für nuancierte reale Situationen erforderlich sind.

Prime LLM -Datensätze für verschiedene Kategorien

Allgemeine Kraftkraftwerke

Das Repository enthält einige bemerkenswerte allgemeine Datensätze, die ausgewogene Kombinationen aus Chat, Code und mathematischen Argumentation enthalten:

- Unendlichkeitsstruktur (7,45 m Proben): Es ist der Goldstandard für aktuell entwickelte hochwertige Proben, die erzeugt werden. Baai erstellte den Datensatz im August 2024 aus einem Open-Supply-Datensatz mit erweiterten Evolutionstechniken, um fortschrittliche Trainingsproben zu erstellen.

Hyperlink: https://huggingface.co/datasets/baai/infinity-instruct - WebInstructSub (2,39 m Proben): Dieser Datensatz erfasst die Essenz eines Datensatzes eindeutig. Es wird Dokumente aus allgemeinem Crawl abgerufen, das Dokument durchsucht, um Fragen-Antwort-Paare zu extrahieren, und erstellt anspruchsvolle Verarbeitungspipelines, um sie zu verarbeiten. Der Datensatz, der in der Mammoth2-Veröffentlichung befindet, zeigt, wie Webmaßstabsdaten in hochwertigen Schulungsbeispielen erstellt werden.

Hyperlink: https://huggingface.co/datasets/chargoddard/WebinStructSub-Prometheus - Das Tome (1,75 m Proben): Es wurde von Arcee AI erstellt und betont den Anweisungen. Es ist für seine umgeleiteten und gefilterten Sammlungen bekannt, die durch den Benutzer eindeutig die Anweisungen hervorrufen. Dies ist sehr wichtig für Produktions -KI -Systeme.

Hyperlink: https://huggingface.co/datasets/arcee-ai/the-tome

Mathematisches Denken: Logik hinter dem Drawback lösen

Mathematisches Denken ist nach wie vor einer der schwierigsten Bereiche für Sprachmodelle. Für diese Kategorie haben wir einige gezielte Datensätze, um dieses kritische Drawback zu bekämpfen:

- OpenMathinstruct-2 (14m Proben): Es verwendet Lama-3.1-405B-Instruction, um erweiterte Proben aus etablierten Benchmarks wie GSM8K und Mathematik zu erstellen. Dieser Datensatz, der im September 2024 von NVIDIA veröffentlicht wurde, stellt die hochmodernste Mathematik-AI-Trainingsdaten dar.

Hyperlink: https://huggingface.co/datasets/nvidia/openmathinstruct-2 - Numinamath-Cot (859K-Proben): Es wurde als Gewinner des ersten Fortschrittspreises der AI Math Olympiade angetrieben. Es markierte das Denken der Kette des Denkens und lieferte Werkzeug-integrierte Argumentationsversionen im Datensatz für Anwendungsfälle, die ein größeres Problemlösungspotential haben.

Hyperlink: https://huggingface.co/datasets/ai-mo/numinamath-cot - Metamathqa (395K -Proben): Es conflict neuartig, als es mathematische Fragen aus mehreren Perspektiven umschrieben, um verschiedene Trainingsbedingungen für eine größere Modellrobustheit in mathematischen Domänen zu schaffen.

Hyperlink: https://huggingface.co/datasets/meta-math/metamathqa

Codegenerierung: Überbrückung von KI und Softwareentwicklung

Der Programmierbereich benötigt spezielle Datensätze, die Aspekte der Syntax, Logik und Finest Practices in verschiedenen Programmiersprachen verstehen:

Erweiterte Funktionen: Funktionsaufruf und Agentenverhalten

Für die Entwicklung moderner Anwendungen mit KI besteht ein Bedarf an komplexen Funktionen für Funktionen, und der Benutzer muss auch eine agentenähnliche Disposition aufweisen.

Konversationsdaten in realer Welt: Lernen aus menschlicher Interaktion lernen

Ansprechend erstellen AI -AssistentenEs ist wichtig, natürliche menschliche Kommunikationsmuster zu erfassen:

- Wildchat-1M (1,04 m Proben): Es probiert Actual Conversations-Benutzer mit fortgeschrittenen Sprachmodellen wie GPT-3.5 und GPT-4, die authentische Interaktionen zeigen und letztendlich die tatsächlichen Nutzungsmuster und -erwartungen belegen.

Hyperlink: https://huggingface.co/datasets/allenai/wildchat-1m - LMSYS-CHAT-1M: Es verfolgt Gespräche mit 25 einzigartigen Sprachmodellen, die aus über 210.000 eindeutigen IP-Adressen gesammelt wurden, und ist eines der größten Datensätze für die reale Konversation.

Hyperlink: https://huggingface.co/datasets/lmsys/lmsys-chat-1m

Präferenzausrichtung: KI lehrt, dass sie menschliche Werte entsprechen

Präferenzausrichtungsdatensätze sind mehr als nur Anweisungen, um sicherzustellen, dass KI-Systeme Werte und Vorlieben ausgerichtet haben:

Das GitHub -Repository bietet nicht nur LLM -Datensätze, sondern auch einen vollständigen Satz von Instruments für die Erzeugung, Filterung und Erkundung von Datensätzen:

Datenerzeugungswerkzeuge

- Kurator: Vereinfacht die Erzeugung der synthetischen Daten mit hervorragender Stapelunterstützung

- Distilabel: Vollständige Toolset zum Generieren sowohl des Supervisors Full Hint (SFT) als auch zum DPO -Daten (Knowledge Supplier Beobachtung)

- Augmentoolkit: Konvertiert unstrukturierten Textual content mit mehreren Modelltypen in unterschiedliche strukturierte Datensätze

Qualitätskontrolle und Filterung

- Argilla: Kollaborativer Bereich zur Durchführung einer manuellen Datensatzfilterung und Datenanmerkungen

- Semhash: Führt Antipattern Fuzzy -Deduplizierung unter Verwendung von Modellbettendings durch, die größtenteils destilliert wurden

- Richter: LLM -Richterbibliothek für vollständig automatisierte Qualitätsprüfungen

Datenerforschung und -analyse

- Lila: Ein sehr reichhaltiges Device zur Erkundung und Qualitätssicherung

- Nomischer Atlas: Eine Softwareanwendung, die das Wissen aktiv aus Unterrichtsdaten entdeckt.

- Textklustering: Framework zum Clustering von Textdaten auf sinnvolle Weise.

Finest Practices für die Auswahl und Implementierung von Datensätzen

Behalten Sie diese strategischen Perspektiven bei der Auswahl von Datensätzen im Auge:

- Es ist eine gute Praxis, allgemeine Datensätze wie Infinity-Instruct oder The-Tome zu erkunden, die eine gute Modellstiftung mit breiter Abdeckung und zuverlässige Leistung bei mehreren Aufgaben bieten.

- Schichten Sie auf spezialisierten Datensätzen relativ zu Ihrem Anwendungsfall. Wenn Ihr Prototyp beispielsweise mathematisches Denken erfordert, enthält Datensätze wie Numinamath-Cot. Wenn sich Ihr Modell auf die Codegenerierung konzentriert, sollten Sie sich möglicherweise gründlich getestete Datensätze wie getestet-143K-Python-Alpaca ansehen.

- Wenn Sie benutzergerichtete Anwendungen erstellen, vergessen Sie nicht Präferenzausrichtungsdaten. Datensätze wie Skywork-Reward-Präferenz stellen sicher, dass sich Ihre KI-Systeme so verhalten, dass die Erwartungen und Werte der Benutzer übereinstimmen.

- Verwenden Sie die von uns bereitgestellten Qualitätssicherungsinstrumente. Die Betonung der in diesem Repository beschriebenen Genauigkeit, Vielfalt und Komplexität wird durch Instruments unterstützt, mit denen Sie diese Requirements in Ihren eigenen Datensätzen aufrechterhalten können.

Abschluss

Bereit, diese erstaunlichen Datensätze für Ihr Projekt zu verwenden? So können Sie anfangen;

- Gehen Sie zum Repository unter github.com/mlabonne/llm-datasets und finden Sie alle verfügbaren Ressourcen

- Überlegen Sie, was Sie benötigen, basierend auf Ihrer Bewerbung (Allgemeinzweck, Mathematik, Codierung usw.)

- Wählen Sie Datensätze aus, die Ihren Anforderungen und Benchmarks für die Qualitätsfallqualität entsprechen

- Verwenden Sie die Instruments, die wir zur Filterung der Datensätze und zur Sicherheitsversicherung empfohlen haben

- Fügen Sie der Datensatzfamilie zurück, indem Sie Verbesserungen oder neue Datensätze teilen

Wir leben in unglaublichen Zeiten für KI. Das Tempo des Fortschritts der KI beschleunigt sich, aber für den Erfolg ist es immer noch wichtig, großartige Datensätze zu haben, die intestine kuratiert sind. Die Datensätze in diesem Github-Repository haben alles, was Sie benötigen, um leistungsstarke LLMs zu erstellen, die auch fähig, genau und menschlich zentriert sind.

Melden Sie sich an, um weiter zu lesen und Experten-Kuratinhalte zu genießen.