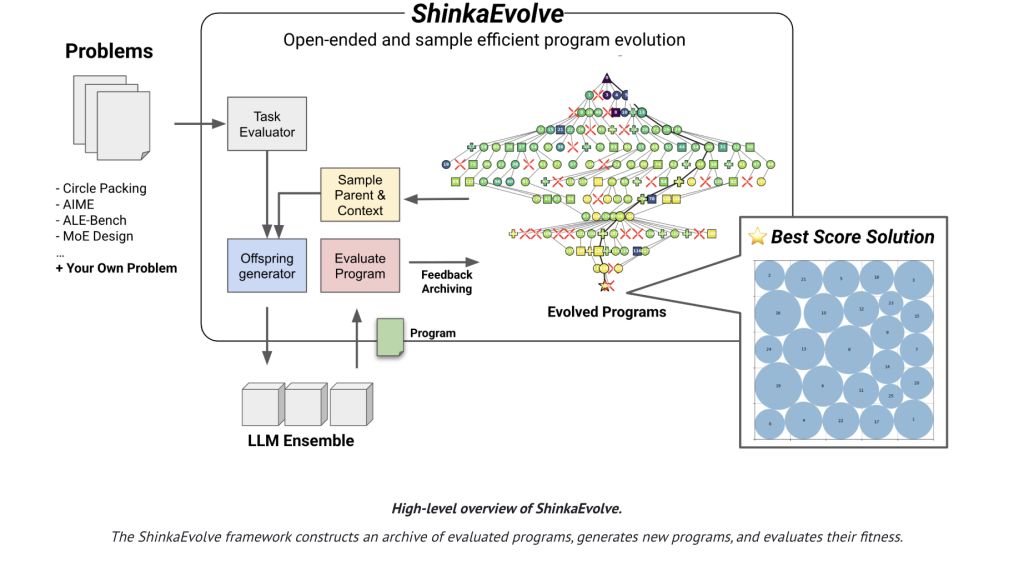

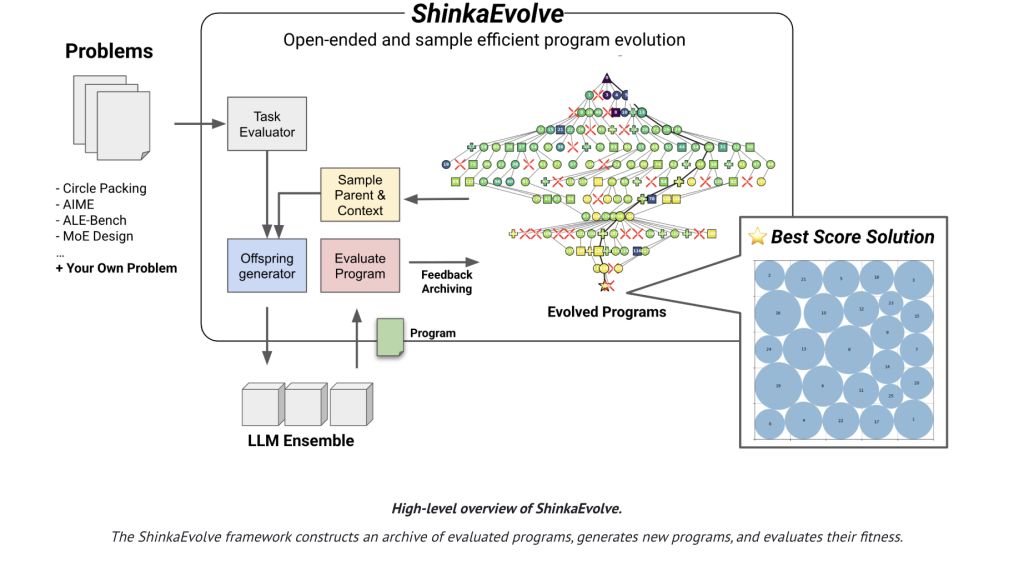

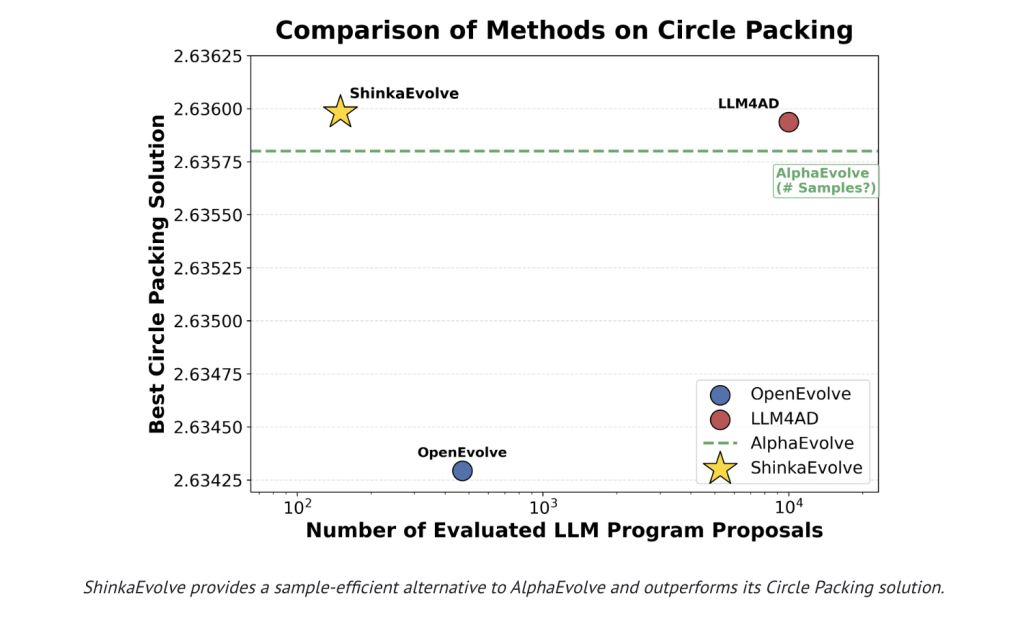

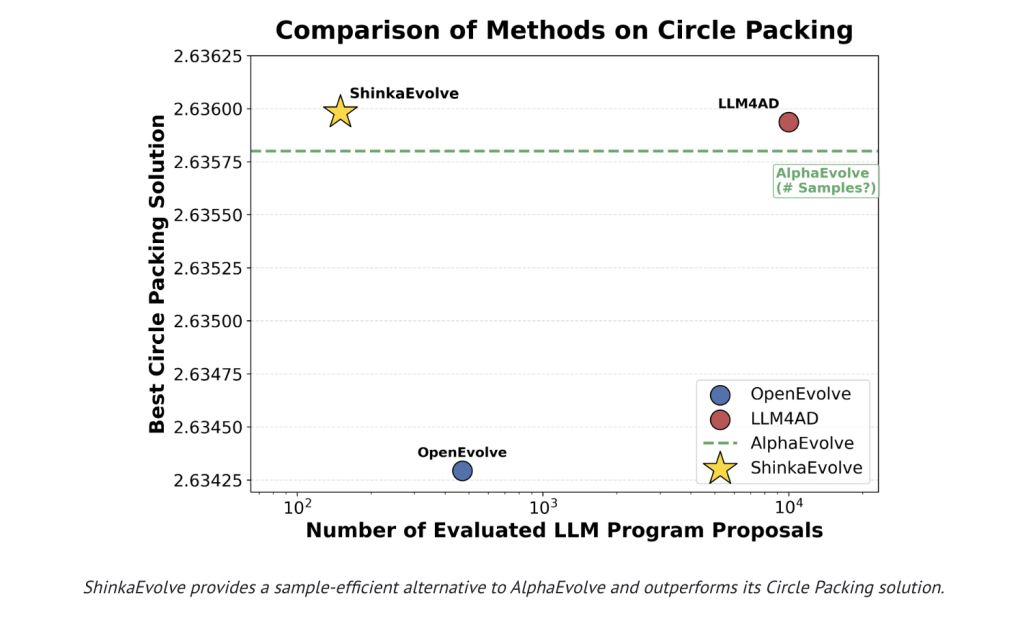

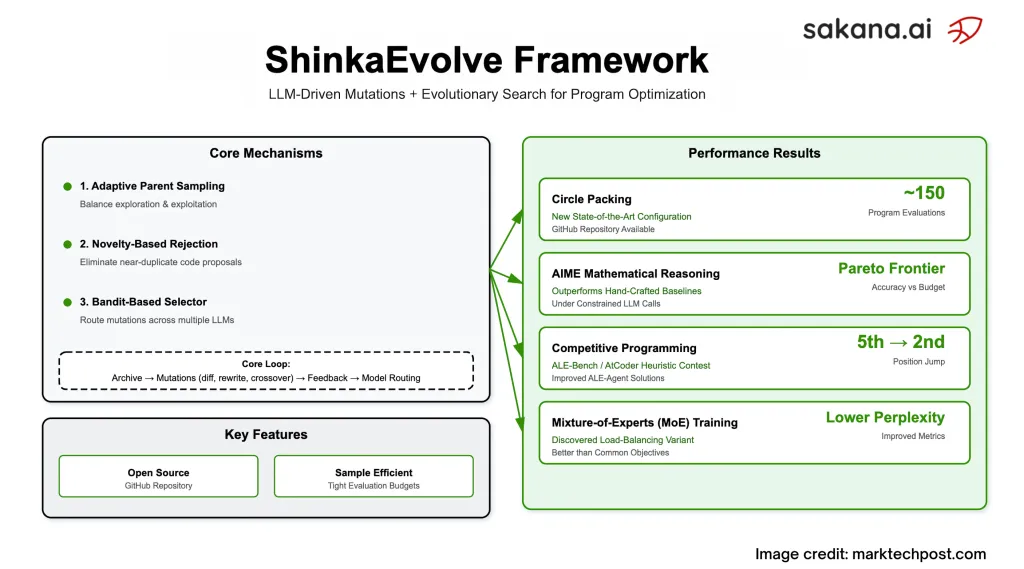

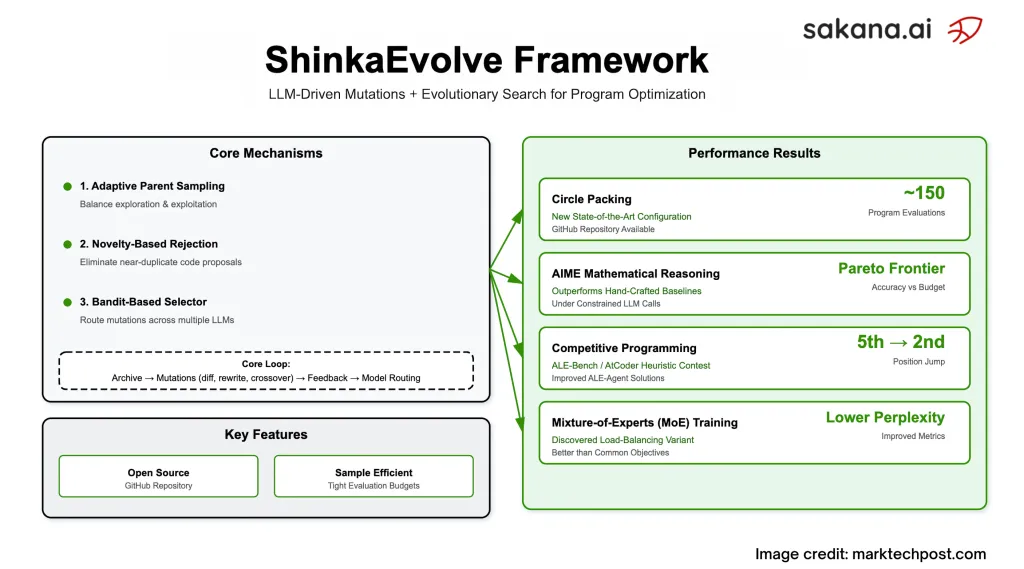

Sakana Ai hat veröffentlicht Shinkaevolveein Open-Sourcing Programme entwickeln Bei wissenschaftlichen und technischen Problemen, die die Anzahl der zur Erreichung starken Lösungen erforderlichen Bewertungen drastisch reduzieren. Auf der Kanonisch Kreisverpackung Benchmark (n = 26 in einem Einheitsquadrat), Shinkaevolve meldet eine neue SOTA -Konfiguration mithilfe ~ 150 Programmbewertungenwo frühere Systeme normalerweise verbrannt wurden Tausende. Das Projekt schifft unter Apache-2.0mit einem Forschungsbericht und einem öffentlichen Kodex.

Welches Drawback löst es tatsächlich?

Die meisten „Agenten“ -Codes-Evolution-Systeme untersuchen durch Brute Drive: Sie mutieren Code, führen ihn aus, bewerten Sie es und wiederholen Sie-konsumieren Sie enorme Stichprobenbudgets. Shinkaevolve -Ziele, die explizit mit verschwenden Drei interagierende Komponenten:

- Anpassungsfähige übergeordnete Abtastung Exploration/Ausbeutung ausgleichen. Die Eltern stammen aus „Inseln“ über Health- und Neuheitspolitik (Machtgesetz oder gewichtet von Leistung und Nachkommen), anstatt immer auf das aktuelle Beste zu klettern.

- Neuheit basierende Ablehnungsfilterung Um zu vermeiden, dass Close to-Duplikate neu bewertet werden. Mutable Code -Segmente sind eingebettet; Wenn die Ähnlichkeit der Cosinus einen Schwellenwert überschreitet, dient eine sekundäre LLM vor der Ausführung als „Neuheitsrichter“.

- Bandit-basierte LLM-Ensembling Das System lernt additionally, welches Modell (z. relativ Health springt und leitet zukünftige Mutationen entsprechend (UCB1-Replace zur Verbesserung gegenüber Eltern/Basislinie).

Geht der Probeneffizienzanspruch über Spielzeugprobleme hinaus?

Das Forschungsteam bewertet vier verschiedene Domänen und zeigt konsistente Gewinne mit kleinen Budgets:

- Kreisverpackung (n = 26): erreicht eine verbesserte Konfiguration in ungefähr 150 Bewertungen; Das Forschungsteam bestätigt auch eine strengere Überprüfung der exakten Bekämpfung.

- Aime Mathematik (2024 Set): entwickelt sich Agentengerüste das verfolgt a Pareto Frontier (Genauigkeit gegen LLM-Name-Price range), übertriffende handgefertigte Baselines unter begrenzten Abfragenbudgets / Pareto-Grenze der Genauigkeit im Vergleich zu Anrufen und Übertragung in andere Aime-Jahre und LLMs.

- Wettbewerbsprogrammierung (Ale-Bench Lite): Ausgehend von Ale-Agent Lösungen, Shinkaevolve liefert ~ 2,3% mittlere Verbesserung über 10 Aufgaben hinweg und schieben die Lösung einer Aufgabe aus 5. → 2. in einem Atcoder -Rangliste kontrafaktisch.

- LLM-Coaching (Expertenmischung): entwickelt a Neuer Verlust des Ladungsausgleichs Dies verbessert die Verwirrung und die nachgelagerte Genauigkeit bei mehreren Regularisierungsstärken im Vergleich zur weit verbreiteten globalen LBL.

Wie sieht die Evolutionsschleife in der Praxis aus?

Shinkaevolve unterhält eine Archiv von bewerteten Programmen mit Health, öffentlichen Metriken und Textfeedback. Für jede Era: Probieren Sie eine Insel und Eltern; Erstellen Sie einen Mutationskontext mit High-Ok- und zufälligen „Inspirations“ -Programmen; Schlagen Sie dann Änderungen über drei Operatoren vor –Diff -ÄnderungenAnwesend Vollständige UmschreibenUnd LLM-geführte Kreuzungen– Schutz unveränderlicher Coderegionen mit expliziten Markern. Ausgeführte Kandidaten aktualisieren sowohl das Archiv als auch das Banditstatistik Das steuert die nachfolgende LLM/Modellauswahl. Das System erzeugt regelmäßig a Meta-Scratchpad Dies fasst kürzlich erfolgreiche Strategien zusammen; Diese Zusammenfassungen werden in die Aufforderung, spätere Generationen zu beschleunigen, zurückversetzt.

Was sind die konkreten Ergebnisse?

- Kreisverpackung: kombiniert Strukturierte Initialisierung (z. B. Golden-Winkelmuster), Hybrid World -Lokal -Suche (simuliertes Glühen + SLSQP) und Fluchtmechanismen (Temperaturerwärmung, Ringrotationen), die vom System entdeckt wurden-nicht von Hand codiert a priori.

- Aime -Gerüste: Dreistufiges Experten-Ensemble (Era → Kritische Peer-Assessment → Synthese), die die Genauigkeit/Kosten bei ~ 7 Aufrufen trifft und gleichzeitig Robustheit beibehält, wenn sie auf verschiedene LLM-Backends ausgetauscht werden.

- Ale-Bench: Zieltechnische Gewinne (z. B., z. Ausschnitt KD-Tree-Substree-Statistiken; „Zielgeschwindige Randbewegungen“ zu falsch klassifizierten Elementen), die die Ergebnisse ohne Umschreibungen des Großhandels verschieben.

- MOE -Verlust: fügt dem globalen Batch-Ziel eine entropie modulierte Strafe hinzu; Reduziert empirisch Miss-Routing und verbessert Verwirrung/Benchmarks als Schichtrouting-Konzentrate.

Wie ist dies im Vergleich zu Alphaevolve und verwandten Systemen?

Alphaevolve zeigte starke Ergebnisse mit geschlossenen Supply, jedoch bei höheren Bewertungszählungen. Shinkaevolve reproduziert und übertrifft Das Kreisverpackungsergebnis mit Anordnungen weniger Proben und gibt alle Komponenten frei Open-Supply. Das Forschungsteam kontrastieren auch Varianten (Single-Mannequin vs. Fastened Ensemble Vs. Banditensemble) und ablieren Elternauswahl Und Neuheit Filterungund zeigt, dass jeder zur beobachteten Effizienz beiträgt.

Zusammenfassung

Shinkaevolve ist ein Apache-2.0 Rahmen für LLM-gesteuerte Programmentwicklung das schneidet die Bewertungen aus Tausende Zu Hunderte durch Kombination Health/neuheitspunkte übergeordnete StichprobeAnwesend Einbettungspluse-llm Neuheit Ablehnungund a Adaptives LLM-Ensemble im UCB1-Stil. Es legt a Neues Sota An Kreisverpackung (~ 150 Evals), findet stärker Aime Gerüste unter strengen Abfragebudgets, verbessert sich Ale-Bench Lösungen (~ 2,3% mittlere Verstärkung, 5. → 2. auf einer Aufgabe) und entdeckt a neuer MOE-Ladungsausgleichsverlust Das verbessert Verwirrung und nachgelagerte Genauigkeit. Code und Bericht sind öffentlich.

FAQs – Shinkaevolve

1) Was ist Shinkaevolve?

Ein Open-Supply-Framework, das LLM-gesteuerte Programmmutationen mit evolutionärer Suche zur Automatisierung der Algorithmus-Entdeckung und -Optimierung. Code und Bericht sind öffentlich.

2) Wie erreicht es eine höhere Probeneffizienz als frühere Evolutionssysteme?

Drei Mechanismen: Adaptive übergeordnete Stichproben (Discover/Exploit-Gleichgewicht), neuheitsbasierte Ablehnung zur Vermeidung doppelter Bewertungen und ein Bandit-basierter Selektor, der Mutationen an die vielversprechendsten LLM leitet.

3) Was unterstützt die Ergebnisse?

Es erreicht ein hochmodernes Kreisverpackung mit ~ 150 Bewertungen; Auf Aime-2024 entwickelt es Gerüste unter einer 10-Quer-Obergrenze professional Drawback; Es verbessert Ale-Bench-Lösungen über starke Baselines.

4) Wo kann ich es ausführen und wie lautet die Lizenz?

Das GitHub Repo bietet ein Webui und Beispiele. Shinkaevolve wird unter Apache-2.0 veröffentlicht.

Schauen Sie sich das an Technische ParticularsAnwesend Papier Und Github -Seite. Fühlen Sie sich frei, unsere zu überprüfen Github -Seite für Tutorials, Codes und Notizbücher. Fühlen Sie sich auch frei, uns zu folgen Twitter Und vergessen Sie nicht, sich unserer anzuschließen 100k+ ml Subreddit und abonnieren Unser E-newsletter.

Asif Razzaq ist der CEO von Marktechpost Media Inc. Sein jüngstes Bestreben ist die Einführung einer Medienplattform für künstliche Intelligenz, Marktechpost, die sich durch die ausführliche Berichterstattung über maschinelles Lernen und Deep-Studying-Nachrichten auszeichnet, die von einem breiten Publikum technisch intestine und leicht verständlich sind. Die Plattform verfügt über über 2 Millionen monatliche Ansichten und veranschaulicht ihre Beliebtheit des Publikums.