In letzter Zeit habe ich mich gefragt, ob ich wirklich noch kostenpflichtige Abonnements für ChatGPT oder Claude benötige. China hat ein beeindruckendes LLM nach dem anderen eingeführt, und das neueste, GLM 4.6, wird als eines der bisher besten gefeiert. Dieses Modell konkurriert Claude 4,5 Sonett in Codierung und Übereinstimmungen GPT-5 Und Gemini 2.5 Professional in der Texterstellung und Argumentation. Und hier ist der Clou: Während die großen Technologieanbieter für ähnliche Funktionen zwischen 10 und 30 US-Greenback professional Monat verlangen, haben Sie mit GLM 4.6 kostenlosen Zugriff auf alles. In diesem Beitrag befassen wir uns mit GLM 4.6, dem Zugriff darauf, seinen Funktionen, Leistungsbenchmarks und einem praktischen Check an realen Aufgaben.

Beginnen wir mit GLM 4.6!

Was ist GLM 4.6?

GLM 4.6 wurde von der chinesischen Firma Zhipu AI entwickelt und ist das neueste große Sprachmodell und ein Improve gegenüber seinem Vorgänger GLM 4.5. Es handelt sich um ein Textgenerierungsmodell, das ausschließlich mit Textual content als Eingabe und Ausgabe arbeitet. Das Modell umfasst verbesserte Codierungs-, Argumentations- und Agentenfunktionen, die es ihm ermöglichen, aus dem Satz verfügbarer Instruments proaktiv das richtige Device für eine bestimmte Aufgabe auszuwählen.

Hauptmerkmale von GLM 4.6

- Erweitertes Kontextfenster: GLM 4.6 verfügt über ein Kontextfenster von 200.000 Token, was deutlich größer ist als das 128.000-Fenster von GLM 4.5.

- Besseres Denken und bessere Agentenfähigkeiten: Das Modell zeigt eine verbesserte Argumentation und Agentenleistung. Es lässt sich reibungslos in Agenten-Frameworks integrieren und liefert konsistentere, zuverlässigere Ausgaben.

- Bessere Codierung: GLM 4.6 schneidet bei Codierungs-Benchmarks außergewöhnlich intestine ab und lässt sich effektiv in Instruments wie integrieren Claude CodeCline und Kilo-Code.

Das Beste daran?

Die Gewichte des GLM 4.6-Modells sind auf Hugging Face unter der MIT-Lizenz öffentlich verfügbar, was es zu einem Open-Entry-Modell macht. Tatsächlich liegt es derzeit auf Platz 1 unter den offenen Modellen und auf Platz 4 insgesamt LMArena-Rangliste.

Ist GLM 4.6 kostenlos oder kostenpflichtig?

Auf das Modell kann über seine Chat-Plattform frei zugegriffen werden. Dabei unterstützt Sie der Chatbot bei allen möglichen Aufgaben, sei es Texterstellung, Codierung, Bearbeitung. Für die API fallen jedoch einige Kosten an, die von der Nutzung und den Kosten für Eingabe- und Ausgabe-Tokens abhängen. Schließlich gibt es für GLM-4.6 einen Codierungsplan, bei dem die Gentle-Model etwa 3 US-Greenback professional Monat und die Professional-Model etwa 15 US-Greenback professional Monat kostet.

Wie greife ich auf GLM-4.6 zu?

Jeder kann über die Chat-Schnittstelle oder API auf dieses Modell zugreifen.

So greifen Sie über die Chat-Oberfläche darauf zu:

- Gehen Sie zu diesen Hyperlink.

- Melden Sie sich an oder registrieren Sie sich, um Ihr Konto zu erstellen.

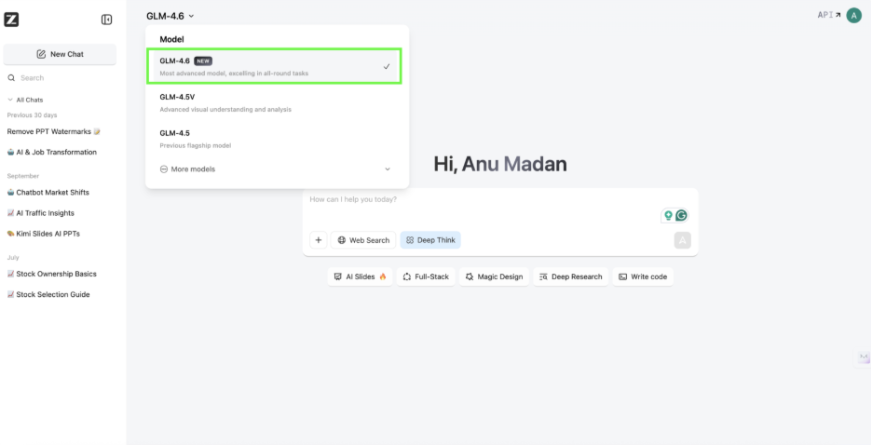

- Wählen Sie aus der Dropdown-Liste oben in der Mitte des Bildschirms das Modell GLM-4.6 aus

- Fügen Sie die Eingabeaufforderung in die Chatbox in der Mitte des Bildschirms ein.

So greifen Sie über die API auf GLM-4.6 zu:

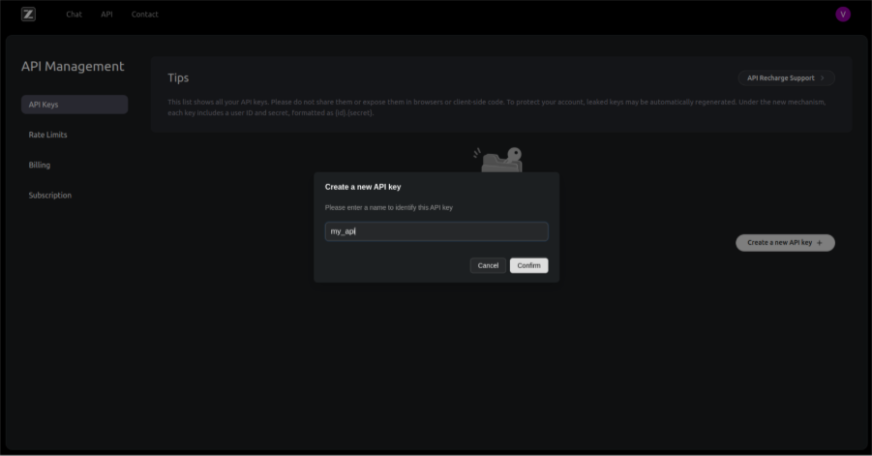

- Besuchen diese Web site und klicken Sie auf „API-Schlüssel“.

- Wenn Sie noch kein Konto haben, erstellen Sie ein neues Konto oder melden Sie sich bei Google an

- Klicken Sie nun auf „Neuen API-Schlüssel erstellen“, geben Sie Ihrer API einen Namen und klicken Sie auf „Bestätigen“.

Aufgaben aus der Praxis mit GLM-4.6

In diesem Abschnitt werden wir dieses neueste LLM anhand von drei Hauptaufgaben testen:

- Codierung

- Argumentation

- Agentenfähigkeiten

Beginnen wir mit dem ersten!

Codierung

Immediate: „Erstellen Sie eine Börsenanalyse-App, die den Menschen Vorschläge macht, wie sie ihre Investitionen basierend auf ihren zukünftigen Zielen diversifizieren können.“

Ausgabe:

Die vollständige Ausgabe finden Sie hier!

Rezension:

Ich habe mit diesem LLM eine hervorragende Leistung erzielt. Ich habe das Device „Full Stack“ ausgewählt, nachdem ich meine Eingabeaufforderung geschrieben hatte, um sicherzustellen, dass das Modell versteht, dass es einen Prototyp für meine Idee erstellen muss. Die Anfrage bestand darin, eine Marktanalyse-App zu erstellen, die den Nutzern dabei helfen könnte, herauszufinden, wie viel sie investieren sollten und wie sie ihre Investitionen an zukünftigen Zielen ausrichten können.

Die generierte Webseite enthielt mehrere Registerkarten: Dashboard, Anlageziele, Portfolioanalyse und KI-Empfehlungen. Jede Registerkarte diente einem klaren Zweck und half Benutzern dabei, ihre Investitionen basierend auf ihren Zielen zu planen, zu verfolgen und zu optimieren. Ich fand die gesamte Benutzeroberfläche benutzerfreundlich und interaktiv, insbesondere die Abschnitte zu Anlagezielen und KI-Empfehlungen, die umsetzbare Erkenntnisse und ein reibungsloses Erlebnis lieferten.

Argumentation

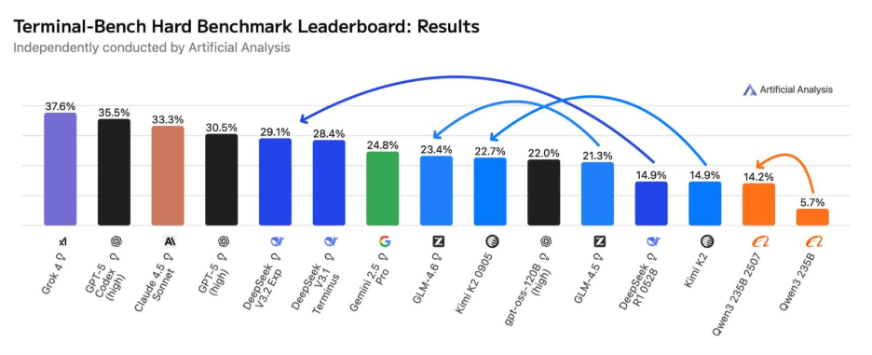

Immediate: „Analysieren Sie das Bild und beschreiben Sie, was passiert. Folgen Sie den Pfeilen, um die Entwicklung von Closed- und Open-Supply-Modellen im angezeigten Maßstab zu verfolgen. Interpretieren Sie, was das bedeutet, erkunden Sie seine Auswirkungen und bieten Sie einen gezielten, tiefen Einblick in die Zukunft von Open-Supply-Modellen. Untermauern Sie Ihre Schlussfolgerungen mit einfachen, klaren Diagrammen oder Bildern, um die Erkenntnisse leicht verständlich zu machen.“

Ausgabe:

Rezension:

Das Mannequin gab die Antwort zunächst auf Chinesisch, additionally bat ich es, sie auf Englisch bereitzustellen. Das Bild wurde korrekt gelesen und identifiziert, wo jedes LLM stand und wohin die Pfeile zeigten. Aber seine Begründung warfare nicht zutreffend. Die Interpretation des Modells warfare weit von dem entfernt, was das Bild andeutete.

Das Bild zeigte, dass die Kluft zwischen Open-Supply- und Closed-Supply-Modellen kleiner wird, das Modell sagte jedoch, dass die Kluft größer wird. Außerdem wurde eine Mindmap für die Zukunft von Open-Supply-Modellen erstellt, die zwar intestine aussah, deren Inhalt jedoch größtenteils falsch warfare.

Agentenfähigkeiten

Immediate: „Ich möchte die vollständige Liste der von Trump gegen verschiedene Länder verhängten Zölle, die Änderung der Steuersätze vor und nach der Einführung der Zölle und die möglichen Auswirkungen auf die Wirtschaft dieses Landes und der USA nach der Einführung dieser Zölle. Erstellen Sie eine Visualisierung der Gesamtzölle, die Trump verschiedenen Ländern auferlegt hat, und eine Grafik der wirtschaftlichen Auswirkungen.”

Ausgabe:

Rezension:

Auf den ersten Blick sieht die Ausgabe detailliert und vollständig aus. Es scheint alles abzudecken, wonach Sie gefragt haben. Aber wie immer ist es wichtig, es sorgfältig zu lesen, bevor man sich darauf verlässt. Das Modell beginnt intestine und erklärt die Auswirkungen der Trump-Zölle, doch die Probleme zeigen sich im Element. Die dort aufgeführten Tarifsätze wurden nur bis zum 9. April aktualisiert, und selbst nach mehreren Versuchen gelang es dem Modell nicht, die neuesten Daten einzubeziehen. Dies zeigt eine deutliche Einschränkung seiner Agentenfähigkeiten.

Leistung und Benchmarks

GLM 4.6 schneidet bei wichtigen Benchmarks für Argumentation, Codierung und Agentenaufgaben intestine ab und zeigt deutliche Verbesserungen gegenüber GLM 4.5 und konkurrierenden Modellen:

- ZIEL 25: Höchste Gesamtpunktzahl, führend im Denken mit Werkzeugen.

- GPQA und LiveCodeBench v6: Starke Leistung bei der Problemlösung und Codierungsgenauigkeit.

- BrowseComp: Deutliche Verbesserung bei Searching- und Verständnisaufgaben.

- SWE-Bench verifiziert: Wettbewerbsfähige Ergebnisse, ähnlich den Claude-Modellen.

- HLE & Terminal-Bench: Mäßige Ergebnisse mit Verbesserungspotenzial.

- τ²-Financial institution: Etwas hinter Claude Sonnet, aber immer noch solide.

Lesen Sie auch: 14 beliebte LLM-Benchmarks, die Sie im Jahr 2025 kennen sollten

Ist GLM-4.6 besser als GPT-5 oder Gemini 2.5 Professional oder Claude Sonnet 4.5?

Bisher denke ich, dass die Antwort auf diese Frage NEIN lautet. Das Modell verfügt über ein riesiges Kontextfenster, seine Argumentations- und Agentenfähigkeiten haben jedoch keine Probability gegen die Topmodelle von OpenAI oder Google. Das Modell ist schnell, halluziniert aber irgendwie in der Artwork und Weise, wie es Informationen abruft und verarbeitet. Was die Codierung betrifft, zeigt es deutliche Verbesserungen gegenüber dem letzten Modell und mit seinen Integrationen in High-Codierungstools wie Claude Code wird dieses Modell ein Begleiter für Codierer zu einem günstigeren Preis sein.

Weitere wichtige Veröffentlichungen:

Abschluss

GLM 4.6 ist kein Modell, das Sie für alltägliche Aufgaben verwenden würden. Obwohl es kostenlos ist, sind seine Antworten weniger zuverlässig als die anderer Modelle. LLMs haben sich in den letzten Monaten rasant verbessert, und viele offene Modelle weisen mittlerweile eine beeindruckende Ausgereiftheit auf. Im Vergleich dazu bleibt GLM 4.6 immer noch hinter diesem Normal zurück. Es hat jedoch positives Suggestions für seine Codierungsleistung erhalten. Wir können davon ausgehen, dass sich die Ergebnisse in den kommenden Tagen verbessern werden.

Probieren Sie es aus und lassen Sie mich wissen, ob Sie mit meiner Bewertung einverstanden sind.

Melden Sie sich an, um weiterzulesen und von Experten kuratierte Inhalte zu genießen.