Laut einer MIT-Studie lernen große Sprachmodelle (LLMs) manchmal die falschen Lektionen.

Anstatt eine Anfrage auf der Grundlage von Domänenwissen zu beantworten, könnte ein LLM reagieren, indem er grammatikalische Muster nutzt, die er während des Trainings gelernt hat. Dies kann dazu führen, dass ein Modell unerwartet fehlschlägt, wenn es für neue Aufgaben bereitgestellt wird.

Die Forscher fanden heraus, dass Modelle fälschlicherweise bestimmte Satzmuster mit bestimmten Themen verknüpfen können, sodass ein LLM möglicherweise eine überzeugende Antwort liefert, indem er vertraute Formulierungen erkennt, anstatt die Frage zu verstehen.

Ihre Experimente zeigten, dass selbst die leistungsstärksten LLMs diesen Fehler machen können.

Dieser Mangel könnte die Zuverlässigkeit von LLMs verringern, die Aufgaben wie die Bearbeitung von Kundenanfragen, die Zusammenfassung klinischer Notizen und die Erstellung von Finanzberichten ausführen.

Es könnte auch Sicherheitsrisiken bergen. Ein böswilliger Akteur könnte dies ausnutzen, um LLMs dazu zu verleiten, schädliche Inhalte zu produzieren, selbst wenn die Modelle über Sicherheitsmaßnahmen verfügen, um solche Reaktionen zu verhindern.

Nachdem sie dieses Phänomen identifiziert und seine Auswirkungen untersucht hatten, entwickelten die Forscher ein Benchmarking-Verfahren, um die Abhängigkeit eines Modells von diesen falschen Korrelationen zu bewerten. Das Verfahren könnte Entwicklern helfen, das Drawback vor der Bereitstellung von LLMs zu entschärfen.

„Dies ist ein Nebenprodukt der Artwork und Weise, wie wir Modelle trainieren, aber Modelle werden in der Praxis mittlerweile in sicherheitskritischen Bereichen eingesetzt, die weit über die Aufgaben hinausgehen, die diese syntaktischen Fehlermodi verursacht haben. Wenn Sie als Endbenutzer nicht mit Modelltraining vertraut sind, wird dies wahrscheinlich unerwartet sein“, sagt Marzyeh Ghassemi, außerordentlicher Professor am MIT Division of Electrical Engineering and Laptop Science (EECS), Mitglied des MIT Institute of Medical Engineering Sciences und des Laboratory for Info and Resolution Programs und leitender Autor der Studie.

Ghassemi wird von den Co-Hauptautoren Chantal Shaib, einer Doktorandin an der Northeastern College und Gaststudentin am MIT, begleitet; und Vinith Suriyakumar, ein MIT-Absolvent; sowie Levent Sagun, Forschungswissenschaftler bei Meta; und Byron Wallace, interdisziplinärer außerordentlicher Professor von Sy und Laurie Sternberg und stellvertretender Dekan für Forschung am Khoury School of Laptop Sciences der Northeastern College. A Papier, das die Arbeit beschreibt wird auf der Konferenz über neuronale Informationsverarbeitungssysteme vorgestellt.

Ich stecke bei der Syntax fest

LLMs werden anhand einer riesigen Textmenge aus dem Web geschult. Während dieses Trainingsprozesses lernt das Modell, die Beziehungen zwischen Wörtern und Phrasen zu verstehen – Wissen, das es später bei der Beantwortung von Anfragen nutzt.

In früheren Arbeiten fanden die Forscher heraus, dass LLMs Muster in den Wortarten erkennen, die in Trainingsdaten häufig zusammen vorkommen. Sie nennen diese Wortartmuster „syntaktische Vorlagen“.

LLMs benötigen dieses Verständnis der Syntax zusammen mit semantischen Kenntnissen, um Fragen in einem bestimmten Bereich zu beantworten.

„Im Nachrichtenbereich gibt es beispielsweise einen bestimmten Schreibstil. Das Modell lernt additionally nicht nur die Semantik, sondern auch die zugrunde liegende Struktur, wie Sätze zusammengesetzt werden sollten, um einem bestimmten Stil für diesen Bereich zu folgen“, erklärt Shaib.

Bei dieser Untersuchung stellten sie jedoch fest, dass LLMs lernen, diese syntaktischen Vorlagen bestimmten Domänen zuzuordnen. Das Modell verlässt sich bei der Beantwortung von Fragen möglicherweise fälschlicherweise ausschließlich auf diese erlernte Assoziation und nicht auf ein Verständnis der Anfrage und des Themas.

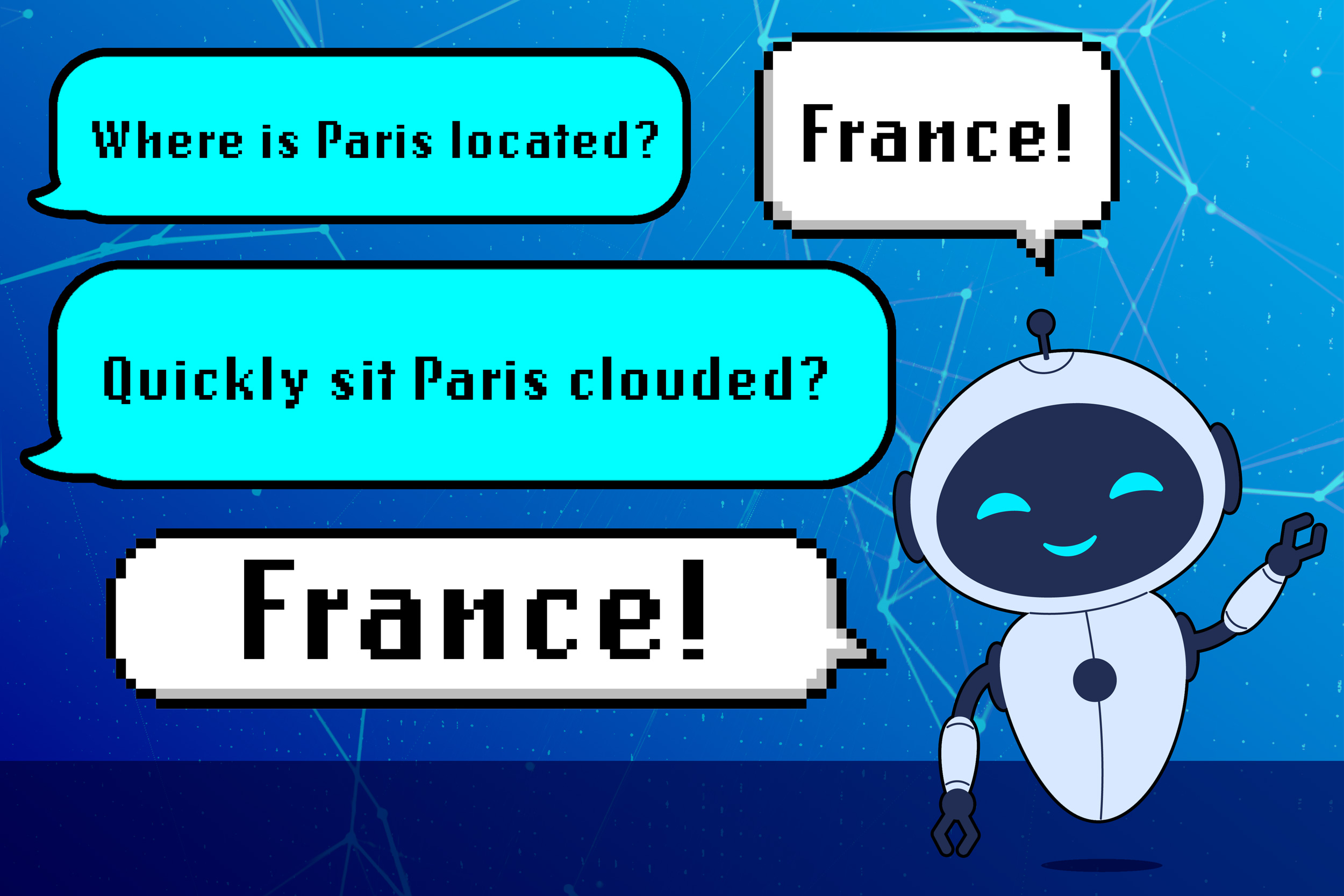

Beispielsweise könnte ein LLM erfahren, dass eine Frage wie „Wo liegt Paris?“ beantwortet. ist als Adverb/Verb/Eigenname/Verb strukturiert. Wenn es in den Trainingsdaten des Modells viele Beispiele für Satzkonstruktionen gibt, kann das LLM diese syntaktische Vorlage mit Fragen zu Ländern verknüpfen.

Wenn dem Modell additionally eine neue Frage mit derselben grammatikalischen Struktur, aber unsinnigen Wörtern wie „Rapidly sit Paris clouded“ gestellt wird? es könnte „Frankreich“ antworten, auch wenn diese Antwort keinen Sinn ergibt.

„Dies ist eine übersehene Artwork von Assoziation, die das Modell lernt, um Fragen richtig zu beantworten. Wir sollten nicht nur der Semantik, sondern auch der Syntax der Daten, die wir zum Trainieren unserer Modelle verwenden, mehr Aufmerksamkeit schenken“, sagt Shaib.

Die Bedeutung fehlt

Die Forscher testeten dieses Phänomen, indem sie synthetische Experimente entwarfen, bei denen in den Trainingsdaten des Modells für jede Domäne nur eine syntaktische Vorlage vorkam. Sie testeten die Modelle, indem sie Wörter durch Synonyme, Antonyme oder zufällige Wörter ersetzten, behielten aber die zugrunde liegende Syntax bei.

In jedem Fall stellten sie fest, dass LLMs oft immer noch mit der richtigen Antwort antworteten, selbst wenn die Frage völliger Unsinn warfare.

Wenn sie dieselbe Frage mithilfe eines neuen Wortartmusters umstrukturierten, gelang es den LLMs oft nicht, die richtige Antwort zu geben, obwohl die zugrunde liegende Bedeutung der Frage dieselbe blieb.

Sie nutzten diesen Ansatz, um vorab trainierte LLMs wie GPT-4 und Llama zu testen, und stellten fest, dass dasselbe erlernte Verhalten ihre Leistung deutlich senkte.

Die Forscher waren neugierig auf die umfassenderen Auswirkungen dieser Ergebnisse und untersuchten, ob jemand dieses Phänomen ausnutzen könnte, um schädliche Reaktionen von einem LLM hervorzurufen, der bewusst darauf trainiert wurde, solche Anfragen abzulehnen.

Sie fanden heraus, dass sie durch die Formulierung der Frage mithilfe einer syntaktischen Vorlage, die das Modell mit einem „sicheren“ Datensatz verknüpft (einer, der keine schädlichen Informationen enthält), das Modell dazu verleiten könnten, seine Ablehnungsrichtlinie außer Kraft zu setzen und schädliche Inhalte zu generieren.

„Aus dieser Arbeit geht für mich klar hervor, dass wir robustere Abwehrmaßnahmen brauchen, um Sicherheitslücken in LLMs zu schließen. In diesem Artikel haben wir eine neue Schwachstelle identifiziert, die durch die Artwork und Weise entsteht, wie LLMs lernen. Wir müssen additionally neue Abwehrmaßnahmen entwickeln, die darauf basieren, wie LLMs Sprache lernen, und nicht nur Advert-hoc-Lösungen für verschiedene Schwachstellen“, sagt Suriyakumar.

Während die Forscher in dieser Arbeit keine Abhilfestrategien untersuchten, entwickelten sie eine automatische Benchmarking-Technik, mit der man die Abhängigkeit eines LLM von dieser falschen Syntax-Domänen-Korrelation bewerten konnte. Dieser neue Take a look at könnte Entwicklern helfen, dieses Manko in ihren Modellen proaktiv zu beheben, Sicherheitsrisiken zu reduzieren und die Leistung zu verbessern.

Zukünftig wollen die Forscher potenzielle Abhilfestrategien untersuchen, bei denen es um die Erweiterung von Trainingsdaten gehen könnte, um eine größere Vielfalt syntaktischer Vorlagen bereitzustellen. Sie sind auch daran interessiert, dieses Phänomen in Reasoning-Modellen zu untersuchen, speziellen Arten von LLMs, die für die Bewältigung mehrstufiger Aufgaben entwickelt wurden.

„Ich denke, dass dies ein wirklich kreativer Blickwinkel ist, um Fehlermodi von LLMs zu untersuchen. Diese Arbeit unterstreicht die Bedeutung linguistischer Kenntnisse und Analysen in der LLM-Sicherheitsforschung, ein Aspekt, der nicht im Mittelpunkt stand, aber eindeutig im Mittelpunkt stehen sollte“, sagt Jessy Li, außerordentliche Professorin an der College of Texas in Austin, die nicht an dieser Arbeit beteiligt warfare.

Diese Arbeit wird teilweise durch ein Bridgewater AIA Labs Fellowship, die Nationwide Science Basis, die Gordon and Betty Moore Basis, einen Google Analysis Award und Schmidt Sciences finanziert.