In den letzten Jahren drehten sich viele Gespräche über KI um eine einzige, täuschend einfache Frage: Welches Modell ist das beste?

Aber die nächste Frage battle immer: das Beste wofür?

Das Beste zum Argumentieren? Schreiben? Codierung? Oder ist es vielleicht das Beste für Bilder, Audio oder Video?

Diese Formulierung machte Sinn, als die Technologie neu und uneinheitlich battle. Als die Lücken zwischen den Modellen offensichtlich waren, schien es produktiv und quick notwendig, über Benchmarks zu debattieren. Durch die Wahl des richtigen Modells könnte sich das, was Sie erreichen konnten oder nicht, erheblich ändern.

Aber wenn man KI heute für echte Arbeit einsetzt – Schreiben, Planen, Recherchieren, Analysieren und Synthetisieren von Informationen – oder einfach nur, um halbfertige Ideen in etwas Brauchbares umzuwandeln, fühlt sich diese Frage seltsam nebensächlich an. Denn die Wahrheit ist: Die Modelle sind schon seit einiger Zeit kein Flaschenhals mehr.

Was die Menschen jetzt ausbremst, ist weder künstliche noch sonstige Intelligenz. Es ist der immer komplexer werdende Overhead Umgebungsprobleme wie mehrere Abonnements, fragmentierte Arbeitsabläufe und ständiger Kontextwechsel. Sie haben einen Browser voller Registerkarten, von denen jede für einen kleinen Teil der Arbeit geeignet ist, den Relaxation jedoch völlig ignoriert. Infolgedessen springen Sie von Instrument zu Instrument, erklären den Kontext neu, gestalten Eingabeaufforderungen neu, laden Dateien erneut hoch und formulieren Ziele neu.

Irgendwann auf dem Weg dorthin fühlt sich die ursprüngliche Prämisse, nämlich dass KI zu erheblicher Zeit- und Kosteneffizienz führen kann, als hohl an. Das ist der Second, in dem sich auch die Frage ändert, die sich Praktiker stellen. Anstatt zu fragen: „Welches Modell soll ich verwenden?“ Es entsteht ein weitaus banalerer und aufschlussreicherer Gedanke: Warum fühlt sich die Arbeit mit KI oft schwieriger und umständlicher an als die Arbeit, die sie vereinfachen soll?

Modelle verbessern sich. Workflows sind es nicht.

Für die alltägliche Wissensarbeit sind die heutigen Leitmodelle bereits intestine genug. Ihre Leistung ist möglicherweise nicht bei allen Aufgaben identisch und sie sind nicht in jedem Grenzfall austauschbar, aber sie sind gerade an dem Punkt angelangt, an dem geringfügige Verbesserungen der Ausgabequalität selten zu nennenswerten Produktivitätssteigerungen führen.

Wenn sich Ihr Schreibstil um fünf Prozent verbessert, Sie aber doppelt so viel Zeit damit verbringen, zu entscheiden, welches Instrument Sie öffnen oder fehlerhaften Kontext bereinigen möchten, ist das nur Reibung, die als Raffinesse getarnt ist. Die wirklichen Gewinne kommen jetzt aus weniger glamourösen Bereichen: Reibungsverluste reduzieren, Kontext bewahren, Kosten kontrollieren und Entscheidungsmüdigkeit verringern. Diese Verbesserungen sind vielleicht nicht auffällig, aber sie verstärken sich mit der Zeit schnell.

Ironischerweise untergräbt der heutige Ansatz von KI-Nutzern alle vier davon.

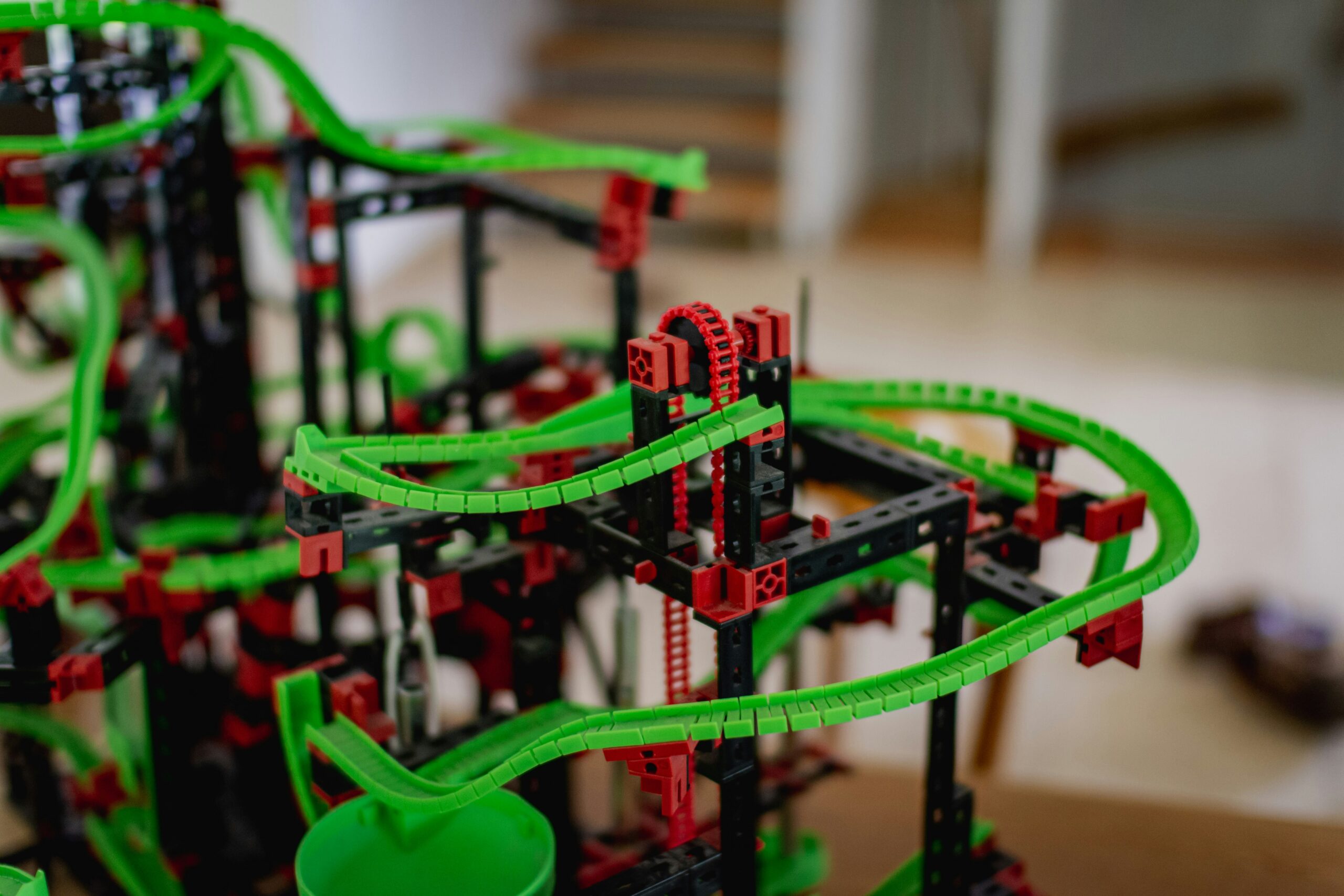

Wir haben das frühe nachgebildet SaaS-Wildwuchsproblemaber schneller und lauter. Ein Instrument zum Schreiben, ein anderes für Bilder, ein drittes für die Recherche, ein viertes für die Automatisierung und so weiter. Jedes für sich ist elegant und beeindruckend, aber keines ist so konzipiert, dass es anmutig mit den anderen koexistiert.

Für sich genommen sind diese Instruments leistungsstark. Zusammengenommen sind sie anstrengend und möglicherweise kontraproduktiv.

Anstatt die kognitive Belastung zu reduzieren oder die Arbeit zu vereinfachen, fragmentieren sie sie. Sie fügen neue Entscheidungen hinzu: Wo soll diese Aufgabe leben? Welches Modell sollte ich zuerst ausprobieren? Wie verschiebe ich Ausgaben von einem Ort an einen anderen, ohne den Kontext zu verlieren?

Aus diesem Grund wird die Konsolidierung (nicht bessere Eingabeaufforderungen oder etwas intelligentere Modelle) zum nächsten echten Vorteil.

Die versteckte Steuer des kognitiven Overheads

Einer der am wenigsten diskutierten Kostenfaktoren heutiger KI-Workflows ist weder Geld noch Leistung. Es ist Aufmerksamkeit. Jedes zusätzliche Instrument, jede Modellauswahl, jede Preisstufe und jede Schnittstelle bringt eine kleine Entscheidung mit sich. Für sich genommen fühlt sich jede Entscheidung trivial an. Aber im Laufe eines Tages summieren sie sich. Was als Flexibilität beginnt, verwandelt sich langsam in Reibung.

Wenn Sie entscheiden müssen, welches Werkzeug Sie verwenden möchten, bevor Sie überhaupt beginnen, haben Sie bereits mentale Energie verbrannt. Wenn Sie sich merken müssen, welches System Zugriff auf welche Dateien hat, welches Modell sich für welche Aufgabe am besten verhält und welches Abonnement welche Einschränkungen enthält, beginnt der Overhead mit der Arbeit selbst zu konkurrieren. Die Ironie besteht natürlich darin, dass die KI diese Belastung reduzieren und nicht vervielfachen sollte.

Es ist wichtiger, als den meisten Menschen bewusst ist. Die besten Ideen entstehen normalerweise nicht, wenn Sie mit Schnittstellen jonglieren und Nutzungs-Dashboards überprüfen. Sie materialisieren sich, wenn man lange genug in einem Downside bleiben kann, um seine Type klar zu erkennen. Fragmentierte KI-Instruments unterbrechen diese Kontinuität und zwingen Sie zu einer ständigen Neuorientierung. Sie fragen immer wieder: Wo battle ich? Was habe ich versucht? Welchen Kontext habe ich bereits angegeben? Bin ich noch innerhalb des Budgets? Diese Fragen untergraben die Dynamik, und die Konsolidierung beginnt, wie eine Strategie auszusehen.

Eine einheitliche Umgebung sorgt dafür, dass der Kontext bestehen bleibt und Entscheidungen in den Hintergrund treten, wo sie hingehören. Wenn ein System das Routing übernimmt, sich frühere Arbeiten merkt und unnötige Entscheidungen reduziert, gewinnen Sie etwas zurück, das immer seltener wird: ununterbrochene Bedenkzeit. Das ist die eigentliche Produktivitätssteigerung, und es hat nichts damit zu tun, einen weiteren Prozentpunkt aus der Modellqualität herauszuholen. Aus diesem Grund sind Energy-Person oft frustrierter als Anfänger. Je tiefer Sie KI in Ihren Arbeitsablauf integrieren, desto schmerzhafter wird die Fragmentierung. Im großen Maßstab nehmen kleine Ineffizienzen zu und werden zu kostspieligen Belastungen.

Bei der Konsolidierung geht es nicht um Bequemlichkeit

Plattformen wie ChatLLM basieren auf einer Grundannahme: Kein einzelnes Modell wird jemals in allem das Beste sein. Verschiedene Modelle werden bei unterschiedlichen Aufgaben hervorragende Leistungen erbringen, und es werden immer wieder neue hinzukommen. Die Stärken werden sich verschieben und die Preise werden sich ändern. Tatsächlich scheint es eine unhaltbare Entscheidung zu sein, Ihren gesamten Workflow an einen Anbieter zu binden.

Diese Formulierung verändert grundlegend Ihre Einstellung zu KI. Modelle werden zu Bestandteilen eines umfassenderen Techniques und nicht zu Philosophien, denen Sie sich anschließen, oder zu Institutionen, denen Sie Treue schwören. Sie sind keine „GPT-Particular person“ oder „eine Claude-Particular person“ mehr. Stattdessen stellen Sie Intelligenz auf die gleiche Weise zusammen, wie Sie jeden modernen Stack zusammenstellen: Sie wählen das Instrument aus, das für die Aufgabe geeignet ist, ersetzen es, wenn dies nicht der Fall ist, und bleiben flexibel, wenn sich die Landschaft und Ihre Projektanforderungen weiterentwickeln.

Es handelt sich um einen entscheidenden Wandel, und sobald man ihn erkennt, ist er kaum noch zu übersehen.

Von Chat-Schnittstellen bis hin zu funktionierenden Systemen

Der Chat allein lässt sich nicht wirklich skalieren.

Immediate rein, Antwort raus? Dies magazine ein nützliches Schema sein, aber es scheitert, wenn KI Teil der täglichen Arbeit wird und nicht nur ein gelegentliches Experiment. Sobald Sie sich wiederholt darauf verlassen, werden seine Grenzen deutlich.

Es kommt zu einer echten Hebelwirkung wenn KI mit Sequenzen umgehen kann und erinnern Sie sich an das, was vorher battle, antizipieren Sie, was als nächstes kommt, und reduzieren Sie die Häufigkeit, mit der ein Mensch eingreifen muss, nur um Informationen zu verschieben. Hier beginnen Agenten-Instruments in einem hochwertigen Sinne eine Rolle zu spielen: Sie können Informationen überwachen, laufende Eingaben zusammenfassen, wiederkehrende Berichte erstellen, Daten über Instruments hinweg verbinden und zeitaufwändige manuelle Klebearbeiten eliminieren.

Die Kosten sind wieder im Gespräch

Da KI-Arbeitsabläufe immer multimodaler werden, spielen wirtschaftliche Aspekte wieder eine Rolle. Die Token-Preisgestaltung allein sagt nicht alles aus, wenn leichte Aufgaben neben schweren Aufgaben liegen oder wenn Experimente zu nachhaltiger Nutzung werden.

Eine Zeit lang verschleierte die Neuheit diese Tatsache. Aber sobald KI zur Infrastruktur wird, verschiebt sich die Frage. Es ist nicht mehr „kann X Y tun?„Stattdessen wird es zu „Ist das nachhaltig?„Infrastrukturen unterliegen Einschränkungen, und zu lernen, mit ihnen umzugehen, trägt dazu bei, die Technologie tatsächlich nützlich zu machen. Genauso wie wir unsere eigenen kognitiven Budgets neu kalibrieren müssen, modern Preisstrategien auch notwendig werden.

Der Kontext ist der eigentliche Graben

Je einfacher Modelle ersetzt werden können, desto schwieriger wird es, den Kontext zu reproduzieren. Ihre Dokumente, Gespräche, Entscheidungen, Ihr institutionelles Gedächtnis und all das andere chaotische, angesammelte Wissen, das in allen Instruments vorhanden ist, bilden den Kontext, der nicht gefälscht werden kann.

Ohne Kontext ist KI klug, aber oberflächlich. Es kann believable Antworten generieren, aber nicht sinnvoll auf früheren Arbeiten aufbauen. Im Kontext kann sich KI wirklich nützlich anfühlen. Aus diesem Grund sind Integrationen wichtiger als Demos.

Der große Wandel

Die wichtigste Veränderung, die derzeit in der KI stattfindet, betrifft die Organisation. Wir gehen weg von der Besessenheit darüber, welches Modell das beste ist, und hin zur Gestaltung von Arbeitsabläufen, die im Laufe der Zeit ruhiger, kostengünstiger und nachhaltiger sind. ChatLLM ist ein Beispiel Teil dieser breiteren Bewegung, aber wichtiger als das Produkt selbst ist das, was es repräsentiert: Konsolidierung, Routing, Orchestrierung und kontextsensitive Systeme.

Die meisten Menschen brauchen kein besseres oder intelligenteres Modell. Sie müssen weniger Entscheidungen treffen und weniger Momente erleben, in denen die Dynamik abbricht, weil der Kontext verloren gegangen ist oder die falsche Schnittstelle geöffnet battle. Sie brauchen KI, um sich in die Type der realen Arbeit einzufügen, anstatt zu verlangen, dass wir jedes Mal, wenn sich im Vorfeld etwas ändert, einen völlig neuen Arbeitsablauf erstellen.

Deshalb verlagert sich das Gespräch auf Fragen, die viel banaler klingen, aber mit einer realistischen Erwartung größerer Effizienz und besserer Ergebnisse verbunden sind: Wo sind organisatorische Informationen gespeichert? Wie können wir einen Kostenanstieg verhindern? Was sollten wir tun, um uns präventiv davor zu schützen, dass Anbieter ihr Produkt wechseln?

Diese Fragen könnten darüber entscheiden, ob KI zur Infrastruktur wird oder als Neuheit stecken bleibt. Plattformen wie ChatLLM basieren auf der Annahme, dass Fashions kommen und gehen, dass sich Stärken verändern und dass Flexibilität wichtiger ist als Loyalität. Der Kontext ist kein Bonus; Das ist der springende Punkt. Künftige KI könnte durch Systeme definiert werden, die Reibungsverluste reduzieren, den Kontext bewahren und die Realität der menschlichen Aufmerksamkeit respektieren. Es ist der Wandel, der KI endlich nachhaltig machen könnte.