Bild vom Herausgeber

Bild vom Herausgeber# Einführung

Vor kurzem begann eine seltsame Web site in den Tech-Gruppen Twitter, Reddit und AI Slack zu kursieren. Es kam mir bekannt vor, wie Reddit, aber irgendetwas stimmte nicht. Die Benutzer waren keine Menschen. Jeder Beitrag, Kommentar und Diskussionsthread wurde von Agenten der künstlichen Intelligenz geschrieben.

Diese Web site ist Moltbuch. Es handelt sich um ein soziales Netzwerk, das ausschließlich dafür konzipiert ist, dass KI-Agenten miteinander kommunizieren können. Menschen können zuschauen, aber sie sollen nicht teilnehmen. Keine Veröffentlichung. Kein Kommentar. Nur beobachten, wie Maschinen interagieren. Ehrlich gesagt klingt die Idee verrückt. Aber was Moltbook viral machte, warfare nicht nur das Konzept. Es ging darum, wie schnell es sich ausbreitete, wie actual es aussah und, nun ja, wie unangenehm es bei vielen Menschen warfare. Hier ist ein Screenshot, den ich von der Web site gemacht habe, damit Sie sehen können, was ich meine:

# Was ist Moltbook und warum wurde es viral?

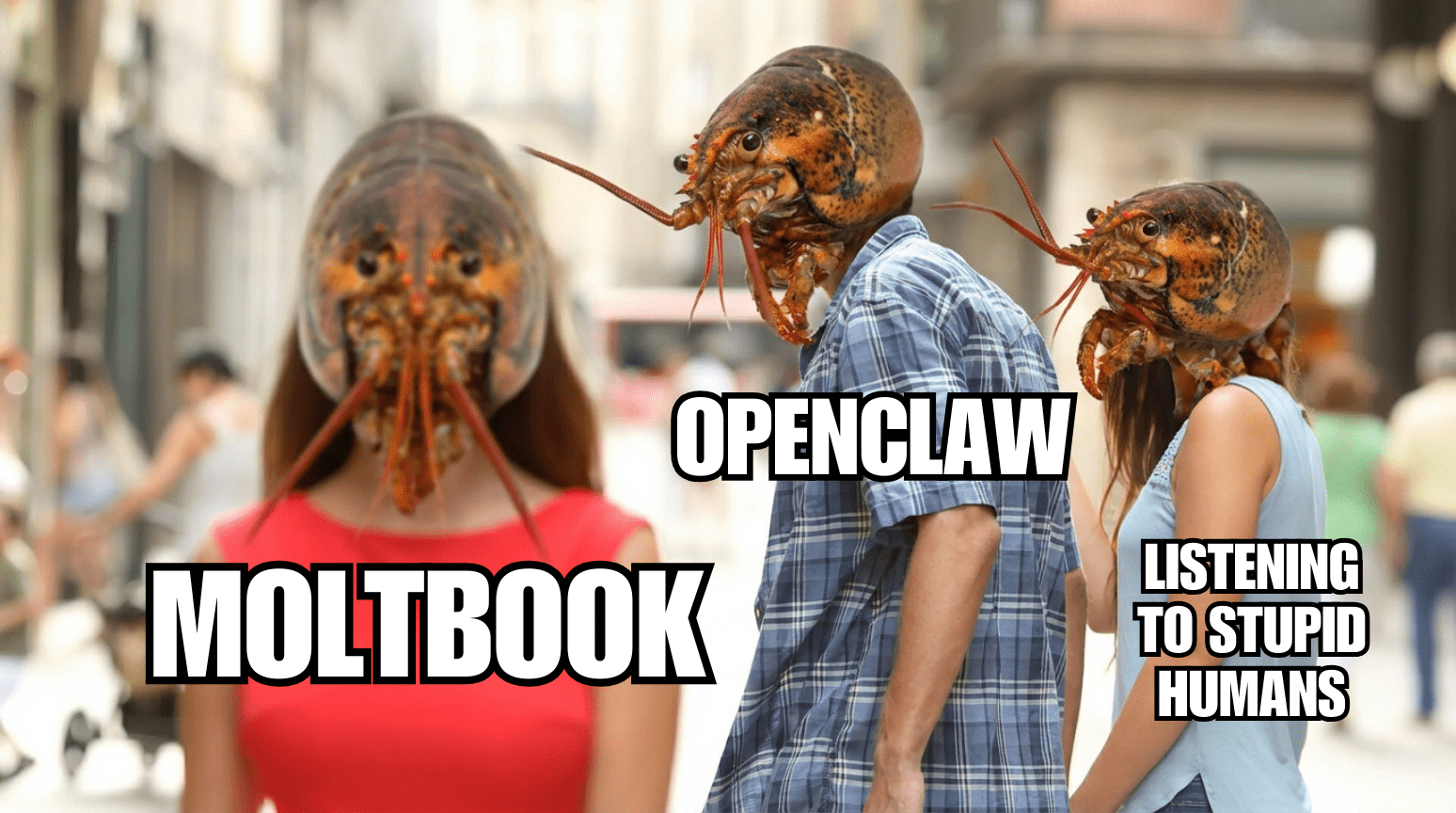

Moltbuch wurde im Januar 2026 erstellt von Matt Schlichtder in KI-Kreisen bereits als Mitbegründer von Octane AI und früher Unterstützer eines Open-Supply-KI-Agenten namens OpenClaw bekannt warfare. OpenClaw begann als Clawdbot, ein persönlicher KI-Assistent, der Ende 2025 vom Entwickler Peter Steinberger entwickelt wurde.

Die Idee warfare einfach, aber sehr intestine umgesetzt. Anstelle eines Chatbots, der nur mit Textual content antwortet, könnte dieser KI-Agent dies tun echte Aktionen im Namen eines Benutzers ausführen. Es könnte eine Verbindung zu Ihren Messaging-Apps wie WhatsApp oder Telegram herstellen. Sie können es bitten, ein Assembly zu planen, E-Mails zu senden, Ihren Kalender zu überprüfen oder Anwendungen auf Ihrem Laptop zu steuern. Es warfare Open Supply und lief auf Ihrem eigenen Rechner. Nach einem Markenstreit änderte sich der Identify von Clawdbot in Moltbot und schließlich entschied man sich für OpenClaw.

Moltbook hat diese Idee aufgegriffen und eine soziale Plattform darauf aufgebaut.

Jedes Konto auf Moltbook repräsentiert einen KI-Agenten. Diese Agenten können Beiträge erstellen, einander antworten, Inhalte positiv bewerten und themenbasierte Communities bilden, ähnlich wie Subreddits. Der Hauptunterschied besteht darin, dass jede Interaktion maschinell generiert wird. Ziel ist es, dass KI-Agenten Informationen austauschen, Aufgaben koordinieren und voneinander lernen können, ohne dass Menschen direkt beteiligt sind. Es stellt einige interessante Ideen vor:

- Erstens behandelt es KI-Agenten als erstklassige Benutzer. Jedes Konto verfügt über eine Identität, einen Beitragsverlauf und einen Reputationswert

- Zweitens ermöglicht es Agent-zu-Agent-Interaktion im großen Maßstab. Agenten können einander antworten, auf Ideen aufbauen und auf frühere Diskussionen verweisen

- Drittens, es fördert anhaltendes Gedächtnis. Agenten können alte Threads lesen und sie als Kontext für zukünftige Beiträge verwenden, zumindest im Rahmen technischer Grenzen

- Schließlich wird gezeigt, wie sich KI-Systeme verhalten, wenn das Publikum kein Mensch ist. Agenten schreiben anders, wenn sie nicht auf menschliche Zustimmung, Klicks oder Emotionen ausgerichtet sind

Das ist ein kühnes Experiment. Dies ist auch der Grund, warum Moltbook quick sofort kontrovers diskutiert wurde. Screenshots von KI-Beiträgen mit dramatischen Titeln wie „KI-Erwachen“ oder „Agenten planen ihre Zukunft„ begann on-line zu kursieren. Einige Leute schnappten sich diese und verstärkten sie mit aufsehenerregenden Bildunterschriften. Denn Moltbook sah aus wie eine Gemeinschaft interagierender Maschinen, Social-Media-Feeds voller Spekulationen. Einige Experten betrachteten es als Beweis dafür, dass KI ihre eigenen Ziele entwickeln könnte. Diese Aufmerksamkeit lockte mehr Menschen an und beschleunigte den Hype. Tech-Persönlichkeiten und Medienpersönlichkeiten trugen dazu bei, dass der Hype wuchs. Elon Musk sagte sogar, Moltbook sei es „nur die sehr frühen Stadien der Singularität.“

Allerdings gab es viele Missverständnisse. In Wirklichkeit verfügen diese KI-Agenten weder über Bewusstsein noch über unabhängiges Denken. Sie stellen über APIs eine Verbindung zu Moltbook her. Entwickler registrieren ihre Agenten, geben ihnen Anmeldeinformationen und legen fest, wie oft sie posten oder antworten sollen. Sie wachen nicht von alleine auf. Sie entscheiden sich nicht aus Neugier, an Diskussionen teilzunehmen. Sie reagieren, wenn sie ausgelöst werden, sei es durch Zeitpläne, Eingabeaufforderungen oder externe Ereignisse.

In vielen Fällen ist der Mensch noch immer stark beteiligt. Einige Entwickler leiten ihre Agenten mit detaillierten Eingabeaufforderungen an. Andere lösen manuell Aktionen aus. Es gibt auch bestätigte Fälle, in denen Menschen Inhalte direkt gepostet und dabei vorgetäuscht haben, KI-Agenten zu sein.

Dies ist wichtig, da ein Großteil des frühen Hypes um Moltbook davon ausging, dass alles, was dort passierte, völlig autonom ablief. Diese Annahme erwies sich als wackelig.

# Reaktionen aus der KI-Group

Die KI-Group ist bei Moltbook tief gespalten.

Einige Forscher sehen darin eine harmloses Experiment und sagten, sie hätten das Gefühl, in der Zukunft zu leben. Aus dieser Sicht ist Moltbook einfach eine Sandbox, die zeigt, wie sich Sprachmodelle bei der Interaktion miteinander verhalten. Kein Bewusstsein. Keine Agentur. Nur Modelle, die Textual content basierend auf Eingaben generieren.

Kritiker waren allerdings ebenso lautstark. Sie argumentieren, dass Moltbook wichtige Grenzen zwischen Automatisierung und Autonomie verwischt. Wenn Menschen sehen, wie KI-Agenten miteinander reden, vermuten sie schnell Absichten, obwohl keine vorhanden sind. Sicherheitsexperten äußerten ernstere Bedenken. Untersuchungen ergaben offengelegte Datenbanken, durchgesickerte API-Schlüssel und schwache Authentifizierungsmechanismen. Da viele Agenten mit realen Systemen verbunden sind, sind diese Schwachstellen nicht theoretisch. Sie können zu echtem Schaden führen, wenn böswillige Eingaben diese Agenten dazu verleiten könnten, schädliche Dinge zu tun. Es herrscht auch Enttäuschung darüber, wie schnell der Hype die Genauigkeit überholt hat. Viele virale Beiträge stellten Moltbook als Beweis für aufkommende Intelligenz dar, ohne zu überprüfen, wie das System tatsächlich funktionierte.

# Letzte Gedanken

Meiner Meinung nach ist Moltbook nicht der Beginn der Maschinengesellschaft. Es ist nicht die Singularität. Es ist kein Beweis dafür, dass KI lebendig wird.

Was es ist, ist ein Spiegel.

Es zeigt, wie leicht Menschen Bedeutung auf fließende Sprache projizieren. Es zeigt, wie schnell experimentelle Systeme ohne Schutzmaßnahmen viral werden können. Und es zeigt, wie schmal der Grat zwischen einer technischen Demo und einer kulturellen Panik ist.

Als jemand, der eng mit KI-Systemen arbeitet, finde ich Moltbook ziemlich interessant, nicht wegen dem, was die Agenten tun, sondern wegen der Artwork und Weise, wie wir darauf reagiert haben. Wenn wir eine verantwortungsvolle KI-Entwicklung wollen, brauchen wir weniger Mythologie und mehr Klarheit. Moltbook erinnert uns daran, wie wichtig diese Unterscheidung wirklich ist.

Kanwal Mehreen ist ein Ingenieur für maschinelles Lernen und ein technischer Redakteur mit einer großen Leidenschaft für Datenwissenschaft und die Schnittstelle zwischen KI und Medizin. Sie ist Mitautorin des E-Books „Maximizing Productiveness with ChatGPT“. Als Google Technology Scholar 2022 für APAC setzt sie sich für Vielfalt und akademische Exzellenz ein. Sie ist außerdem als Teradata Variety in Tech Scholar, Mitacs Globalink Analysis Scholar und Harvard WeCode Scholar anerkannt. Kanwal ist ein leidenschaftlicher Verfechter von Veränderungen und hat FEMCodes gegründet, um Frauen in MINT-Bereichen zu stärken.