Wenn Sie versuchen, Ideen zu kommunizieren oder zu verstehen, tun Wörter nicht immer den Trick. Manchmal besteht der effizientere Ansatz darin, eine einfache Skizze dieses Konzepts durchzuführen. Zum Beispiel kann die Diagrammung einer Schaltung dazu beitragen, wie das System funktioniert.

Aber was wäre, wenn künstliche Intelligenz uns helfen könnte, diese Visualisierungen zu erforschen? Während diese Systeme in der Regel realistische Gemälde und Karikaturzeichnungen erstellen können, erfassen viele Modelle nicht die Essenz des Skizzierens: seine Schlaganfall- und iterative Prozesse, die dem Menschen hilft, Brainstorming zu erstellen und zu bearbeiten, wie sie ihre Ideen darstellen möchten.

Ein neues Zeichensystem aus dem MIT -Labor für Informatik und künstliche Intelligenz (CSAIL) und der Stanford College kann mehr so skizzieren, wie wir es tun. Ihre Methode mit dem Namen „Sketchagent“ verwendet ein multimodales Sprachmodell – KI -Systeme, die auf Textual content und Bilder trainieren, wie das Claude 3.5 -Sonett von Anthropic -, um natürliche Sprache in wenigen Sekunden in Skizzen zu verwandeln. Zum Beispiel kann es ein Haus entweder selbst oder durch Zusammenarbeit kritzeln, mit einem Menschen zeichnen oder textbasierte Eingaben einbeziehen, um jeden Teil separat zu skizzieren.

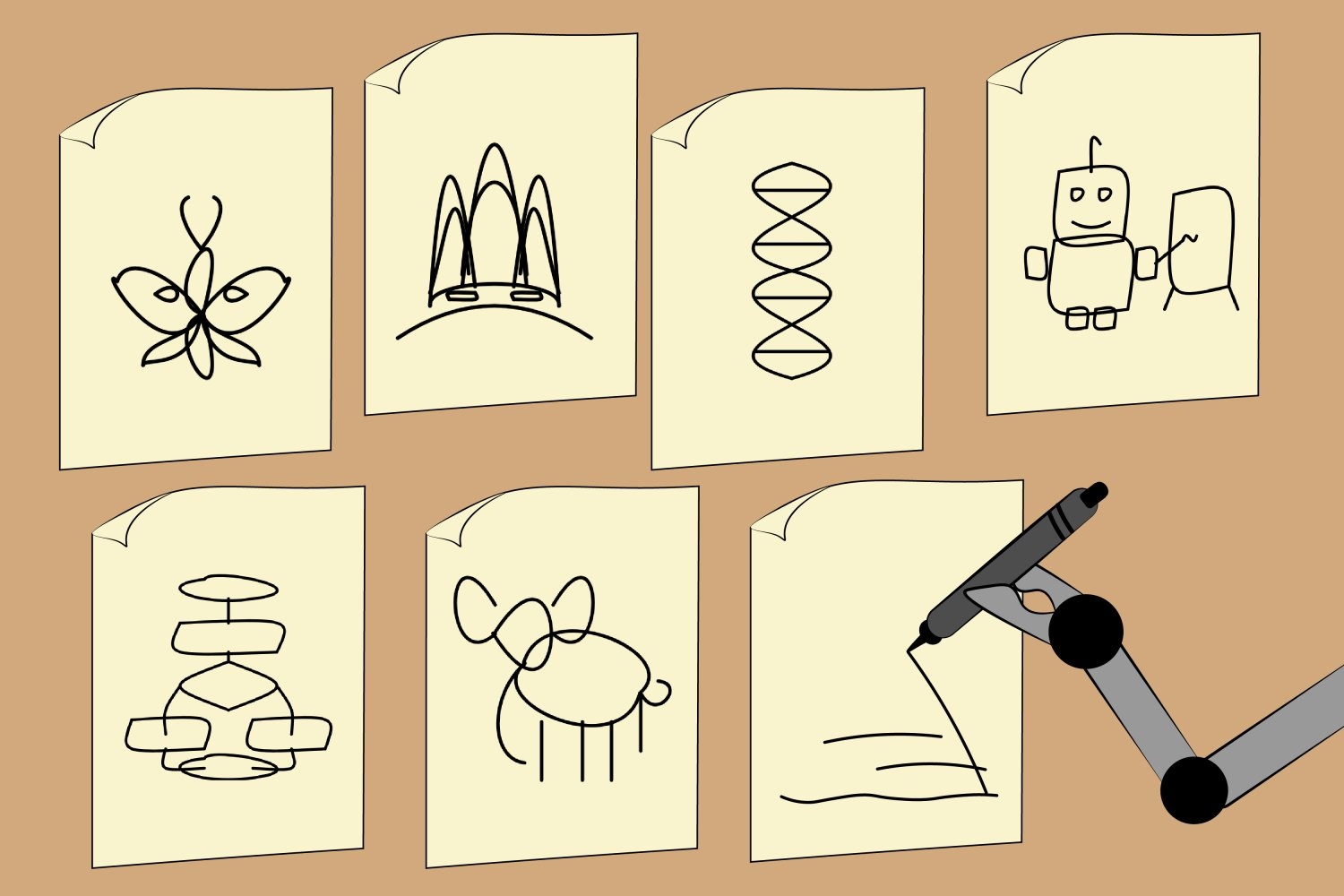

Die Forscher zeigten, dass Sketchagent abstrakte Zeichnungen verschiedener Konzepte wie Roboter, Schmetterling, DNA -Helix, Flowdiagramm und sogar das Sydney Opera Home erstellen kann. Eines Tages könnte das Instrument in ein interaktives Kunstspiel erweitert werden, das Lehrern und Forschern hilft, komplexe Konzepte auszuräumen oder den Benutzern eine schnelle Zeichenstunde zu geben.

CSAIL Postdoc Yael Vinker, der der Hauptautor von A ist Papier Wenn Sie Sketchagent vorstellen, stellt das System fest, dass das System den Menschen eine natürlichere Möglichkeit einführt, mit KI zu kommunizieren.

„Nicht jeder weiß, wie sehr er ihr tägliches Leben zeichnen. Wir können unsere Gedanken oder Workshop -Ideen mit Skizzen zeichnen“, sagt sie. „Unser Instrument zielt darauf ab, diesen Prozess nachzuahmen und multimodale Sprachmodelle nützlicher zu machen, um uns visuell Ideen auszudrücken.“

Sketchagent lehrt diese Modelle, Schlaganfall zu zeichnen, ohne Daten zu trainieren. Stattdessen entwickelten die Forscher eine „Skizziersprache“, in der eine Skizze in eine nummerierte Folge von Schlaganfällen auf einem Raster übersetzt wird. Das System erhielt ein Beispiel dafür, wie Dinge wie ein Haus gezogen werden würden, wobei jeder Schlag nach dem, was es darstellte – wie der siebte Schlag, ein Rechteck, das als „Haustür“ bezeichnet wurde -, um das Modell auf neue Konzepte zu verallgemeinern.

Vinker schrieb das Papier zusammen mit drei CSAIL -Associates – Postdoc Tamar Rott Shaham, Scholar -Forscher Alex Zhao und Professorin Antonio Torralba – sowie Kristine Zheng, Analysis der Stanford College, und der stellvertretende Professor Judith Ellen Fan. Sie werden ihre Arbeiten auf der Konferenz 2025 über Laptop Imaginative and prescient und Mustererkennung (CVPR) in diesem Monat präsentieren.

Bewertung der Skizzierungsfähigkeiten von KI

Während Textual content-zu-Picture-Modelle wie Dall-E 3 faszinierende Zeichnungen erzeugen können, fehlt ihnen eine entscheidende Komponente des Skizzierens: Der spontane, kreative Prozess, bei dem sich jeder Schlag auf das Gesamtdesign auswirken kann. Andererseits werden Sketchagents Zeichnungen als Folge von Schlaganfällen modelliert, die natürlicher und flüssiger erscheinen, wie menschliche Skizzen.

Frühere Arbeiten haben diesen Prozess auch nachgeahmt, aber sie haben ihre Modelle auf menschlichen Datensätzen geschult, die häufig in Größenordnung und Vielfalt begrenzt sind. Sketchagent verwendet stattdessen vorgeborene Sprachmodelle, die sich über viele Konzepte kennenlernen, aber nicht wissen, wie man skizziert. Als die Forscher Sprachmodelle diesen Prozess unterrichteten, begann Sketchagent, verschiedene Konzepte zu skizzieren, an denen sie nicht explizit ausgebildet waren.

Trotzdem wollten Vinker und ihre Kollegen sehen, ob Sketchagent aktiv mit Menschen am Skizzierungsprozess zusammenarbeitete oder ob es unabhängig von seinem Zeichenpartner arbeitete. Das Group testete sein System im Kollaborationsmodus, wo ein Mensch und ein Sprachmodell darauf hinarbeiten, ein bestimmtes Konzept mit Tandem zu zeichnen. Das Entfernen von Sketchagents Beiträgen ergab, dass die Schläge ihres Werkzeugs für die endgültige Zeichnung von wesentlicher Bedeutung waren. In einer Zeichnung eines Segelboots machte das Entfernen der künstlichen Striche, die einen Mast darstellen, die Gesamtskizze nicht wiederzuerkennen.

In einem anderen Experiment haben CSAIL- und Stanford -Forscher verschiedene multimodale Sprachmodelle in SketchAgent angeschlossen, um festzustellen, welche die bekanntesten Skizzen erzeugen könnten. Das standardmäßige Spine-Modell, Claude 3.5 Sonett, erzeugte die menschlichsten Vektorgrafiken (im Wesentlichen textbasierte Dateien, die in hochauflösende Bilder konvertiert werden können). Es übertraf Modelle wie GPT-4O und Claude 3 Opus.

„Die Tatsache, dass Claude 3.5 Sonett andere Modelle wie GPT-4O und Claude 3 Opus übertraf, legt nahe, dass dieses Modell sich unterschiedlich verarbeitet und visuell bezogene Informationen erzeugt“, sagt Co-Autor Tamar Rott Shaham.

Sie fügt hinzu, dass Sketchagent zu einer hilfreichen Schnittstelle für die Zusammenarbeit mit KI-Modellen hinausgehen könnte, die über die Normal-textbasierte Kommunikation hinausgehen. „Wenn Modelle beim Verständnis und Generieren anderer Modalitäten wie Skizzen voranschreiten und generieren, öffnen sie den Benutzern neue Möglichkeiten, Ideen auszudrücken und Antworten zu erhalten, die sich intuitiver und menschlicher anfühlen“, sagt Rott Shaham. „Dies könnte die Interaktionen erheblich bereichern und KI zugänglicher und vielseitiger machen.“

Während Sketchagents Zeichnungskompetenz vielversprechend ist, kann es noch keine professionellen Skizzen erstellen. Es macht einfache Darstellungen von Konzepten unter Verwendung von Stick -Figuren und Kritzeleien, kämpft jedoch darum, Dinge wie Logos, Sätze, komplexe Kreaturen wie Einhörner und Kühe und bestimmte menschliche Figuren zu kritzeln.

Zuweilen missverstanden ihr Modell auch die Absichten der Benutzer in kollaborativen Zeichnungen, wie als Sketchagent einen Hasen mit zwei Köpfen zog. Laut Vinker kann dies daran liegen, dass das Modell jede Aufgabe in kleinere Schritte (auch als „Kette der Gedankenkette“ bezeichnet) unterteilt. Bei der Arbeit mit Menschen erstellt das Modell einen Zeichnungsplan, der möglicherweise falsch interpretiert, zu welchem Teil dieser Umrisse ein Mensch beiträgt. Die Forscher könnten diese Zeichnungsfähigkeiten möglicherweise verfeinern, indem sie synthetische Daten aus Diffusionsmodellen trainieren.

Darüber hinaus erfordert Sketchagent häufig einige Runden, um menschliche Kritzeleien zu erzeugen. In Zukunft soll das Group es einfacher machen, mit multimodalen Sprachmodellen zu interagieren und zu skizzieren, einschließlich der Verfeinerung der Schnittstelle.

Dennoch schlägt das Instrument vor, dass KI verschiedene Konzepte wie Menschen anziehen könnte, mit Schritt-für-Schritt-Human-AI-Zusammenarbeit, die zu einer besseren endgültigen Designs führt.

Diese Arbeit wurde zum Teil von der US Nationwide Science Basis, einem Hoffman-yee-Stipendium des Stanford Institute for Human-Centered AI, der Hyundai Motor Co., dem Forschungslabor der US-Armee, dem Zuckerman STEM-Führungsprogramm und einem Viterbi-Stipendium unterstützt.