Die KI-Picture-Generierung, die sich auf neuronale Netzwerke stützt, um neue Bilder aus verschiedenen Eingaben zu erstellen, einschließlich Texteingabeaufforderungen-wird voraussichtlich bis Ende dieses Jahrzehnts zu einer Milliarden-Greenback-Branche werden. Selbst mit der heutigen Technologie, wenn Sie ein phantasievolles Bild von einem Freund machen wollten, der eine Flagge auf dem Mars pflanzt oder ohne Haft in ein schwarzes Loch fliegt, könnte es weniger als eine Sekunde dauern. Bevor sie jedoch solche Aufgaben ausführen können, werden Bildgeneratoren häufig auf massiven Datensätzen geschult, die Millionen von Bildern enthalten, die häufig mit dem zugehörigen Textual content gepaart werden. Das Coaching dieser generativen Modelle kann eine mühsame Aufgabe sein, die Wochen oder Monate dauert und in dem Prozess enorme Rechenressourcen verbraucht.

Aber was wäre, wenn es möglich wäre, Bilder über AI -Methoden zu generieren, ohne überhaupt einen Generator zu verwenden? Diese reale Möglichkeit wurde zusammen mit anderen faszinierenden Ideen in a beschrieben Forschungspapier Präsentiert auf der Internationalen Konferenz über maschinelles Lernen (ICML 2025), das Anfang dieses Sommers in Vancouver, British Columbia, stattfand. Das Papier, in dem neuartige Techniken zum Manipulieren und Generieren von Bildern beschrieben wurden, wurde von Lukas Lao Beyer, einem Scholar -Forscher des MIT -Labors für Data und Entscheidungssysteme (LIDS), geschrieben. Tianhong Li, ein Postdoc im MIT -Labor für Informatik und künstliche Intelligenz (CSAIL); Xinlei Chen von Fb AI Analysis; Sertac Karaman, MIT -Professor für Luftfahrt und Astronautik und Direktor von Lids; und Kaiming HE, ein MIT Affiliate Professor für Elektrotechnik und Informatik.

Diese Gruppenbemühungen hatten seinen Ursprung in einem Klassenprojekt für ein Graduiertenseminar zu Deep Generative Fashions, das Lao Beyer im vergangenen Herbst eingenommen hat. In Gesprächen während des Semesters wurde es sowohl Lao Beyer als auch dem, den das Seminar unterrichtete, deutlich, dass diese Forschung ein echtes Potenzial hatte, das weit über die Grenzen einer typischen Hausaufgabe hinausging. Andere Mitarbeiter wurden bald in das Bestreben gebracht.

Der Ausgangspunkt für die Untersuchung von Lao Beyer struggle ein Papier im Juni 2024, das von Forschern der Technischen Universität von München und dem chinesischen Unternehmen Bytedance verfasst wurde und eine neue Methode zur Vertretung visueller Informationen einführte, die als eindimensionale Tokenzaizer bezeichnet werden. Mit diesem Gerät, bei dem es sich auch um eine Artwork neuronales Netzwerk handelt, kann ein 256×256-Pixel-Bild in eine Sequenz von nur 32 Zahlen übersetzt werden, die als Token bezeichnet werden. „Ich wollte verstehen, wie ein so hohes Komprimierungsgrad erreicht werden konnte und was die Token selbst tatsächlich vertreten“, sagt Lao Beyer.

Die vorherige Technology von Tokenisierern würde in der Regel das gleiche Bild in ein Array von 16×16 -Token zerlegen – wobei jedes Token in stark kondensierter Kind einen bestimmten Teil des Originalbildes entspricht. Die neuen 1D -Tokenizer können ein Bild effizienter codieren, indem sie insgesamt weit weniger Tokens verwenden, und diese Token können Informationen über das gesamte Bild erfassen, nicht nur einen einzelnen Quadranten. Jede dieser Token ist außerdem eine 12-stellige Zahl, die aus 1s und 0s besteht, die 2 ermöglicht12 (oder ungefähr 4.000) Möglichkeiten insgesamt. „Es ist wie ein Wortschatz von 4.000 Wörtern, die eine abstrakte, verborgene Sprache ausmachen, die vom Pc gesprochen wird“, erklärt er. „Es ist nicht wie eine menschliche Sprache, aber wir können trotzdem versuchen herauszufinden, was es bedeutet.“

Genau das hatte Lao Beyer sich zunächst vorgenommen – Arbeiten, die den Samen für das ICML 2025 -Papier lieferten. Der Ansatz, den er verfolgte, struggle ziemlich einfach. Wenn Sie herausfinden möchten, was ein bestimmtes Token tut, sagt Lao Beyer: „Sie können es einfach herausnehmen, einen zufälligen Wert auszeigen und feststellen, ob sich die Ausgabe zu erkennbaren.“ Er fand einen Token, der die Bildqualität ersetzt und ein Bild mit niedrigem Auflösung in ein hochauflösendes Bild verwandelt oder umgekehrt. Ein weiterer Token beeinflusste die Unschärfe im Hintergrund, während ein anderer die Helligkeit immer noch beeinflusste. Er fand auch ein Token, das mit der „Pose“ zusammenhängt, was bedeutet, dass beispielsweise nach dem Bild eines Robins sich der Kopf des Vogels von rechts nach hyperlinks verlagern könnte.

„Dies struggle ein nie zuvor gesehenes Ergebnis, da niemand visuell identifizierbare Veränderungen aus manipulierenden Token beobachtet hatte“, sagt Lao Beyer. Der Befund erhöhte die Möglichkeit eines neuen Ansatzes zur Bearbeitung von Bildern. Und die MIT -Gruppe hat tatsächlich gezeigt, wie dieser Prozess optimiert und automatisiert werden kann, so dass Token nacheinander nicht von Hand geändert werden müssen.

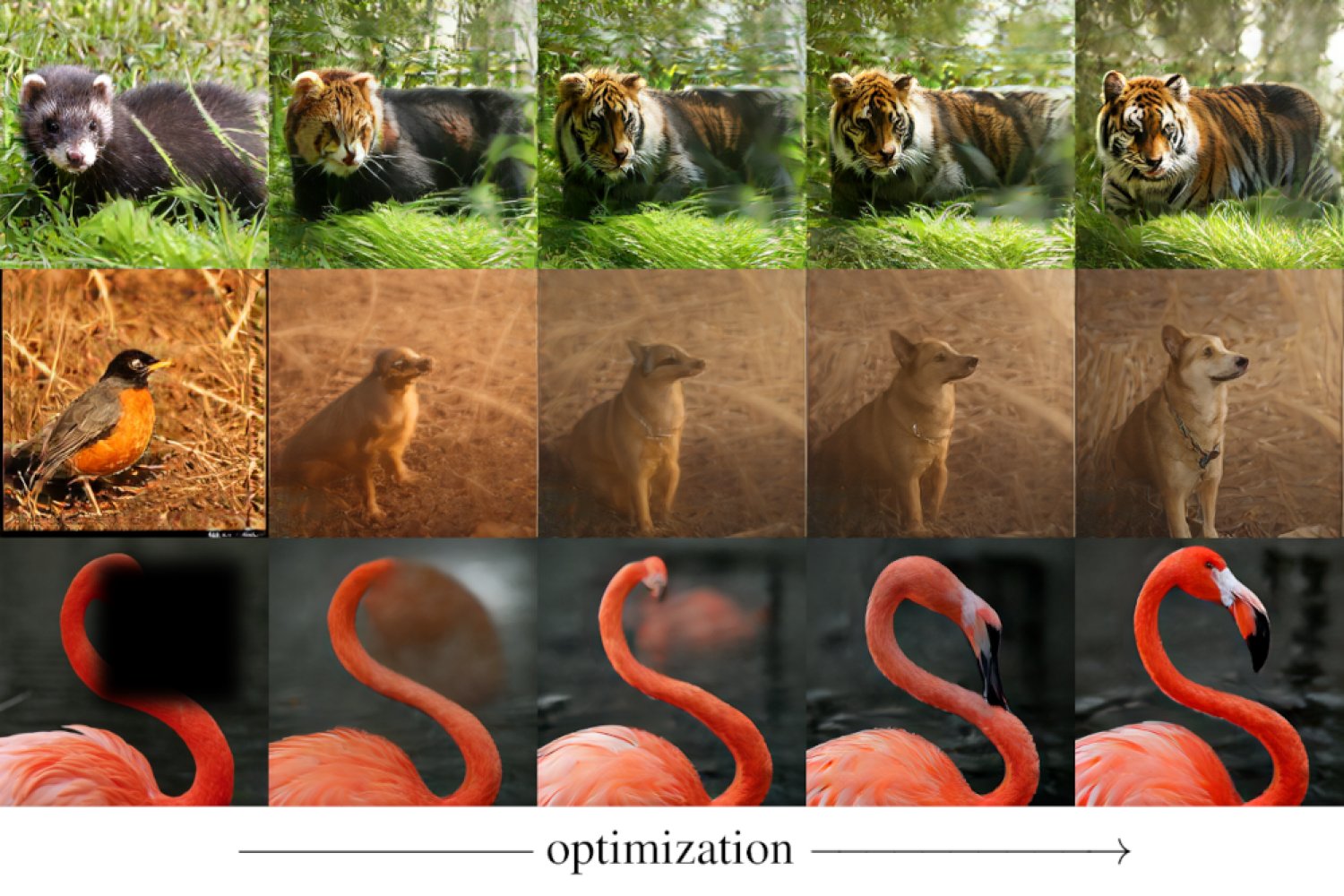

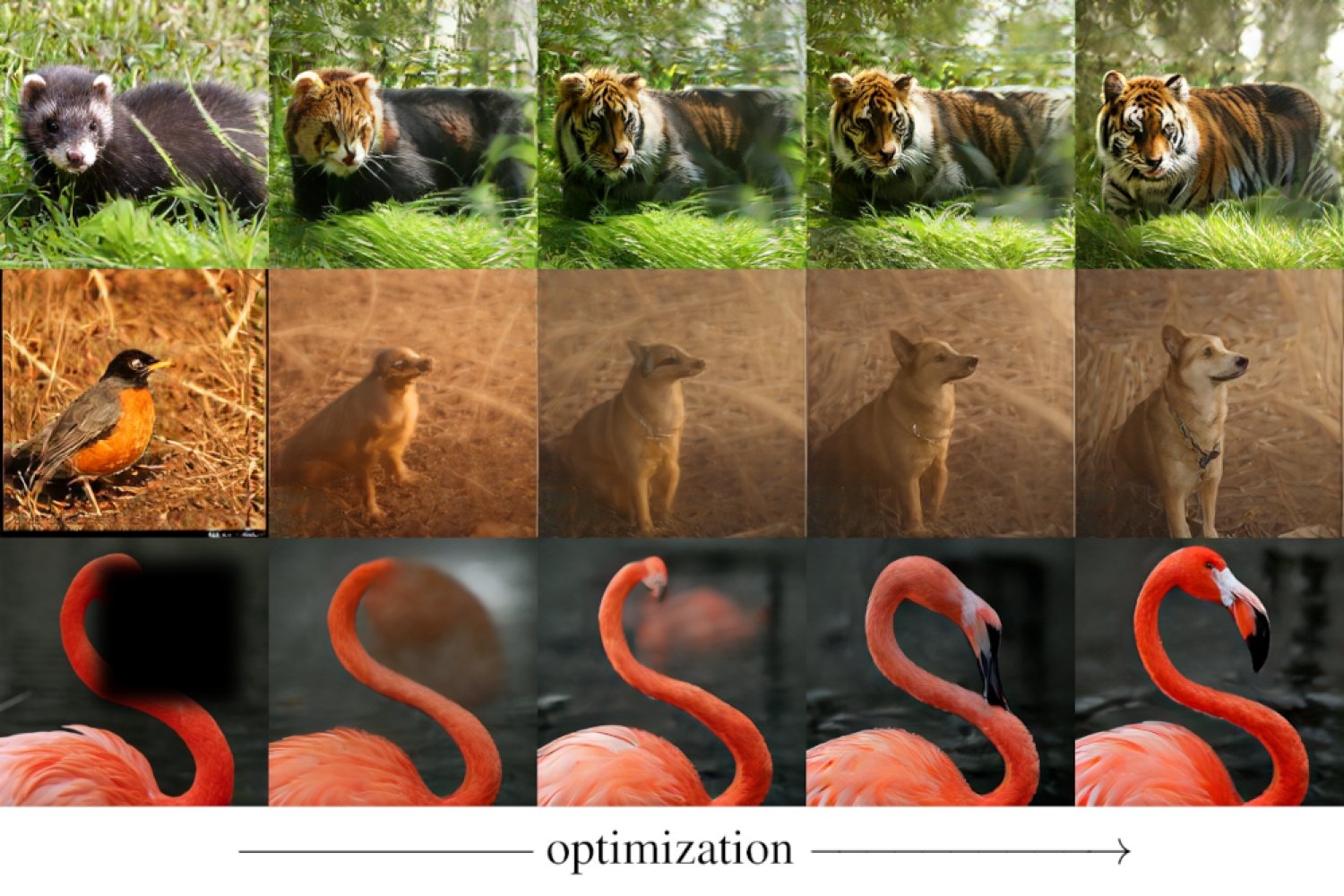

Er und seine Kollegen erzielten ein noch konsequenteres Ergebnis, das die Bilderzeugung umfasste. Ein System, das Bilder normalerweise erzeugen kann, erfordert normalerweise einen Tokenizer, der visuelle Daten komprimiert und codiert, zusammen mit einem Generator, der diese kompakten Darstellungen kombinieren und anordnen kann, um neue Bilder zu erstellen. Die MIT -Forscher fanden einen Weg, Bilder zu erstellen, ohne überhaupt einen Generator zu verwenden. Ihr neuer Ansatz verwendet einen 1D-Tokenizer und einen sogenannten Detokenisierer (auch als Decoder bezeichnet), der ein Bild von einer Reihe von Token rekonstruieren kann. Mit Anleitungen, die durch ein abgeschaltetes neuronales Netzwerk namens Clip geliefert werden, das nicht selbst Bilder generieren kann, aber messen kann, wie intestine ein bestimmtes Bild mit einer bestimmten Textaufforderung übereinstimmt-konnte das Group beispielsweise ein Bild eines roten Pandas in einen Tiger umwandeln. Darüber hinaus können sie Bilder eines Tigers oder einer anderen gewünschten Kind erstellen, die vollständig von vorne beginnen – aus einer State of affairs, in der allen Token ursprünglich zufällige Werte zugeordnet werden (und dann iterativ operativ so gepoppt werden, dass dem rekonstruierten Bild zunehmend mit der gewünschten Textaufforderung übereinstimmt).

Die Gruppe zeigte, dass mit demselben Setup, der sich auf einen Tokenizer und einen Detokener stützt, aber ohne Generator – auch „Inpainting“ erledigen konnte, was bedeutet, dass Teile von Bildern, die irgendwie ausgeblendet waren, ausfüllen. Die Vermeidung der Verwendung eines Turbines für bestimmte Aufgaben kann zu einer erheblichen Reduzierung der Rechenkosten führen, da Generatoren, wie erwähnt, normalerweise ein umfassendes Coaching erfordern.

Was an den Beiträgen dieses Groups seltsam erscheinen magazine, erklärt er, „ist, dass wir nichts Neues erfunden haben. Wir haben keinen 1D -Tokenizer erfunden, und wir haben das Clip -Modell auch nicht erfunden. Wir haben jedoch festgestellt, dass neue Funktionen entstehen können, wenn Sie all diese Teile zusammenfügen.“

„Diese Arbeit definiert die Rolle von Tokenizern neu“, kommentiert Saining Xie, Informatiker an der New York College. „Es zeigt, dass Bild-Tokenisierer-Werkzeuge, die normalerweise nur zum Komprimieren von Bildern verwendet werden-tatsächlich viel mehr tun können. Die Tatsache, dass ein einfacher (aber hochkomprimierter) 1D-Tokenizer Aufgaben wie Inpfle oder textgesteuerte Bearbeitung erledigen kann, ohne ein volles Generativmodell trainieren zu müssen, ist ziemlich überraschend.“

Zhuang Liu von der Princeton College stimmt zu und sagt, dass die Arbeit der MIT-Gruppe „zeigt, dass wir die Bilder auf eine Weise generieren und manipulieren können, die viel einfacher ist als bisher, im Grunde genommen zeigt es, dass Bildgenerierung ein Nebenprodukt eines sehr effektiven Bildkompressors sein kann, was möglicherweise die Kosten der Generierung von Bildern mehrere Falte einsetzt.“

Es könnte viele Anwendungen außerhalb des Bereichs des Pc Imaginative and prescient geben, schlägt Karaman vor. „Zum Beispiel könnten wir in Betracht ziehen, die Handlungen von Robotern oder selbstfahrenden Autos auf die gleiche Weise zu Tokenisieren, was die Auswirkungen dieser Arbeit schnell erweitern kann.“

Lao Beyer denkt in ähnlicher Weise und stellt fest, dass die excessive Komprimierung von 1D -Tokenizern es Ihnen ermöglicht, „einige erstaunliche Dinge“ zu machen, die auf andere Felder angewendet werden könnten. Zum Beispiel im Bereich selbstfahrender Autos, die eines seiner Forschungsinteressen sind, könnten die Token anstelle von Bildern die verschiedenen Routen darstellen, die ein Fahrzeug aufnehmen könnte.

Xie ist auch fasziniert von den Anwendungen, die aus diesen innovativen Ideen stammen können. „Es gibt einige wirklich coole Anwendungsfälle, die sich freischalten können“, sagt er.