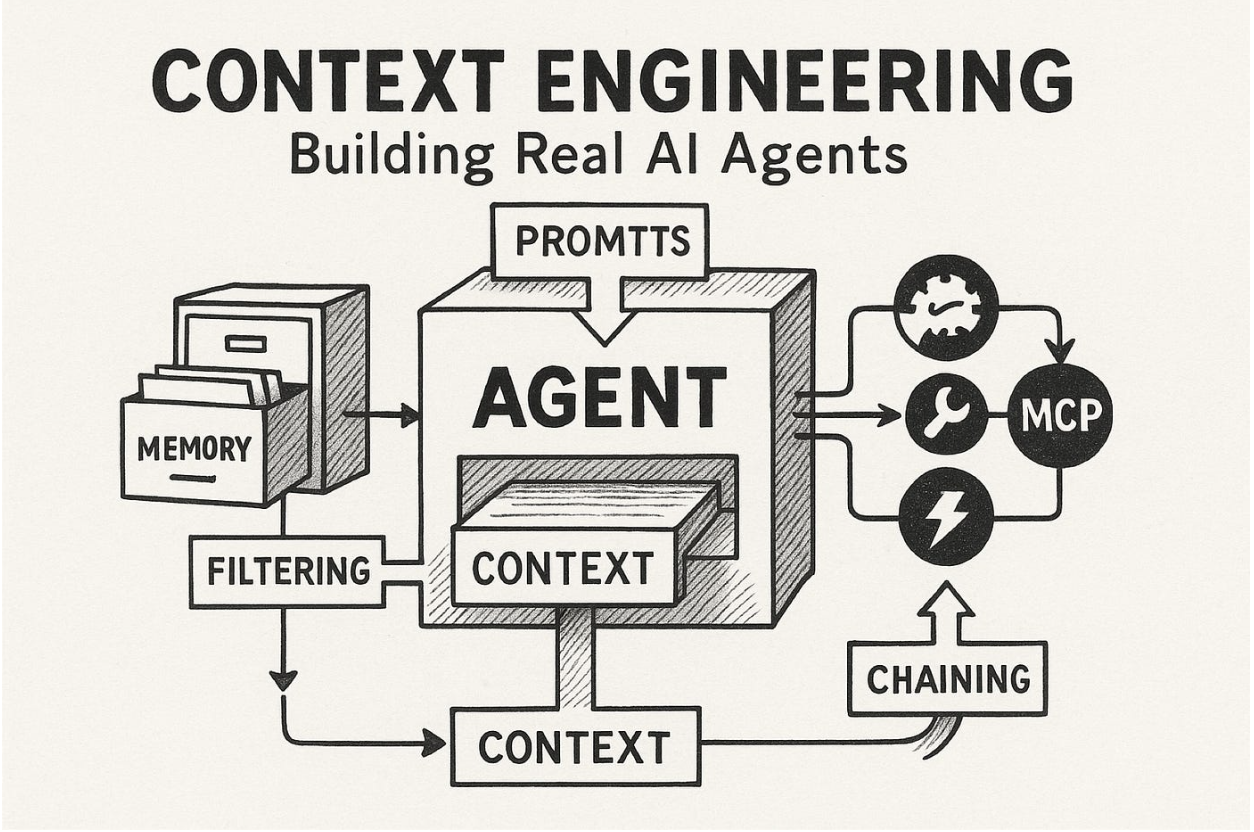

Aufbau effektiver KI -Agenten bedeutet mehr als nur ein leistungsstarkes Sprachmodell auszuwählen. Wie das Manus -Projekt entdeckte, ist die Artwork und Weise, wie Sie den „Kontext“ entwerfen und verwalten – die Informationen, die die KI -Prozesse für Entscheidungen treffen – von größter Bedeutung. Dieser „Kontext -Engineering“ wirkt sich direkt auf die Geschwindigkeit, Kosten, Zuverlässigkeit und Intelligenz eines Agenten aus.

Zunächst battle die Wahl klar: Nutzen Sie das In-Kontext-Lernen von Frontier-Modellen über langsame, iterative Feinabstimmungen. Dies ermöglicht schnelle Verbesserungen, Versandänderungen in Stunden statt Wochen, wodurch das Produkt an die sich entwickelnden KI -Fähigkeiten anpassbar ist. Dieser Weg erwies sich jedoch weitaus einfach und führte zu mehreren Rahmen, die sie durch den „stochastischen Abstieg der Absolventen“ – einen Prozess der experimentellen Vermutung, liebevoll als „stochastischen Abstiegsabstieg“ bezeichneten.

Hier sind die kritischen Lektionen, die bei Manus für effektive Kontext -Engineering gezogen wurden:

1. Design um den KV-Cache entwerfen

Der KV-Cache ist für die Leistung der Agenten von entscheidender Bedeutung, die sich direkt auf Latenz und Kosten auswirkt. Agenten fügen Aktionen und Beobachtungen kontinuierlich an ihren Kontext hinzu und machen die Eingabe erheblich länger als die Ausgabe. KV-CACHE wiederverwendet den identischen Kontext-Präfixen und verkürzt die Verarbeitungszeit und -kosten drastisch (z. B. ein 10-fach-Kostenunterschied mit Claude-Sonnet).

Maximieren Sie KV-Cache-Hits:

- Stabile schnelle Präfixe: Selbst eine einzelne Änderung zu Beginn Ihrer Systemaufforderung kann den Cache ungültig machen. Vermeiden Sie dynamische Elemente wie präzise Zeitstempel.

- Nur der Kontext nur anhängen: Vergangene Handlungen oder Beobachtungen nicht ändern. Stellen Sie sicher, dass die deterministische Serialisierung von Daten (wie JSON), um subtile Cache -Pausen zu verhindern.

- Explizite Cache -Haltepunkte: Einige Frameworks erfordern eine manuelle Einführung von Cache -Haltepunkten, idealerweise nach der Eingabeaufforderung des Methods.

2. Maske, nicht entfernen

Wenn Agenten mehr Werkzeuge gewinnen, wird ihr Aktionsraum komplex und „den Agenten dumbig“, da es sich kämpft, korrekt zu wählen. Während dynamisches Software-Laden intuitiv erscheinen magazine, macht es den KV-Cache ungültig und verwirrt das Modell, wenn der vergangene Kontext auf undefinierte Instruments bezieht.

Manus verwendet stattdessen eine kontextbewusste Zustandsmaschine, um die Verfügbarkeit von Werkzeugen durch zu verwalten Maskierungstoken -Protokolle Während des Dekodierens. Dies verhindert, dass das Modell nicht verfügbare oder unangemessene Aktionen auswählt, ohne die Kern -Software -Definitionen zu ändern, den Kontext stabil und den Agenten fokussiert zu halten.

3. Verwenden Sie das Dateisystem als Kontext

Selbst bei großen Kontextfenstern (128K+ Token) können reale agierische Beobachtungen (wie Webseiten oder PDFs) die Grenzwerte leicht überschreiten, die Leistung beeinträchtigen und hohe Kosten verursachen. Irreversible Komprimierungsrisiken verlieren entscheidende Informationen, die für zukünftige Schritte erforderlich sind.

Manus behandelt das Dateisystem als den ultimativen, unbegrenzten Kontext. Der Agent lernt, von Dateien auf Anfrage zu lesen und sie in Dateien zu schreiben. Verwenden des Dateisystems als externalisierte, strukturierte reminiscence.

4.. Manipulieren Sie die Aufmerksamkeit durch Rezitation

Agenten können den Fokus verlieren oder langfristige Ziele bei komplexen, mehrstufigen Aufgaben vergessen. Manus geht dies an, indem der Agent eine todo.md -Datei ständig umschreibt. Durch die Rezitation seiner Ziele und Fortschritte in das Ende des Kontextes ist die Aufmerksamkeit des Modells auf seinen globalen Plan voreingenommen, die Probleme mit „Verlorenen in der Mitte“ mildern und das Ziel-Fehlausrichtung verringern. Dies nutzt die natürliche Sprache, um den Fokus der KI ohne architektonische Veränderungen zu beeinflussen.

5. Halten Sie das falsche Zeug in

Agenten werden Fehler machen – Halluzinat, Begegnung mit Fehlern, schlecht benehmen. Der natürliche Impuls besteht darin, diese Fehler zu beseitigen. Manus stellte jedoch fest, dass das Verlassen gescheiterter Handlungen und Beobachtungen im Kontext die internen Überzeugungen des Modells implizit aktualisiert. Das Sehen seiner eigenen Fehler hilft dem Agenten dabei, das Erlernen und Reduzieren der Wahrscheinlichkeit des gleichen Fehlers zu lernen und die Fehlerwiederherstellung zu einem wichtigen Indikator für echtes Agentenverhalten zu machen.

6. Lassen Sie sich nicht nur wenige verarbeiten lassen

Während nur wenige Schussanforderungen für LLMs leistungsfähig sind, kann es in Agenten nach hinten losgehen, indem sie zu Mimikry und suboptimalen, sich wiederholenden Verhaltensweisen führen. Wenn der Kontext mit ähnlichen Motion-Bobservation-Paaren zu einheitlich ist, kann der Agent in eine Rut fallen, was zu Drift oder Halluzination führt.

Die Lösung ist kontrollierte Vielfalt. Manus führt kleine Variationen in Serialisierungsvorlagen, Phrasierung oder Formatierung im Kontext ein. Dieses „Rauschen“ hilft, sich wiederholende Muster zu brechen und die Aufmerksamkeit des Modells zu verschieben und zu verhindern, dass es in einer starre Nachahmung vergangener Handlungen steckt.

Zusammenfassend ist Context Engineering sehr neu, aber ein kritisches Feld für AI -Agenten. Es geht über die RAW -Modellleistung hinaus und diktiert, wie ein Agent das Gedächtnis verwaltet, mit seiner Umgebung interagiert und aus dem Suggestions lernt. Das Beherrschen dieser Prinzipien ist für den Aufbau robuster, skalierbarer und intelligenter AI -Agenten von wesentlicher Bedeutung.

Sponsoring -Gelegenheit: Erreichen Sie die einflussreichsten KI -Entwickler in den USA und in Europa. 1m+ monatliche Leser, 500.000+ Gemeindebauer, unendliche Möglichkeiten. (Sponsoring erkunden)