Wie verhindern Sie, dass das Reinforcement Studying für große Reasoning-Modelle bei einigen sehr langen, sehr langsamen Rollouts ins Stocken gerät, während die GPUs nicht ausgelastet sind? ein Forscherteam aus Moonshot AI und die Tsinghua-Universität stellen „Seer“ vorein neues On-line-Kontextlernsystem, das auf einen bestimmten Systemengpass beim verstärkenden Lernen für große Sprachmodelle abzielt. Bei synchronen On-Coverage-Setups dominiert die Rollout-Section die Kosten jeder Iteration. Seer strukturiert diese Section neu und meldet Rollout-Durchsatzsteigerungen von 74 bis 97 Prozent und Reduzierungen der Tail-Latenz von 75 bis 93 Prozent im Vergleich zu einer starken synchronen Basislinie namens veRL.

Warum der synchrone Rollout für Reasoning-Modelle langsam ist?

Moderne RL-Arbeitslasten zum Denken verwenden eine lange Kette von Gedankenstilausgaben. In den Seer-Experimenten wenden die Forscher GRPO auf drei verschiedene Modelle an: Moonlight, Qwen2 VL 72B und Kimi K2. Diese Workloads werden auf 32 Rechenknoten mit 8 H800-GPUs professional Knoten ausgeführt. Die drei Aufgaben nutzen jeweils 32, 128 und 256 GPUs mit 400, 600 und 800 Eingabeaufforderungen professional Iteration und 8 oder 16 Antworten professional Eingabeaufforderung.

Die maximale Generationslänge ist groß. Moonlight ist für 65.536 Token konfiguriert, Qwen2 VL 72B für 40.960 Token und Kimi K2 für 98.304 Token. Eine einzelne lange Gedankenkette kann mit fortschreitender Dekodierung von einigen hundert Megabyte KVCache auf mehrere zehn Gigabyte anwachsen. Dieses Speicherwachstum zwingt Instanzen dazu, die Parallelität zu reduzieren oder Anfragen zuvorzukommen, was eine kostspielige Neudekodierung auslöst.

Das Forschungsteam definiert Tail Requests als die letzten 10 Prozent der Requests, die bei einem Rollout abgeschlossen werden müssen. Bei Moonlight und Qwen2 VL 72B kann allein dieser Schweif bis zu 50 Prozent der gesamten Rollout-Zeit im Basissystem in Anspruch nehmen. Der Rollout dominiert bereits die Iterationszeit, sodass dieser Tail-Effekt RL direkt verlangsamt.

Seer-Architektur auf Mooncake und vLLM

Seer hält den RL-Algorithmus identisch mit dem synchronen veRL. Jede Trainingsiteration verwendet nur Daten aus der aktuellen Rollout-Iteration, sodass das System das Richtlinienverhalten beibehält. In der Trainingsphase wird Megatron zur verteilten Optimierung verwendet. In der Rollout-Section wird eine interne Implementierung von vLLM als Inferenz-Engine verwendet.

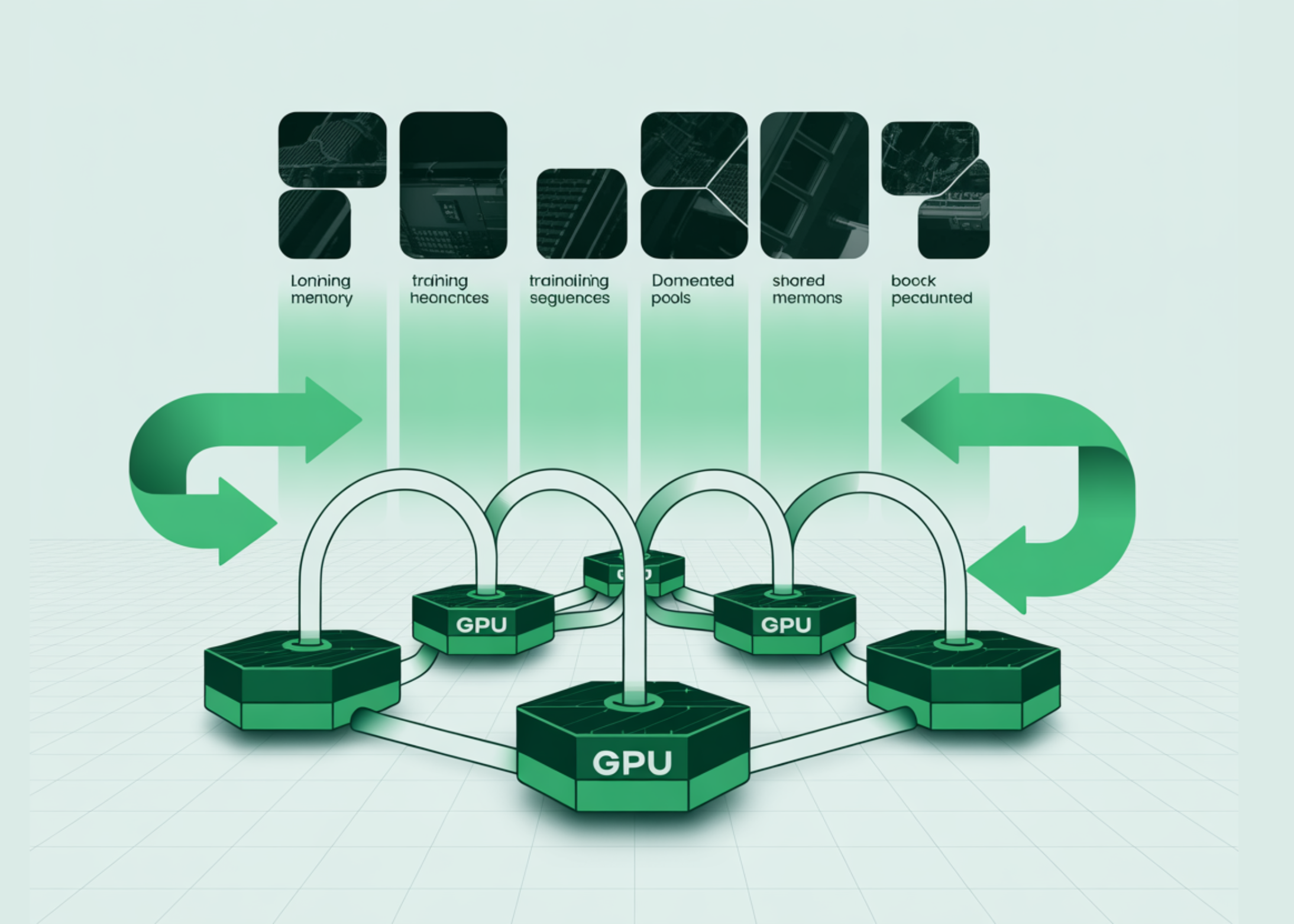

Um eine aggressive Anforderungsplanung zu unterstützen, verlässt sich Seer auf einen globalen KVCache-Pool, der auf der disaggregierten KVCache-Architektur von Mooncake basiert, die in der Produktion für Kimi verwendet wird. Mooncake bietet einen zweistufigen DRAM- und SSD-KV-Cache-Speicher, der von allen Inferenzknoten gemeinsam genutzt wird, was es Seer ermöglicht, Anforderungen zu migrieren, ohne Vorabfüllungen neu berechnen zu müssen.

Auf diesem Substrat liegt Seer stellt drei Schlüsselmechanismen vor:

- Geteilter Rollout

- Kontextbewusste Planung

- Adaptive gruppierte spekulative Dekodierung

Diese werden durch einen Anforderungspuffer, einen Kontextmanager und einen Inferenz-Engine-Pool orchestriert, der mit dem globalen KVCache-Pool verbunden ist.

Geteilter Rollout, fein abgestimmte Planung und Migration

Beim herkömmlichen synchronen Rollout werden Inferenzinstanzen ganze GRPO-Gruppen zugewiesen. Eine Gruppe ist eine Reihe von Anfragen, die eine gemeinsame Eingabeaufforderung haben. Nach der Zuweisung bleibt eine Gruppe auf derselben Instanz, bis alle Antworten abgeschlossen sind. Aufgrund der großen Unterschiede in den Ausgangslängen führt dies zu Lastungleichgewichten und langen Nachzüglern.

Seer unterteilt Gruppen in zwei Schritte. Es zerlegt zunächst jede Gruppe in einzelne Anfragen. Anschließend wird jede Anfrage basierend auf der Generierungslänge in mehrere Blöcke unterteilt. Wenn der Scheduler eine Anforderung aus dem Anforderungspuffer sendet, legt er einen kleinen maximalen Token-Wert fest, z. B. 8.000 Token für diesen Block. Nach jedem Block wird die Anforderung erneut in die Warteschlange gestellt, bis sie ein Ende-der-Sequenz-Token oder ihr ursprüngliches maximales Token-Restrict erreicht.

Da KVCache im globalen KVCache-Pool gespeichert wird, können geteilte Anforderungen zwischen Instanzen an Chunk-Grenzen verschoben werden, ohne dass die Vorabfüllung erneut ausgeführt werden muss. Der Scheduler verwaltet ein Parallelitätsniveau, das die Speicherauslastung hoch hält und gleichzeitig eine vorzeitige Belegung vermeidet. Dies reduziert die Verschwendung und sorgt für eine gleichmäßigere KVCache-Nutzung während der gesamten Iteration.

Kontextbewusste Planung mithilfe von Gruppenlängenstatistiken

Das Forschungsteam beobachtete, dass verschiedene Anfragen in derselben Gruppe tendenziell korrelierende Ausgabelängen haben. Seer nutzt diese Struktur als On-line-Kontext. Für jede Eingabeaufforderungsgruppe wird eine Anfrage als spekulative Anfrage festgelegt. Der Scheduler hält spekulative Anfragen in einer Warteschlange mit hoher Priorität und bedient sie mit der kleinsten ersten Richtlinie basierend auf den bisher generierten Token. Kurze Anfragen werden schnell abgeschlossen und beendet. Lange Anfragen bleiben bestehen und identifizieren Gruppen, die potenzielle Schlusskandidaten sind.

Der Kontextmanager verwaltet eine Längenschätzung für jede Gruppe. Diese Schätzung wird auf die maximal generierte Länge unter den abgeschlossenen Anforderungen in der Gruppe aktualisiert. Wenn keine Anfrage abgeschlossen wurde, werden die ursprünglichen maximalen Token als konservative Grenze verwendet. Sobald spekulative Anfragen in Bearbeitung sind oder erledigt sind, plant Seer die verbleibenden Anfragen mit der ungefähren längsten ersten Richtlinie auf Gruppenebene. Dieses Design erreicht einen Durchsatz und ein Tail-Verhalten, das einem Oracle-Scheduler ähnelt, der alle Ausgabelängen im Voraus kennt.

Adaptive gruppierte spekulative Dekodierung

Seer fügt zusätzlich zu den beiden vorherigen Komponenten Adaptive Grouped Speculative Decoding hinzu, um die Decodierung zu beschleunigen, insbesondere bei langen Anfragen im Tail. Es führt einen verteilten gruppierten Entwurf ein Serveroder DGDS. DGDS verwaltet einen komprimierten Suffixbaum für jede Gruppe und aggregiert Tokensequenzen aus allen Anforderungen in dieser Gruppe. Instanzen hängen generierte Token asynchron an DGDS an, rufen regelmäßig aktualisierte Suffixbäume ab und führen eine lokale spekulative Dekodierung basierend auf den gemeinsam genutzten Musterstatistiken durch.

Das System passt die Entwurfslänge und die Anzahl der Pfade entsprechend der Modellarchitektur, der Chargengröße und der gemessenen Akzeptanzlänge an. Für dichte Modelle und Combination-of-Specialists-Modelle berechnet es vorab unterschiedliche Spekulationsschwellenwerte und verwendet sie, um die Entwurfstiefe für jede Cost zu begrenzen. In späten Endstadien ist die Parallelität gering, daher erhöht Seer die Draft-Tiefe und ermöglicht Multi-Path-Drafting, um akzeptierte Token professional Schritt zu erhöhen.

Ablationsergebnisse zeigen, dass ein geteilter Rollout eine Durchsatzverbesserung von bis zu 35 Prozent gegenüber dem Ausgangswert bringt. Durch das Hinzufügen einer kontextbezogenen Planung erhöht sich dieser Wert auf bis zu 47 Prozent gegenüber dem Ausgangswert. Durch die Aktivierung der gruppierten spekulativen Dekodierung wird die Gesamtgeschwindigkeit in der ausgewerteten Iteration auf 77 bis 87 Prozent gegenüber dem Ausgangswert erhöht.

Durchgängige Auswirkung auf das RL-Coaching

Das Forschungsteam bewertet Seer anhand von drei RL-Aufgaben, die auf Moonlight, Qwen2 VL 72B und Kimi K2 basieren. Sie führen 10 Rollout-Iterationen professional Aufgabe durch und messen die Ausgabetokens professional Sekunde und die Abschlusszeit für jeden Rollout. Seer verbessert den Rollout-Durchsatz bei diesen Workloads um 74 bis 97 Prozent im Vergleich zu veRL mit demselben RL-Algorithmus und der gleichen vLLM-basierten Inferenz-Engine.

Die Tail-Latenz wird um 75 bis 93 Prozent reduziert. Bei speicherbeschränkten Aufgaben verbringt das Basissystem bis zur Hälfte seiner Zeit mit den letzten 10 Prozent der Anfragen. Seer beseitigt den größten Teil dieses Issues durch die Kombination von geteiltem Rollout, kontextbewusster Planung und adaptiver gruppierter spekulativer Dekodierung auf dem Mooncake-basierten globalen KVCache-Pool.

Wichtige Erkenntnisse

- Rollout-Engpass: Seer zielt auf die Rollout-Section von synchronem RL ab, die etwa 63 % bis 87 % der Iterationszeit ausmacht und von Lengthy-Tail-Anfragen und KV-Cache-Fragmentierung dominiert wird.

- Drei Kernmechanismen: Seer kombiniert geteiltes Rollout, kontextbewusste Planung und adaptive gruppierte spekulative Dekodierung, um die Ausgabelänge und Musterähnlichkeit zwischen GRPO-Antworten auszunutzen, die eine Eingabeaufforderung teilen.

- Fein abgestimmte Planung für einen globalen KV-Cache: Anforderungen werden in Blöcke aufgeteilt und über einen globalen KVCache-Pool im Mooncake-Stil migriert, der die Synchronität der Richtlinien-RL gewährleistet, gleichzeitig die GPU-Speicherauslastung hoch hält und vorzeitige Unterbrechungen reduziert.

- On-line-Kontext zur Reduzierung der Tail-Latenz: Längenstatistiken auf Gruppenebene aus spekulativen Anfragen ermöglichen eine kontextbewusste Planung, die sich einem Oracle-Longest-First-Scheduler annähert und die Zeit, die für die letzten 10 Prozent der Anfragen aufgewendet wird, deutlich reduziert.

- Gemessene Finish-to-Finish-Gewinne: Bei RL-Workloads in Produktionsqualität mit Moonlight, Qwen2 VL 72B und Kimi K2 verbessert Seer den Rollout-Durchsatz um 74 % bis 97 % und reduziert die Lengthy-Tail-Latenz um 75 % bis 93 % im Vergleich zu einer hochmodernen synchronen vLLM-basierten Basislinie.

Seer ist ein wichtiger Systembeitrag, da es die Rollout-Section im synchronen RL optimiert, ohne den zugrunde liegenden GRPO-Algorithmus zu ändern, sodass Richtliniengarantien und Reproduzierbarkeit gewahrt bleiben und gleichzeitig ein echter Infrastrukturengpass behoben wird. Die Kombination aus geteiltem Rollout, kontextbewusster Planung und adaptiver gruppierter spekulativer Dekodierung bietet eine praktische Vorlage für andere RL-Stacks, die auf Modellen mit langer Gedankenkette und großen KVCache-Footprints basieren. Insgesamt zeigt Seer, dass das On-line-Kontextlernen auf Systemebene mittlerweile genauso wichtig ist wie die Modellarchitektur für die effiziente Skalierung von Reasoning RL.

Schauen Sie sich das an Papier hier. Schauen Sie sich gerne bei uns um GitHub-Seite für Tutorials, Codes und Notebooks. Sie können uns auch gerne weiter folgen Twitter und vergessen Sie nicht, bei uns mitzumachen 100.000+ ML SubReddit und Abonnieren Unser E-newsletter. Warten! Bist du im Telegram? Jetzt können Sie uns auch per Telegram kontaktieren.

Asif Razzaq ist CEO von Marktechpost Media Inc.. Als visionärer Unternehmer und Ingenieur setzt sich Asif dafür ein, das Potenzial der künstlichen Intelligenz für das soziale Wohl zu nutzen. Sein jüngstes Unterfangen ist die Einführung einer Medienplattform für künstliche Intelligenz, Marktechpost, die sich durch eine ausführliche Berichterstattung über maschinelles Lernen und Deep-Studying-Nachrichten auszeichnet, die sowohl technisch fundiert als auch für ein breites Publikum leicht verständlich ist. Die Plattform verfügt über mehr als 2 Millionen monatliche Aufrufe, was ihre Beliebtheit beim Publikum verdeutlicht.