In einem Büro im MIT -Labor für Informatik und künstliche Intelligenz (CSAIL) rundet eine weiche Roboterhand seine Finger sorgfältig ab, um ein kleines Objekt zu erfassen. Der faszinierende Teil ist nicht das mechanische Design oder eingebettete Sensoren – tatsächlich enthält die Hand keine. Stattdessen stützt sich das gesamte System auf eine einzelne Kamera, die die Bewegungen des Roboters beobachtet und diese visuellen Daten verwendet, um sie zu steuern.

Diese Fähigkeit stammt aus einem neuen System, das CSAIL -Wissenschaftler entwickelt haben und eine andere Perspektive auf die Roboterkontrolle bieten. Anstatt handgesteuerte Modelle oder komplexe Sensor-Arrays zu verwenden, können Roboter lernen, wie ihr Körper auf Kontrollbefehle reagiert, ausschließlich durch Imaginative and prescient. Der Ansatz, der als neuronale jakobische Felder (NJF) bezeichnet wird, gibt Robotern eine Artwork körperliches Selbstbewusstsein. Ein Open-Entry-Papier über die Arbeiten wurde veröffentlicht in Natur am 25. Juni.

„Diese Arbeit weist auf eine Verschiebung von Programmierrobotern zum Unterrichten von Robotern hin“, sagt Sizhe Lester Li, MIT -PhD -Scholar in Elektrotechnik und Informatik, CSAIL -Accomplice und führender Forscher in der Arbeit. „Heute erfordern viele Robotikaufgaben umfangreiches Engineering und Codieren. In Zukunft stellen wir uns vor, einem Roboter zu zeigen, was zu tun ist, und lassen Sie lernen, wie das Ziel autonom erreicht werden kann.“

Die Motivation ergibt sich aus einer einfachen, aber leistungsstarken Umfragung: Die Hauptbarriere für erschwingliche, versatile Robotik ist keine {Hardware} – die Kontrolle über die Fähigkeit, die auf verschiedene Arten erreicht werden könnte. Traditionelle Roboter sind so starr und sensorreich, was es einfacher macht, einen digitalen Zwilling zu konstruieren, eine präzise mathematische Replik, die zur Kontrolle verwendet wird. Aber wenn ein Roboter weich, deformierbar oder unregelmäßig geformt ist, fallen diese Annahmen auseinander. Anstatt Roboter dazu zu zwingen, unseren Modellen abzustimmen, dreht NJF das Skript um und gibt den Robotern die Möglichkeit, ihr eigenes internes Modell aus der Beobachtung zu lernen.

Schau und lerne

Diese Entkopplung von Modellierung und Hardwaredesign könnte den Entwurfsraum für Robotik erheblich erweitern. In weichen und bio-inspirierten Robotern betten Designer häufig Sensoren ein oder verstärken Teile der Struktur, nur um die Modellierung realisierbar zu machen. NJF hebt diese Einschränkung. Das System benötigt keine Bordsensoren oder Design -Optimierungen, um die Kontrolle zu ermöglichen. Designer sind freier, um unkonventionelle, nicht eingeschränkte Morphologien zu erforschen, ohne sich Sorgen darüber zu machen, ob sie sie später modellieren oder steuern können.

„Überlegen Sie, wie Sie lernen, Ihre Finger zu kontrollieren: Sie wackeln, Sie beobachten, Sie passen sich an“, sagt Li. „Das ist, was unser System tut. Es experimiert mit zufälligen Aktionen und findet heraus, welche Kontrollpersonen die Teile des Roboters bewegen.“

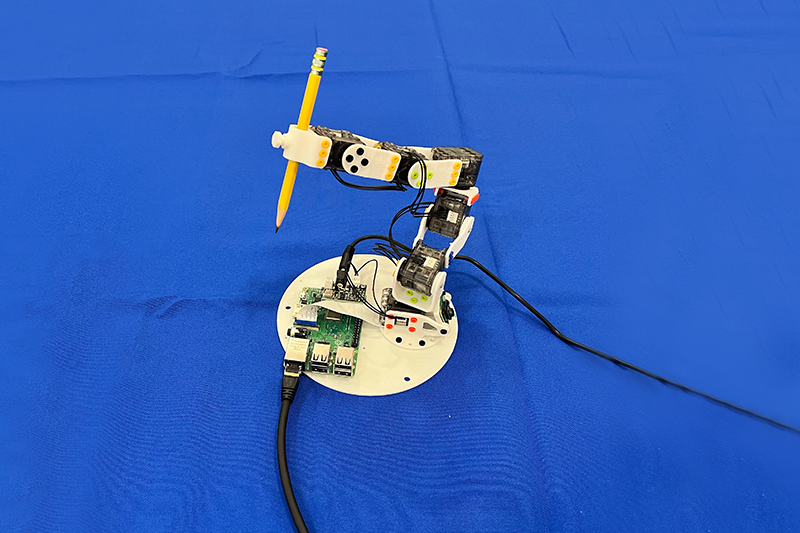

Das System hat sich in einer Reihe von Robotertypen als sturdy erwiesen. Das Staff testete NJF auf einer pneumatischen weichen Roboterhand, die in der Lage warfare, zu kneifen und zu greifen, eine starre Allegrohand, einen 3D-gedruckten Roboterarm und sogar eine rotierende Plattform ohne eingebettete Sensoren. In jedem Fall lernte das System sowohl die Kind des Roboters als auch wie es auf Kontrollsignale reagierte, nur von Sicht und zufälliger Bewegung.

Die Forscher sehen das Potenzial weit über das Labor hinaus. Mit NJF ausgestattete Roboter könnten eines Tages landwirtschaftliche Aufgaben mit Lokalisierungsgenauigkeit auf Zentimeterebene ausführen, auf Baustellen ohne aufwändige Sensorarrays arbeiten oder dynamische Umgebungen navigieren, in denen traditionelle Methoden zusammenbrechen.

Im Kern von NJF befindet sich ein neuronales Netzwerk, das zwei miteinander verflochtene Aspekte der Ausführungsform eines Roboters erfasst: seine dreidimensionale Geometrie und seine Empfindlichkeit gegenüber der Steuerung von Eingaben. Das System baut auf Neural Radiance Fields (NERF) auf, eine Technik, die 3D -Szenen aus Bildern rekonstruiert, indem räumliche Koordinaten auf Farb- und Dichtewerte hergestellt werden. NJF erweitert diesen Ansatz, indem er nicht nur die Kind des Roboters, sondern auch ein jakobisches Feld lernt, eine Funktion, die vorhersagt, wie sich jeder Punkt auf den Körper des Roboters als Reaktion auf Motorbefehle bewegt.

Um das Modell zu trainieren, führt der Roboter zufällige Bewegungen durch, während mehrere Kameras die Ergebnisse aufzeichnen. Es ist keine menschliche Überwachung oder Vorkenntnis der Struktur des Roboters erforderlich – das System stärkt einfach die Beziehung zwischen Kontrollsignalen und Bewegung durch Beobachten.

Sobald das Coaching abgeschlossen ist, benötigt der Roboter nur eine einzelne monokulare Kamera für die Echtzeit-Steuerung mit geschlossenen Schleife, die bei etwa 12 Hertz ausgeführt wird. Dies ermöglicht es, sich selbst kontinuierlich zu beobachten, zu planen und reaktionsmäßig zu handeln. Diese Geschwindigkeit macht NJF praktikabler als viele physikbasierte Simulatoren für weiche Roboter, die oft zu rechenintensiv für Echtzeitgebrauch sind.

In frühen Simulationen konnten selbst einfache 2D -Finger und Schieberegler diese Kartierung mit nur wenigen Beispielen lernen. Durch die Modellierung, wie spezifische Punkte in der Reaktion auf Aktion verformen oder verändern, erstellt NJF eine dichte Karte der Kontrollebarkeit. Dieses interne Modell ermöglicht es ihm, die Bewegung über den Körper des Roboters zu verallgemeinern, auch wenn die Daten laut oder unvollständig sind.

„Was wirklich interessant ist, ist, dass das System selbst herausfindet, welche Motoren die Teile des Roboters steuern“, sagt Li. „Das ist nicht programmiert – es taucht natürlich durch Lernen auf, ähnlich wie eine Particular person, die die Tasten auf einem neuen Gerät entdeckt.“

Die Zukunft ist weich

Seit Jahrzehnten befürwortet die Robotik starre, leicht modellierte Maschinen – wie die industriellen Waffen in Fabriken -, weil ihre Eigenschaften die Kontrolle vereinfachen. Aber das Feld hat sich in Richtung weicher, bio-inspirierter Roboter bewegt, die sich flüssiger an die reale Welt anpassen können. Der Kompromiss? Diese Roboter sind schwerer zu modellieren.

„Robotics fühlt sich heute aufgrund von teuren Sensoren und komplexen Programmieren oft unerreichbar an. Unser Ziel mit neuronalen jakobischen Feldern ist es, die Barriere zu senken und die Robotik erschwinglich, anpassungsfähig und für mehr Personen zugänglich zu machen. Imaginative and prescient ist eine belastbare, zuverlässige Sensorin“, sagt der stellvertretende Professor Vincent Sittens, der die Gruppe der Szene -Repräsentation leitet. „Es öffnet die Tür für Roboter, die in unordentlichen, unstrukturierten Umgebungen, von Bauernhöfen bis zu Baustellen, ohne teure Infrastruktur betrieben werden können.“

„Das Sehen allein kann die für die Lokalisierung und Kontrolle benötigten Hinweise liefern-die Notwendigkeit von GPS, externen Monitoring-Systemen oder komplexen Onboard-Sensoren. RUS, MIT -Professor für Elektrotechnik und Informatik und Direktor von CSAIL. „Durch das Lernen aus visuellem Suggestions entwickeln diese Systeme interne Modelle eigener Bewegung und Dynamik und ermöglichen einen flexiblen, selbstüberwachenden Betrieb, bei dem herkömmliche Lokalisierungsmethoden fehlschlagen würden.“

Während das Coaching von NJF derzeit mehrere Kameras benötigt und für jeden Roboter erneuert werden muss, stellen sich die Forscher bereits eine besser zugängliche Model vor. In Zukunft konnten Hobbyisten die zufälligen Bewegungen eines Roboters mit ihrem Telefon aufzeichnen, ähnlich wie Sie ein Video von einem Mietwagen nehmen würden, bevor Sie abfahren, und dieses Filmmaterial verwenden, um ein Steuermodell zu erstellen, ohne dass Vorkenntnisse oder spezielle Geräte erforderlich sind.

Das System verallgemeinert noch nicht über verschiedene Roboter, und es fehlt eine Kraft oder eine taktile Erfassung, was seine Wirksamkeit auf Kontaktaufgaben einschränkt. Das Staff untersucht jedoch neue Wege, um diese Einschränkungen anzugehen: Verbesserung der Verallgemeinerung, Umgang mit Okklusionen und Erweiterung der Fähigkeit des Modells, über längere räumliche und zeitliche Horizonte zu argumentieren.

„So wie Menschen ein intuitives Verständnis dafür entwickeln, wie sich ihr Körper bewegen und auf Befehle reagieren, gibt NJF Robotern, die selbst durch Imaginative and prescient selbstbewusstes Selbstbewusstsein verkörpert“, sagt Li. „Dieses Verständnis ist eine Grundlage für versatile Manipulation und Kontrolle in realen Umgebungen. Unsere Arbeit spiegelt im Wesentlichen einen breiteren Pattern in der Robotik wider: sich vom manuellen Programmieren detaillierter Modelle zum Unterrichten von Robotern durch Beobachtung und Interaktion zu entfernen.“

Dieses Papier brachte die Pc Imaginative and prescient und die selbstbewertete Lernarbeiten aus dem Sitzlabor und das Fachwissen in weichen Robotern aus dem RUS-Labor zusammen. Li, Sitzmann und Rus haben das Papier mit CSAIL Associates Annan Zhang SM ’22 mitautorisiert, ein Doktorand in Elektrotechnik und Informatik (EECS); Boyuan Chen, Doktorand in EECs; Hanna Matusik, Studentforscherin für Maschinenbau; und Chao Liu, ein Postdoc im sensiblen Stadtlabor am MIT.

Die Forschung wurde vom Solomon Buchsbaum Analysis Fund durch das MIT Analysis Help Committee, ein MIT -Präsidentschaftsstipendium, die Nationwide Science Basis und das Gwangju Institute of Science and Expertise unterstützt.