Ein Roboter, der nach Arbeitern sucht, die in einem teilweise eingestürzten Minenschacht gefangen sind, muss schnell eine Karte des Tatorts erstellen und seinen Standort innerhalb des Tatorts identifizieren, während er durch das tückische Gelände navigiert.

Forscher haben kürzlich damit begonnen, leistungsstarke Modelle für maschinelles Lernen zu entwickeln, um diese komplexe Aufgabe nur mithilfe von Bildern der Bordkameras des Roboters auszuführen. Doch selbst die besten Modelle können jeweils nur wenige Bilder verarbeiten. Bei einer realen Katastrophe, bei der jede Sekunde zählt, müsste ein Such- und Rettungsroboter schnell große Gebiete durchqueren und Tausende von Bildern verarbeiten, um seine Mission zu erfüllen.

Um dieses Downside zu lösen, griffen MIT-Forscher auf Ideen sowohl neuerer Visionsmodelle mit künstlicher Intelligenz als auch klassischer Pc Imaginative and prescient zurück, um ein neues System zu entwickeln, das eine beliebige Anzahl von Bildern verarbeiten kann. Ihr System erstellt in Sekundenschnelle präzise 3D-Karten von komplizierten Szenen wie einem überfüllten Bürokorridor.

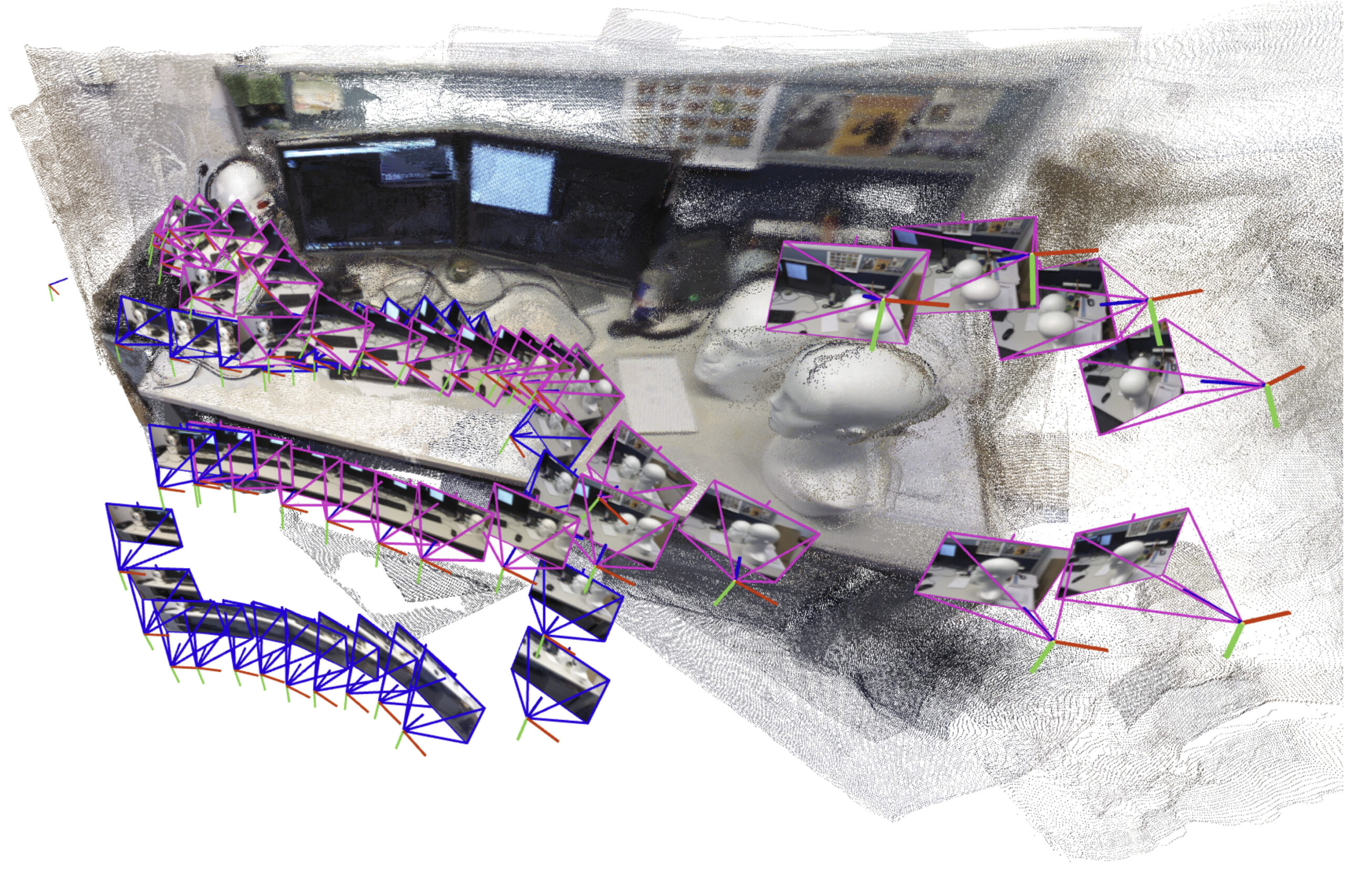

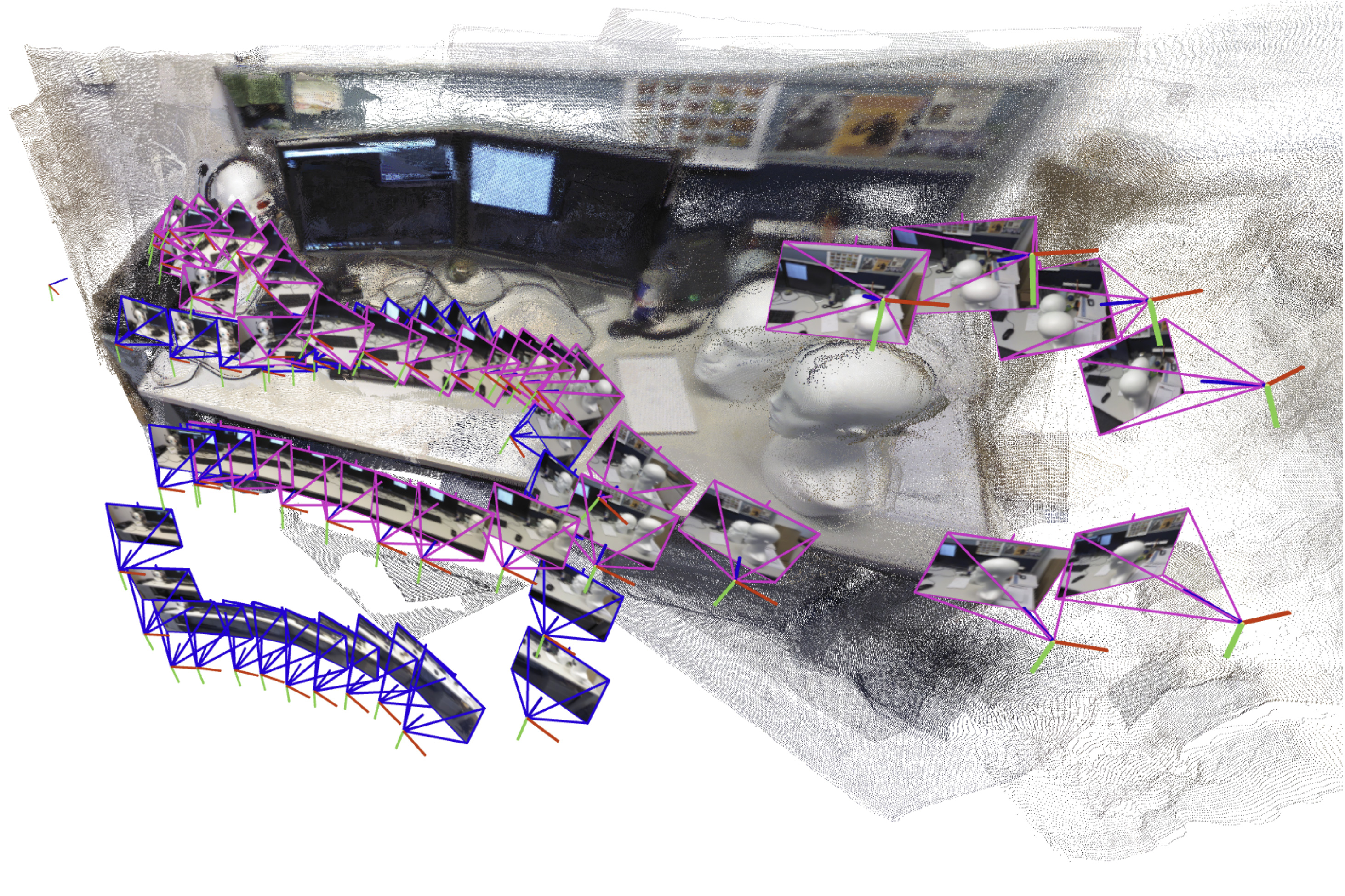

Das KI-gesteuerte System erstellt und richtet inkrementell kleinere Teilkarten der Szene aus, die es zusammenfügt, um eine vollständige 3D-Karte zu rekonstruieren, während es gleichzeitig die Place des Roboters in Echtzeit schätzt.

Im Gegensatz zu vielen anderen Ansätzen erfordert ihre Technik keine kalibrierten Kameras oder einen Experten, um eine komplexe Systemimplementierung abzustimmen. Die einfachere Natur ihres Ansatzes, gepaart mit der Geschwindigkeit und Qualität der 3D-Rekonstruktionen, würde die Skalierung für reale Anwendungen erleichtern.

Diese Methode hilft nicht nur bei der Navigation von Such- und Rettungsrobotern, sondern könnte auch dazu verwendet werden, erweiterte Realitätsanwendungen für tragbare Geräte wie VR-Headsets zu erstellen oder Industrierobotern zu ermöglichen, Waren innerhalb eines Lagers schnell zu finden und zu bewegen.

„Damit Roboter immer komplexere Aufgaben erfüllen können, benötigen sie viel komplexere Kartendarstellungen der Welt um sie herum. Aber gleichzeitig wollen wir es nicht schwieriger machen, diese Karten in die Praxis umzusetzen. Wir haben gezeigt, dass es möglich ist, in Sekundenschnelle eine genaue 3D-Rekonstruktion mit einem Instrument zu erstellen, das sofort einsatzbereit ist“, sagt Dominic Maggio, ein MIT-Absolvent und Hauptautor von a Artikel über diese Methode.

Maggio wird bei der Arbeit von Postdoktorand Hyungtae Lim und leitendem Autor Luca Carlone unterstützt, außerordentlicher Professor in der Abteilung für Luft- und Raumfahrttechnik (AeroAstro) des MIT, Hauptforscher im Labor für Informations- und Entscheidungssysteme (LIDS) und Direktor des MIT SPARK-Labors. Die Forschung wird auf der Konferenz über neuronale Informationsverarbeitungssysteme vorgestellt.

Eine Lösung entwerfen

Seit Jahren beschäftigen sich Forscher mit einem wesentlichen Component der Roboternavigation, dem sogenannten Simultaneous Localization and Mapping (SLAM). Bei SLAM erstellt ein Roboter eine Karte seiner Umgebung und orientiert sich dabei im Raum.

Herkömmliche Optimierungsmethoden für diese Aufgabe scheitern in anspruchsvollen Szenen oft oder erfordern eine vorherige Kalibrierung der Bordkameras des Roboters. Um diese Fallstricke zu vermeiden, trainieren Forscher Modelle für maschinelles Lernen, um diese Aufgabe aus Daten zu lernen.

Obwohl sie einfacher zu implementieren sind, können selbst die besten Modelle nur etwa 60 Kamerabilder gleichzeitig verarbeiten, was sie für Anwendungen ungeeignet macht, bei denen sich ein Roboter schnell durch eine abwechslungsreiche Umgebung bewegen und dabei Tausende von Bildern verarbeiten muss.

Um dieses Downside zu lösen, haben die MIT-Forscher ein System entwickelt, das statt der gesamten Karte kleinere Teilkarten der Szene generiert. Ihre Methode „klebt“ diese Teilkarten zu einer gesamten 3D-Rekonstruktion zusammen. Das Modell verarbeitet immer noch nur wenige Bilder gleichzeitig, aber das System kann größere Szenen viel schneller neu erstellen, indem es kleinere Teilkarten zusammenfügt.

„Das schien eine sehr einfache Lösung zu sein, aber als ich sie zum ersten Mal ausprobierte, struggle ich überrascht, dass sie nicht so intestine funktionierte“, sagt Maggio.

Auf der Suche nach einer Erklärung vertiefte er sich in Forschungsarbeiten zum Thema Pc Imaginative and prescient aus den 1980er und 1990er Jahren. Durch diese Analyse erkannte Maggio, dass Fehler in der Artwork und Weise, wie die Modelle für maschinelles Lernen Bilder verarbeiten, das Ausrichten von Teilkarten zu einem komplexeren Downside machten.

Herkömmliche Methoden richten Unterkarten aus, indem sie Drehungen und Verschiebungen anwenden, bis sie ausgerichtet sind. Diese neuen Modelle können jedoch zu Mehrdeutigkeiten in den Teilkarten führen, was deren Ausrichtung erschwert. Beispielsweise könnte eine 3D-Unterkarte einer Seite eines Raums leicht gebogene oder gestreckte Wände aufweisen. Das einfache Drehen und Verschieben dieser deformierten Teilkarten zum Ausrichten funktioniert nicht.

„Wir müssen sicherstellen, dass alle Teilkarten gleichmäßig deformiert sind, damit wir sie intestine aneinander ausrichten können“, erklärt Carlone.

Ein flexiblerer Ansatz

In Anlehnung an Ideen aus der klassischen Bildverarbeitung entwickelten die Forscher eine flexiblere mathematische Technik, die alle Verformungen in diesen Teilkarten darstellen kann. Durch die Anwendung mathematischer Transformationen auf jede Unterkarte kann diese flexiblere Methode sie so ausrichten, dass die Mehrdeutigkeit behoben wird.

Basierend auf den Eingabebildern gibt das System eine 3D-Rekonstruktion der Szene und Schätzungen der Kamerapositionen aus, die der Roboter verwenden würde, um sich im Raum zu lokalisieren.

„Sobald Dominic die Instinct hatte, diese beiden Welten – lernbasierte Ansätze und traditionelle Optimierungsmethoden – zu verbinden, struggle die Implementierung ziemlich einfach“, sagt Carlone. „Etwas so Effektives und Einfaches zu entwickeln, hat Potenzial für viele Anwendungen.

Ihr System arbeitete schneller und mit weniger Rekonstruktionsfehlern als andere Methoden, ohne dass spezielle Kameras oder zusätzliche Instruments zur Datenverarbeitung erforderlich waren. Die Forscher erstellten nahezu in Echtzeit 3D-Rekonstruktionen komplexer Szenen wie des Inneren der MIT-Kapelle, indem sie nur kurze, mit einem Mobiltelefon aufgenommene Movies verwendeten.

Der durchschnittliche Fehler dieser 3D-Rekonstruktionen betrug weniger als 5 Zentimeter.

Zukünftig wollen die Forscher ihre Methode für besonders komplizierte Szenen zuverlässiger machen und darauf hinarbeiten, sie an realen Robotern in anspruchsvollen Umgebungen umzusetzen.

„Es zahlt sich aus, sich mit traditioneller Geometrie auszukennen. Wenn man genau versteht, was im Modell vor sich geht, kann man viel bessere Ergebnisse erzielen und die Dinge viel skalierbarer machen“, sagt Carlone.

Diese Arbeit wird teilweise von der US Nationwide Science Basis, dem US Workplace of Naval Analysis und der Nationwide Analysis Basis of Korea unterstützt. Carlone, der derzeit ein Sabbatical als Amazon Scholar absolviert, hat diese Arbeit abgeschlossen, bevor er zu Amazon kam.