Das chinesische KI -Startup Deepseek Veröffentlichungen Deepseek-V3.1Es ist das neueste Flaggschiff -Sprachmodell. Es baut auf der Architektur von auf Deepseek-V3Hinzufügen von signifikanten Verbesserungen zum Argumentieren, der Verwendung von Instruments und der Codierungsleistung. Bemerkenswerterweise haben Deek -Modelle schnell einen Ruf für Lieferung von OpenAI- und Anthropic-Ebene zu einem Bruchteil der Kosten.

Modellarchitektur und Fähigkeiten

- Hybrid -Denkmodus: Deepseek-V3.1 unterstützt beide Denken (Überlegungen der Gedankenkette, vorberateter) und Nicht nachdenken (Direkter, Stream-of-Co-Bewusstsein) Technology, schaltbar über die Chat-Vorlage. Dies ist eine Abkehr von früheren Versionen und bietet Flexibilität für verschiedene Anwendungsfälle.

- Werkzeug- und Agentenunterstützung: Das Modell wurde für optimiert Werkzeuganruf Und Agentenaufgaben (zB mithilfe von APIs, Codeausführung, Suche). Toolaufrufe verwenden ein strukturiertes Format, und das Modell unterstützt benutzerdefinierte Code -Agenten und Suchagenten mit detaillierten Vorlagen im Repository.

- Large Skala, effiziente Aktivierung: Das Modell verfügt über 671b Gesamtparametermit 37b aktiviert professional Token-A Expertenmischung (MOE) Design, das die Schlusskosten senkt und gleichzeitig die Kapazität aufrechterhält. Der Kontextfenster Ist 128k Tokenviel größer als die meisten Konkurrenten.

- Lange Kontextverlängerung: Deepseek-V3.1 verwendet a Zwei-Phasen-Langkontext-Erweiterung Ansatz. Die erste Part (32K) wurde trainiert 630b Token (10x mehr als v3) und der zweite (128k) auf 209b Token (3,3x mehr als V3). Das Modell ist mit trainiert mit FP8 Mikroskalierung für effiziente Arithmetik auf {Hardware} der nächsten Technology.

- Chat -Vorlage: Die Vorlage unterstützt Multiturn-Gespräche Mit expliziten Token für Systemaufforderungen, Benutzeranfragen und Assistentenantworten. Der Denken Und Nicht nachdenken Modi werden durch ausgelöst

<suppose>Und</suppose>Token in der schnellen Sequenz.

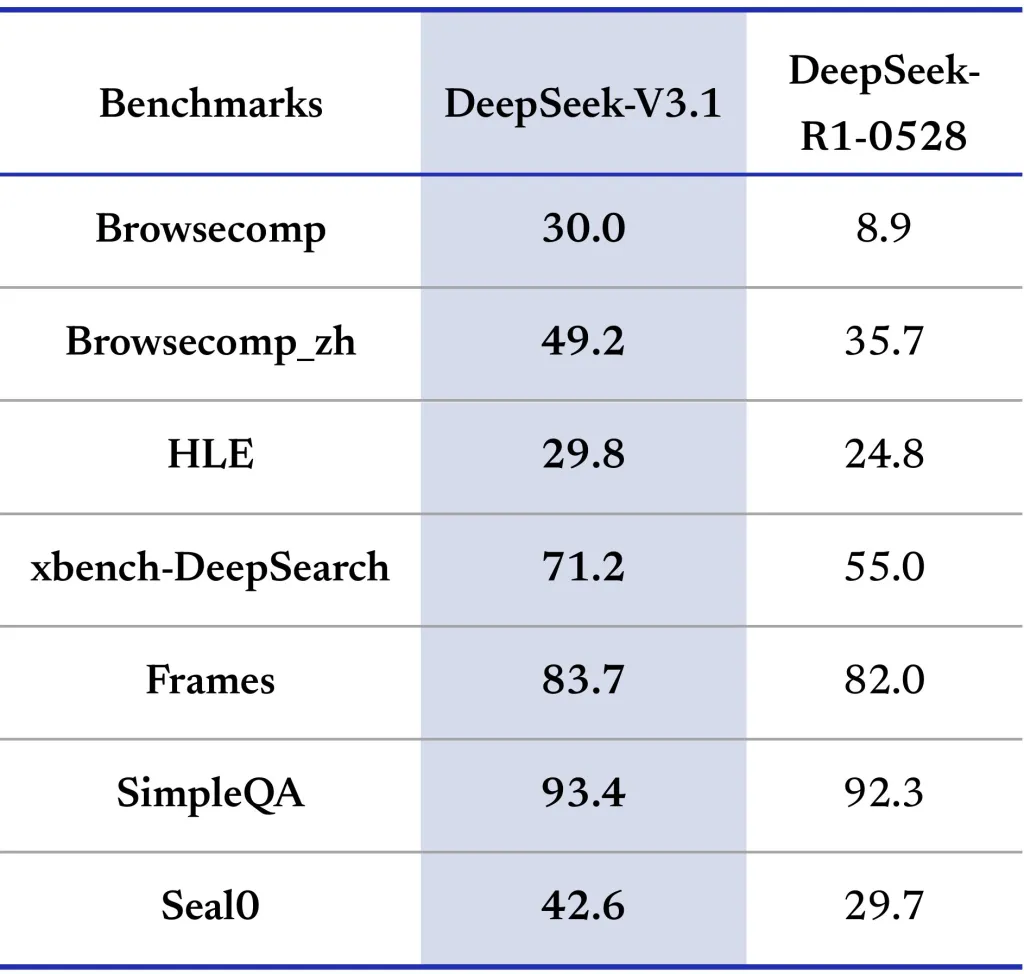

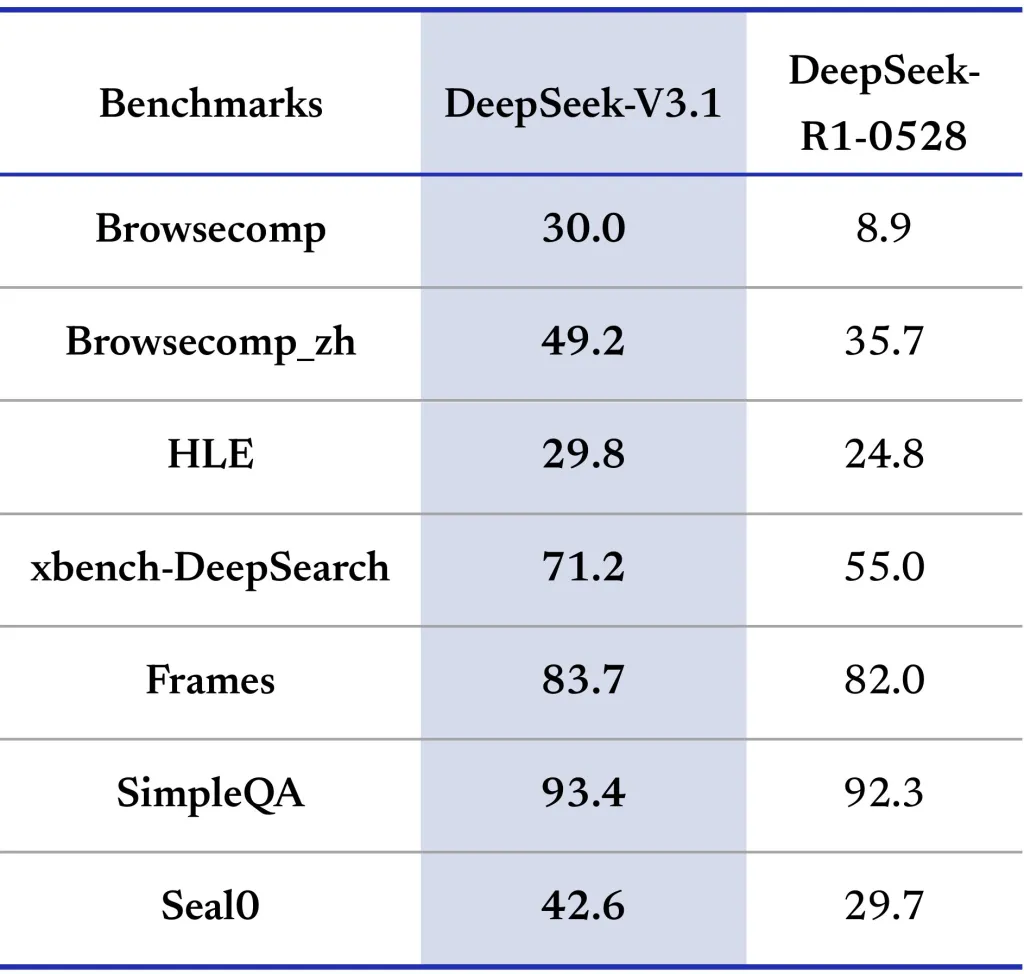

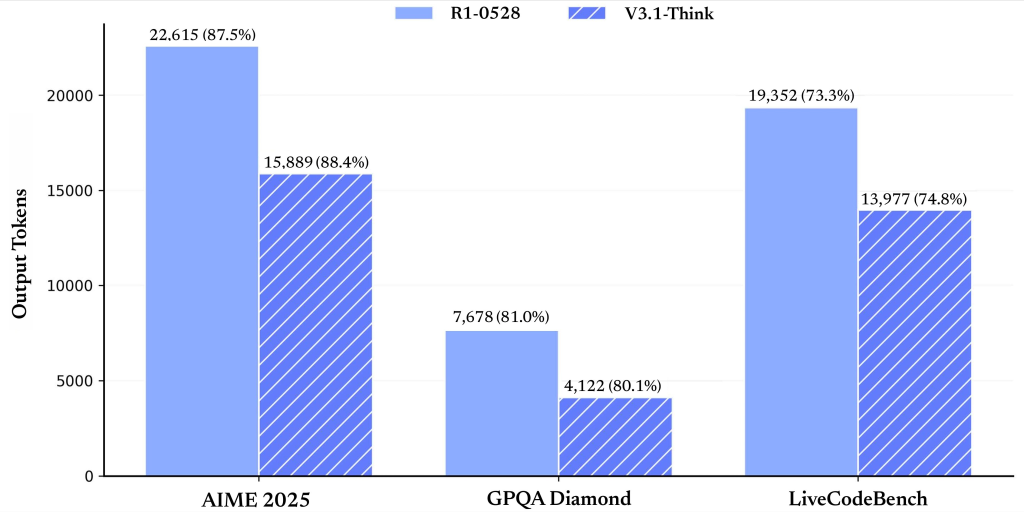

Leistungsbenchmarks

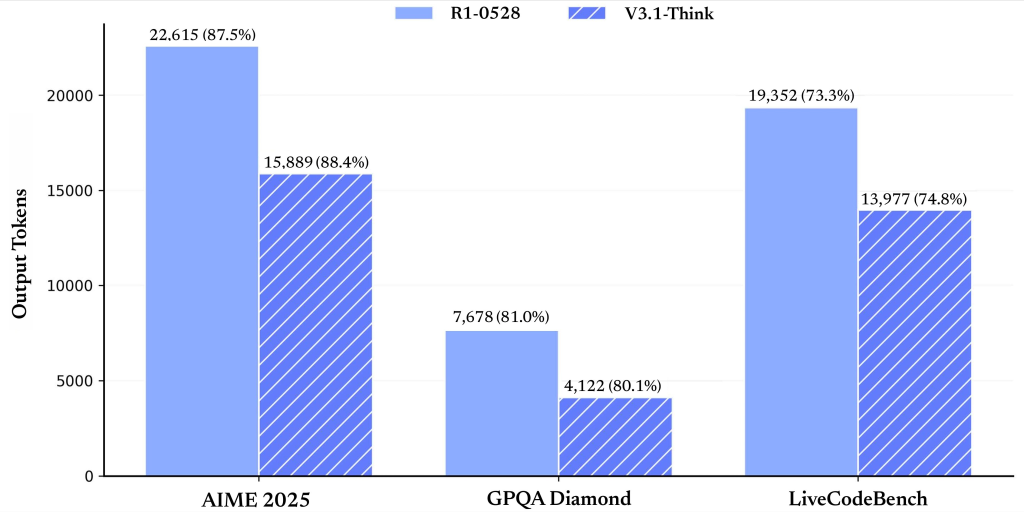

Deepseek-V3.1 ist über eine Vielzahl von Benchmarks bewertet (Siehe Tabelle unten) einschließlich Allgemeinwissen, Codierung, Mathematik, Werkzeuggebrauch und Agentenaufgaben. Hier sind Highlights:

| Metrisch | V3.1-NONTHINKING | V3.1-denken | Konkurrenten |

|---|---|---|---|

| Mmlu-redux (em) | 91.8 | 93.7 | 93,4 (R1-0528) |

| Mmlu-pro (em) | 83.7 | 84,8 | 85,0 (R1-0528) |

| Gpqa diamond (Go@1) | 74,9 | 80.1 | 81.0 (R1-0528) |

| LivecodeBench (Go@1) | 56,4 | 74,8 | 73,3 (R1-0528) |

| Aimé 2025 (Go@1) | 49,8 | 88,4 | 87,5 (R1-0528) |

| SWE-Bench (Agentenmodus) | 54,5 | – | 30,5 (R1-0528) |

Der Denkmodus Übereinstimmt frühere hochmoderne Versionen oder übertrifft konsequent, insbesondere in Codierung und Mathematik. Der Nichtdenkungsmodus ist schneller, aber etwas weniger genau, was es ultimate für latenzempfindliche Anwendungen macht.

Integration von Werkzeug- und Codeagenten

- Werkzeuganruf: Strukturierte Toolaufrufe werden im Nichtdenkungsmodus unterstützt, sodass skriptierbare Workflows mit externen APIs und Diensten ermöglicht werden.

- Codeagenten: Entwickler können benutzerdefinierte Code -Agenten erstellen, indem sie den bereitgestellten Trajektorienvorlagen befolgen, die das Interaktionsprotokoll für die Erzeugung, Ausführung und Debuggierung von Code detailliert beschreiben. Deepseek-V3.1 kann externe Suchwerkzeuge für aktuelle Informationen verwenden, eine Funktion, die für Unternehmens-, Finanz- und technische Forschungsanwendungen von entscheidender Bedeutung ist.

Einsatz

- Open Supply, MIT -Lizenz: Alle Modellgewichte und Code sind frei verfügbar Auf Umarmung von Gesicht und ModelsCope unter dem MIT -Lizenzsowohl Forschung als auch kommerzielle Nutzung fördern.

- Lokale Inferenz: Die Modellstruktur ist mit Deepseek-V3 kompatibel, und es werden detaillierte Anweisungen für die lokale Bereitstellung bereitgestellt. Das Laufen erfordert aufgrund der Skala des Modells erhebliche GPU -Ressourcen, aber das offene Ökosystem und die Group -Instruments senken die Adoptionsbarrieren.

Zusammenfassung

Deepseek-V3.1 stellt einen Meilenstein bei der Demokratisierung der fortgeschrittenen KI dar, die zeigt, dass Open-Supply-Modelle, kosteneffiziente und hochkarätige Sprachmodelle. Seine Mischung aus Skalierbares DenkenAnwesend WerkzeugintegrationUnd außergewöhnliche Leistung Bei der Codierung und Mathematikaufgaben positioniert es als praktische Wahl für Forschung und angewandte KI -Entwicklung.

Schauen Sie sich das an Modell auf dem Umarmungsgesicht. Fühlen Sie sich frei, unsere zu überprüfen Github -Seite für Tutorials, Codes und Notizbücher. Fühlen Sie sich auch frei, uns zu folgen Twitter Und vergessen Sie nicht, sich unserer anzuschließen 100k+ ml Subreddit und abonnieren Unser E-newsletter.