Reinforcement Studying (RL) eignet sich hervorragend zum Lernen Was Dies ist zu tun, wenn das Belohnungssignal sauber ist und die Umgebung nachsichtig ist. Aber viele reale Situationen sind nicht so. Sie sind chaotisch, riskant und voller „quick richtiger“ Entscheidungen. Hier werden von Experten geprüfte Argumentationsdatensätze zu einem Kraftmultiplikator: Sie vermitteln Modellen das Warum hinter einer Aktion – nicht nur das Ergebnis.

Der versteckte Engpass bei der RL-Leistung: schwache Argumentationssignale

RL-Agenten können in der Ausbildung beeindruckend aussehen und im Einsatz dennoch scheitern. Ein häufiger Grund ist, dass das Modell Abkürzungen lernt – Muster, die in bekannten Szenarien belohnt werden, aber zusammenbrechen, wenn sich die Bedingungen ändern.

Hier ist eine kleine Geschichte, die Sie erkennen werden, wenn Sie RL-Systeme ausgeliefert haben:

Ein Lagerroboterteam schult einen Agenten darin, Artikel auszuwählen und zu platzieren. In der Simulation steigen die Erfolgsquoten schnell. Doch auf realen Böden beginnt der Roboter, das Setup zu „spielen“ und nimmt riskante Flugbahnen ein, die im Simulator funktionieren, aber in der Nähe reflektierender Oberflächen zu Kollisionen führen. Die Belohnungsfunktion battle nicht falsch. Der Argumentation Das gelernte Modell battle unvollständig.

Wenn Ihre Daten nur Ergebnisse erfassen („Erfolg/Misserfolg“ oder eine skalare Belohnung), vermissen Sie die Zwischenentscheidungslogik, die Menschen instinktiv verwenden: Einschränkungen, Sicherheitsprüfungen und Schrittreihenfolge.

Was „von Experten geprüfte Argumentationsdaten“ tatsächlich beinhalten

Auf praktischer Ebene handelt es sich bei von Experten überprüften Argumentationsdaten um eine kuratierte Reihe von Beispielen, bei denen Fachspezialisten den Entscheidungsweg validieren – und nicht nur das Endergebnis.

Argumentationsspuren: die fehlende Mitte

Eine Argumentationsspur ist der schrittweise Weg von Beobachtung → Entscheidung → Aktion. Abhängig von Ihrem Anwendungsfall könnte das so aussehen:

- Identifizieren relevanter Signale („Sensordrift erkannt; Vertrauen verringert“)

- Anwenden von Domänenregeln („Vor dem Betreten Vorrang geben; Fußgängern Vorrang einräumen“)

- Auswahl von Aktionen mit Einschränkungen („Wählen Sie Pfad B, um den toten Winkel zu vermeiden“)

Was „geprüft“ bedeutet (im Klartext)

„Geprüft“ umfasst normalerweise:

- Von Experten verfasste oder von Experten überprüfte Richtlinien

- einheitliche Kennzeichnungsrubriken (damit zwei Experten denselben Fall auf ähnliche Weise lösen)

- systematische Prüfung auf Widersprüche und fehlende Schritte

- ein Prüfpfad der Änderungen, wenn sich die Richtlinien weiterentwickeln

Dies ist wichtig, da kleine Logikfehler kaskadieren können – insbesondere, wenn Sie später Belohnungsmodelle trainieren oder menschliche Feedbackschleifen verwenden.

Wie Reasoning-Datensätze die Leistung von Reinforcement-Studying-Modellen verbessern

Die Vorteile sind nicht mystisch. Sie sind mechanisch.

Schnellere Konvergenz, weniger Belohnungshacking

Argumentationsspuren reduzieren den Suchraum. Anstatt blind zu erkunden, erhält der Agent strukturierte Signale darüber, welche Zwischenschritte gültig sind. Das bedeutet in der Regel, dass weniger Trainingsiterationen in Sackgassen verschwendet werden und die Belohnungsfunktion weniger „intelligent“ ausgenutzt wird.

Untersuchungen zu RLHF und Belohnungsmodellierung zeigen immer wieder, wie empfindlich Coaching auf verrauschte oder minderwertige Präferenz-/Suggestions-Daten reagieren kann (Quelle: Affiliation for Computational Linguistics, 2024). Diese Sensibilität verschwindet im RL nicht – sie verstärkt sich.

Bessere Verallgemeinerung auf Randfälle

Fachmännisches Denken kodiert Einschränkungen Und Prinzipien Diese Übertragung: Sicherheitsgrenzen, Compliance-Regeln und Kausallogik. Wenn sich die Umgebung ändert, gelten diese Prinzipien weiterhin – auch wenn dies bei den genauen Pixeln, Texten oder Zustandsübergängen nicht der Fall ist.

Stabilere Belohnungsmodellierung und RLHF-Schleifen

Wenn Sie Publish-Coaching im RLHF-Stil verwenden, helfen Ihnen Argumentationsdaten dabei, bessere Belohnungsmodelle zu erstellen, da das Belohnungsmodell lernen kann, nicht nur „gute Antworten“, sondern auch „gute Entscheidungspfade“ zu bewerten. Dies führt zu konsistenteren Aktualisierungen während der Optimierung und zu weniger Regressionen bei der Skalierung des Trainings.

Wenn Sie RLHF-Pipelines bauen oder skalieren, Shaip’s RLHF-Lösungen basieren auf von Experten geleiteten Arbeitsabläufen und Qualitätskontrollen, die konsistente Ausrichtungsdaten unterstützen.

Eine Analogie: Flugstunden vs. Flugunterricht

Stellen Sie sich die RL-Ausbildung wie eine Pilotenausbildung vor. Sie können allein im Simulator endlose Stunden verbringen – aber wenn Sie die falschen Gewohnheiten einüben, verstärken Sie diese. Ein Ausbilder sagt nicht einfach „bestanden/nicht bestanden“. Sie korrigieren Ihre Argumentation mitten im Flug: Scan-Reihenfolge, Entscheidungszeitpunkt und Risikomanagement. Von Experten geprüfte Argumentationsdatensätze spielen für RL die „Lehrer“-Rolle – das Unterrichten des Modells Wie die Aufgabe zu durchdenken, nicht nur, ob sie gelandet ist.

Vergleichstabelle: Interne vs. Crowdsourcing- vs. ausgelagerte Prüfmodelle

Die meisten Groups haben am Ende einen Hybrid, aber es hilft, die Kompromisse deutlich zu machen.

Für umfassendere Etikettierungsanforderungen, die mit RL- und RLHF-Pipelines verbunden sind, Datenanmerkungsdienste von Shaip kann alles vom Richtliniendesign bis zur mehrstufigen Qualitätssicherung unterstützen – insbesondere, wenn Sie wiederholbare Qualität im großen Maßstab benötigen.

Ein praktisches QC-Playbook für von Experten geprüfte Argumentationsdatensätze

Hier ist ein Playbook, das zeigt, was leistungsstarke Groups umsetzen.

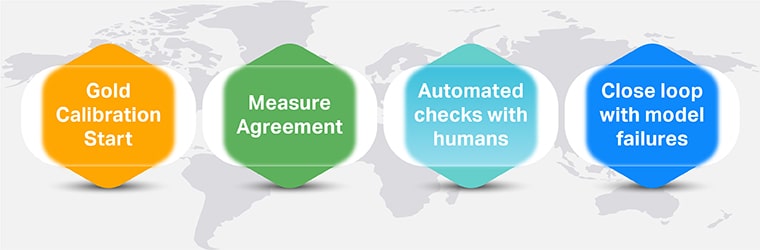

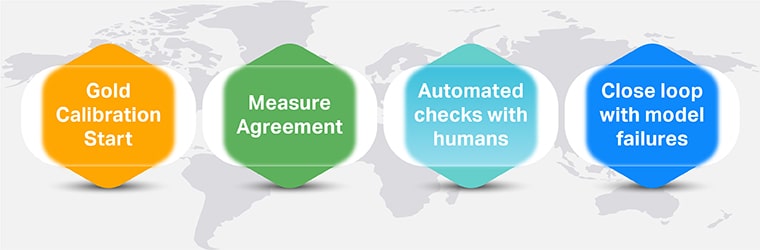

1. Beginnen Sie mit „Gold“ und der Kalibrierung

Erstellen Sie einen erstklassigen Satz kanonischer Beispiele (einschließlich kniffliger Randfälle). Verwenden Sie es, um Annotatoren zu kalibrieren und Experten darüber zu informieren, wie „gutes Denken“ aussieht.

2. Messen Sie die Übereinstimmung – und lösen Sie dann Meinungsverschiedenheiten richtig

Verwenden Sie die Vereinbarung zwischen Annotatoren, wo es sinnvoll ist (und vermeiden Sie es, eine Vereinbarung in von Natur aus mehrdeutigen Fällen zu erzwingen). Der Schlüssel ist Schlichtung: Meinungsverschiedenheiten sollten zu besseren Richtlinien führen, nicht nur zu einem Münzwurf-Etikett.

3. Fügen Sie automatisierte Kontrollen hinzu, aber lassen Sie den Menschen die Kontrolle

Automatisieren Sie, was kostengünstig zu überprüfen ist:

- Formatkonsistenz (Schrittanzahl, Schemagültigkeit)

- Regelverstöße (fehlende Einschränkungen, verbotene Aktionen)

- Widerspruchserkennung (Schritt sagt „A“, impliziert später „nicht A“)

Leiten Sie dann markierte Elemente zur Expertenprüfung weiter. Hier zahlt sich die hybride Qualitätskontrolle aus Mensch und KI aus: Maschinen erkennen „offensichtliche Fehler“, Experten beheben „subtile Fehler“.

4. Schließen Sie den Kreis bei Modellfehlern

Behandeln Sie Bereitstellungsfehler als Datensatz-Suggestions. Wenn das Modell ausfällt, fragen Sie:

- Fehlte in der Argumentationsspur eine Einschränkung?

- Wurde in den Richtlinien der Randfall nicht ausreichend spezifiziert?

- Haben wir uns zu sehr an die „Blissful Path“-Logik gehalten?

Diese Schleife verwandelt Ihren Datensatz in einen lebendigen Vermögenswert und nicht in eine einmalige Lieferung. Für Groups, die Finish-to-Finish-Datenpipelines aufbauen (Erfassung → Qualitätssicherung → Bereitstellung), Shaips KI-Trainingsdatendienste kann dabei helfen, dies kontinuierlich zu operationalisieren.

Entscheidungsrahmen: So wählen Sie die richtige Überprüfungsstrategie aus

Verwenden Sie diese sechs Fragen, um die richtige Mischung aus Inhouse-, Crowd- und Managed-Providers auszuwählen: