Großsprachige Modelle (LLMs) sind jetzt besser als je zuvor zugänglich. Die Gemini -API von Google bietet Entwicklern und Schöpfer ein leistungsstarkes und vielseitiges Software. In diesem Leitfaden werden die zahlreichen praktischen Anwendungen untersucht, die Sie mit der kostenlosen Gemini -API verwenden können. Wir werden mehrere praktische Beispiele durchgehen. Sie lernen wichtige Gemini -API -Aufforderungstechniken, von einfachen Abfragen bis hin zu komplexen Aufgaben. Wir werden Methoden wie Zero-Shot-Aufforderung, Gemini und wenige Schussaufforderung abdecken. Sie lernen auch, wie Sie Aufgaben wie die grundlegende Codegenerierung mit Gemini ausführen und Ihren Workflow effizienter machen.

Wie bekomme ich Ihre kostenlose Gemini -API?

Bevor wir beginnen, müssen Sie Ihre Umgebung einrichten. Dieser Vorgang ist einfach und dauert nur wenige Minuten. Sie brauchen eine Google AI Studio API -Schlüssel zu Beginn.

Installieren Sie zunächst die erforderlichen Python Bibliotheken. Mit diesem Paket können Sie leicht mit der Gemini -API kommunizieren.

!pip set up -U -q "google-genai>=1.0.0"Konfigurieren Sie als Nächstes Ihren API -Schlüssel. Sie können einen kostenlosen Schlüssel von erhalten Google AI Studio. Speichern Sie es sicher und verwenden Sie den folgenden Code, um den Shopper zu initialisieren. Dieses Setup ist die Grundlage für alle folgenden Beispiele.

from google import genai

# Ensure to safe your API key

# For instance, by utilizing userdata in Colab

# from google.colab import userdata

# GOOGLE_API_KEY=userdata.get('GOOGLE_API_KEY')

shopper = genai.Shopper(api_key="YOUR_API_KEY")

MODEL_ID = "gemini-1.5-flash"Teil 1: Grundlagenanlauf -Techniken

Beginnen wir mit zwei grundlegenden Gemini -API -Anforderungen, die Techniken fordern. Diese Methoden bilden die Grundlage für fortgeschrittenere Interaktionen.

Technik 1: Null-Shot-Aufforderung für schnelle Antworten

Null-Shot-Aufforderung ist der einfachste Weg, um mit einem zu interagieren Llm. Sie stellen eine Frage direkt, ohne Beispiele anzugeben. Diese Methode eignet sich intestine für einfache Aufgaben, bei denen das vorhandene Wissen des Modells ausreicht. Für eine effektive Aufforderung zum Null-Shot ist Klarheit der Schlüssel.

Verwenden wir es, um das Gefühl einer Kundenüberprüfung zu klassifizieren.

Immediate:

immediate = """

Classify the sentiment of the next evaluation as constructive, detrimental, or impartial:

Overview: "I am going to this restaurant each week, I find it irresistible a lot."

"""

response = shopper.fashions.generate_content(

mannequin=MODEL_ID,

contents=immediate,

)

print(response.textual content)Ausgabe:

Dieser einfache Ansatz erledigt die Arbeit schnell. Es ist eines der häufigsten Dinge, die Sie mit der freien API des Geminis tun können.

Technik 2: wenige Schüsse Aufforderung für benutzerdefinierte Formate

Manchmal benötigen Sie die Ausgabe in einem bestimmten Format. Wenige Schüsse Aufforderung Leitet das Modell, indem Sie einige Beispiele für Eingabe und erwartete Ausgabe anbieten. Diese Technik hilft dem Modell, Ihre Anforderungen genau zu verstehen.

Hier extrahieren wir Städte und ihre Länder in ein JSON -Format.

Immediate:

immediate = """

Extract cities from the textual content and embrace the nation they're in.

USER: I visited Mexico Metropolis and Poznan final 12 months

MODEL: {"Mexico Metropolis": "Mexico", "Poznan": "Poland"}

USER: She wished to go to Lviv, Monaco and Maputo

MODEL: {"Lviv": "Ukraine", "Monaco": "Monaco", "Maputo": "Mozambique"}

USER: I'm presently in Austin, however I will likely be shifting to Lisbon quickly

MODEL:

"""

# We additionally specify the response ought to be JSON

generation_config = varieties.GenerationConfig(response_mime_type="utility/json")

response = mannequin.generate_content(

contents=immediate,

generation_config=generation_config

)

show(Markdown(f"```jsonn{response.textual content}n```"))Ausgabe:

Durch die Bereitstellung von Beispielen lehren Sie dem Modell die genaue Struktur, die Sie möchten. Dies ist ein leistungsstarker Fortschritt von Primary Null-Shot, der Zwillinge auffordert.

Teil 2: Führung des Verhaltens und Wissens des Modells

Sie können die Particular person des Modells steuern und ihm spezifisches Wissen vermitteln. Diese Gemini -API -Aufforderungstechniken machen Ihre Interaktionen zielgerichteter.

Technik 3: Rolle, die dazu veranlasst wird, eine Persona zu definieren

Sie können dem Modell eine Rolle zuweisen, um seinen Ton und Stil zu beeinflussen. Dadurch wird die Antwort authentischer und auf einen bestimmten Kontext zugeschnitten.

Bitten wir aus der Sicht eines deutschen Reiseleiters um Museumsempfehlungen.

Immediate:

system_instruction = """

You're a German tour information. Your activity is to offer suggestions

to folks visiting your nation.

"""

immediate="May you give me some suggestions on artwork museums in Berlin and Cologne?"

model_with_role = genai.GenerativeModel(

'gemini-2.5-flash-',

system_instruction=system_instruction

)

response = model_with_role.generate_content(immediate)

show(Markdown(response.textual content))Ausgabe:

Das Modell übernimmt die Persona und macht die Antwort ansprechender und hilfreicher.

Technik 4: AddiNG Kontext zur Beantwortung von Nischenfragen

LLMs wissen nicht alles. Sie können spezifische Informationen in der Eingabeaufforderung bereitstellen, um das Modell zu helfen, Fragen zu neuen oder privaten Daten zu beantworten. Dies ist ein Kernkonzept dahinter REMAINAL-AUGENTED-Technology (LAG).

Hier geben wir dem Modell eine Tabelle olympischer Athleten, um eine bestimmte Frage zu beantworten.

Immediate:

immediate = """

QUERY: Present a listing of athletes that competed within the Olympics precisely 9 occasions.

CONTEXT:

Desk title: Olympic athletes and variety of occasions they've competed

Ian Millar, 10

Hubert Raudaschl, 9

Afanasijs Kuzmins, 9

Nino Salukvadze, 9

Piero d'Inzeo, 8

"""

response = mannequin.generate_content(immediate)

show(Markdown(response.textual content))Ausgabe:

Das Modell verwendet nur den bereitgestellten Kontext, um eine genaue Antwort zu geben.

Technik 5: Bereitstellung von Basisfällen für klare Grenzen

Es ist wichtig zu definieren, wie sich ein Modell verhalten sollte, wenn es eine Anfrage nicht erfüllen kann. Die Bereitstellung von Basisfällen oder Standardantworten verhindert unerwartete oder off-topische Antworten.

Lassen Sie uns einen Urlaubsassistenten mit einer begrenzten Verantwortung erstellen.

Immediate:

system_instruction = """

You're an assistant that helps vacationers plan their trip. Your duties are:

1. Serving to ebook the resort.

2. Recommending eating places.

3. Warning about potential risks.

If one other request is requested, return "I can't assist with this request."

"""

model_with_rules = genai.GenerativeModel(

'gemini-1.5-flash-latest',

system_instruction=system_instruction

)

# On-topic request

response_on_topic = model_with_rules.generate_content("What ought to I look out for on the seashores in San Diego?")

print("--- ON-TOPIC REQUEST ---")

show(Markdown(response_on_topic.textual content))

# Off-topic request

response_off_topic = model_with_rules.generate_content("What bowling locations do you advocate in Moscow?")

print("n--- OFF-TOPIC REQUEST ---")

show(Markdown(response_off_topic.textual content))Ausgabe:

Teil 3: Fortgeschrittene Argumentation freischalten

Für komplexe Probleme müssen Sie den Denkprozess des Modells leiten. Diese Argumentationstechniken verbessern die Genauigkeit bei mehrstufigen Aufgaben.

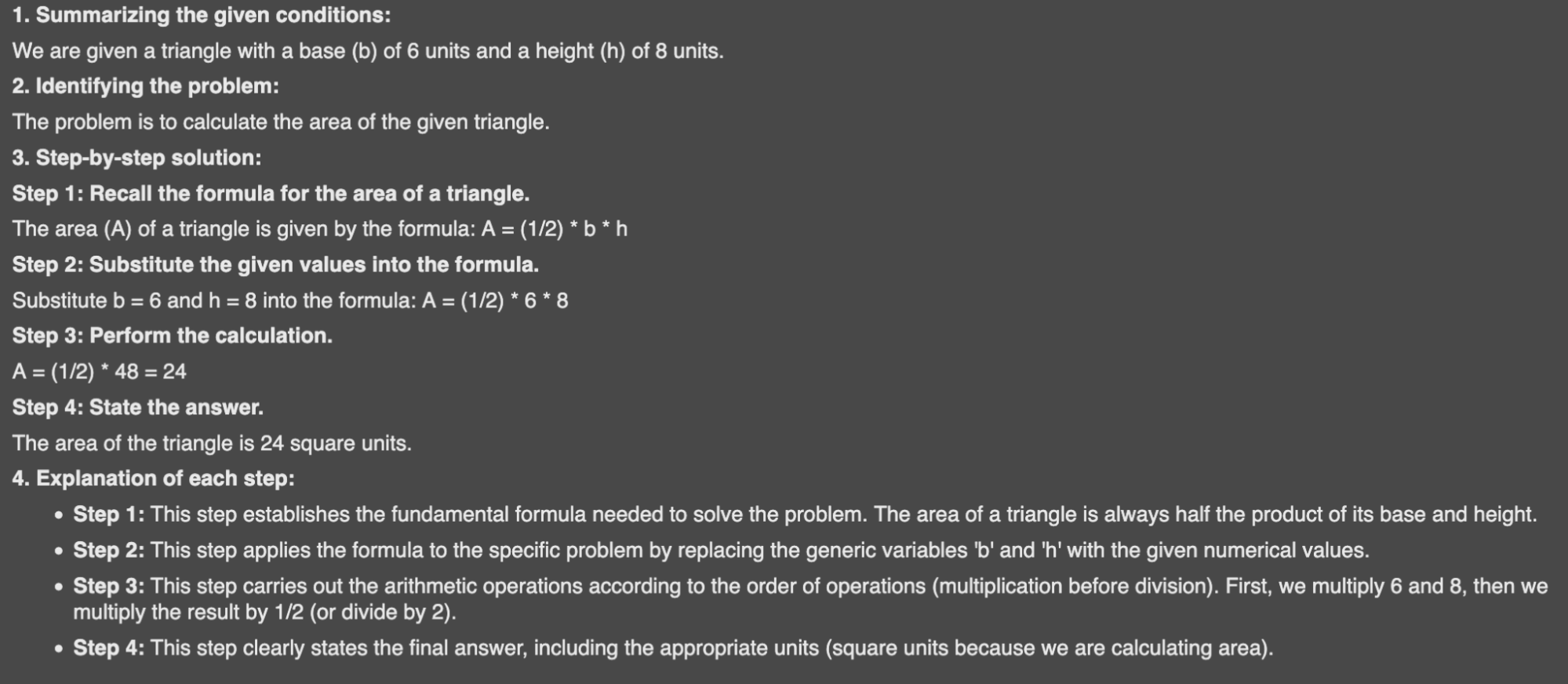

Technik 6: Grundlegende Begründung für Schritt-für-Schritt-Lösungen

Sie können das Modell anweisen, ein Downside zu brechen und seine Schritte zu erklären. Dies ist nützlich für mathematische oder logische Probleme, bei denen der Prozess genauso wichtig ist wie die Antwort.

Hier bitten wir das Modell, um den Bereich eines Dreiecks zu lösen und seine Arbeit zu zeigen.

Immediate:

system_instruction = """

You're a instructor fixing mathematical issues. Your activity:

1. Summarize given circumstances.

2. Determine the issue.

3. Present a transparent, step-by-step resolution.

4. Present an evidence for every step.

"""

math_problem = "Given a triangle with base b=6 and top h=8, calculate its space."

reasoning_model = genai.GenerativeModel(

'gemini-1.5-flash-latest',

system_instruction=system_instruction

)

response = reasoning_model.generate_content(math_problem)

show(Markdown(response.textual content))Ausgabe:

Diese strukturierte Ausgabe ist klar und leicht zu befolgen.

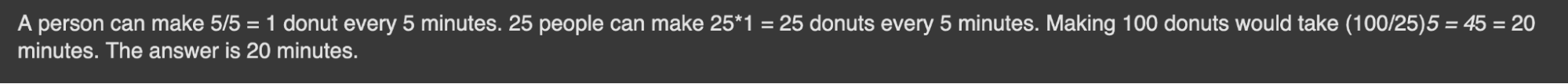

Technik 7: Kette des Gedankens für komplexe Probleme

Die Aufforderung der Kette der Gedanken (COT) ermutigt das Modell, Schritt für Schritt zu denken. Untersuchungen von Google zeigen, dass dies die Leistung bei komplexen Argumentationsaufgaben erheblich verbessert. Anstatt nur die endgültige Antwort zu geben, erklärt das Modell seinen Argumentationsweg.

Lassen Sie uns ein logisches Puzzle mit COT lösen.

Immediate:

immediate = """

Query: 11 factories could make 22 automobiles per hour. How a lot time would it not take 22 factories to make 88 automobiles?

Reply: A manufacturing facility could make 22/11=2 automobiles per hour. 22 factories could make 22*2=44 automobiles per hour. Making 88 automobiles would take 88/44=2 hours. The reply is 2 hours.

Query: 5 folks can create 5 donuts each 5 minutes. How a lot time would it not take 25 folks to make 100 donuts?

Reply:

"""

response = mannequin.generate_content(immediate)

show(Markdown(response.textual content))Ausgabe:

Das Modell folgt dem Muster und unterteilt das Downside in logische Schritte.

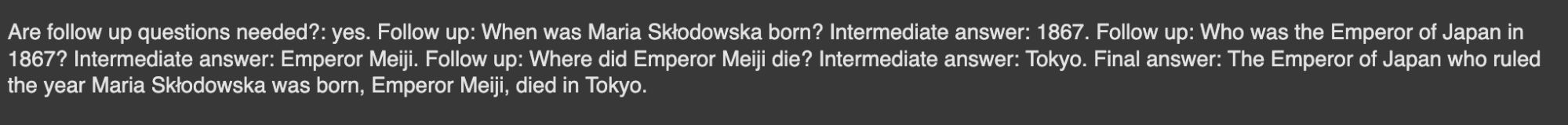

Technik 8: Selbstmanner Aufforderung zur Dekonstruktion von Fragen

Die Aufforderung der Selbstakadung ähnelt dem COT. Das Modell unterteilt eine Hauptfrage in kleinere Comply with-up-Fragen. Es beantwortet jede Unter Frage, bevor Sie zur endgültigen Antwort ankommen.

Verwenden wir dies, um eine mehrteilige historische Frage zu lösen.

Immediate:

immediate = """

Query: Who was the president of the us when Mozart died?

Are observe up questions wanted?: sure.

Comply with up: When did Mozart die?

Intermediate reply: 1791.

Comply with up: Who was the president of the us in 1791?

Intermediate reply: George Washington.

Ultimate reply: When Mozart died George Washington was the president of the USA.

Query: The place did the Emperor of Japan, who dominated the 12 months Maria Skłodowska was born, die?

"""

response = mannequin.generate_content(immediate)

show(Markdown(response.textual content))Ausgabe:

Dieser strukturierte Denkprozess sorgt für die Genauigkeit komplexer Abfragen.

Teil 4: reale Anwendungen mit Gemini

Lassen Sie uns nun sehen, wie diese Techniken für gemeinsame reale Aufgaben gelten. Die Erforschung dieser Beispiele zeigt die Vielzahl von Dingen, die Sie mit der freien API des Geminis tun können.

Technik 9: Klassifizierung des Textes für Moderation und Analyse

Sie können Gemini verwenden, um den Textual content automatisch zu klassifizieren. Dies ist nützlich für Aufgaben wie die Mäßigung von Inhalten, bei denen Sie Spam oder missbräuchliche Kommentare identifizieren müssen. Mit nur wenigen Schuss-Aufforderung hilft Gemini dem Modell, Ihre spezifischen Kategorien zu lernen.

Immediate:

classification_template = """

Subject: The place can I purchase an affordable cellphone?

Remark: You have got simply gained an IPhone 15 Professional Max!!! Click on the hyperlink!!!

Class: Spam

Subject: How lengthy do you boil eggs?

Remark: Are you silly?

Class: Offensive

Subject: {subject}

Remark: {remark}

Class:

"""

spam_topic = "I'm on the lookout for a vet in our neighbourhood."

spam_comment = "You'll be able to win 1000$ by simply following me!"

spam_prompt = classification_template.format(subject=spam_topic, remark=spam_comment)

response = mannequin.generate_content(spam_prompt)

show(Markdown(response.textual content))Ausgabe:

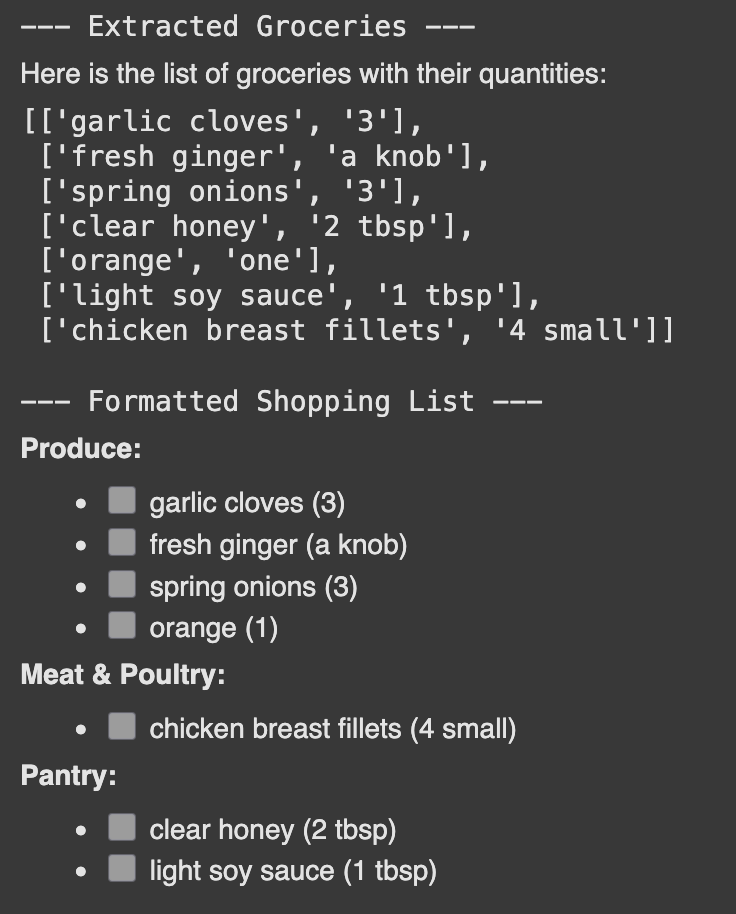

Gemini kann bestimmte Informationen aus unstrukturiertem Textual content extrahieren. Auf diese Weise können Sie einfachen Textual content wie ein Rezept in ein strukturiertes Format wie eine Einkaufsliste umwandeln.

Immediate:

recipe = """

Grind 3 garlic cloves, a knob of recent ginger, and three spring onions to a paste.

Add 2 tbsp of clear honey, juice from one orange, and 1 tbsp of sunshine soy sauce.

Pour the combination over 4 small rooster breast fillets.

"""

# Step 1: Extract the listing of groceries

extraction_prompt = f"""

Your activity is to extract to a listing all of the groceries with its portions primarily based on the supplied recipe.

Make it possible for groceries are within the order of look.

Recipe:{recipe}

"""

extraction_response = mannequin.generate_content(extraction_prompt)

grocery_list = extraction_response.textual content

print("--- Extracted Groceries ---")

show(Markdown(grocery_list))

# Step 2: Format the extracted listing right into a procuring listing

formatting_system_instruction = "Set up groceries into classes for simpler procuring. Listing every merchandise with a checkbox ()."

formatting_prompt = f"""

LIST: {grocery_list}

OUTPUT:

"""

formatting_model = genai.GenerativeModel(

'gemini-2.5-flash',

system_instruction=formatting_system_instruction

)

formatting_response = formatting_model.generate_content(formatting_prompt)

print("n--- Formatted Buying Listing ---")

show(Markdown(formatting_response.textual content))Ausgabe:

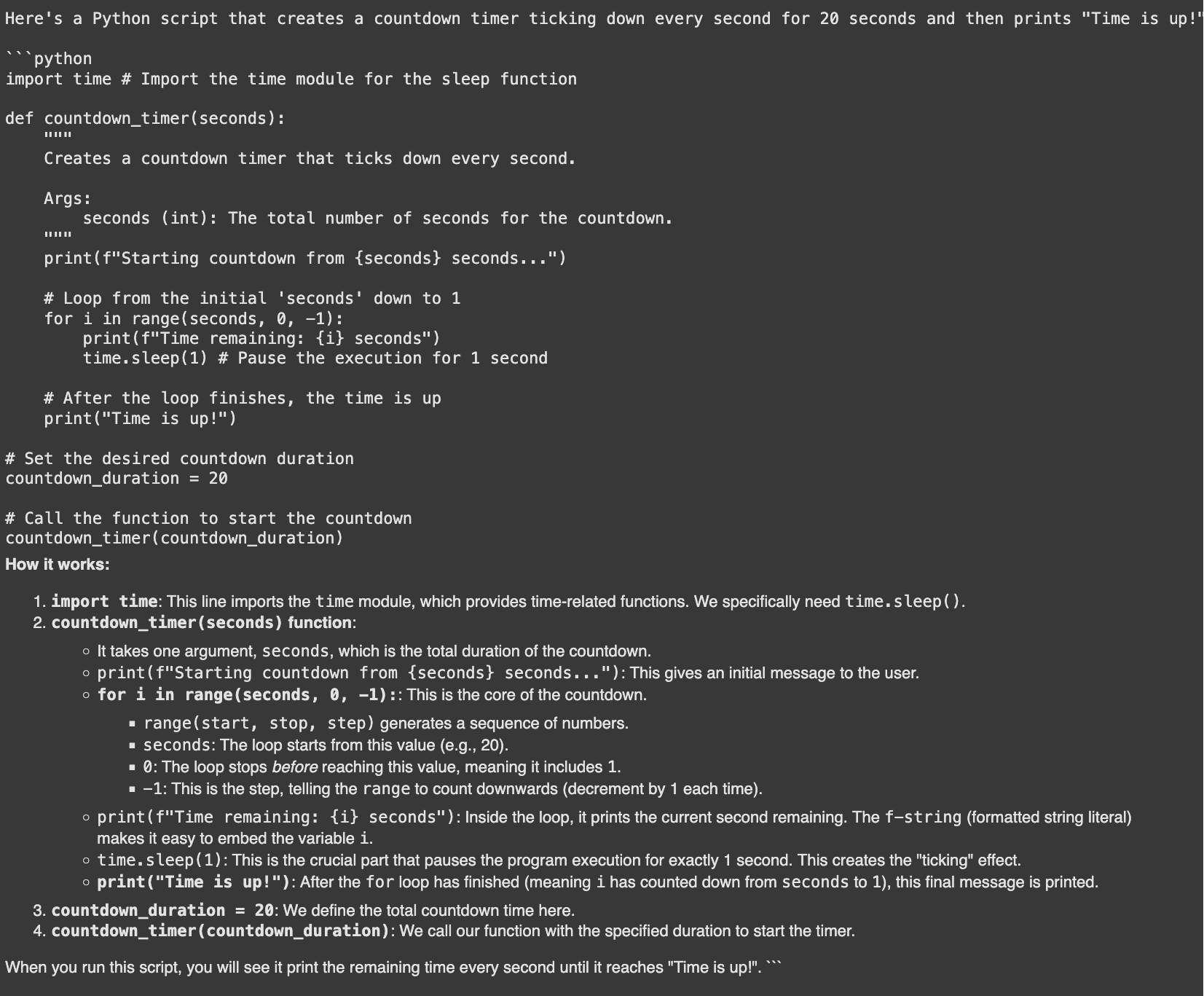

Technik 11: Grundlegende Codegenerierung und -Debugging

Eine leistungsstarke Anwendung ist die grundlegende Codegenerierung mit Gemini. Es kann Code -Ausschnitte schreiben, Fehler erklären und Korrekturen vorschlagen. Eine GitHub -Umfrage ergab, dass Entwickler, die KI -Codierungswerkzeuge verwenden, bis zu 55% schneller sind.

Bitten wir Gemini, ein Python -Skript für einen Countdown -Timer zu generieren.

Immediate:

code_generation_prompt = """

Create a countdown timer in Python that ticks down each second and prints

"Time is up!" after 20 seconds.

"""

response = mannequin.generate_content(code_generation_prompt)

show(Markdown(f"```pythonn{response.textual content}n```"))Ausgabe:

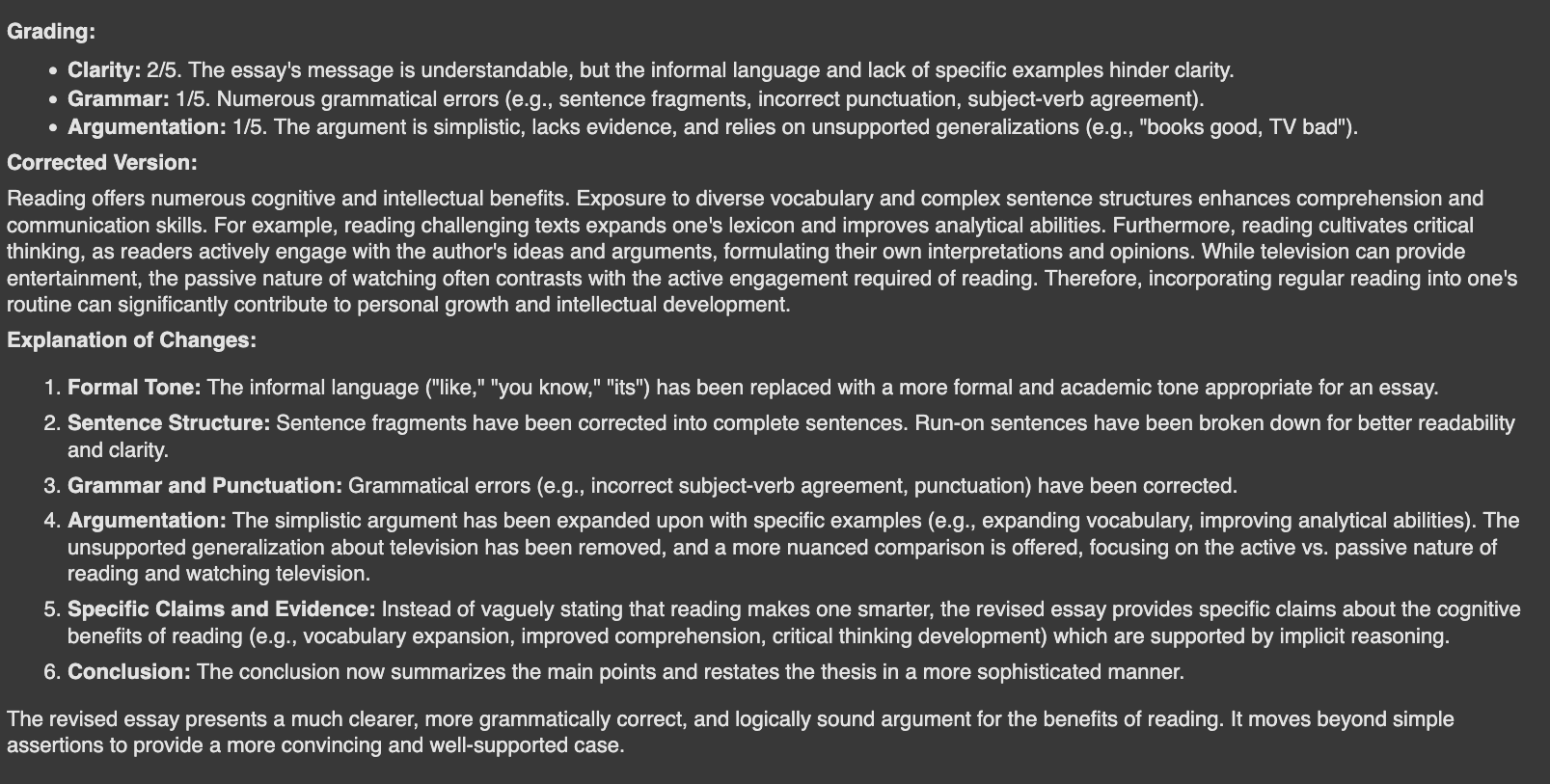

Technik 12: Bewertung des Textes zur Qualitätssicherung

Sie können sogar Gemini verwenden, um Textual content zu bewerten. Dies ist nützlich für die Einstufung, Bereitstellung von Suggestions oder die Gewährleistung der Inhaltsqualität. Hier haben wir das Modell als Lehrer und einen schlecht geschriebenen Aufsatz.

Immediate:

teacher_system_instruction = """

As a instructor, you might be tasked with grading a pupil's essay.

1. Consider the essay on a scale of 1-5 for readability, grammar, and argumentation.

2. Write a corrected model of the essay.

3. Clarify the adjustments made.

"""

essay = "Studying is like, a extremely good factor. It’s useful, you already know? Like, rather a lot. Whenever you learn, you study new phrases and that is good. Its like a secret code to being good. I learn a ebook final week and I do know it was making me smarter. Due to this fact, books good, TV dangerous. So everybody ought to learn extra."

evaluation_model = genai.GenerativeModel(

'gemini-1.5-flash-latest',

system_instruction=teacher_system_instruction

)

response = evaluation_model.generate_content(essay)

show(Markdown(response.textual content))Ausgabe:

Abschluss

Die Gemini -API ist eine versatile und leistungsstarke Ressource. Wir haben eine breite Palette von Dingen untersucht, die Sie mit der kostenlosen Gemini -API tun können, von einfachen Fragen bis hin zu erweitertem Denken und Codegenerierung. Durch die Beherrschung dieser Gemini -API -Aufforderungstechniken können Sie intelligenteren, effizienteren Anwendungen erstellen. Der Schlüssel ist zu experimentieren. Verwenden Sie diese Beispiele als Ausgangspunkt für Ihre eigenen Projekte und entdecken Sie, was Sie erstellen können.

Häufig gestellte Fragen

A. Sie können Textklassifizierung, Informationsextraktion und Zusammenfassung durchführen. Es eignet sich auch hervorragend für Aufgaben wie grundlegende Codegenerierung und komplexes Denken.

A. Auf der Aufforderung von Null-Photographs beinhaltet die direkte Frage direkt ohne Beispiele. Nur wenige Schussaufforderung liefert dem Modell einige Beispiele, um das Reaktionsformat und den Reaktionsformat und den Stil zu leiten.

A. Ja, Gemini kann Code -Snippets generieren, Programmierkonzepte erklären und Fehler debuggen. Dies hilft, den Entwicklungsprozess für viele Programmierer zu beschleunigen.

A. Das Zuweisen einer Rolle gibt dem Modell eine bestimmte Particular person und einen bestimmten Kontext. Dies führt zu Antworten, die einen angemesseneren Ton, Stil und Domänenwissen aufweisen.

A. Es ist eine Technik, bei der das Modell ein Downside in kleinere, sequentielle Schritte aufteilt. Dies hilft, die Genauigkeit für komplexe Aufgaben zu verbessern, die Argumentation erfordern.

Melden Sie sich an, um weiter zu lesen und Experten-Kuratinhalte zu genießen.