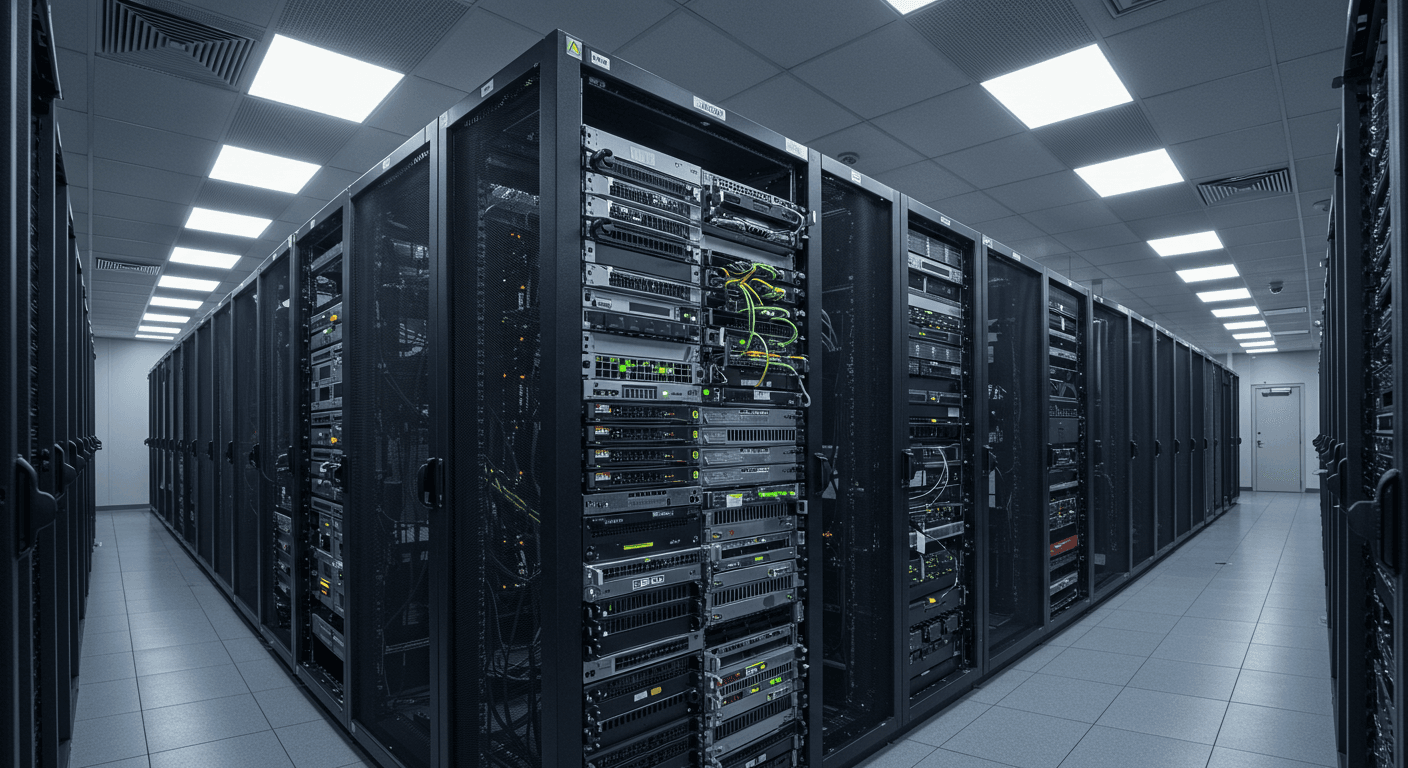

Wir haben viel gesprochen über die Vorteile von KI Auf Good Knowledge Collective, aber wir müssen uns über einige der Kosten actual machen. Die Explosion der Einführung künstlicher Intelligenz hat einen massiven Appetit auf Rechenressourcen in jeder Branche ausgelöst. Sie können es in den wachsenden GPUs, den endlosen Reihen von Servern und der Nachfrage nach schnelleren Cloud -Diensten sehen. Es wird klar, dass KI nicht nur eine Software program -Revolution ist – es ist auch eine {Hardware}.

Eine Studie von McKinsey und Firm stellte fest, dass 78 Prozent der Befragten Sagen Sie, ihre Organisationen verwenden KI in mindestens einer Geschäftsfunktion. Diese Zahl steigt rasant, da Unternehmen neue Möglichkeiten zur Automatisierung von Entscheidungen, zur Verbesserung des Kundenservice und zur Verarbeitung massiver Datensätze erforschen. Sie könnten denken, dass diese Verschiebung rein digital ist, aber hinter jedem KI -Modell liegt ein Anstieg der physischen Computeranforderungen. Es ist eine Herausforderung, die viele Unternehmen nicht erwartet haben, als sie das maschinelle Lernen anfingen. Lesen Sie weiter, um mehr zu erfahren.

Warum KI die Notwendigkeit dedizierter Server vorantreibt

Goldman Sachs Analysis prognostiziert, dass die globale Leistungsnachfrage aus Rechenzentren bis 2027 um 50 Prozent und bis zum Ende des Jahrzehnts um 165 Prozent steigen wird. Sie können bereits die Auswirkungen als Versorgungsunternehmen und Dateninfrastrukturanbieter sehen, die die Kapazität erweitern können. Es ist das bisher klarste Anzeichen, dass die Rechenleistung eher zu einer strategischen Notwendigkeit als zu einem Hintergrundvorgang geworden ist.

Die Anzahl der Unternehmen, die AI nutzen, ist in nur wenigen Jahren in die Höhe geschossenMit mehr als 50% der Unternehmen, die bis zu Beginn 2024 über 5.000 Arbeitnehmer einsetzen. Sie könnten annehmen, dass Cloud -Ressourcen mithalten würden, aber sie werden unter der wachsenden Rechenlast zunehmend dünn gestreckt. Für Unternehmen ist es oft praktischer, dedizierte Server zu pflegen, die ihre spezifischen KI -Anforderungen erfüllen können, ohne von gemeinsamen Cloud -Einschränkungen abhängig zu sein.

Es gibt Grenzen dafür, wie viel virtualisierte Umgebungen bei KI-Workloads umgehen können, die einen ständigen Zugriff auf GPUs und hohe Reminiscence-Systeme erfordern. Sie können Latenz-, Ausfallzeit- und Ressourcen -Drosselungen durch Investition in physische Infrastruktur vermeiden. Es ist eine der wenigen Möglichkeiten, um konsistente Modelltrainingsgeschwindigkeiten und schnellere Bereitstellungszyklen in den Abteilungen zu gewährleisten.

Ein Bericht der Worldwide Vitality Company ergab, dass die US -Wirtschaft aufgrund steigender Datenverarbeitungsanforderungen darauf eingestellt ist Konsumieren Sie im Jahr 2030 mehr Strom zum Umgang mit Daten als für die Herstellung. Sie können dies als Zeichen dafür interpretieren, wie die digitale Macht die traditionelle Industrie als Hauptwirtschaftsfahrer überholt hat. Es ist auch eine Warnung, dass Unternehmen, die sich auf KI verlassen, sorgfältig über ihre Infrastruktur-Fußabdruck und langfristige Energiekosten nachdenken müssen.

Es gibt viele Vorteile, engagierte Server in dieser neuen Umgebung zu besitzen. Sie erhalten direkte Kontrolle über Sicherheit, Verfügbarkeit und Skalierbarkeit ohne die versteckten Gebühren, die häufig Cloud -Dienste begleiten. Es ist auch einfacher, die Leistung vorherzusagen, da Ihre Ressourcen nicht mit anderen Kunden geteilt werden, die nicht in Beziehung stehende Workloads ausführen.

Sie können davon ausgehen, dass große Unternehmen die einzigen sind, die sich mit diesem Drawback konfrontiert, aber selbst mittelgroße Unternehmen spüren die Crunch. Es gibt nur wenige KI-Workflows, die sich nicht mehr auf intensives Datentraining oder Echtzeitanalysen verlassen. Während der Skalierung erkennen die Groups oft, wie schnell die Cloud -Kosten die vorhersehbaren Kosten für die Aufrechterhaltung eines dedizierten Techniques übertreffen können.

Der Anstieg der Rechennachfrage verlangsamt sich nicht so schnell. Sie können erwarten, dass der Energie- und Hardwaredrücke steigt, wenn KI -Modelle komplexer und in den täglichen Betrieb integriert werden. Es ist bereits klar, dass Unternehmen ein langfristiges Datenmanagement und die Resilienz der Stromversorgung planen müssen, anstatt KI nur als ein weiteres Software program-Improve zu behandeln.

Die Serverinfrastruktur Ihres Unternehmens bestimmt, wie schnell Anwendungen ausgeführt werden, wie viele Benutzer gleichzeitig auf Dienste zugreifen können und wie sicher Ihre Daten bestehen. Während gemeinsame Internet hosting und virtuelle non-public Server für kleinere Operationen funktionieren, benötigen Unternehmen, die bestimmte Schwellenwerte erreichen, die vollständigen Ressourcen und Kontrolle, die engagierte Server bereitstellen. Hier sind fünf spezifische Gründe, warum das Umschalten auf dedizierte {Hardware} für wachsende Unternehmen sinnvoll ist.

Vollständige Verarbeitungsleistung ohne Wettbewerb

Dedizierte Server erhalten Sie exklusiven Zugriff auf alle CPU -Kerne, RAM und Speicher auf der Maschine. Beim gemeinsam genutzten Internet hosting kann Ihre Web site einen Second lang auf 2 GB RAM zugreifen und sich im nächsten auf 512 MB drosselt, wenn andere Web sites auf demselben Server Ressourcen konsumieren. Diese Unvorhersehbarkeit verschwindet mit dedizierter {Hardware}.

Betrachten Sie eine E-Commerce-Plattform während des Verkaufs von Black Friday. Beim gemeinsam genutzten Internet hosting kann der Anstieg des Besucherverkehrs dazu führen, dass die Lastzeiten der Seiten von 2 Sekunden auf 8 Sekunden oder mehr erhöht werden. Studien zeigen, dass 40% der Benutzer Web sites aufgeben, deren Laden länger als 3 Sekunden dauert. Bei einem dedizierten Server, der dieselbe Plattform ausführt, bleiben diese Ladezeiten konsistent, da keine anderen Web sites von Ihrem Prozessor oder Speicherpool abziehen.

Wenn gemeinsame Ressourcen Engpässe erstellen

Wachsende Unternehmen beginnen häufig mit gemeinsam genutzten Internet hosting -Plänen, bei denen mehrere Web sites um dieselben Serverressourcen konkurrieren. Diese Vereinbarung funktioniert, bis Verkehrspikes oder Ressourcenanforderungen zunehmen, was zu Verlangsamungen führt, die jeden Prozess von Datenbankabfragen zur Dateiübertragung beeinflussen. Unternehmen, die ressourcenintensive Anwendungen ausführen dediziertes Server -Internet hosting Optionen, die jeweils unterschiedliche Ressourcenisolation bieten.

Der Engpass -Effekt zeigt sich bei der Untersuchung der Server -Antwortzeiten während der Spitzenzeiten. In einem Unternehmen, das Finanztransaktionen verarbeitet, könnte die Abfragen von Millisekunden in volle Sekunden lang springen, wenn benachbarte Konten auf der gemeinsamen Infrastruktur übermäßige Bandbreite oder Verarbeitungsleistung verbrauchen. Diese Verzögerungen werden über miteinander verbundene Systeme hinweg zusammengesetzt und verwandeln geringfügige Verlangsamungen in operative Probleme, die sich auf Kundentransaktionen und interne Workflows auswirken.

Vollständige Kontrolle über die Serverkonfiguration

Mit dedizierten Servern können Sie alle Betriebssysteme, Software program -Stapel oder benutzerdefinierte Anwendungen installieren, die Ihr Unternehmen benötigt. Sie können Home windows Server 2022 mit bestimmten .NET -Framework -Versionen ausführen oder a bereitstellen Abgeklagte Linux-Verteilung optimiert für Ihre spezielle Arbeitsbelastung. Shared Internet hosting sperrt Sie in vorgegebene Konfigurationen, die möglicherweise Kompromisse bei Ihrer technologischen Auswahl erzwingen.

Ein medizinisches Bildgebungsunternehmen benötigt beispielsweise möglicherweise spezialisierte GPU -Treiber für die Verarbeitung von CT -Scans. Die Set up dieser Treiber erfordert Root -Zugriffs- und Kernel -Änderungen, die freigegebene Internet hosting -Anbieter nicht zulassen. Das gleiche Unternehmen muss möglicherweise auch eine proprietäre Analyse -Software program ausführen, für die bestimmte Bibliotheksversionen erforderlich sind, die mit Commonplace -Internet hosting -Umgebungen nicht kompatibel sind. Dedizierte Server entfernen diese Einschränkungen vollständig.

Sicherheit durch körperliche Isolation

Ihre Daten stehen allein auf dedizierter {Hardware} und beseitigen Risiken aus benachbarten Konten. Shared Server sind mit Kreuzkontaminationsbedrohungen ausgesetzt, bei denen Sicherheitslücken im Code eines Kunden möglicherweise andere Standorte auf derselben Maschine freilegen können. Im Jahr 2019 entdeckten die Forscher die Sicherheitsanfälligkeit „Aspect-Channel Assault“, die es böswilligen Akteuren ermöglichte, Verschlüsselungsschlüssel aus virtuellen Maschinen zu extrahieren, die denselben physischen Prozessor teilen.

Finanzdienstleistungsunternehmen, die Zahlungskartendaten bearbeiten, müssen den PCI -DSS -Anforderungen entsprechen, die bei der Steuerung der gesamten Serverumgebung einfacher zu erfüllen sind. Sie können {Hardware}-basierte Verschlüsselung implementieren, benutzerdefinierte Firewall-Regeln auf Kernelebene konfigurieren und sicherstellen, dass die Prüfprotokolle jedes Systemereignis ohne Störung der Aktivitäten anderer Mieter erfassen.

Vorhersehbare Leistungsmetriken

Dedizierte Server liefern konsistente Reaktionszeiten, die Sie Kunden messen und garantieren können. Ein Video -Streaming -Dienst weiß genau, wie viele gleichzeitige Streams sein dedizierter Server verarbeiten können, da die Hardwarespezifikationen konstant bleiben. Sie können 4K -Streaming auf 500 gleichzeitige Benutzer versprechen, da sie dieses genaue Szenario auf ihrer dedizierten {Hardware} getestet haben.

Die Leistungsüberwachung wird unkompliziert, wenn Sie einen einzelnen Mieter verfolgen. Sie können Speicherlecks in Ihrem Anwendungscode identifizieren, anstatt sich zu fragen, ob Verlangsamungen aus externen Faktoren stammen. Die Bemühungen zur Datenbankoptimierung zeigen unmittelbare, messbare Ergebnisse, da die Ausführungszeiten der Abfragen ausschließlich von Ihrer Konfiguration und Workload abhängen.

Direkter Hardwarezugriff für spezielle Anforderungen

Es gibt nur wenige Momente in der technologischen Geschichte, in denen die Nachfrage die Infrastruktur so schnell wie bei KI übertroffen hat. Sie können es in den Skyrocketing Knowledge Middle -Leistungsprojektionen und im bloßen Volumen der Computerzyklen sehen, die sich dem Modelltraining widmen. Es geht nicht nur darum, die neueste {Hardware} zu haben – es geht darum, sicherzustellen, dass die Infrastruktur die Arbeitsbelastung von morgen aufrechterhalten kann.

Sie können jetzt proaktive Schritte unternehmen, indem Sie engagierte Server erkundet, die den Skala und Zielen Ihres Unternehmens entsprechen. Es ist eine zukunftsgerichtete Entscheidung, die dazu beiträgt, Leistung, Sicherheit und Kosten in einer Ära auszugleichen, in der AI nicht nur die Artwork und Weise verändert, wie Unternehmen arbeiten, sondern neu definiert, welche Artwork von Pc sie benötigen, um zu überleben.

Einige Unternehmen benötigen bestimmte Hardwarekonfigurationen, die gemeinsame Umgebungen nicht bereitstellen können. Ein Startup für maschinelles Lernen könnte erforderlich sein Server mit mehreren Nvidia A100 GPUs Für die Ausbildung neuronaler Netzwerke. Audioproduktionsunternehmen benötigen möglicherweise Server mit speziellen Soundkarten für die Echtzeitverarbeitung. Gaming-Unternehmen benötigen oft Server mit hochfrequentem CPUs, das für eine Leistung mit einem Thread optimiert ist, anstatt für einen Multi-Core-Durchsatz.

Dedizierte Server ermöglichen auch physische {Hardware} -Ergänzungen und -änderungen. Sie können RAID-Controller-Karten für den redundanten Speicher hinzufügen, 10-Gigabit-Netzwerkschnittstellen für eine schnellere Datenübertragung installieren oder externe Speicherarrays für erweiterte Kapazitäten anschließen. Diese Anpassungen auf Hardwareebene sind in gemeinsam genutzten oder virtualisierten Umgebungen unmöglich.

Die Entscheidung, auf dedizierte Server zu wechseln, hängt von Ihren spezifischen Leistungsanforderungen, Sicherheitsbedürfnissen und Wachstumsprognosen ab. Unternehmen, die smart Daten verarbeiten, ressourcenintensive Anwendungen ausführen oder garantierte Leistungsstufen benötigen, ermitteln, dass dedizierte Server Probleme lösen, die andere Internet hosting-Optionen nicht beheben können. Die höheren monatlichen Kosten führen zu einer vorhersehbaren Leistung, der vollständigen Kontrolle und der Beseitigung des Ressourcenwettbewerbs, der den Geschäftsbetrieb auf der gemeinsamen Infrastruktur einschränkt.