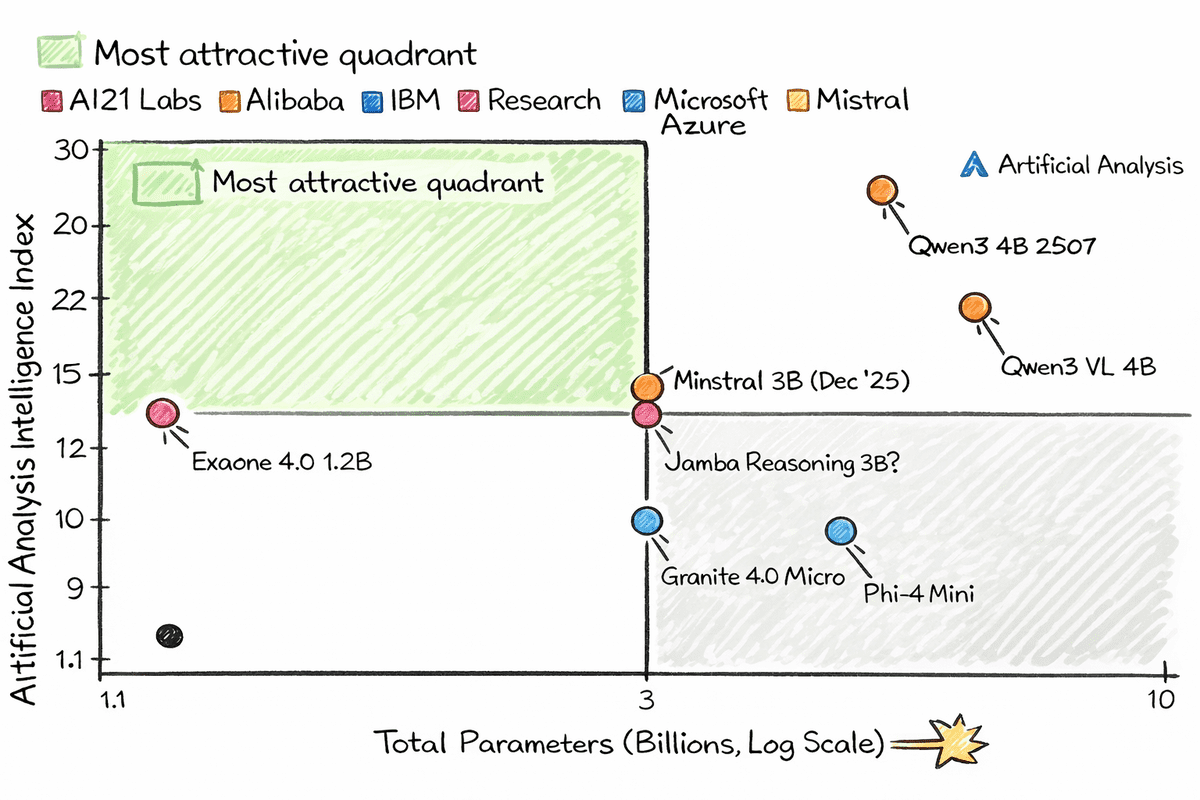

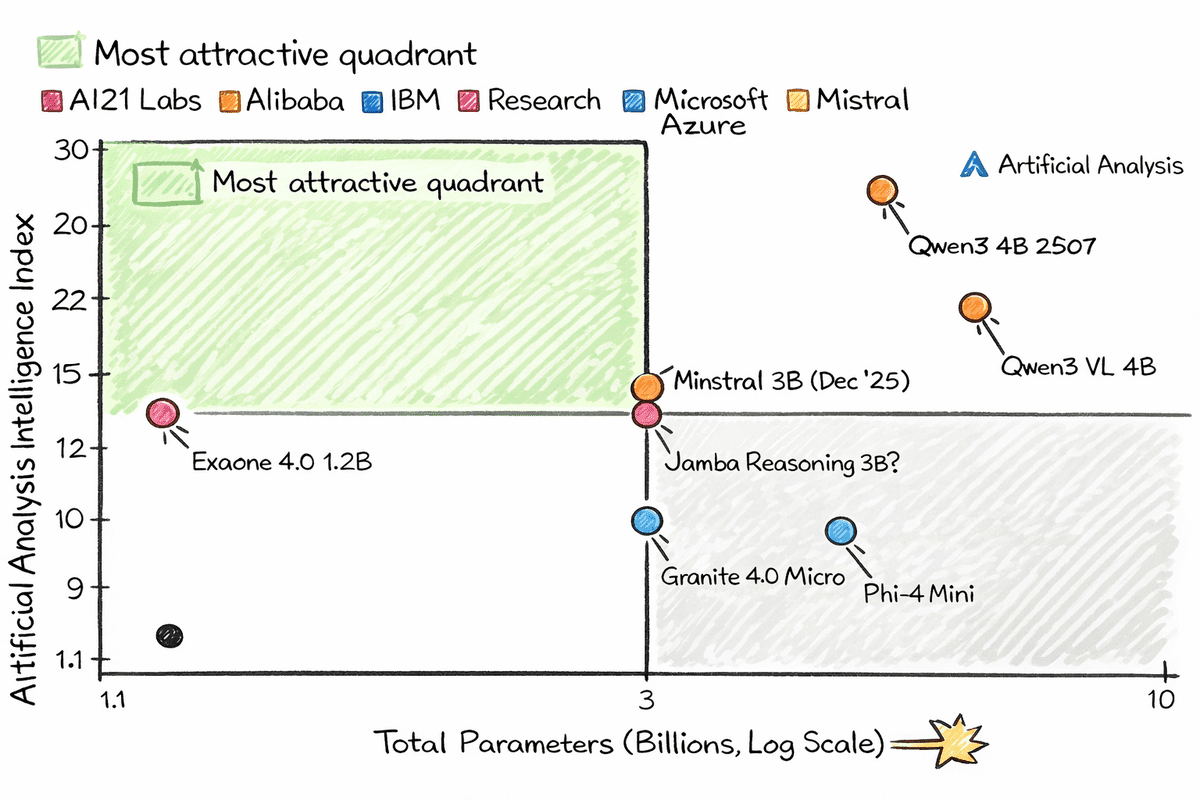

Bild basierend auf Künstliche Analyse

# Einführung

Wir sprechen oft von kleinen KI-Modellen. Aber was ist mit winzigen Modellen, die tatsächlich auf einem Raspberry Pi mit begrenzter CPU-Leistung und sehr wenig RAM laufen können?

Dank moderner Architekturen und aggressiver Quantisierung können Modelle mit etwa 1 bis 2 Milliarden Parametern jetzt auf extrem kleinen Geräten ausgeführt werden. Wenn sie quantisiert sind, können diese Modelle quick überall laufen, sogar auf Ihrem intelligenten Kühlschrank. Sie benötigen lediglich llama.cpp, ein quantisiertes Modell aus dem Hugging Face Hub, und einen einfachen Befehl, um loszulegen.

Das Spannende an diesen winzigen Modellen ist, dass sie weder schwach noch veraltet sind. Viele von ihnen übertreffen viel ältere große Modelle bei der Textgenerierung in der realen Welt. Einige unterstützen auch Software-Aufrufe, Imaginative and prescient-Verstehen und strukturierte Ausgaben. Das sind keine kleinen und dummen Modelle. Sie sind klein, schnell und überraschend clever und können auf Geräten ausgeführt werden, die in Ihre Handfläche passen.

In diesem Artikel werden wir 7 winzige KI-Modelle untersuchen, die mit llama.cpp intestine auf einem Raspberry Pi und anderen Maschinen mit geringem Stromverbrauch laufen. Wenn Sie mit lokaler KI ohne GPUs, Cloud-Kosten oder umfangreiche Infrastruktur experimentieren möchten, ist diese Liste ein guter Ausgangspunkt.

# 1. Qwen3 4B 2507

Qwen3-4B-Instruct-2507 ist ein kompaktes und dennoch äußerst leistungsfähiges, nicht denkendes Sprachmodell, das für seine Größe einen großen Leistungssprung bietet. Mit nur 4 Milliarden Parametern zeigt es starke Fortschritte in den Bereichen Unterrichtsfolge, logisches Denken, Mathematik, Naturwissenschaften, Codierung und Werkzeugnutzung und erweitert gleichzeitig die Abdeckung von Lengthy-Tail-Wissen über viele Sprachen hinweg.

Das Modell zeigt eine deutlich verbesserte Anpassung an Benutzerpräferenzen bei subjektiven und offenen Aufgaben, was zu einer klareren, hilfreicheren und qualitativ hochwertigeren Textgenerierung führt. Durch die Unterstützung einer beeindruckenden nativen Kontextlänge von 256 KB kann es extrem lange Dokumente und Konversationen effizient verarbeiten, was es zu einer praktischen Wahl für reale Anwendungen macht, die sowohl Tiefe als auch Geschwindigkeit erfordern, ohne den Overhead größerer Modelle.

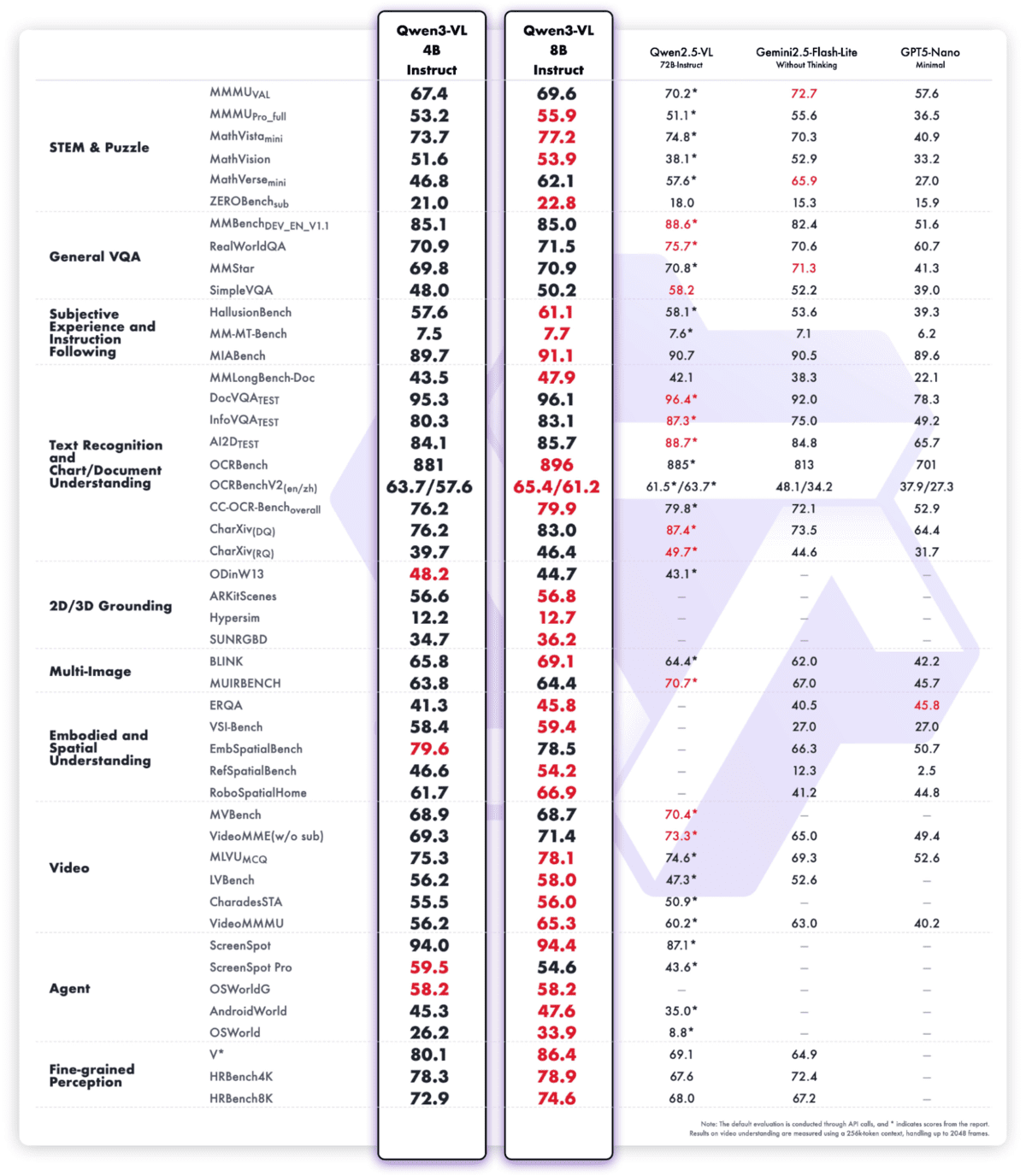

# 2. Qwen3 VL 4B

Qwen3-VL-4B-Instruct ist das bislang fortschrittlichste Imaginative and prescient-Language-Modell der Qwen-Familie und vereint modernste multimodale Intelligenz in einem hocheffizienten 4B-Parameter-Formfaktor. Es bietet ein hervorragendes Textverständnis und eine bessere Textgenerierung, kombiniert mit einer tieferen visuellen Wahrnehmung, Argumentation und einem räumlichen Bewusstsein, und ermöglicht so eine starke Leistung bei Bildern, Movies und langen Dokumenten.

Das Modell unterstützt nativen 256K-Kontext (erweiterbar auf 1 MB) und ermöglicht so die Verarbeitung ganzer Bücher oder stundenlanger Movies mit präzisem Abruf und feinkörniger zeitlicher Indizierung. Architektur-Upgrades wie Interleaved-MRoPE, DeepStack-Visible-Fusion und präzise Textual content-Zeitstempel-Ausrichtung verbessern die Argumentation von Movies über lange Zeithorizonte, die Erkennung feiner Particulars und die Bild-Textual content-Erdung erheblich

Über die Wahrnehmung hinaus fungiert Qwen3-VL-4B-Instruct als visueller Agent, der PC- und cell GUIs bedienen, Instruments aufrufen, visuellen Code (HTML/CSS/JS, Draw.io) generieren und komplexe multimodale Arbeitsabläufe mit einer sowohl auf Textual content als auch auf Imaginative and prescient basierenden Argumentation abwickeln kann.

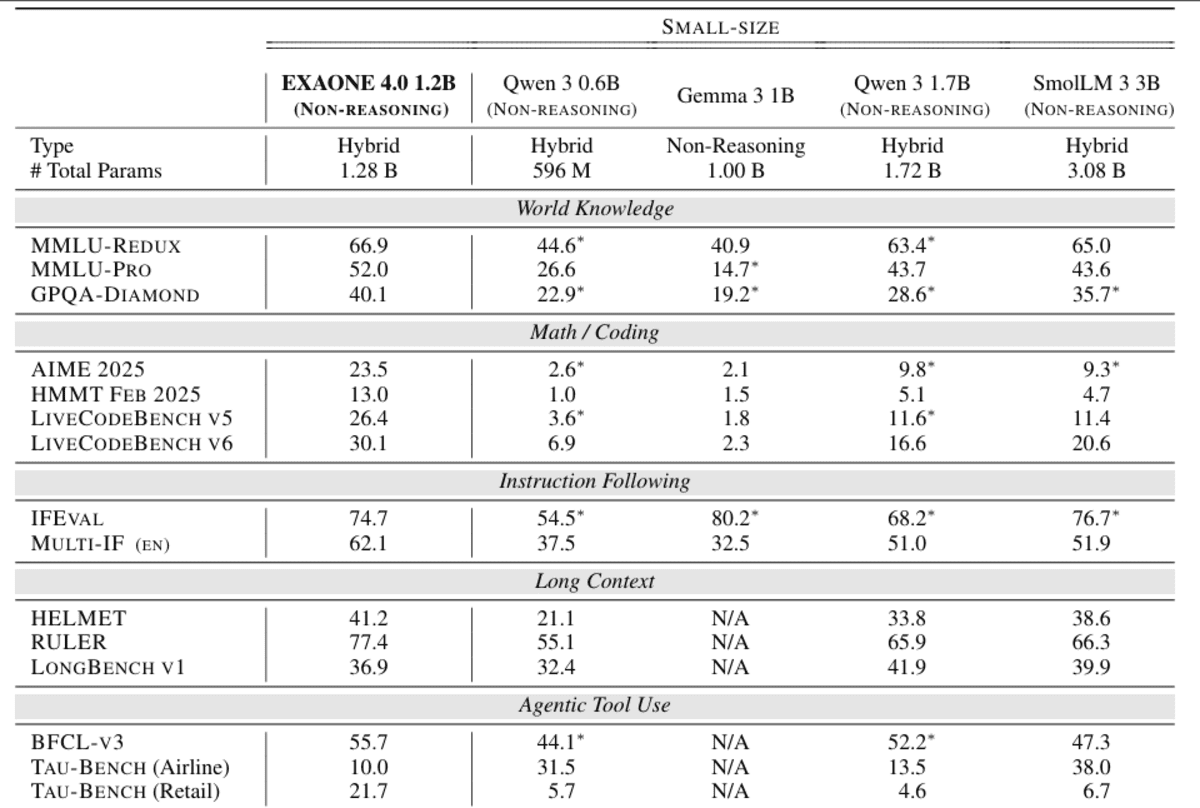

# 3. Exaone 4.0 1.2B

EXAONE 4.0 1.2B ist ein kompaktes, gerätefreundliches Sprachmodell, das entwickelt wurde, um agentische KI und hybrides Denken in äußerst ressourceneffiziente Bereitstellungen zu integrieren. Es integriert sowohl den Nicht-Begründungsmodus für schnelle, praktische Antworten als auch einen optionalen Begründungsmodus für die Lösung komplexer Probleme, sodass Entwickler innerhalb eines einzigen Modells dynamisch zwischen Geschwindigkeit und Tiefe wechseln können.

Trotz ihrer geringen Größe unterstützt die 1.2B-Variante die Verwendung von Agententools, ermöglicht Funktionsaufrufe und autonome Aufgabenausführung und bietet mehrsprachige Funktionen in Englisch, Koreanisch und Spanisch, wodurch ihr Nutzen über einsprachige Edge-Anwendungen hinaus erweitert wird.

Architektonisch übernimmt es die Fortschritte von EXAONE 4.0 wie hybride Aufmerksamkeit und verbesserte Normalisierungsschemata und unterstützt gleichzeitig eine 64-KByte-Token-Kontextlänge, was es ungewöhnlich stark für das Verständnis langer Kontexte in dieser Größenordnung macht

Es ist auf Effizienz optimiert und speziell für geräteinterne und kostengünstige Inferenzszenarien konzipiert, bei denen Speicherbedarf und Latenz ebenso wichtig sind wie die Modellqualität.

# 4. Ministerial 3B

Ministerl-3-3B-Instruct-2512 ist das kleinste Mitglied der Ministral 3-Familie und ein hocheffizientes kleines multimodales Sprachmodell, das speziell für den Edge- und ressourcenarmen Einsatz entwickelt wurde. Es handelt sich um ein fein abgestimmtes FP8-Unterweisungsmodell, das speziell für Arbeitsbelastungen im Chat und bei der Befolgung von Anweisungen optimiert ist und gleichzeitig eine starke Einhaltung von Systemaufforderungen und strukturierten Ausgaben gewährleistet

Architektonisch kombiniert es ein 3,4-B-Parameter-Sprachmodell mit einem 0,4-B-Imaginative and prescient-Encoder und ermöglicht so das native Bildverständnis neben der Textbegründung.

Trotz seiner kompakten Größe unterstützt das Modell ein großes 256K-Kontextfenster, eine robuste mehrsprachige Abdeckung über Dutzende Sprachen sowie native Agentenfunktionen wie Funktionsaufrufe und JSON-Ausgabe, wodurch es sich intestine für Echtzeit-, eingebettete und verteilte KI-Systeme eignet.

Ministral 3 3B Instruct ist so konzipiert, dass es in FP8 innerhalb von 8 GB VRAM passt (und sogar noch weniger, wenn es quantisiert ist) und bietet eine starke Leistung professional Watt und professional Greenback für Produktionsanwendungsfälle, die Effizienz ohne Einbußen bei der Leistungsfähigkeit erfordern

# 5. Jamba-Argumentation 3B

Jamba-Reasoning-3B ist ein kompaktes und dennoch außergewöhnlich leistungsfähiges Argumentationsmodell mit 3 Milliarden Parametern, das starke Intelligenz, Verarbeitung langer Kontexte und hohe Effizienz auf kleinem Raum bietet.

Seine entscheidende Innovation ist eine hybride Transformer-Mamba-Architektur, bei der eine kleine Anzahl von Aufmerksamkeitsschichten komplexe Abhängigkeiten erfasst, während die meisten Schichten Mamba-Zustandsraummodelle für eine hocheffiziente Sequenzverarbeitung verwenden.

Dieses Design reduziert den Speicheraufwand erheblich und verbessert den Durchsatz, sodass das Modell reibungslos auf Laptops, GPUs und sogar Geräten der Mobilklasse läuft, ohne dass die Qualität darunter leidet.

Trotz seiner Größe unterstützt Jamba Reasoning 3B 256K-Token-Kontexte und lässt sich auf sehr lange Dokumente skalieren, ohne auf large Aufmerksamkeits-Caches angewiesen zu sein, was die Inferenz langer Kontexte praktisch und kostengünstig macht

Bei Intelligenz-Benchmarks übertrifft es vergleichbare kleine Modelle wie Gemma 3 4B und Llama 3.2 3B bei einem kombinierten Ergebnis aus mehreren Bewertungen und zeigt eine für seine Klasse ungewöhnlich starke Denkfähigkeit.

# 6. Granit 4.0 Micro

Granit-4.0-Mikro ist ein 3B-Parameter-Langkontext-Anweisungsmodell, das vom Granite-Staff von IBM entwickelt und speziell für Assistenten und Agenten-Workflows der Unternehmensklasse entwickelt wurde.

Feinabgestimmt von Granite-4.0-Micro-Base unter Verwendung einer Mischung aus freizügig lizenzierten offenen Datensätzen und hochwertigen synthetischen Daten, legt es Wert auf zuverlässige Befolgung von Anweisungen, professionellen Ton und sichere Antworten, verstärkt durch eine standardmäßige Systemaufforderung, die in seinem Replace vom Oktober 2025 hinzugefügt wurde.

Das Modell unterstützt ein sehr großes 128K-Kontextfenster, starke Werkzeugaufruf- und Funktionsausführungsfunktionen sowie eine umfassende mehrsprachige Unterstützung, die die wichtigsten europäischen, nahöstlichen und ostasiatischen Sprachen abdeckt.

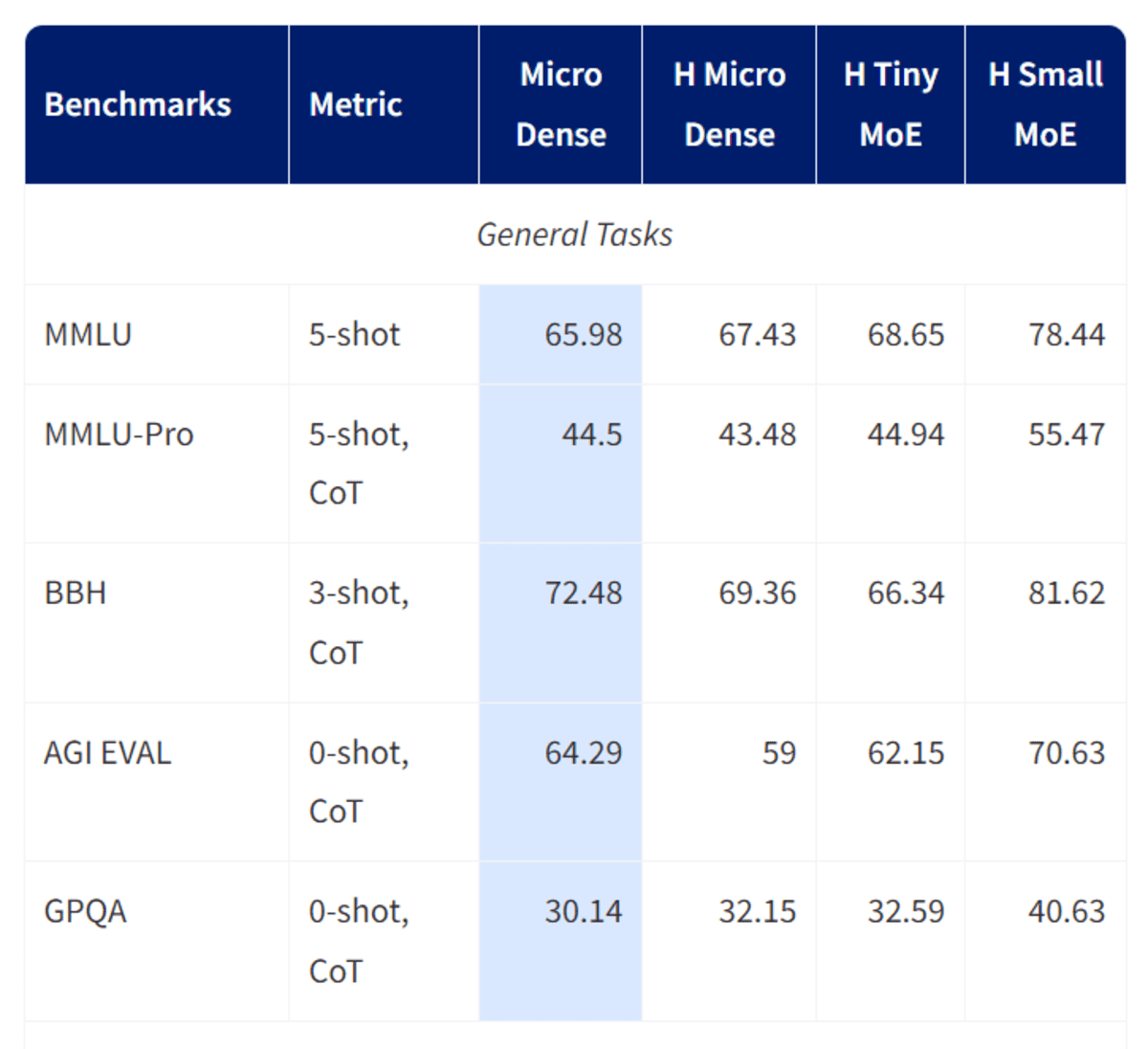

Granite-4.0-Micro basiert auf einer dichten, reinen Decoder-Transformator-Architektur mit modernen Komponenten wie GQA, RoPE, SwiGLU MLPs und RMSNorm. Granite-4.0-Micro vereint Robustheit und Effizienz und eignet sich daher intestine als Basismodell für Geschäftsanwendungen, RAG-Pipelines, Codierungsaufgaben und LLM-Agenten, die unter einer Apache 2.0-Open-Supply-Lizenz sauber in externe Systeme integriert werden müssen.

# 7. Phi-4 Mini

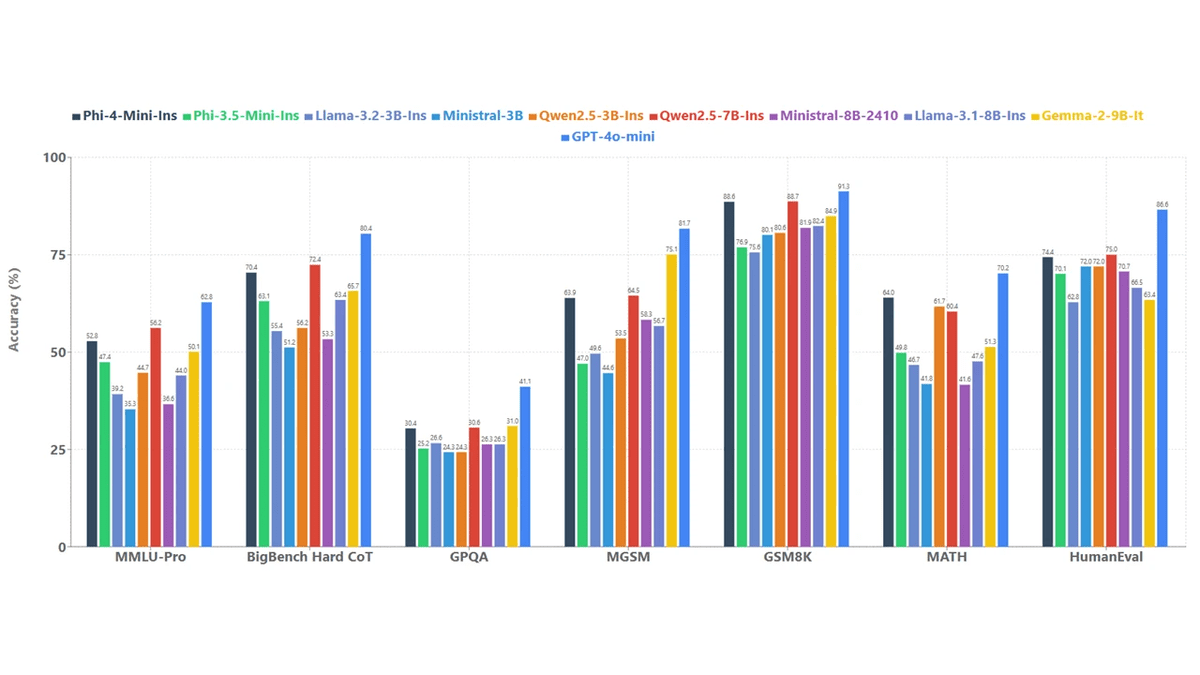

Phi-4-Mini-Anweisung ist ein leichtes, offenes 3,8-B-Parameter-Sprachmodell von Microsoft, das eine starke Leistung beim Denken und Befolgen von Anweisungen unter engen Speicher- und Rechenbeschränkungen bietet.

Es basiert auf einer dichten, reinen Decoder-Transformer-Architektur und wird in erster Linie auf hochwertigen synthetischen „Lehrbuch-ähnlichen“ Daten und sorgfältig gefilterten öffentlichen Quellen trainiert, wobei der Schwerpunkt bewusst auf begründungsintensiven Inhalten statt auf rohem Auswendiglernen von Fakten liegt.

Das Modell unterstützt ein 128-KByte-Token-Kontextfenster und ermöglicht so das Verständnis langer Dokumente und ausführlicher Gespräche, was in dieser Größenordnung ungewöhnlich ist.

Put up-Coaching kombiniert überwachte Feinabstimmung und direkte Präferenzoptimierung, was zu einer präzisen Einhaltung von Anweisungen, robustem Sicherheitsverhalten und effektivem Funktionsaufruf führt.

Mit einem großen 200K-Token-Vokabular und einer breiten mehrsprachigen Abdeckung positioniert sich Phi-4-mini-instruct als praktischer Baustein für Forschungs- und Produktionssysteme, die Latenz, Kosten und Argumentationsqualität in Einklang bringen müssen, insbesondere in Umgebungen mit eingeschränktem Speicher oder Rechenleistung.

# Letzte Gedanken

Winzige Modelle haben einen Punkt erreicht, an dem die Größe keine Einschränkung mehr für die Leistungsfähigkeit darstellt. Die Qwen 3-Serie sticht in dieser Liste heraus und bietet eine Leistung, die mit viel größeren Sprachmodellen mithalten kann und sogar einige proprietäre Systeme in Frage stellt. Wenn Sie Anwendungen für einen Raspberry Pi oder andere Geräte mit geringem Stromverbrauch erstellen, ist Qwen 3 ein ausgezeichneter Ausgangspunkt und es lohnt sich, ihn in Ihr Setup zu integrieren.

Über Qwen hinaus sind die EXAONE 4.0 1.2B-Modelle besonders stark in der Argumentation und nicht-trivialen Problemlösung, bleiben aber deutlich kleiner als die meisten Alternativen. Der Ministral 3B verdient auch Aufmerksamkeit als neueste Model seiner Serie, die einen aktualisierten Wissensgrenzwert und eine solide Allzweckleistung bietet.

Insgesamt sind viele dieser Modelle beeindruckend, aber wenn Ihre Prioritäten auf Geschwindigkeit, Genauigkeit und Software-Calling liegen, sind die LLM- und VLM-Varianten von Qwen 3 kaum zu übertreffen. Sie zeigen deutlich, wie weit die winzige On-Machine-KI fortgeschritten ist und warum lokale Inferenz auf kleiner {Hardware} kein Kompromiss mehr ist.

Abid Ali Awan (@1abidaliawan) ist ein zertifizierter Datenwissenschaftler, der gerne Modelle für maschinelles Lernen erstellt. Derzeit konzentriert er sich auf die Erstellung von Inhalten und das Schreiben technischer Blogs zu maschinellem Lernen und Datenwissenschaftstechnologien. Abid verfügt über einen Grasp-Abschluss in Technologiemanagement und einen Bachelor-Abschluss in Telekommunikationstechnik. Seine Imaginative and prescient ist es, ein KI-Produkt mithilfe eines graphischen neuronalen Netzwerks für Schüler mit psychischen Erkrankungen zu entwickeln.