Während wir uns dem Jahr 2025 nähern, dachte ich, es wäre intestine, einen Blick zurück auf die KI-Modelle zu werfen, die das ganze Jahr über einen bleibenden Eindruck hinterlassen haben. Dieses Jahr rückten neue KI-Modelle ins Rampenlicht, während auch einige der älteren Modelle stark an Popularität gewannen. Von der Verarbeitung natürlicher Sprache bis hin zu Pc Imaginative and prescient haben diese Modelle eine Vielzahl von Themen beeinflusst KI Domänen. In diesem Artikel werden die Modelle vorgestellt, die im Jahr 2025 die größte Wirkung erzielt haben.

Kriterien für die Modellauswahl

Die in diesem Artikel aufgeführten KI-Modelle wurden anhand der folgenden Kriterien aus den HuggingFace-Bestenlisten ausgewählt:

- Die Anzahl der Downloads

- Entweder über eine Apache 2.0- oder MIT-Open-Supply-Lizenz verfügen

Dazu gehört eine Mischung aus Modellen, die in diesem Jahr herauskamen oder im Vorjahr, die einen Anstieg der Beliebtheit erlebten. Die vollständige Liste der HuggingFace-Bestenliste finden Sie hier: https://huggingface.co/fashions?license=license:apache-2.0&type=downloads

1. Satztransformator MiniLM

Kategorie: Verarbeitung natürlicher Sprache

Ein kompaktes Einbettungsmodell für englische Sätze, das für semantische Ähnlichkeit, Clustering und Abruf optimiert ist. Es destilliert MiniLM in einen 6-Schicht-Transformator (384-dimensionale Einbettungen), der auf Millionen von Satzpaaren trainiert wird. Trotz seiner Größe bietet es eine starke Leistung bei semantischen Such- und Themenmodellierungsaufgaben und kann mit größeren Modellen mithalten.

Lizenz: Apache 2.0

HuggingFace-Hyperlink: https://huggingface.co/sentence-transformers/all-MiniLM-L6-v2

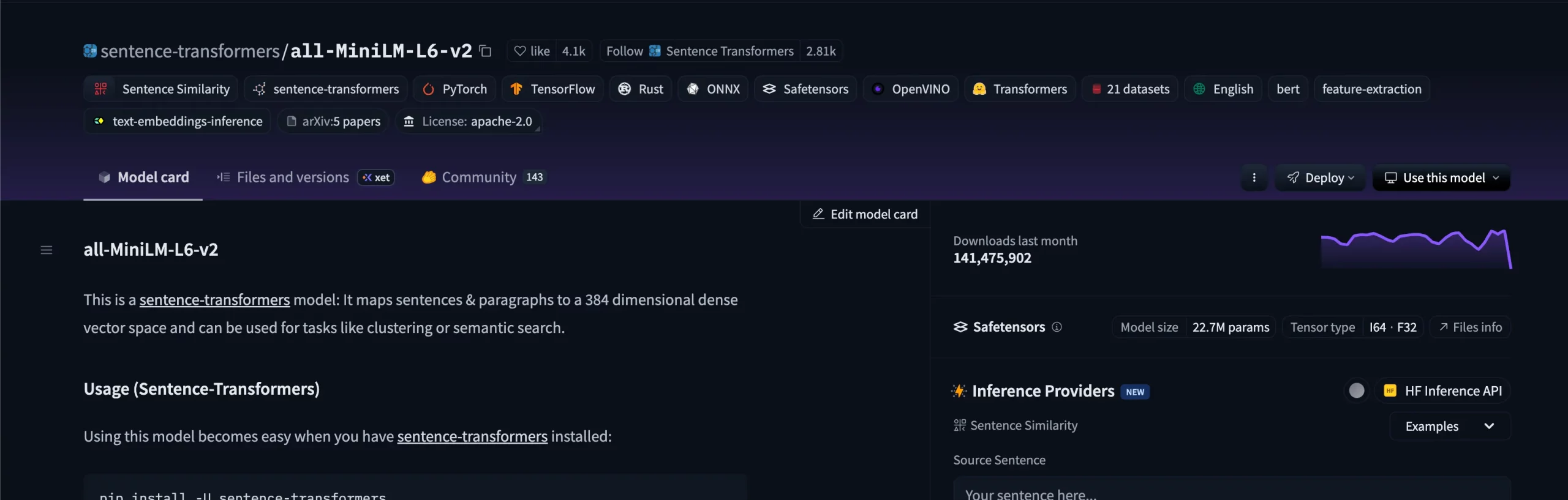

2. Google Electra Base Discriminator

Kategorie: Verarbeitung natürlicher Sprache

ELECTRA definiert die maskierte Sprachmodellierung neu, indem es Modelle trainiert, ersetzte Token zu erkennen, anstatt sie vorherzusagen. Die Basisversion (110 Millionen Parameter) erreicht eine mit der BERT-Foundation vergleichbare Leistung und erfordert dabei viel weniger Rechenaufwand. Es wird häufig zur Merkmalsextraktion und Feinabstimmung verwendet Einstufung und QS-Pipelines.

Lizenz: Apache 2.0

HuggingFace-Hyperlink: https://huggingface.co/google/electra-base-discriminator

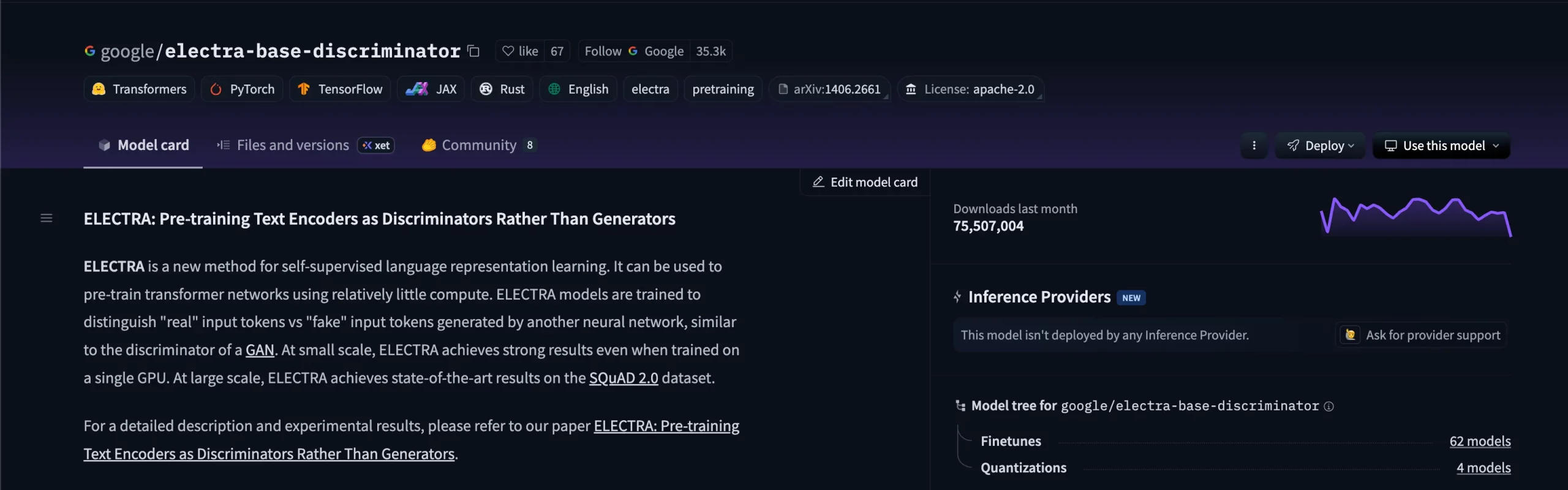

3. FalconsAI NSFW-Bilderkennung

Kategorie: Pc Imaginative and prescient

A CNN-basiertes Modell zur Erkennung von NSFW oder unsicheren Inhalten in Bildern. Nutzer von Web sites wie Reddit sind sich des berüchtigten „NSFW-Blockers“ bewusst. Es basiert auf Architekturen wie EfficientNet oder MobileNet und gibt Wahrscheinlichkeiten für die Kategorien „sicher“ und „unsicher“ aus, was es zu einer wichtigen Moderationskomponente für KI-generierte oder vom Benutzer hochgeladene Visuals macht.

Lizenz: Apache 2.0

HuggingFace Hyperlink: https://huggingface.co/Falconsai/nsfw_image_detection

4. Google Uncased BERT

Kategorie: Verarbeitung natürlicher Sprache

Das ursprüngliche BERT-Basismodell von Google Analysis, trainiert auf BooksCorpus und der englischen Wikipedia. Mit 12 Schichten und 110 Millionen Parametern legte es den Grundstein für moderne Transformatorarchitekturen und bleibt eine starke Foundation für Klassifizierung, NER und Fragebeantwortung.

Lizenz: Apache 2.0

HuggingFace Hyperlink: https://huggingface.co/google-bert/bert-base-uncased

5. Alterserkennung des Fairface-Bildes

Kategorie: Pc Imaginative and prescient

Ein auf dem FairFace-Datensatz trainiertes Modell zur Vorhersage des Gesichtsalters, das eine ausgewogene Darstellung von ethnischer Zugehörigkeit und Geschlecht betont. Es priorisiert Equity und demografische Konsistenz und eignet sich daher für Analyse- und Forschungspipelines mit Gesichtsattributen.

Lizenz: Apache 2.0

HuggingFace-Hyperlink: https://huggingface.co/dima806/fairface_age_image_detection

6. MobileNet-Bildklassifizierungsmodell

Kategorie: Pc Imaginative and prescient

Ein leichter Faltungsbildklassifizierer aus der timm-Bibliothek, der für den effizienten Einsatz auf Geräten mit begrenzten Ressourcen entwickelt wurde. MobileNetV3 Small, trainiert auf ImageNet-1k mit dem LAMB-Optimierer, erreicht solide Genauigkeit mit geringer Latenz und ist somit perfect für Edge- und cell Inferenz.

Lizenz: Apache 2.0

HuggingFace-Hyperlink: https://huggingface.co/timm/mobilenetv3_small_100.lamb_in1k

7. Laion CLAP

Kategorie: Multimodal (Audio zu Sprache)

Eine Fusion von CLAP (Contrastive Language–Audio Pretraining) und HTS-AT (Hierarchical Token-Semantic Audio). Transformator), das Audio und Textual content einem gemeinsamen Einbettungsraum zuordnet. Es unterstützt Zero-Shot-Audioabruf, Tagging und Untertitelung und verbindet so Klangverständnis und natürliche Sprache.

Lizenz: Apache 2.0

HuggingFace-Hyperlink: https://huggingface.co/laion/clap-htsat-fused

8. DistilBERT

Kategorie: Verarbeitung natürlicher Sprache

Eine destillierte Model der BERT-Foundation, die von Hugging Face entwickelt wurde, um Leistung und Effizienz in Einklang zu bringen. Es behält etwa 97 % der BERT-Genauigkeit bei, ist aber 40 % kleiner und 60 % schneller und eignet sich perfect für einfache NLP-Aufgaben wie Klassifizierung, Einbettungen und semantische Suche.

Lizenz: Apache 2.0

HuggingFace-Hyperlink: https://huggingface.co/distilbert/distilbert-base-uncased

9. Pyannote-Segmentierung 3

Kategorie: Sprachverarbeitung

Eine Kernkomponente der Pyannote Audio-Pipeline zur Erkennung und Segmentierung von Sprachaktivitäten. Es erkennt Bereiche mit Stille, Einzelsprechern und überlappender Sprache und funktioniert auch in lauten Umgebungen zuverlässig. Wird häufig als Grundlage für Lautsprechersysteme verwendet.

Lizenz: MIT

HuggingFace-Hyperlink: https://huggingface.co/pyannote/segmentation-3.0

10. FacebookAI Roberta Massive

Kategorie: Verarbeitung natürlicher Sprache

Eine strong optimierte BERT Variante, trainiert auf 160 GB englischem Textual content mit dynamischer Maskierung und ohne Vorhersage des nächsten Satzes. Mit 24 Schichten und 355 Mio. Parametern übertrifft RoBERTa-large durchgängig BERT-base bei GLUE und anderen Benchmarks und ermöglicht so eine hohe Genauigkeit NLP Anwendungen.

Lizenz: MIT

HuggingFace Hyperlink: https://huggingface.co/FacebookAI/roberta-large

Abschluss

Diese Liste erhebt keinen Anspruch auf Vollständigkeit, und es gibt mehrere Modelle, die enorme Auswirkungen hatten, es aber nicht auf die Liste geschafft haben. Einige waren genauso wirkungsvoll, hatten aber keine Open-Supply-Lizenz. Und andere hatten einfach keine Zahlen. Aber sie alle haben dazu beigetragen, einen Teil eines größeren Issues zu lösen. Die in dieser Liste geteilten Fashions haben möglicherweise nicht die Begeisterung, die Fashions wie folgen Zwillinge, ChatGPT, Claudeaber was sie anbieten, ist ein offener Transient an Information-Science-Enthusiasten, die Dinge von Grund auf erstellen möchten, ohne ein Rechenzentrum einzurichten.

Häufig gestellte Fragen

A. Die Modelle wurden auf der Grundlage von zwei Schlüsselfaktoren ausgewählt: Gesamtzahl der Downloads auf Hugging Face und eine freizügige Open-Supply-Lizenz (Apache 2.0 oder MIT), um sicherzustellen, dass sie sowohl beliebt als auch frei nutzbar sind.

A. Die meisten sind es, aber für einige – wie Falconsai/nsfw_image_detection oder FairFace-basierte Modelle – können Nutzungsbeschränkungen gelten. Überprüfen Sie vor der Bereitstellung in der Produktion immer die Modellkarte und die Lizenz.

A. Open-Supply-Modelle geben Forschern und Entwicklern die Freiheit, ohne Anbieterbindung oder hohe Infrastrukturanforderungen zu experimentieren, Feinabstimmungen vorzunehmen und bereitzustellen, wodurch Innovationen leichter zugänglich werden.

A. Die meisten von ihnen werden unter freizügigen Lizenzen wie Apache 2.0 oder MIT veröffentlicht, was bedeutet, dass Sie sie sowohl für Forschungs- als auch für kommerzielle Projekte verwenden können.

A. Ja. Viele Produktionssysteme verketten Modelle aus verschiedenen Domänen – zum Beispiel verwenden sie ein Sprachsegmentierungsmodell wie Pyannote, um Dialoge zu isolieren, dann ein Sprachmodell wie RoBERTa, um Stimmungen oder Absichten zu analysieren, und schließlich ein Visionsmodell, um begleitende Bilder zu moderieren.

Melden Sie sich an, um weiterzulesen und von Experten kuratierte Inhalte zu genießen.