Unternehmen bewegen sich von einfachen Chatbots zu komplexen, geschäftskritischen KI-Systemen. Verschiedene Groups experimentieren gleichzeitig, was spannend klingt, aber schnell chaotisch wird. Wenn es keine gemeinsame Kontrollschicht gibt, steigen die Kosten, die Systeme fragmentieren und die Zuverlässigkeit sinkt. Die OpenAI Ausfall im August 2025 machte dies schmerzlich deutlich: Copiloten froren ein, Chatbots versagten und die Produktivität sank branchenübergreifend.

Die Frage ist nun nicht, ob Unternehmen KI nutzen können, sondern ob sie darauf vertrauen können, dass sie ihr Geschäft betreibt. Um KI sicher zu skalieren, müssen Sie eine Möglichkeit haben, sie über Modelle, Anbieter und interne Instruments hinweg zu verwalten, zu steuern und zu überwachen. Die herkömmliche Infrastruktur wurde dafür nicht entwickelt, daher sind zwei neue Schichten entstanden, um diese Lücke zu schließen: das AI Gateway und das MCP. Gemeinsam verwandeln sie verstreute KI-Experimente in etwas Zuverlässiges, Konformitätsfähiges und bereit für den echten Unternehmenseinsatz.

Das KI-Rückgrat des Unternehmens: Kontrolle mit dem KI-Gateway schaffen

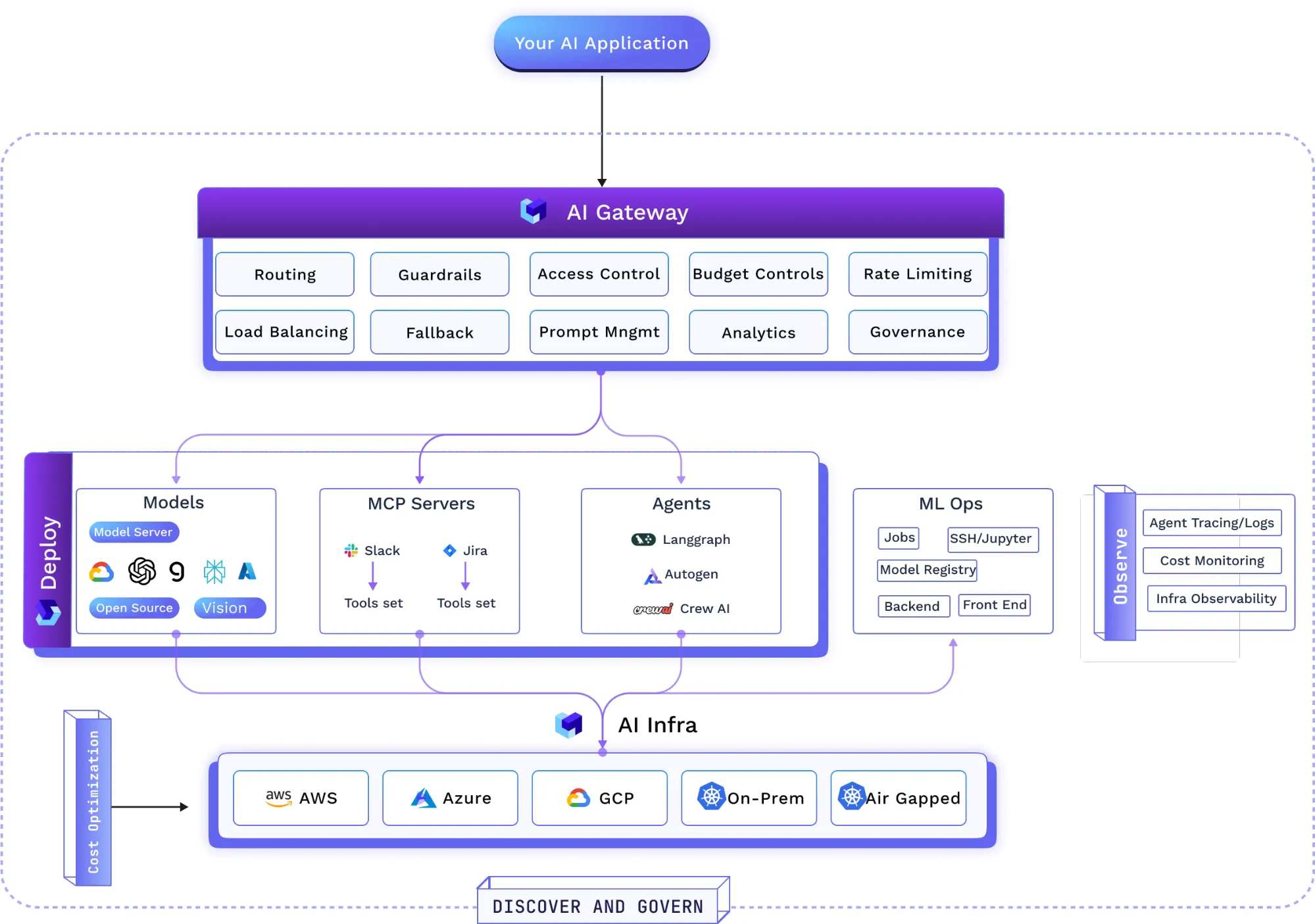

Ein AI Gateway ist mehr als ein einfacher Proxy. Es fungiert als leistungsstarke Middleware-Schicht – die Eingangs-, Richtlinien- und Telemetrieschicht für den gesamten generativen KI-Verkehr. Es ist zwischen Anwendungen und dem Ökosystem der LLM-Anbieter (einschließlich APIs von Drittanbietern und selbst gehosteten Modellen) positioniert und fungiert als einheitliche Steuerungsebene, um die dringendsten Herausforderungen bei der Einführung von KI zu bewältigen.

Einheitlicher Zugriff und Herstellerunabhängigkeit

In einer Welt mit mehreren Modellen ist die Bewältigung der Komplexität eine große Herausforderung. Ein AI Gateway bietet einen einzigen, einheitlichen API-Endpunkt für den Zugriff auf viele LLMs, selbst gehostete Open-Supply-Modelle (z. B. Lama, Falke) und kommerzielle Anbieter (z. B. OpenAI, Claude, Zwillinge, Groq, Mistral). Über eine Schnittstelle kann das Gateway verschiedene Modelltypen unterstützen: Chat, Vervollständigung, Einbettung und Neubewertung.

Eine praktische Designwahl ist die Kompatibilität mit APIs im OpenAI-Stil. Dies reduziert den Integrationsaufwand und ermöglicht Groups die Wiederverwendung vorhandener Shopper-Bibliotheken. Durch die Übersetzung allgemeiner Anfragen in anbieterspezifische Formate fungiert das Gateway als Protokolladapter. Die Wahl eines LLM wird zu einer Laufzeitkonfiguration und nicht zu einer fest codierten Entscheidung. Groups können ein neues, günstigeres oder leistungsstärkeres Modell testen, indem sie eine Einstellung im Gateway ändern, ohne den Anwendungscode zu ändern. Dies beschleunigt das Experimentieren und Optimieren und verringert gleichzeitig das Lock-in-Risiko.

Governance und Compliance

Da KI Teil von Geschäftsprozessen wird, sind Governance und Compliance von entscheidender Bedeutung. Ein AI Gateway zentralisiert die API-Schlüsselverwaltung und bietet entwicklerspezifische Token für die Entwicklung und eng begrenzte, widerrufliche Token für die Produktion. Es erzwingt die rollenbasierte Zugriffskontrolle (RBAC) und lässt sich in Enterprise Single Signal-On (SSO) integrieren, um den Zugriff für bestimmte Benutzer, Groups oder Dienste auf bestimmte Modelle zu definieren.

Richtlinien können einmal auf Gateway-Ebene definiert und bei jeder Anfrage durchgesetzt werden, z. B. das Filtern persönlich identifizierbarer Informationen (PII) oder das Blockieren unsicherer Inhalte. Das Gateway sollte manipulationssichere Aufzeichnungen von Anfragen und Antworten erfassen, um die Prüfbarkeit für Requirements wie SOC 2, HIPAA und DSGVO zu unterstützen. Für Organisationen mit Anforderungen an die Datenresidenz kann das Gateway in einer Digital Non-public Cloud (VPC), vor Ort oder in Air-Hole-Umgebungen bereitgestellt werden, sodass smart Daten unter der Kontrolle des Unternehmens bleiben.

Kostenmanagement und -optimierung

Ohne angemessene Aufsicht können die KI-bezogenen Ausgaben schnell steigen. Ein AI Gateway bietet Instruments für ein proaktives Finanzmanagement, einschließlich der Echtzeitverfolgung der Token-Nutzung und -Ausgaben nach Benutzer, Staff, Modell, Anbieter oder Area. Die Preise können den Preislisten der Anbieter entnommen werden, um eine manuelle Nachverfolgung zu vermeiden.

Diese Transparenz ermöglicht interne Chargeback- oder Showback-Modelle und macht KI zu einer messbaren Ressource. Administratoren können Budgetgrenzen und Kontingente basierend auf Kosten oder Token-Anzahl festlegen, um Überschreitungen zu verhindern. Routingfunktionen können die Kosten senken, indem sie Abfragen für bestimmte Aufgaben an kostengünstige Modelle weiterleiten und, sofern möglich, Techniken wie dynamische Modellauswahl, Caching und Anforderungsstapelung anwenden.

Zuverlässigkeit und Leistung: Wie ein leistungsstarkes KI-Gateway aussieht

Damit KI unverzichtbar ist, muss sie zuverlässig und reaktionsfähig sein. Viele KI-Anwendungen – Echtzeit-Chat-Assistenten und Retrieval-Augmented Era (RAG)-Systeme – reagieren empfindlich auf Latenz. Ein intestine konzipiertes KI-Gateway sollte einen Overhead im einstelligen Millisekundenbereich im Scorching Path anstreben.

Zu den Architekturbüros, die dies ermöglichen, gehören:

- In-Reminiscence-Authentifizierung und Ratenbegrenzung im Anforderungspfad, um externe Netzwerkaufrufe zu vermeiden.

- Asynchrone Protokollierung und Metriken über eine dauerhafte Warteschlange, um den Scorching Path minimal zu halten.

- Horizontale Skalierung mit CPU-gebundener Verarbeitung, um bei steigender Nachfrage eine gleichbleibende Leistung aufrechtzuerhalten.

- Verkehrskontrollen wie latenzbasiertes Routing zum schnellsten verfügbaren Modell, gewichteter Lastausgleich und automatisches Failover, wenn ein Anbieter ausfällt.

Diese Designoptionen ermöglichen es Unternehmen, das Gateway direkt im Produktionsinferenzpfad zu platzieren, ohne übermäßige Leistungseinbußen hinnehmen zu müssen.

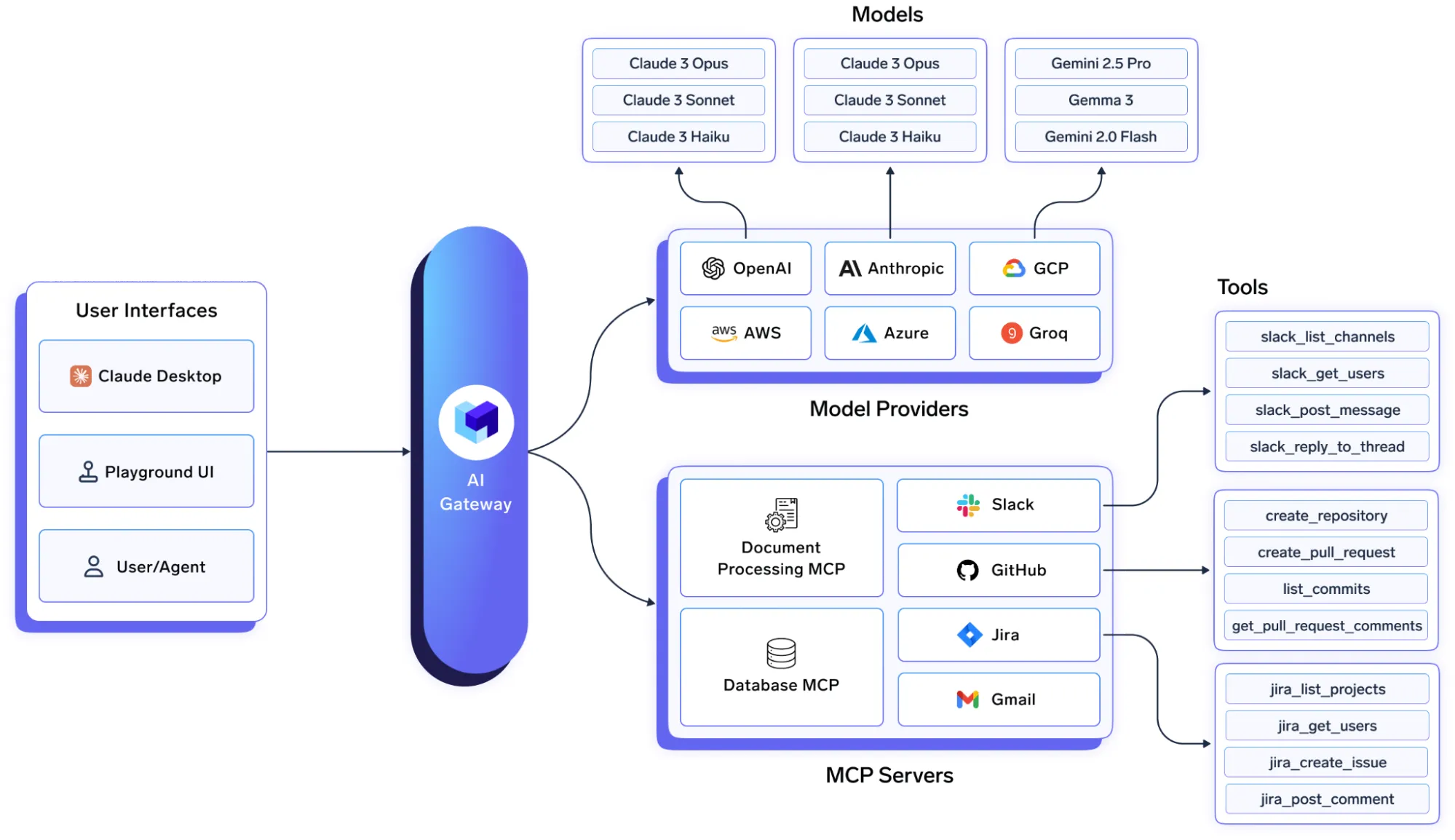

Referenzarchitektur für ein KI-Gateway

Agenten mit der Mannequin Management Aircraft (MCP) freisetzen

Fortschritte in der KI hängen davon ab, was LLMs mithilfe von Instruments erreichen können. Übergang von der Textgenerierung zu Agentische KI. Die Systeme, die mit externen Instruments schlussfolgern, planen und interagieren können, benötigen eine Standardmethode, um Modelle mit den Systemen zu verbinden, die sie verwenden müssen.

Der Aufstieg der Agenten-KI und die Notwendigkeit eines Standardprotokolls

Agentische KI-Systeme bestehen aus zusammenarbeitenden Elementen: einem zentralen Argumentationsmodell, einem Speichermodul, einem Orchestrator und Instruments. Um innerhalb eines Unternehmens nützlich zu sein, müssen diese Agenten zuverlässig mit internen und externen Systemen wie Slack kommunizieren. GitHubJira, Confluence, Datadog und proprietäre Datenbanken und APIs.

In der Vergangenheit conflict für die Verbindung eines LLM mit einem Device benutzerdefinierter Code für jede API erforderlich, der fragil und schwer zu skalieren conflict. Der Mannequin Context Protocol (MCP)eingeführt von Anthropic, standardisiert, wie KI-Agenten Instruments entdecken und mit ihnen interagieren. MCP fungiert als Abstraktionsschicht und trennt das „Gehirn“ der KI (das LLM) von ihren „Händen“ (den Werkzeugen). Ein Agent, der „MCP spricht“, kann jedes über einen MCP-Server bereitgestellte Device erkennen und verwenden, wodurch die Entwicklung beschleunigt und eine modulare, wartbare Architektur für Agentensysteme mit mehreren Instruments gefördert wird.

Die Risiken einer unregierten MCP

Der Einsatz von MCP-Servern ohne Governance in einer Unternehmensumgebung wirft drei Bedenken auf:

- Sicherheit: MCP-Server arbeiten mit den ihnen erteilten Berechtigungen. Der Umgang mit Anmeldeinformationen und die Verwaltung von Zugriffskontrollen über mehrere Instruments hinweg können unsicher und schwer zu prüfen sein.

- Sichtweite: Direkte Verbindungen bieten begrenzte Einblicke in die Agentenaktivität. Ohne zentralisierte Protokolle der Device-Nutzung und -Ergebnisse leidet die Überprüfbarkeit.

- Operationen: Die Verwaltung, Aktualisierung und Überwachung vieler MCP-Server in verschiedenen Umgebungen (Entwicklung, Staging, Produktion) ist komplex.

Die Risiken eines unkontrollierten MCP entsprechen denen eines unregulierten LLM-API-Zugriffs, können jedoch größer sein. Ein ungeprüfter Agent mit Device-Zugriff könnte beispielsweise eine Produktionsdatenbank löschen, vertrauliche Informationen in einem öffentlichen Kanal veröffentlichen oder Finanztransaktionen falsch ausführen. Eine Governance-Schicht für MCP ist daher für Unternehmensbereitstellungen unerlässlich.

Der moderne Gen-AI-Stack

Das Gateway als Kontrollpunkt für die Agenten-KI

Ein KI-Gateway mit MCP-Bewusstsein ermöglicht es Unternehmen, interne MCP-Server über eine zentrale Schnittstelle zu registrieren, bereitzustellen und zu verwalten. Das Gateway kann als sicherer Proxy für MCP-Device-Aufrufe fungieren, sodass Entwickler über ein einziges SDK und einen Endpunkt eine Verbindung zu registrierten Servern herstellen können, ohne direkt Device-spezifische Anmeldeinformationen verwalten zu müssen.

Durch die Integration der MCP-Unterstützung in das Gateway erhalten Unternehmen eine einheitliche Steuerungsebene für Modell- und Toolaufrufe. Agenten-Workflows beinhalten eine Schleife: Der Agent begründet, indem er ein LLM aufruft, handelt dann, indem er ein Device aufruft, und begründet dann noch einmal. Mit einem integrierten Ansatz kann der gesamte Prozess: die erste Eingabeaufforderung, der LLM-Aufruf, die Entscheidung des Modells, ein Device zu verwenden, der Device-Aufruf über dasselbe Gateway, die Antwort des Instruments und die endgültige Ausgabe in einem einzigen Hint erfasst werden. Diese einheitliche Ansicht vereinfacht die Durchsetzung, Fehlerbehebung und Compliance von Richtlinien.

Abschluss

AI Gateways und MCP bieten zusammen einen praktischen Weg zum sicheren Betrieb agentenbasierter KI im großen Maßstab. Sie helfen Groups dabei, fortschrittliche Modelle und Instruments als verwaltete Komponenten des breiteren Software program-Stacks zu behandeln – vorbehaltlich konsistenter Richtlinien-, Beobachtbarkeits- und Leistungsanforderungen. Mit einer zentralen Kontrollebene für Modelle und Instruments können Unternehmen KI auf zuverlässige, sichere und kostenbewusste Weise einführen.

Sie können mehr über das Thema erfahren Hier.

Häufig gestellte Fragen

A. Ein KI-Gateway ist eine Middleware-Schicht, die die Steuerung des gesamten KI-Verkehrs zentralisiert. Es vereinheitlicht den Zugriff auf mehrere LLMs, erzwingt die Governance, verwaltet die Kosten und gewährleistet die Zuverlässigkeit aller in Unternehmens-KI-Systemen verwendeten Modelle und Instruments.

A. Es erzwingt RBAC, lässt sich in SSO integrieren, verwaltet API-Schlüssel und wendet Richtlinien für die Datenfilterung und Audit-Protokollierung an. Dies unterstützt die Einhaltung von Requirements wie SOC 2, HIPAA und DSGVO.

A. MCP standardisiert die Artwork und Weise, wie KI-Agenten Instruments erkennen und mit ihnen interagieren, sodass keine benutzerdefinierten Integrationen erforderlich sind. Es ermöglicht modulare, skalierbare Verbindungen zwischen LLMs und Unternehmenssystemen wie Slack oder Jira.

Melden Sie sich an, um weiterzulesen und von Experten kuratierte Inhalte zu genießen.