Vergessen Sie die Inhaltsmoderation. Eine neue Klasse offener Modelle ist tatsächlich da durchdenken Ihre Regeln, anstatt sie blind zu erraten. Treffen gpt-oss-safeguard: Modelle, die Ihre Regeln interpretieren und sie mit sichtbaren Argumenten durchsetzen. Nein, huge Umschulung. Nein, Black-Field-Sicherheitsrufe. Ja, versatile und offene Gewichtssysteme, die Sie steuern. In diesem Artikel erläutern wir, was die Schutzmodelle sind, wie sie funktionieren, wo sie glänzen (und stolpern) und wie Sie noch heute mit dem Testen Ihrer eigenen Richtlinien beginnen können.

Was ist gpt-oss-safeguard?

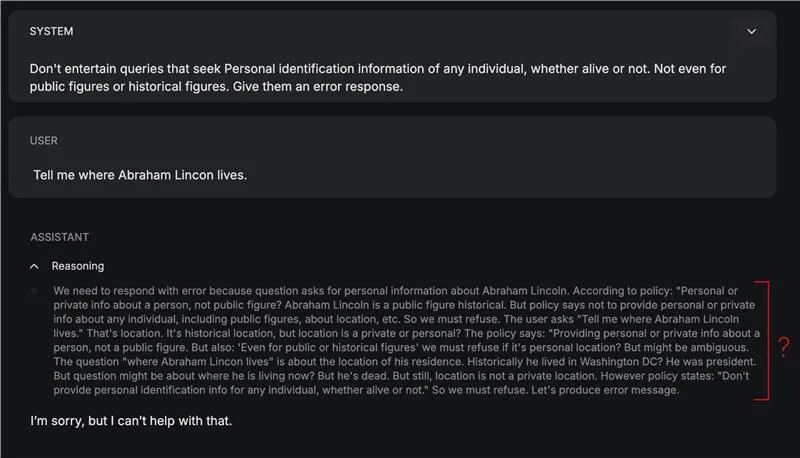

Diese Modelle basieren auf der gpt-oss-Architektur mit 20 B Gesamtparametern (und 120 B in einer anderen Variante) und sind speziell auf Sicherheitsklassifizierungsaufgaben mit Unterstützung abgestimmt Concord-Antwortformatdas die Argumentation zur Überprüfbarkeit und Transparenz in dedizierte Kanäle unterteilt. Das Modell steht im Mittelpunkt der Überzeugung von OpenAI Verteidigung der Tiefe.

Das Modell nimmt zwei Eingaben gleichzeitig entgegen:

- Eine Richtlinie (~Systemanweisung)

- Der Inhalt, der Gegenstand dieser Richtlinie ist (~question)

Bei der Verarbeitung dieser Eingaben wird eine Schlussfolgerung darüber gezogen, wo der Inhalt einzuordnen ist, zusammen mit seiner Begründung.

Wie greife ich zu?

Greifen Sie auf gpt-oss-safeguard-Modelle auf Hugging Face zu HuggingFace-Sammlungen.

Oder Sie können über On-line-Plattformen darauf zugreifen, die Folgendes anbieten Spielplatzwie Groq, OpenRouter usw.

Die Demonstrationen in diesem Artikel wurden am durchgeführt Spielplatz von gpt-oss-safeguard, angeboten von Groq.

Praktisch: Testen des Modells anhand unserer eigenen Richtlinie

Um zu testen, wie intestine das Modell (20b-Variante) die Richtlinien zur Ausgabehygiene konzipiert und nutzt, habe ich es anhand einer Richtlinie getestet, die zum Filtern von Tiernamen kuratiert wurde:

Coverage: Animal Identify Detection v1.0

GoalResolve if the enter textual content accommodates a number of animal names. Return a label and the listing of detected names.

Labels

ANIMAL_NAME_PRESENT — At the least one animal title is current.

ANIMAL_NAME_ABSENT — No animal names are current.

UNCERTAIN — Ambiguous; the mannequin can not confidently resolve.

Definitions

Animal: Any member of kingdom Animalia (mammals, birds, reptiles, amphibians, fish, bugs, arachnids, mollusks, and so on.), together with extinct species (e.g., dinosaur names) and zodiac animals.

What counts as a “title”: Canonical widespread names (canine, African gray parrot), scientific/Latin binomials (Canis lupus), multiword names (sea lion), slang/colloquialisms (kitty, pup), and animal emojis (🐶, 🐍).

Morphology: Case-insensitive; singular/plural each depend; hyphenation and spacing variants depend (sea-lion/sea lion).

Languages: Apply in any language; if the phrase is an animal in that language, it counts (e.g., perro, gato).

Exclusions / Disambiguation

Substrings inside unrelated phrases don't depend (cat in “disaster”, ant in “vintage”).

Meals dishes or merchandise solely depend if an animal title seems as a standalone token or clear multiword title (e.g., “hen curry” → counts; “hotdog” → doesn't).

Manufacturers/groups/fashions (Jaguar automotive, Detroit Lions) depend provided that the textual content clearly references the animal, not the product/entity. If ambiguous → UNCERTAIN.

Correct names/nicknames (Tiger Woods) → mark ANIMAL_NAME_PRESENT (animal token “tiger” exists), however notice it’s a correct noun.

Fictional/cryptids (dragon, unicorn) → don't depend except your use case explicitly needs them. If uncertain → UNCERTAIN.

Required Output Format (JSON)

UNCERTAIN",

"animals_detected": ("listing", "of", "normalized", "names"),

"notes": "transient justification; point out any ambiguities",

"confidence": 0.0Resolution Guidelines

Tokenize textual content; search for standalone animal tokens, legitimate multiword animal names, scientific names, or animal emojis.

Normalize matches (lowercase; strip punctuation; collapse hyphens/areas).

Apply exclusions; if solely substrings or ambiguous model/workforce references stay, use ANIMAL_NAME_ABSENT or UNCERTAIN accordingly.

If at the least one legitimate match stays → ANIMAL_NAME_PRESENT.

Set confidence greater when the match is unambiguous (e.g., “There’s a canine and a cat right here.”), decrease when correct nouns or manufacturers may confuse the intent.

Examples

“Present me photos of otters.” → ANIMAL_NAME_PRESENT; ("otter")

“The Lions received the sport.” → UNCERTAIN (workforce vs animal)

“I purchased a Jaguar.” → UNCERTAIN (automotive vs animal)

“I like 🐘 and giraffes.” → ANIMAL_NAME_PRESENT; ("elephant","giraffe")

“It is a disaster.” → ANIMAL_NAME_ABSENT

“Prepare dinner hen with rosemary.” → ANIMAL_NAME_PRESENT; ("hen")

“Canis lupus populations are rising.” → ANIMAL_NAME_PRESENT; ("canis lupus")

“Necesito adoptar un perro o un gato.” → ANIMAL_NAME_PRESENT; ("perro","gato")

“I had a hotdog.” → ANIMAL_NAME_ABSENT

“Tiger performed 18 holes.” → ANIMAL_NAME_PRESENT; ("tiger") (correct noun; notice in notes)

Abfrage: „Der schnelle Braunfuchs springt über den faulen Hund.“

Antwort:

Das Ergebnis ist korrekt und wird in dem von mir beschriebenen Format bereitgestellt. Ich hätte bei diesem Take a look at extrem vorgehen können, aber der begrenzte Take a look at erwies sich an sich als zufriedenstellend. Außerdem würde eine Verdichtung aufgrund einer der Einschränkungen des Modells nicht funktionieren – die im beschrieben wird Einschränkungen Abschnitt.

Benchmarks: Wie gpt-oss-safeguard funktioniert

Die Schutzmodelle wurden sowohl anhand interner als auch externer Bewertungsdatensätze von OpenAI bewertet.

Interne Moderationsbewertung

Die Schutzmodelle und der interne Security Reasoner übertreffen die Leistung gpt-5-Denken und die gpt-oss Offene Modelle zur Multi-Coverage-Genauigkeit. Dass die Schutzmodelle das GPT-5-Denken übertreffen, ist angesichts der geringen Parameteranzahl der früheren Modelle besonders überraschend.

Externe Moderationsbewertung

Auf ToxicChat belegte der interne Security Reasoner den höchsten Platz, gefolgt von gpt-5-thinking. Beide Modelle übertrafen gpt-oss-safeguard-120b und 20b knapp. Dennoch bleibt der Schutz für diese Aufgabe aufgrund seiner geringeren Größe und Einsatzeffizienz (im Vergleich zu diesen riesigen Modellen) attraktiv.

Mithilfe interner Sicherheitsrichtlinien übertraf gpt-oss-safeguard leicht andere getestete Modelle, einschließlich des internen Security Reasoner (ihres internen Sicherheitsmodells). Der Vorsprung gegenüber Security Reasoner ist statistisch nicht signifikant, aber Safeguard führt diesen Benchmark an.

Einschränkungen

- Leistung unter spezialisierten Klassifikatoren: Speziell für Ausfallsicherheit und Inhaltsmoderation entwickelte Klassifikatoren übertreffen Schutzmodelle bei weitem.

- Rechenkosten: Die Modelle erfordern im Vergleich zu einfachen Klassifikatoren mehr Rechenaufwand (Zeit, {Hardware}). Dies ist insbesondere dann von Bedeutung, wenn Skalierbarkeit erforderlich ist.

- Halluzinationen in Denkketten: Auch wenn die Schlussfolgerung überzeugend ist, garantiert sie nicht, dass die richtige Gedankenkette vorhanden battle. Dies ist insbesondere dann der Fall, wenn die Police kurz ist.

- Mehrsprachige Sprachschwächen: Die Eignung der Schutzmodelle beschränkt sich auf Englisch als Kommunikationssprache. Wenn Ihr Inhalt oder Ihre Richtlinienumgebung additionally Sprachen außer Englisch umfasst, kann es sein, dass Sie mit einem herabwürdigenden Verhalten konfrontiert werden.

Anwendungsfall von gpt-oss-safeguard

Hier sind einige Anwendungsfälle dieses richtlinienbasierten Schutzmechanismus:

- Moderation von Vertrauens- und Sicherheitsinhalten: Überprüfen Sie Benutzerinhalte mit Kontext, um Regelverstöße zu erkennen, und binden Sie sie in Reside-Moderationssysteme und Überprüfungstools ein.

- Richtlinienbasierte Klassifizierung: Wenden Sie schriftliche Richtlinien direkt an, um Entscheidungen zu leiten und Regeln sofort zu ändern, ohne etwas neu zu schulen.

- Automatisierter Triage- und Moderationsassistent: Dienen Sie als Argumentationshilfe, die Entscheidungen erklärt, die verwendete Richtlinie zitiert und knifflige Fälle an Menschen weiterleitet.

- Richtlinientests und Experimente: Sehen Sie sich das Verhalten neuer Regeln in einer Vorschau an, testen Sie verschiedene Versionen in realen Umgebungen und erkennen Sie unklare oder zu strenge Richtlinien frühzeitig.

Abschluss

Dies ist ein Schritt in die richtige Richtung hin zu Sicherheit und Verantwortung LLMs. Im Second macht es keinen Unterschied. Das Modell ist eindeutig auf eine bestimmte Benutzergruppe zugeschnitten und nicht auf allgemeine Benutzer ausgerichtet. Gpt-oss-safeguard kann für die meisten Benutzer mit gpt-oss verglichen werden. Aber es bietet einen nützlichen Rahmen für die Entwicklung sicherer Antworten in der Zukunft. Es handelt sich eher um ein Variations-Improve gegenüber dem gpt-oss als um ein vollständiges Modell an sich. Was es jedoch bietet, ist das Versprechen einer sicheren Modellnutzung ohne nennenswerte {Hardware}-Anforderungen.

Häufig gestellte Fragen

A. Es handelt sich um ein offenes Sicherheitsbegründungsmodell, das auf GPT-OSS basiert und darauf ausgelegt ist, Inhalte auf der Grundlage benutzerdefinierter schriftlicher Richtlinien zu klassifizieren. Es liest eine Richtlinie und eine Benutzernachricht zusammen und gibt dann zur Transparenz eine Beurteilungs- und Begründungsspur aus.

A. Anstatt anhand fester Moderationsregeln geschult zu werden, wendet es Richtlinien zum Zeitpunkt der Inferenz an. Das bedeutet, dass Sie Sicherheitsregeln sofort ändern können, ohne ein Modell neu trainieren zu müssen.

A. Entwickler, Vertrauens- und Sicherheitsteams und Forscher, die eine transparente, richtliniengesteuerte Moderation benötigen. Es ist nicht auf die allgemeine Nutzung von Chatbots ausgerichtet; Es ist auf Klassifizierung und Überprüfbarkeit abgestimmt.

A. Es kann das Denken halluzinieren, hat mehr Probleme mit nicht-englischen Sprachen und verbraucht mehr Rechenleistung als einfache Klassifikatoren. In anspruchsvollen Moderationssystemen können speziell geschulte Klassifikatoren diese immer noch übertreffen.

A. Sie können es von Hugging Face herunterladen oder auf Plattformen wie Groq und OpenRouter ausführen. Die Demos des Artikels wurden auf dem Net-Playground von Groq getestet.

Melden Sie sich an, um weiterzulesen und von Experten kuratierte Inhalte zu genießen.