In Eine unserer jüngsten Diskussionen Von Chatbots machte Bob Carpenter eine interessante Auszeichnung.

Der Ökonom Gary Smith hatte geschrieben: „Wenn Sie die Antwort kennen, müssen Sie kein LLM (großes Sprachmodell) fragen. Wenn Sie die Antwort nicht kennen, können Sie keinem vertrauen.“

Bob antwortete:

Das ist falsch. Es verstößt die Asymmetrie falsch zwischen der Erzeugung einer korrekten Antwort und der Überprüfung einer korrekten Antwort. Ich benutze ständig LLMs, um zu generieren. . . ständig codieren. In gewisser Weise kenne ich diese Werkzeuge, aber ich kann mich nie an die genaue Beschwörung erinnern. . . Wenn ich dem Chatbot sage, was ich will, und es generiert Pandas und Ploting -Code, kann ich überprüfen, ob es korrekt ist.

Die Asymmetrie zwischen Überprüfung und Erzeugung ist der Schlüssel zum Verständnis des Unterschieds zwischen Polynomzeit (P) und nicht deterministischer Polynomzeitalgorithmen (NP). Ein NP -Algorithmus kann als Erraten mit einem P -Algorithmus formuliert werden und mit einem P -Algorithmus überprüft werden. Wenn das LLM ein viel besserer Raten als ich ist, spart ich eine große Menge an Suche.

Ich denke, dass viele der Probleme, die wir mit Chatbots sehen (wie der berüchtigte Bericht mit gefälschten Referenzen, die von der US -Gesundheits- und menschlichen Dienste erstellt wurden), von Menschen stammten, die den Chatbot generieren, aber nicht Menschen verwenden, um dies zu überprüfen.

Dies ist auch mit einer Kernidee in der Bayesian -Datenanalyse und der statistischen Workflow im Allgemeinen verbunden, dass das Anpassung und Überprüfen von Modellen zwei verschiedene Dinge sind. Wir diskutieren diese Idee auch in Abschnitt 6.2.1 von diesem Artikelwas zurück auf Ein Weblog -Beitrag von 2011 über die wesentliche „Zweiheit“ der Statistik.

In der Tat denke ich, dass verschiedene versuchte Totalisierungsphilosophien von Statistiken fehlerhaft sind, indem versucht wird, die Schritte der Erzeugung und Überprüfung zu verschmelzen. Zwei solcher Totalisierungsphilosophien, die ich nicht magazine, sind die Idee, Unsicherheitserklärungen („Vertrauensregionen“) durch Inverting von Hypothesentests zu konstruieren (siehe Diskussion aus ein anderer Beitrag 2011) und der Versuch, Bayes -Faktoren zu verwenden, um die Unsicherheit über Modelle hinweg zusammenzufassen (siehe Kapitel 7 von BDA3Zum Beispiel).

Aber kehren wir zu Chatbots zurück.

Gary Smith ist ein häufiger Kritiker des LLM -Hype – wir haben in den letzten Jahren mehrmals mit seinen Beiträgen verbunden – und ich denke, seine Kritik ist sinnvoll, aber ich versuche immer, sie mit Bob Carpenters Erfahrung in Einklang zu bringen, die LLMs für viele Menschen bei der Arbeit, einschließlich Bob, sehr nützlich waren.

Meine Lösung ist, dass Chatbots intestine erzeugen und schlecht überprüft werden können.

Dies steht auch im Einklang mit dem, was Smith immer wieder sagt, was das eigentliche Downside mit Chatbots und KI ist, nicht ihre Ausgabe, von denen einige nützlich sind und von denen einige nicht sind, sondern eher die Tendenz, dass viele Menschen annehmen müssen, dass die Chatbot -Ausgabe korrekt ist, oder dass der Chatbot die Artwork und Weise durch die Artwork und Weise, wie eine menschliche Macht ist, „nachdenkt“.

Ich magazine weiterhin die Analogie von Chatbot als Bullshitter. Die Chatbot-Ausgabe ist so etwas wie das, was von einem intestine ausgebildeten Schüler produziert werden könnte, dem eine Frage gestellt wird und dann ohne Reflexion zu antworten beginnt. Oder die Artwork von Vamping, die ich bei einem Assembly durchführen könnte, wenn ich nicht aufpasse und jemand mich plötzlich fragt, was ich denke. Ich könnte in einer solchen Umgebung etwas Nützliches ausspucken – eigentlich mache ich es die ganze Zeit! -, aber das liegt daran, dass ich einen guten Laden allgemeiner Weisheit habe. Meine unüberlegten Antworten sind so etwas wie das, was Sie erhalten würden, indem Sie nach allem, was ich geschrieben habe, durchführen würden – alle meine Bücher, Artikel und Weblog -Beiträge. Es wird niemals eine kreative Lösung für ein neues Downside sein – das würde tatsächlich darüber nachdenken! -, aber ja, es kann immer noch nützlich sein. Ihr Fehler wäre, diese gedankenlose Antwort von mir als mehr als es zu nehmen.

Hier ist ein weiteres Beispiel von Smith, ein Beitrag mit dem Titel “ GPT 5.0 versteht es nicht, ist aber bestrebt zu gefallen:

Die wirkliche Gefahr ist heute nicht, dass Laptop schlauer sind als wir, sondern dass wir glauben, dass sie schlauer sind als wir und ihnen vertrauen, dass sie Entscheidungen treffen, denen sie nicht vertrauen sollten.

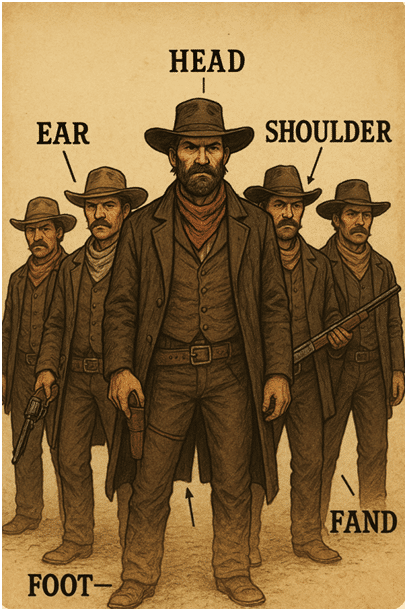

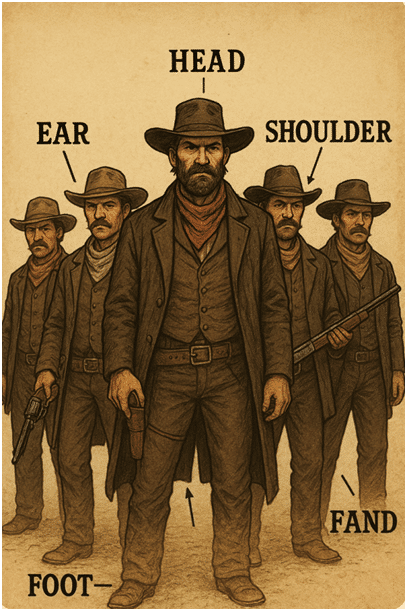

Smith teilt ein amüsantes Beispiel für ein unheimliches Valley-Bild, das vom Chatbot generiert wurde. Als Antwort auf seine Frage „Bitte zeichnen Sie ein Bild einer Posse mit 5 beschrifteten Körperteilen“ (er hatte beabsichtigt, „Opossum“ einzugeben, aber einige Tippfehler führten zu „Posse“):

Smith weist auf einige offensichtliche Probleme mit dem Bild hin und durchläuft einen Dialog mit dem Chatbot, in dem es quick alles angenehm aussagt:

LLMs wissen nicht, was Wörter bedeuten oder wie sie sich auf die reale Welt beziehen. Sie haben folglich keine Möglichkeit zu erkennen, ob der Inhalt, den sie eingeben und ausgeben, wahr oder falsch ist.

Ich denke, Bob würde antworten, dass zukünftige Versionen des Chatbots mehr Verbindungen zur realen Welt haben könnten, einige visuelle/audio-/taktile Eingaben, genau wie wir als Menschen bekommen. Und das könnte so sein, aber im Second vermute ich, dass der erste Schritt der Chatbot -Programmierer darin besteht, herauszufinden, wie die offensichtlichen Probleme wie Rechtschreibfehler behoben werden können, was den resultierenden Textual content und die Bilder unmittelbarer nützlicher macht, aber auch irreführender im Sinne, nicht die Informationen zu enthalten, die ihre Grenzen deutlich anzeigen.

Um zu Bobs Thema „der Asymmetrie zwischen der korrekten Antwort und der Überprüfung einer korrekten Antwort“ zurückzukehren: Wenn Ihr Ziel darin besteht, ein Bild einer hypothetischen Posse zu erstellen, macht der Chatbot ziemlich intestine, dass Google eigentlich noch besser ist, aber der Chatbot gewinnt, wenn Sie ein Mashup wie „eine Posse von Superhelden in Robin -Hauben kosteten, wie einboot, oder so etwas wie ein Boot. Sie können dann Ihre menschlichen Überprüfungsfähigkeiten nutzen, um Probleme mit dem Bild zu erkennen und dann in Photoshop oder was auch immer zu gehen und es zu beheben. Oder lassen Sie sich den Chatbot helfen, ihn in Photoshop zu reparieren. Ich denke, das Ziel ist es, dass die Überprüfung auch vom Laptop durchgeführt wird, aber wir sind noch nicht da.

Im Second sehe ich Gary Smiths Besorgnis, dass Menschen, die Chatbot -Ausgabe vertrauen, als im Einklang mit der Abteilung von Bob Carpenter über die beiden Aufgaben der Erzeugung und Überprüfung übereinstimmen.