Cerebras -Systeme Heute kündigte an, was es sagte, ist rekordverdächtige Leistung Für Deepseek-R1-Distill-Llama-70B-Inferenz und mehr als 1.500 Token professional Sekunde-57-mal schneller als GPU-basierte Lösungen.

Laut Cerebras ermöglicht diese Geschwindigkeit sofortige Argumentationsfunktionen für eines der hoch entwickelten Open-Gewicht-Modelle der Branche, die ausschließlich auf der US-amerikanischen AI-Infrastruktur ohne Datenbindung gelten.

„Deepseek R1 stellt eine neue Grenze für KI -Argumentationsfähigkeiten dar, und heute machen wir sie bei den schnellsten Geschwindigkeiten der Branche zugänglich“, sagte Hagay Lupesko, SVP von AI Cloud, Cerebras. „Durch die Erreichung von mehr als 1.500 Token professional Sekunde auf unserer Cerebras-Inferenzplattform verwandeln wir die Minuten lang langen Argumentationsprozessen in nahezu instantane Antworten und verändern grundlegend die Artwork und Weise, wie Entwickler und Unternehmen fortschrittliche KI-Modelle nutzen können.“

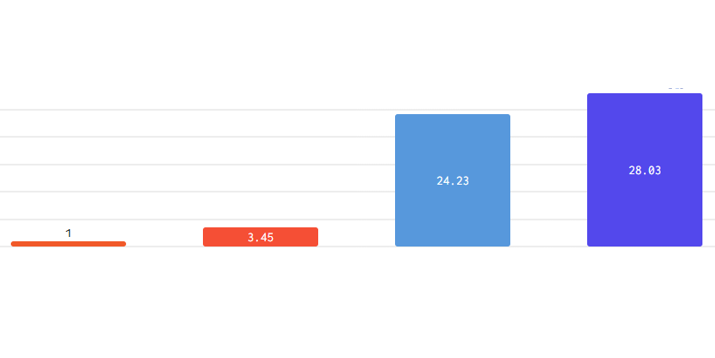

Angetrieben von der Cerebras Wafer Scale Engine, zeigt die Plattform, wie die Plattform zeigt Efficiency-Verbesserungen in der Praxis. Eine Normal -Codierungsaufforderung, die 22 Sekunden auf Wettbewerbsplattformen in nur 1,5 Sekunden auf Cerebras dauert – eine 15 -fache Verbesserung der Zeit, um zu Ergebnissen zu führen. Dieser Durchbruch ermöglicht die praktische Bereitstellung hoch entwickelter Argumentationsmodelle, die traditionell umfangreiche Berechnungszeit erfordern.

Deepseek-R1-Distill-Llama-70b kombiniert die fortschrittlichen Argumentationsfunktionen der 671B-Parametermischung von Experten (MOE) von Deepseek mit der weit verbreiteten Lama-Architektur von Meta. Trotz seiner effizienten Parametergröße von 70B zeigt das Modell eine überlegene Leistung bei komplexen Mathematik- und Codierungsaufgaben im Vergleich zu größeren Modellen.

„Sicherheit und Privatsphäre sind für die Bereitstellung von Enterprise AI von größter Bedeutung“, fuhr Lupesko fort. „Durch die Verarbeitung aller Inferenzanforderungen in US-amerikanischen Rechenzentren ohne Datenbindung können wir sicherstellen, dass Organisationen die modernsten KI-Funktionen nutzen können und gleichzeitig strenge Requirements für die Datenregierung beibehalten können. Daten bleiben zu 100% der Zeit in den USA und gehören ausschließlich dem Kunden. “

„Sicherheit und Privatsphäre sind für die Bereitstellung von Enterprise AI von größter Bedeutung“, fuhr Lupesko fort. „Durch die Verarbeitung aller Inferenzanforderungen in US-amerikanischen Rechenzentren ohne Datenbindung können wir sicherstellen, dass Organisationen die modernsten KI-Funktionen nutzen können und gleichzeitig strenge Requirements für die Datenregierung beibehalten können. Daten bleiben zu 100% der Zeit in den USA und gehören ausschließlich dem Kunden. “

Das Deepseek-R1-Distill-Llama-70b-Modell ist sofort durch verfügbar Cerebras Inferenz, mit API -Zugriff, der Kunden über ein Entwicklervorschau -Programm ausgewählt hat. Weitere Informationen zum Zugriff auf sofortige Argumentationsfunktionen für Anwendungen finden Sie unter Besichtigung www.cerebras.ai/contact-us.