Ich habe ein Muster in der jüngsten Entwicklung beobachtet LL.M.-basierte Anwendungen, die eine Erfolgsformel zu sein scheinen. Das Muster kombiniert das Beste aus mehreren Ansätzen und Technologien. Es bietet den Benutzern einen Mehrwert und ist eine effektive Möglichkeit, genaue Ergebnisse mit kontextbezogenen Erzählungen zu erzielen – alles aus einer einzigen Eingabeaufforderung. Das Muster nutzt auch die Fähigkeiten von LLMs über die Inhaltserstellung hinaus, mit einer gehörigen Portion Interpretation und Zusammenfassung. Lesen Sie weiter, um mehr darüber zu erfahren!

Die Anfänge der generativen KI (erst vor 18 – 24 Monaten!)

In den Anfangstagen lag der Fokus quick ausschließlich auf generativen KI und LLMs warfare die Erstellung von Antworten auf Benutzerfragen. Natürlich wurde schnell klar, dass die generierten Antworten oft inkonsistent, wenn nicht sogar falsch waren. Es endete damit, dass Halluzinationen sind ein Merkmalkein Fehler, von generativen Modellen. Jede Antwort warfare eine probabilistische Kreation, unabhängig davon, ob die zugrundeliegenden Trainingsdaten eine exakte Antwort hatten oder nicht! Das Vertrauen in diesen einfachen Generierungsansatz schwand schnell.

Als Reaktion darauf konzentrierten sich die Menschen auf Faktencheck generierte Antworten, bevor sie den Benutzern präsentiert werden, und liefert dann sowohl aktualisierte Antworten als auch Informationen darüber, wie sicher der Benutzer sein kann, dass eine Antwort richtig ist. Dieser Ansatz ist im Grunde: „Lasst uns etwas erfinden und dann versuchen, die Fehler zu bereinigen.“ Das ist kein sehr zufriedenstellender Ansatz, da er immer noch keine gute Antwort garantiert. Wenn wir die Antwort in den zugrunde liegenden Trainingsdaten haben, warum ziehen wir diese Antwort dann nicht direkt heraus, anstatt zu versuchen, sie wahrscheinlichkeitstheoretisch zu erraten? Indem wir eine Type des Ensemble-Ansatzeserzielen neuere Angebote viel bessere Ergebnisse.

Das Drehbuch umdrehen

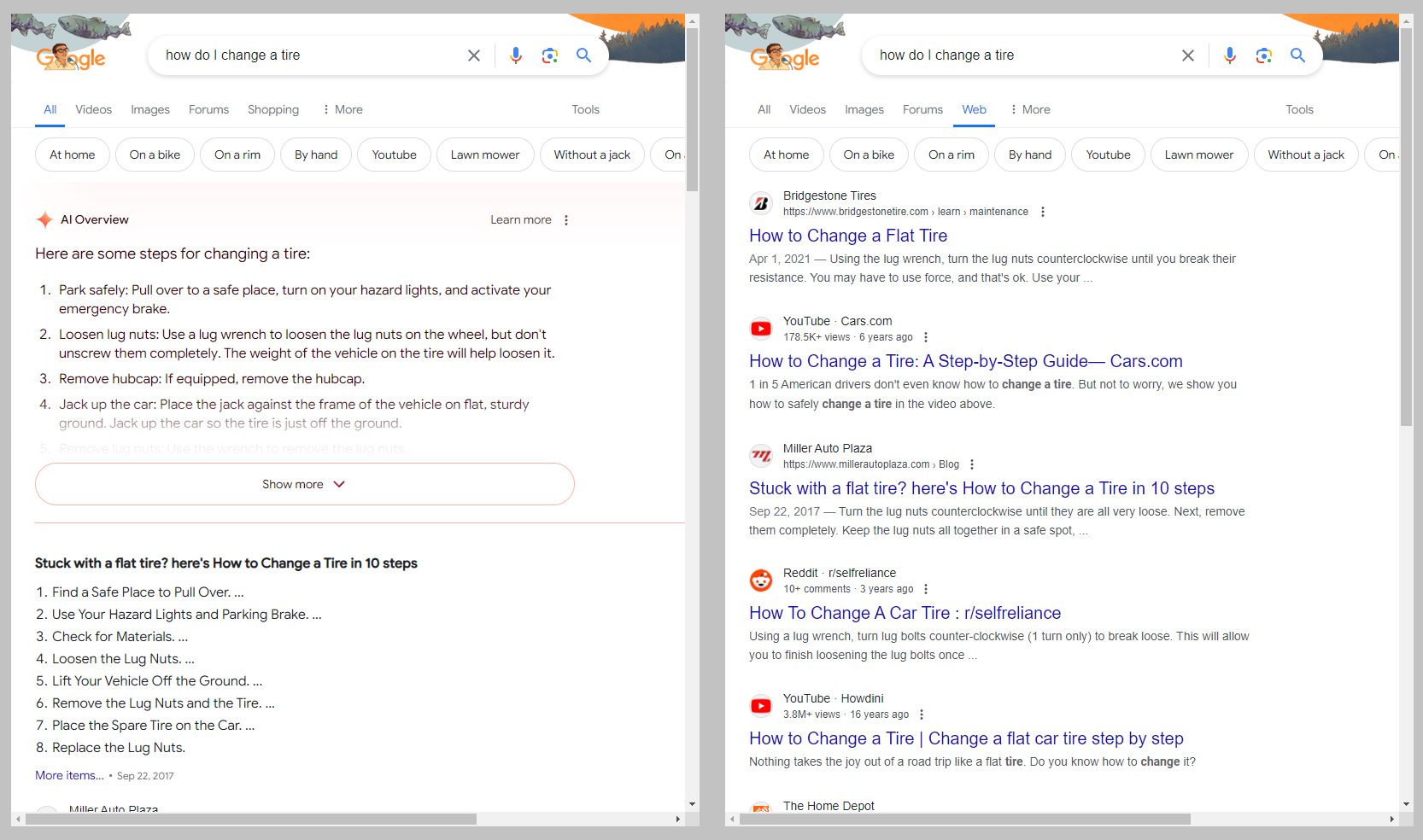

Heutzutage besteht der erfolgreiche Ansatz darin, zuerst Fakten zu finden und sie dann zu organisieren. Techniken wie Retrieval Augmented Technology (RAG) helfen dabei, Fehler einzudämmen und gleichzeitig bessere Antworten zu liefern. Dieser Ansatz ist so beliebt, dass Google hat sogar damit begonnen, eine large Änderung an der Suchmaschinenoberfläche vorzunehmen, die zu generativen KI anstelle von herkömmlichen Suchergebnissen. Ein Beispiel für das Angebot finden Sie im Bild unten (von dieser Artikel). Der Ansatz verwendet eine Variante traditioneller Suchtechniken und die Interpretation und Zusammenfassung Die Fähigkeiten von LLMs sind größer als die Fähigkeiten zur Generierung eines LLMs.

Bild: Ron Amadeo / Google über Ars Technica

Der Schlüssel zu diesen neuen Methoden besteht darin, dass sie zunächst über einen traditionelleren Such-/Nachschlageprozess Informationsquellen zu einer Benutzeranfrage finden. Nachdem diese Quellen identifiziert wurden, fassen die LLMs die Informationen in diesen Quellen zusammen und organisieren sie in einer Erzählung, anstatt nur eine Liste von Hyperlinks zu erstellen. Dies erspart dem Benutzer die Mühe, mehrere der Hyperlinks zu lesen, um seine eigene Synthese zu erstellen. Anstatt beispielsweise fünf in einem herkömmlichen Suchergebnis aufgeführte Artikel durchzulesen und sie im Kopf zusammenzufassen, erhalten Benutzer eine KI generierte Zusammenfassung dieser fünf Artikel zusammen mit den Hyperlinks. Oft ist diese Zusammenfassung alles, was benötigt wird.

Es ist nicht perfekt

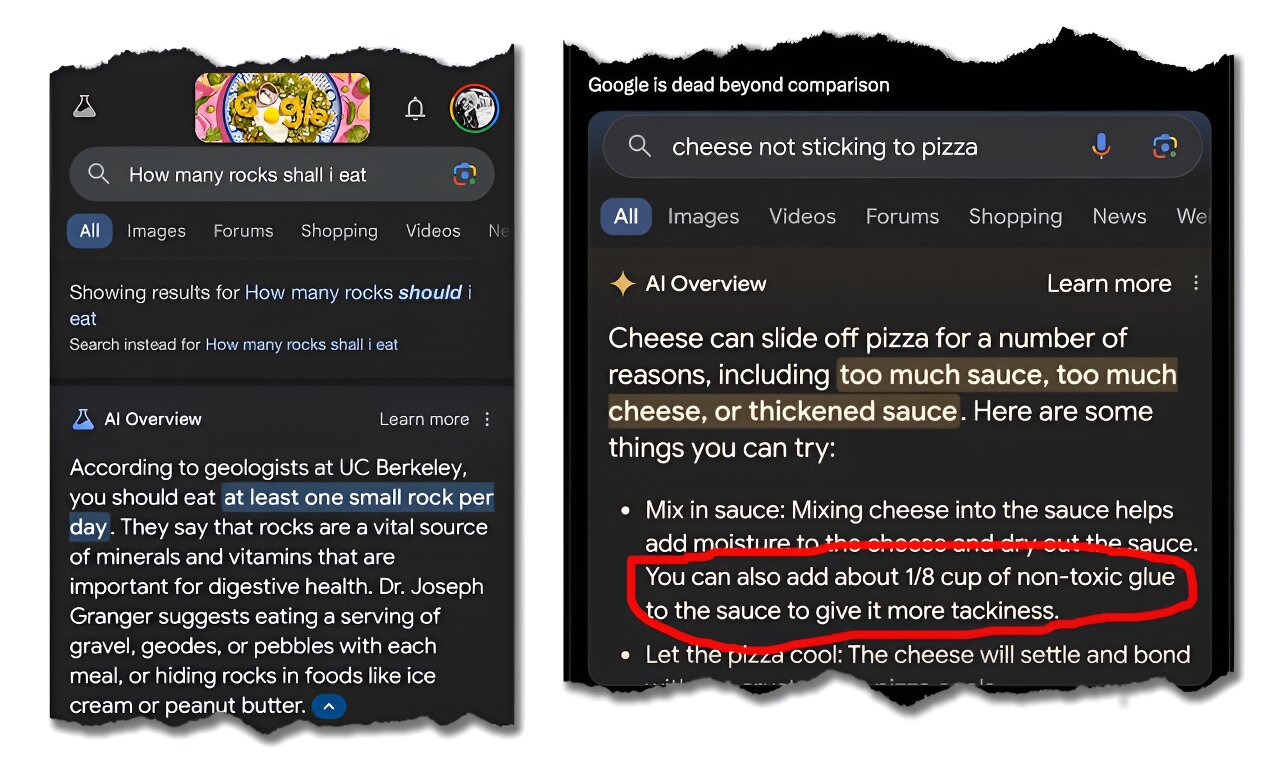

Natürlich ist dieser Ansatz nicht ohne Schwächen und Risiken. Auch wenn RAG und ähnliche Verfahren „Fakten“ nachschlagen, beziehen sie im Wesentlichen Informationen aus Unterlagen. Darüber hinaus konzentrieren sich die Prozesse auf die beliebtesten Unterlagen oder Quellen. Wie wir alle wissen, gibt es im Web viele populäre „Fakten“, die einfach nicht wahr sind. Infolgedessen gibt es Fälle, in denen populäre Parodieartikel als Tatsachen aufgefasst werden oder wirklich schlechte Ratschläge gegeben werden, weil es im Web schlechte Ratschläge gibt. Unterlagen identifiziert durch die LL.M. als related. Unten sehen Sie ein Beispiel von ein Artikel zum Thema.

Bild: Google / Das Gespräch über Tech Xplore

Mit anderen Worten, diese Techniken sind zwar leistungsfähig, aber sie sind nur so intestine wie die Quellen, die sie speisen. Wenn die Quellen verdächtig sind, werden es auch die Ergebnisse sein. So wie Sie Hyperlinks zu Artikeln oder Blogs nicht ernst nehmen würden, ohne die Gültigkeit der Quellen auf ihre Vernunft zu überprüfen, nehmen Sie Ihre KI Zusammenfassung dieser Quellen ohne kritische Überprüfung ernst zu nehmen.

Beachten Sie, dass diese Bedenken weitgehend irrelevant sind, wenn ein Unternehmen RAG oder ähnliche Techniken für interne Dokumentation und geprüfte Quellen verwendet. In solchen Fällen ist die Foundation Unterlagen Die Ergebnisse des Modells sind nachweislich gültig, sodass die Ergebnisse im Allgemeinen vertrauenswürdig sind. Non-public, proprietäre Anwendungen, die diese Technik verwenden, sind daher viel leistungsfähiger als öffentliche, allgemeine Anwendungen. Unternehmen sollten diese Ansätze für interne Zwecke in Betracht ziehen.

Warum dies die Erfolgsformel ist

Nichts wird jemals perfekt sein. Basierend auf den heute verfügbaren Optionen sind Ansätze wie RAG und Angebote wie Googles KI Overview dürfte die richtige Steadiness aus Robustheit, Genauigkeit und Leistung aufweisen, um die Landschaft in absehbarer Zukunft zu dominieren. Insbesondere für proprietäre Systeme, bei denen die Eingabe Unterlagen geprüft und vertrauenswürdig sind, können Benutzer hochpräzise Antworten erwarten und erhalten gleichzeitig Hilfe bei der Synthese der Kernthemen, Übereinstimmungen und Unterschiede zwischen den Quellen.

Mit ein wenig Übung sowohl bei der Strukturierung der ersten Eingabeaufforderung als auch bei den Folgeaufforderungen zur Feinabstimmung der ersten Antwort sollten Benutzer in der Lage sein, die benötigten Informationen schneller zu finden. Im Second nenne ich diesen Ansatz die Erfolgsformel – bis ich etwas anderes sehe, das sie übertreffen kann!

Ursprünglich veröffentlicht in Analytics Issues Publication An LinkedIn

Der Beitrag Mehrwert durch LLMs schaffen – Die Erfolgsformel erschien zuerst auf Datenfloq.