Es wird oft gesagt, dass Supercomputer von vor ein paar Jahrzehnten weniger Leistung hatten als heutige Smartwatches. Jetzt haben wir ein Unternehmen, Tiiny AI Inc., das behauptet, den weltweit kleinsten persönlichen KI-Supercomputer gebaut zu haben, der ein großes Sprachmodell mit 120 Milliarden Parametern auf dem Gerät ausführen kann – ohne Cloud-Konnektivität, Server oder GPUs.

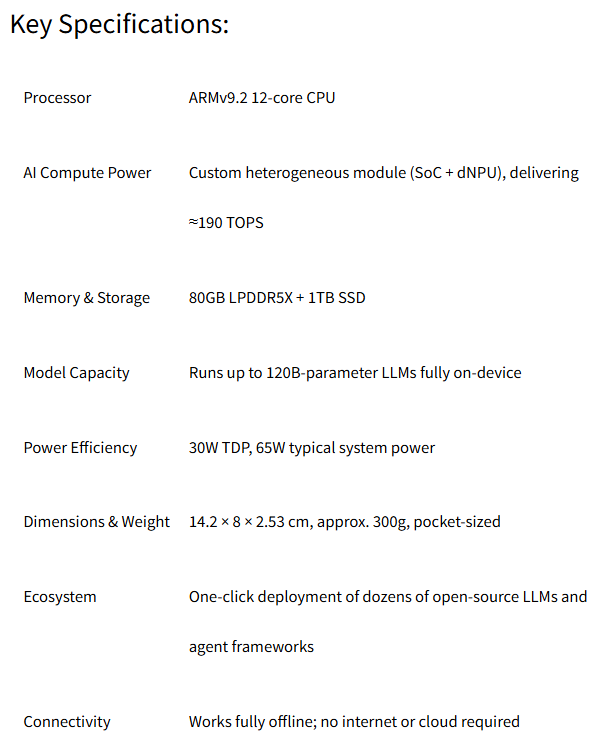

Das Unternehmen sagte, dass das Arm-basierte Produkt auf zwei technologischen Fortschritten basiert, die LLMs mit großen Parametern auf einem kompakten Gerät realisierbar machen.

- TurboSparse, eine spärliche Aktivierungstechnik auf Neuronenebene, verbessert die Inferenzeffizienz und behält gleichzeitig die vollständige Modellintelligenz bei.

- PowerInfer, eine heterogene Open-Supply-Inferenz-Engine mit mehr als 8.000 GitHub-Sternen, beschleunigt schwere LLM-Arbeitslasten durch die dynamische Verteilung der Berechnungen auf CPU und NPU und ermöglicht so eine erstklassige Leistung bei einem Bruchteil des herkömmlichen Stromverbrauchs.

Tiiny AI Pocket Lab wurde für energieeffiziente persönliche Intelligenz entwickelt, läuft in einem Leistungsbereich von 65 W und ermöglicht die Leistung großer Modelle zu einem Bruchteil des Energie- und CO2-Fußabdrucks herkömmlicher GPU-basierter Systeme, sagte Tiiny.

Das Unternehmen sagte, der Engpass im heutigen KI-Ökosystem sei nicht die Rechenleistung, sondern die Abhängigkeit von der Cloud.

„Cloud AI hat bemerkenswerte Fortschritte gebracht, aber auch Abhängigkeiten, Verwundbarkeit und Nachhaltigkeitsherausforderungen geschaffen“, sagte Samar Bhoj, GTM-Direktorin von Kleine KI. „Mit Tiiny AI Pocket Lab glauben wir, dass Intelligenz nicht den Rechenzentren, sondern den Menschen gehören sollte. Dies ist der erste Schritt, um fortschrittliche KI wirklich zugänglich, privat und persönlich zu machen, indem die Leistung großer Modelle aus der Cloud auf jedes einzelne Gerät übertragen wird.“

„Das Gerät stellt einen großen Wandel in der Entwicklung der KI-Branche dar“, sagte das Unternehmen. „Da cloudbasierte KI zunehmend mit Nachhaltigkeitsbedenken, steigenden Energiekosten, weltweiten Ausfällen, den unerschwinglichen Kosten der Verarbeitung langer Kontexte und wachsenden Datenschutzrisiken zu kämpfen hat, führt Tiiny AI ein options Modell ein, das sich auf persönliche, tragbare und vollständig non-public Intelligenz konzentriert.“

Nach Angaben des Unternehmens wurde das Gerät von Guinness World Data in der Kategorie „Der kleinste MiniPC (100 Milliarden LLM lokal)“ verifiziert.

Das Unternehmen bezeichnet sich selbst als „in den USA ansässiges Deep-Tech-KI-Startup“, während die Ankündigung in Hongkong erfolgt. Das Unternehmen wurde 2024 gegründet und vereint Ingenieure von MIT, Stanford, HKUST, SJTU, Intel und Meta, KI-Inferenz und {Hardware}-Software program-Co-Design. Ihre Forschung wurde auf akademischen Konferenzen wie SOSP, OSDI, ASPLOS und EuroSys veröffentlicht. Nach Angaben des Unternehmens sicherte sich Tiiny AI im Jahr 2025 eine Seed-Runde in Höhe von mehreren Millionen Greenback von führenden globalen Investoren.

Tiiny AI Pocket Lab ist darauf ausgelegt, wichtige persönliche KI-Anwendungsfälle zu unterstützen und dient Entwicklern, Forschern, Schöpfern, Fachleuten und Studenten. Es ermöglicht mehrstufiges Denken, tiefes Kontextverständnis, Agenten-Workflows, Inhaltsgenerierung und sichere Verarbeitung sensibler Informationen – auch ohne Internetzugang. Das Gerät bietet außerdem ein echtes persönliches Langzeitgedächtnis, indem es Benutzerdaten, Präferenzen und Dokumente lokal mit Verschlüsselung auf Bankebene speichert und so ein Maß an Privatsphäre und Beständigkeit bietet, das cloudbasierte KI-Systeme nicht bieten können.

Das Tiiny AI Pocket Lab arbeitet im „goldenen Bereich“ der persönlichen KI (Parameter 10B–100B), die nach Angaben des Unternehmens mehr als 80 Prozent der realen Bedürfnisse befriedigt. Es unterstützt Modelle mit einer Skalierung von bis zu 120 Milliarden LLM und liefert Intelligenzniveaus, die mit GPT-4o vergleichbar sind. Dies ermöglicht Argumentation auf PhD-Niveau, mehrstufige Analysen und ein tiefes Kontextverständnis – aber mit der Sicherheit einer vollständigen Offline-Verarbeitung auf dem Gerät.

Das Unternehmen sagte, das Gerät unterstütze die Ein-Klick-Set up beliebter Open-Supply-Modelle, darunter OpenAI GPT-OSS, Llama, Qwen, DeepSeek, Mistral und Phi, und ermögliche die Bereitstellung von Open-Supply-KI-AgentenTs wie OpenManus, ComfyUI, Flowise, Presenton, Libra, Bella und SillyTavern. Benutzer erhalten kontinuierliche Updates, einschließlich offizieller OTA-{Hardware}-Upgrades. Die oben genannten Funktionen werden auf der CES im Januar 2026 veröffentlicht.