Ich habe neulich mit jemandem über eine umstrittene Behauptung in der Wissenschaft gesprochen, etwas, das anscheinend niemand, einschließlich der Forscher, die die ursprüngliche Behauptung veröffentlicht haben, jemals reproduziert hat. An diesem besonderen Beispiel waren weder Brian Wansink noch Dan Ariely beteiligt, noch battle das der Fall Glücksgolfball Studie, die von der Affiliation for Psychological Science gefördert wurde, lange nachdem sie entlarvt worden battle (nicht, dass eine Entlarvung nötig gewesen wäre, wenn man bedenkt, wie lächerlich die Studie überhaupt battle); Tatsächlich hatte es überhaupt nichts mit Psychologie zu tun, aber es hatte insofern einen ähnlichen Geschmack, als das Fehlen jeglichen Versuchs, es zu reproduzieren, bei meinem Korrespondenten ein Gefühl des Misstrauens auslöste: ob es nun Betrug ist oder sich die Wege verzweigen oder Clarkes Gesetz oder was auch immer, da hatte er das Gefühl, dass etwas Verdächtiges vor sich ging. Anders ausgedrückt: Ja, Ehrlichkeit und Transparenz sind es nicht genugund es ist für gute Leute möglich, schlechte Wissenschaft zu betreiben, wenn sie Regeln befolgen, die keinen Sinn ergeben, aber in diesem Fall schien es, dass es im System eine gewisse Unehrlichkeit und Intransparenz gab.

Hier ist meine Frage.

Aus demselben Grund, aus dem diese Probleme meinem Korrespondenten klar waren, sollten sie auch anderen klar sein. Wie bleibt das additionally über Wasser?

Ich weiß es nicht, aber hier ist eine Theorie. Es hilft, einen Kern von Betrug oder Bösgläubigkeit zu haben – einige Forscher im Inneren, die das Gefühl haben, die Antwort bereits zu kennen und bereit sind, alles zu tun, um diese Antwort aus den Daten herauszuholen. Aber dann brauchen Sie eine Gruppe um sich herum, die motiviert ist, den Ball in der Luft zu halten, und zwar aus einer Mischung aus Verwirrung, Wunschdenken, Fehlinterpretationsbeweisen und politischer oder wissenschaftlicher Ideologie.

Ich denke, dass meine Sichtweise sich geringfügig von unserem üblichen Modell wissenschaftlicher Fehler und wissenschaftlichen Fortschritts unterscheidet.

Nach dem üblichen Modell entwickeln Forscher Ideen und entwerfen Experimente, um sie zu testen, und Forscher sammeln Daten, aus denen sie neue Dinge lernen und so neue Theorien und neue Experimente anregen. Auch bei diesem üblichen Modell gibt es manchmal (oft!) Fehler: Schlechte Theorien werden getestet und manchmal scheinbar bestätigt, falsche Schlussfolgerungen werden aus Daten gezogen und schließlich werden schlechte Ideen verworfen oder modifiziert, um sie mit der Realität in Einklang zu bringen, wie sie durch Folgestudien, direkte und indirekte Replikationen, neue Theorien usw. dargestellt wird. Das ist die selbstkorrigierende Natur der Wissenschaft.

Eine Sache, die ich in der Vergangenheit betont habe, ist, dass sich „Wissenschaft“ nur deshalb selbst korrigiert, weil einzelne Wissenschaftler die Arbeit übernehmen, frühere Theorien und empirische Behauptungen zu überprüfen, Theorien zu überarbeiten und im Allgemeinen die Aufzeichnungen zu korrigieren. Es ähnelt der Artwork und Weise, wie die Kontrollen und Gegenkontrollen unserer Regierung auf tatsächlichen Regierungsbeamten beruhen, die die Kontrolle und den Ausgleich durchführen. Das System besteht aus Menschen; nichts ist automatisch.

Aber mein Standpunkt in diesem Beitrag ist etwas anders. Hier geht es mir nicht so sehr darum, wie Fehler untersucht und behoben werden, sondern vielmehr darum, wie sie sich verbreiten. Und was ich sagen möchte ist, dass ich denke, dass dies ziemlich absichtlich geschieht.

Ich meine das nicht unbedingt auf eine unheimliche Artwork und Weise, nämlich die Vorstellung, dass schlaue Forscher ihre Netzwerkfähigkeiten nutzen, um schlechte Arbeit in die Literatur einzubringen – auch wenn ich denke, dass dies ständig vorkommt –, sondern allgemeiner gesagt, dass es viel aktiver Anstrengung bedarf, um diese schlechten Ideen in verkörperter Kognition, Evolutionspsychologie, unterschwelligen Effekten usw. fortzuführen und in der wissenschaftlichen Literatur fortzuführen. Ebenso wie das Ungeheuer von Loch Ness, UFOs als Außerirdische im Weltraum und verschiedene politische Verschwörungstheorien eine ständige Aktualisierung erfordern, um in den Nachrichten zu bleiben. Ja, die Menschen haben alle möglichen dummen Überzeugungen – ein Drittel der Amerikaner gibt an, an Geister zu glauben! –, aber passiver Glaube reicht nicht aus. Intestine vernetzte Menschen müssen sie aktiv fördern, sonst geraten sie in den Hintergrund des kollektiven Bewusstseins.

Zusammenfassend denke ich, dass man, damit schlechte Wissenschaft bestehen und fortbestehen kann, (1) einen Kern ethisch oder methodisch beeinträchtigter Menschen braucht, die bereit sind, Daten zu fabrizieren oder irreführende Beweise zu liefern, und (2) eine größere Gruppe von Menschen, die, aus welchen Gründen auch immer, bereit sind, ihre natürliche Skepsis aufzugeben, um diese Ideen zu fördern.

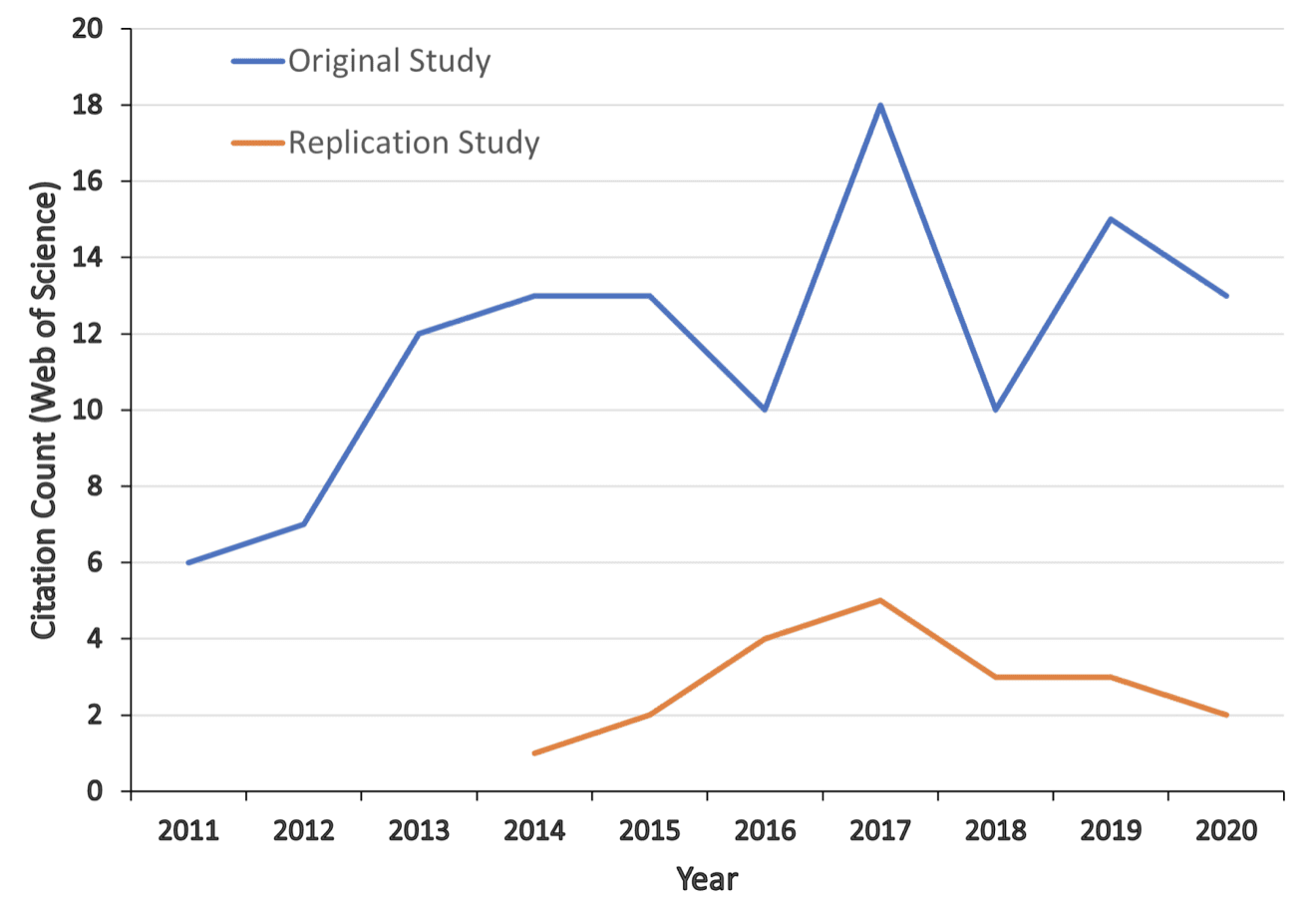

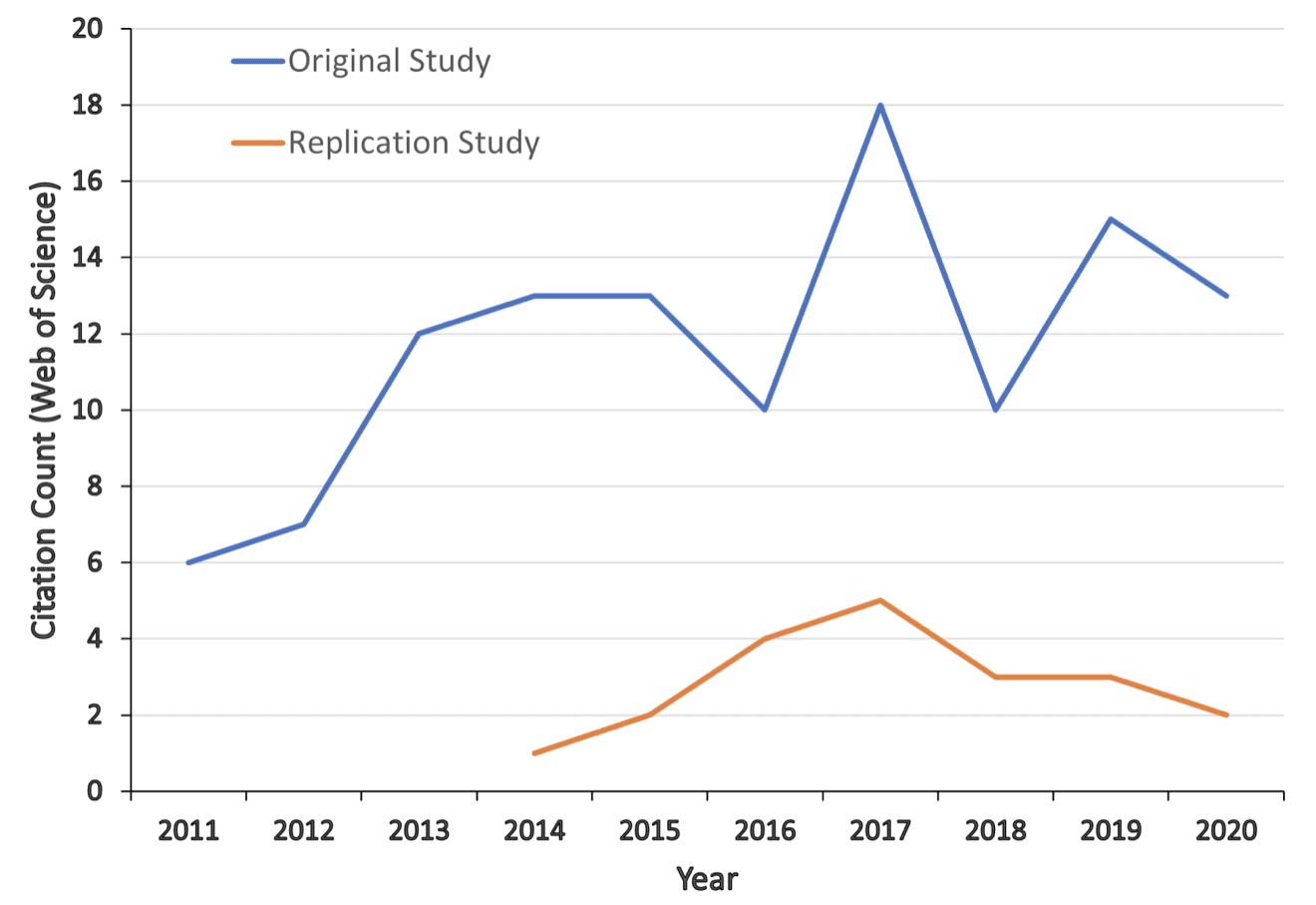

Dies gibt auch Aufschluss darüber, warum es so schwierig sein kann, den Datensatz zu korrigieren (wie die Grafik oben in diesem Beitrag zeigt). Bei diesen schlechten Ideen handelt es sich nicht nur um Fehler, die leider in der Literatur verbreitet wurden; Es sind Fehler oder Betrügereien oder Fehler, die so schlimm sind, dass sie genauso intestine sind wie die Betrügereien, die es dann gibt geschoben in die Literatur und gepflegt dort durch die Bemühungen lokal mächtiger Eliten, wie zum Beispiel als Freakonomics dies förderte unzählig Studie zum Verhältnis von Schönheit und Geschlecht und zum Klimawandel Denier.

Abrufen diese Geschichte vom Psychologen Greg Francis, der von seinen Schwierigkeiten erzählt, sich gegen dieses schreckliche „Glücksgolfball“-Papier zu wehren:

Im Jahr 2012 habe ich bei Psychological Sciences einen Kommentar zu Damish et al. eingereicht. (2010), als mir klar wurde, dass die Ergebnisse „zu intestine um wahr zu sein“ schienen. Der Herausgeber lehnte den Kommentar ab und stützte sich dabei auf das Suggestions eines „sehr distanzierten Professors für experimentelles Design und statistische Methoden“, der (unter anderem) schrieb: „Es würde mich überhaupt nicht überraschen, wenn eine Publikationsverzerrung im Spiel wäre. Wenn ich eine Studie über Aberglauben durchgeführt hätte und die Ergebnisse null wären, würde ich sie wahrscheinlich nicht zur Veröffentlichung einreichen.“

Damals battle mir das noch nicht aufgefallen, aber später wurde mir klar, dass die in Experiment 4 von Damish et al. Papier besteht einen GRIM-Take a look at nicht. Der Maßstab für die Leistung ist die Anzahl der korrekt identifizierten Wörter, daher muss die Summe der Punktzahlen aller Teilnehmer jeder Bedingung ein ganzzahliger Wert sein. Damish et al. Geben Sie nicht ihre Stichprobengröße für jede der beiden Bedingungen an, sondern nur die Gesamtstichprobengröße (n1+n2=29). Der gemeldete Mittelwert für Teilnehmer mit Glücksbringer (M1=45,84) und der Mittelwert für Teilnehmer ohne Glücksbringer (M2=30,56) können nicht gleichzeitig durch eine Kombination von n1 und n2 Stichprobengrößen ermittelt werden, die zusammen eine Gesamtstichprobengröße von 29 ergeben. Wenn beispielsweise n1=14, dann wäre die Summe der Bewertungen n1*M1=641,76, was vermutlich auf 642 aufgerundet wird (muss). eine ganze Zahl sein, da es sich um die Anzahl korrekt identifizierter Wörter handelt). Aber 642/14=45,857, was nicht mit den gemeldeten 45,84 übereinstimmt. Auch das Abrunden hilft nicht, denn 641/14 = 45,785, was nicht dem gemeldeten Mittelwert entspricht. Es gibt keine Möglichkeit, M1=45,84 von n1=14 Teilnehmern zu erhalten. Für andere Kombinationen von n1 und n2 können Sie eines der Mittel verwenden, um einen Sinn zu ergeben, jedoch niemals beide gleichzeitig.

Additionally, ja, die Arbeit an diesem albernen Thema wird in die Zeitschriften gedrängt und abweichende Meinungen werden zurückgewiesen. Diese Artwork von Verhalten steht im Einklang mit einer Lakatos‘schen Sicht auf wissenschaftliche Forschungsprogramme, daher sind wir uns, die über die Soziologie der Wissenschaft nachdenken, in gewisser Weise dessen bewusst. Ich denke jedoch, dass wir leicht in die naive Ansicht verfallen, dass schlechte Ideen nur Fehler sind, die eine Weile bestehen bleiben, bis sie schließlich durch fehlgeschlagene Replikationen widerlegt werden. Tatsächlich werden große Anstrengungen unternommen, um den Established order aufrechtzuerhalten, zu denen auch Angriffe der Regierung gehören Redaktionen von wissenschaftlichen Zeitschriften; die wiederholte Verwendung von PNAS, Ted, NPR usw. zur Förderung schlechter Arbeit; Unterdrückung abweichender Meinungen (wie es Greg Francis widerfahren ist, wie oben beschrieben); und Förderung von Fehlinformationen durch große akademische Institutionen. Nach vielen Jahren hörte Harvard endlich auf, diesen Betrug zu fördern Jesu Frau Manuskript, aber meines Wissens haben sie ihr Manuskript nie zurückgezogen lächerliche Behauptung dass die Replikationsrate in der Psychologie „statistisch nicht von 100 % zu unterscheiden ist“.

Auch hier gibt es für jedes dieser Dinge den ethisch oder methodisch korrupten Kern und dann die größere Gruppe von Influencern, die Dinge bewerben, obwohl sie es besser wissen sollten, vermutlich aus dem Gefühl heraus, dass die schlechte Arbeit die richtige Richtung hat und es daher verdient, vor Kritik geschützt zu werden.