Neuronale Netzwerke haben die Artwork und Weise, wie Ingenieure Robotersteuerungen entwickeln, grundlegend verändert und anpassungsfähigere und effizientere Maschinen hervorgebracht. Dennoch sind diese gehirnähnlichen maschinellen Lernsysteme ein zweischneidiges Schwert: Ihre Komplexität macht sie leistungsstark, aber sie macht es auch schwierig zu garantieren, dass ein Roboter, der von einem neuronalen Netzwerk angetrieben wird, seine Aufgabe sicher erfüllt.

Die traditionelle Methode zur Überprüfung von Sicherheit und Stabilität sind Techniken, die als Ljapunow-Funktionen bezeichnet werden. Wenn Sie eine Ljapunow-Funktion finden, deren Wert kontinuierlich abnimmt, können Sie sicher sein, dass unsichere oder instabile Situationen, die mit höheren Werten verbunden sind, niemals eintreten werden. Bei Robotern, die von neuronalen Netzwerken gesteuert werden, ließen sich frühere Ansätze zur Überprüfung von Ljapunow-Bedingungen jedoch nicht intestine auf komplexe Maschinen skalieren.

Forscher des Laptop Science and Synthetic Intelligence Laboratory (CSAIL) des MIT und anderer Institute haben nun neue Techniken entwickelt, die Ljapunow-Berechnungen in komplexeren Systemen streng zertifizieren. Ihr Algorithmus sucht und verifiziert effizient eine Ljapunow-Funktion und bietet damit eine Stabilitätsgarantie für das System. Dieser Ansatz könnte möglicherweise einen sichereren Einsatz von Robotern und autonomen Fahrzeugen, einschließlich Flugzeugen und Raumfahrzeugen, ermöglichen.

Um frühere Algorithmen zu übertreffen, fanden die Forscher eine kostengünstige Abkürzung für den Trainings- und Verifizierungsprozess. Sie generierten kostengünstigere Gegenbeispiele – beispielsweise widersprüchliche Daten von Sensoren, die den Controller hätten verwirren können – und optimierten dann das Robotersystem, um diese zu berücksichtigen. Das Verständnis dieser Randfälle half den Maschinen, den Umgang mit schwierigen Umständen zu erlernen, wodurch sie unter einer größeren Bandbreite von Bedingungen sicher arbeiten konnten als bisher möglich. Dann entwickelten sie eine neuartige Verifizierungsformulierung, die die Verwendung eines skalierbaren neuronalen Netzwerkverifizierers, α,β-CROWN, ermöglicht, um strenge Worst-Case-Szenario-Garantien über die Gegenbeispiele hinaus zu bieten.

„Wir haben einige beeindruckende empirische Leistungen bei KI-gesteuerten Maschinen wie Humanoiden und Roboterhunden gesehen, aber diesen KI-Controllern fehlen die formalen Garantien, die für sicherheitskritische Systeme entscheidend sind“, sagt Lujie Yang, Doktorand für Elektrotechnik und Informatik (EECS) am MIT und CSAIL-Mitarbeiter, der zusammen mit dem Forscher Hongkai Dai SM ’12, PhD ’16 am Toyota Analysis Institute, Co-Leiter eines neuen Papiers über das Projekt ist. „Unsere Arbeit schließt die Lücke zwischen diesem Leistungsniveau von neuronalen Netzwerkcontrollern und den Sicherheitsgarantien, die für den Einsatz komplexerer neuronaler Netzwerkcontroller in der realen Welt erforderlich sind“, bemerkt Yang.

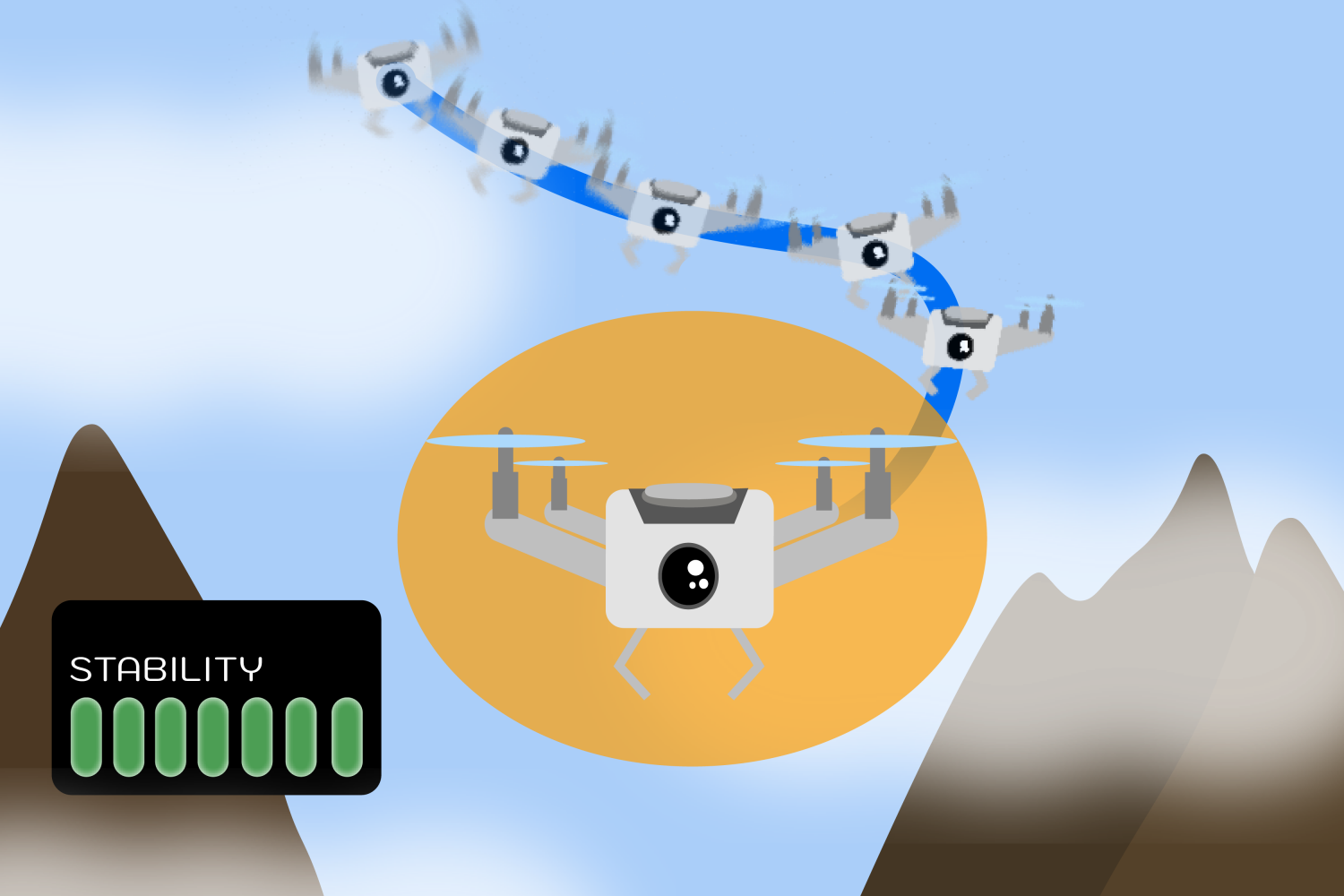

Für eine digitale Demonstration simulierte das Group, wie sich eine Quadrotor-Drohne mit Lidar-Sensoren in einer zweidimensionalen Umgebung stabilisieren würde. Ihr Algorithmus führte die Drohne erfolgreich in eine stabile Schwebeposition, wobei er nur die begrenzten Umgebungsinformationen nutzte, die die Lidar-Sensoren lieferten. In zwei weiteren Experimenten ermöglichte ihr Ansatz den stabilen Betrieb zweier simulierter Robotersysteme unter einem größeren Spektrum von Bedingungen: ein umgekehrtes Pendel und ein pfadverfolgendes Fahrzeug. Diese Experimente sind zwar bescheiden, aber relativ komplexer als das, was die Neighborhood für die Verifizierung neuronaler Netze zuvor hätte tun können, insbesondere weil sie Sensormodelle beinhalteten.

„Anders als bei üblichen Problemen des maschinellen Lernens erfordert die rigorose Verwendung neuronaler Netze als Ljapunow-Funktionen die Lösung schwieriger globaler Optimierungsprobleme, und daher ist die Skalierbarkeit der entscheidende Engpass“, sagt Sicun Gao, außerordentlicher Professor für Informatik und Ingenieurwissenschaften an der College of California in San Diego, der an dieser Arbeit nicht beteiligt conflict. „Die aktuelle Arbeit leistet einen wichtigen Beitrag, indem sie algorithmische Ansätze entwickelt, die viel besser auf die besondere Verwendung neuronaler Netze als Ljapunow-Funktionen in Steuerungsproblemen zugeschnitten sind. Sie erreicht eine beeindruckende Verbesserung der Skalierbarkeit und der Qualität der Lösungen gegenüber bestehenden Ansätzen. Die Arbeit eröffnet spannende Richtungen für die weitere Entwicklung von Optimierungsalgorithmen für neuronale Ljapunow-Methoden und die rigorose Verwendung von Deep Studying in der Steuerung und Robotik im Allgemeinen.“

Der Stabilitätsansatz von Yang und ihren Kollegen hat potenziell weitreichende Anwendungsmöglichkeiten, bei denen die Gewährleistung der Sicherheit von entscheidender Bedeutung ist. Er könnte dazu beitragen, eine ruhigere Fahrt für autonome Fahrzeuge wie Flugzeuge und Raumfahrzeuge zu gewährleisten. Ebenso könnten Drohnen, die Waren ausliefern oder verschiedene Gelände kartieren, von solchen Sicherheitsgarantien profitieren.

Die hier entwickelten Techniken sind sehr allgemein gehalten und nicht nur auf die Robotik beschränkt. Dieselben Techniken könnten in Zukunft möglicherweise auch bei anderen Anwendungen hilfreich sein, etwa in der Biomedizin und der industriellen Verarbeitung.

Während die Technik in Bezug auf die Skalierbarkeit eine Verbesserung gegenüber früheren Arbeiten darstellt, untersuchen die Forscher, wie sie in Systemen mit höheren Dimensionen besser funktionieren kann. Sie möchten auch Daten berücksichtigen, die über Lidar-Messwerte hinausgehen, wie Bilder und Punktwolken.

In der zukünftigen Forschungsrichtung möchte das Group die gleichen Stabilitätsgarantien für Systeme bieten, die sich in unsicheren Umgebungen befinden und Störungen ausgesetzt sind. Wenn eine Drohne beispielsweise einer starken Windböe ausgesetzt ist, möchten Yang und ihre Kollegen sicherstellen, dass sie trotzdem stabil fliegt und die gewünschte Aufgabe erfüllt.

Außerdem wollen sie ihre Methode auf Optimierungsprobleme anwenden, bei denen das Ziel darin besteht, die Zeit und Distanz zu minimieren, die ein Roboter braucht, um eine Aufgabe zu erledigen und dabei stabil zu bleiben. Sie planen, ihre Technik auf Humanoide und andere reale Maschinen auszudehnen, bei denen ein Roboter stabil bleiben muss, während er Kontakt mit seiner Umgebung hält.

Russ Tedrake, Toyota-Professor für EECS, Luft- und Raumfahrt und Maschinenbau am MIT, Vizepräsident für Robotikforschung am TRI und CSAIL-Mitglied, ist leitender Autor dieser Forschungsarbeit. Der Beitrag wird auch dem Doktoranden Zhouxing Shi von der College of California in Los Angeles und dem außerordentlichen Professor Cho-Jui Hsieh sowie dem Assistenzprofessor Huan Zhang von der College of Illinois Urbana-Champaign zugeschrieben. Ihre Arbeit wurde teilweise von Amazon, der Nationwide Science Basis, dem Workplace of Naval Analysis und dem AI2050-Programm von Schmidt Sciences unterstützt. Der Beitrag der Forscher wird auf der Worldwide Convention on Machine Studying 2024 vorgestellt.