Bitten Sie ein großes Sprachmodell (LLM) wie GPT-4, einen regennassen Campingplatz zu riechen, und es wird höflich ablehnen. Bitten Sie dasselbe System, Ihnen diesen Geruch zu beschreiben, und es wird in poetischer Artwork und Weise von „einer Luft voller Vorfreude“ und „einem Geruch, der sowohl frisch als auch erdig ist“ schwärmen, obwohl es weder Erfahrung mit Regen noch eine Nase hat, die ihm dabei helfen könnte, solche Beobachtungen zu machen. Eine mögliche Erklärung für dieses Phänomen ist, dass das LLM einfach den Textual content nachahmt, der in seinen umfangreichen Trainingsdaten vorhanden ist, anstatt mit einem echten Verständnis von Regen oder Gerüchen zu arbeiten.

Doch bedeutet das Fehlen von Augen, dass Sprachmodelle nie „verstehen“ können, dass ein Löwe „größer“ ist als eine Hauskatze? Philosophen und Wissenschaftler gleichermaßen betrachten die Fähigkeit, Sprache Bedeutung zuzuordnen, seit langem als Kennzeichen menschlicher Intelligenz – und fragen sich, welche wesentlichen Voraussetzungen uns dazu befähigen.

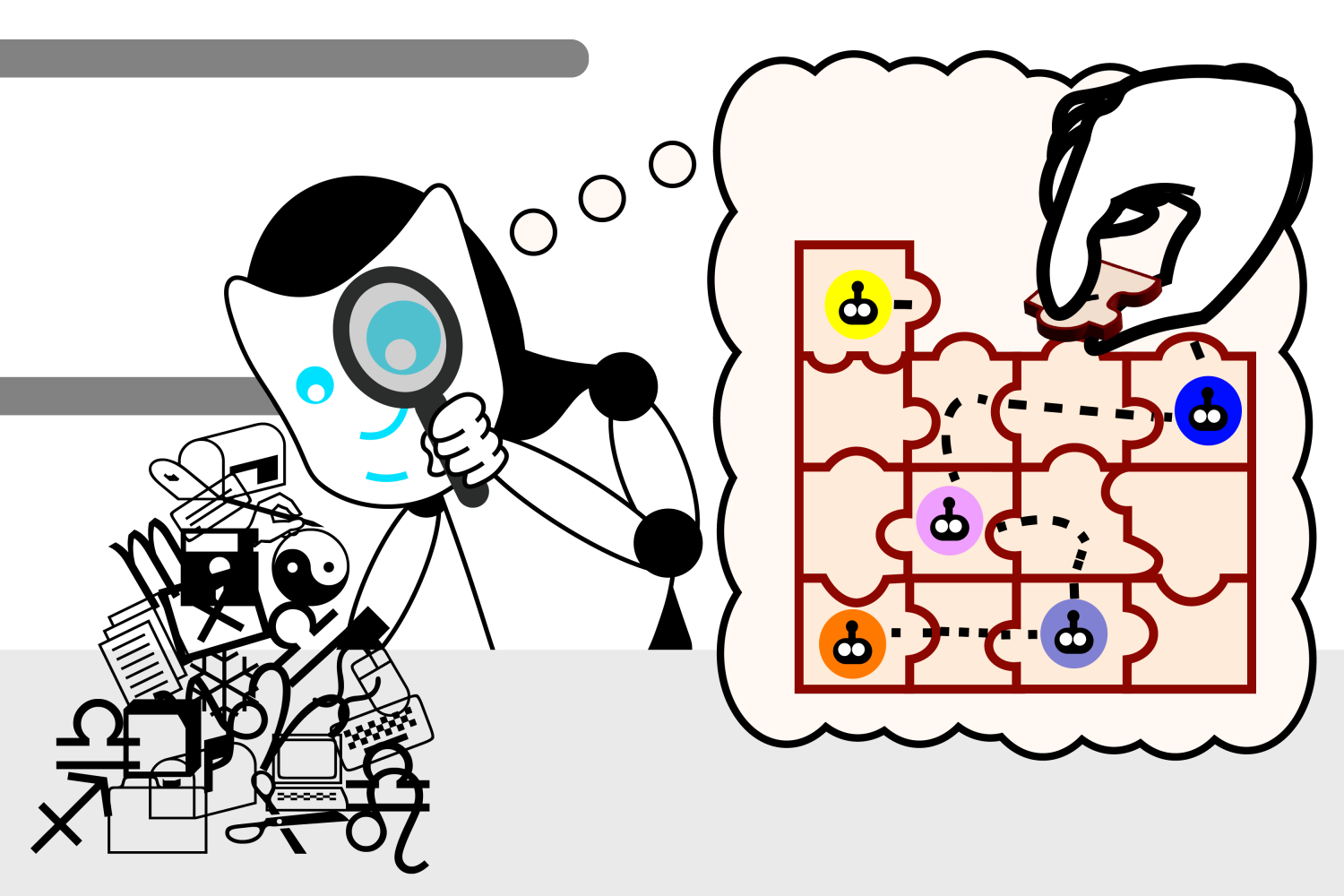

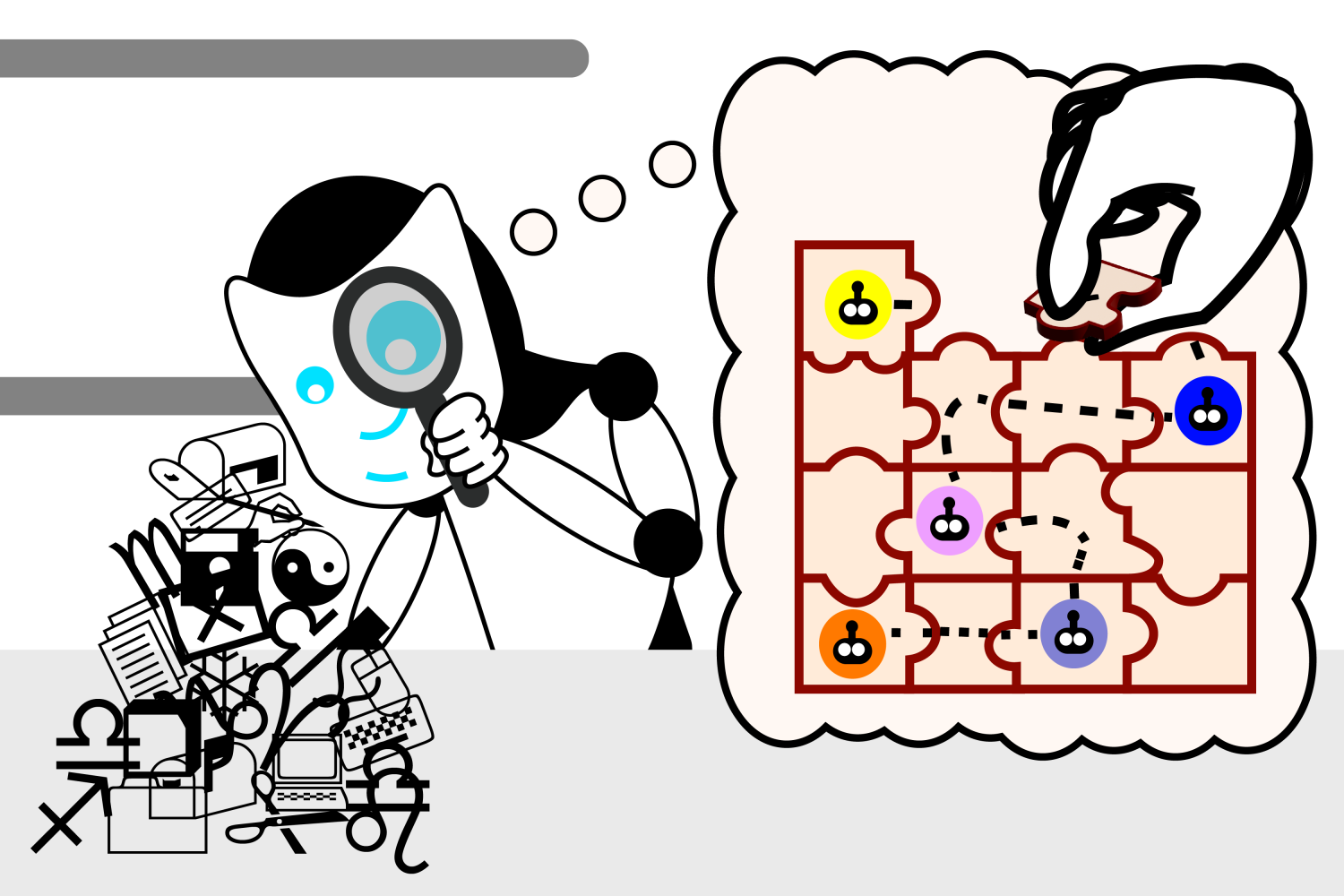

Bei der Untersuchung dieses Rätsels haben Forscher des Laptop Science and Synthetic Intelligence Laboratory (CSAIL) des MIT faszinierende Ergebnisse entdeckt, die darauf schließen lassen, dass Sprachmodelle möglicherweise ihr eigenes Verständnis der Realität entwickeln, um ihre generativen Fähigkeiten zu verbessern. Das Crew entwickelte zunächst eine Reihe kleiner Karel-Puzzles, bei denen es darum ging, Anweisungen zur Steuerung eines Roboters in einer simulierten Umgebung zu entwickeln. Anschließend trainierten sie ein LLM mit den Lösungen, ohne jedoch zu demonstrieren, wie die Lösungen tatsächlich funktionierten. Schließlich untersuchten sie mithilfe einer maschinellen Lerntechnik namens „Probing“ den „Denkprozess“ des Modells bei der Generierung neuer Lösungen.

Nach dem Coaching mit über einer Million zufälliger Rätsel stellten sie fest, dass das Modell spontan seine eigene Vorstellung der zugrunde liegenden Simulation entwickelte, obwohl es während des Trainings nie mit dieser Realität konfrontiert wurde. Solche Ergebnisse stellen unsere Intuitionen darüber in Frage, welche Arten von Informationen zum Erlernen sprachlicher Bedeutung notwendig sind – und ob LLMs eines Tages Sprache auf einer tieferen Ebene verstehen werden als heute.

„Zu Beginn dieser Experimente generierte das Sprachmodell zufällige Anweisungen, die nicht funktionierten. Als wir das Coaching abgeschlossen hatten, generierte unser Sprachmodell mit einer Quote von 92,4 Prozent korrekte Anweisungen“, sagt Charles Jin, Doktorand am MIT für Elektrotechnik und Informatik (EECS) und CSAIL-Mitglied, der Hauptautor eines neues Papier über die Arbeit. „Das conflict ein sehr spannender Second für uns, denn wir dachten, wenn ein Sprachmodell eine Aufgabe mit dieser Genauigkeit erledigen kann, können wir erwarten, dass es auch die Bedeutungen innerhalb der Sprache versteht. Das gab uns einen Ausgangspunkt, um zu untersuchen, ob LLMs tatsächlich Textual content verstehen, und jetzt sehen wir, dass sie zu viel mehr fähig sind, als nur Wörter blind zusammenzufügen.“

Im Kopf eines LLM

Mithilfe der Sonde konnte Jin diesen Fortschritt aus erster Hand miterleben. Ihre Aufgabe conflict es, zu interpretieren, was der LLM dachte, was die Anweisungen bedeuteten. Dabei stellte sich heraus, dass der LLM eine eigene interne Simulation davon entwickelte, wie sich der Roboter als Reaktion auf jede Anweisung bewegte. Als sich die Fähigkeit des Modells verbesserte, Rätsel zu lösen, wurden auch diese Vorstellungen präziser, was darauf hindeutete, dass der LLM begann, die Anweisungen zu verstehen. Es dauerte nicht lange, bis das Modell die Teile immer richtig zusammensetzte, um funktionierende Anweisungen zu erstellen.

Jin weist darauf hin, dass sich das Sprachverständnis des LLM in Phasen entwickelt, ähnlich wie ein Variety das Sprechen in mehreren Schritten lernt. Am Anfang ist es wie das Plappern eines Babys: repetitiv und meist unverständlich. Dann erlernt das Sprachmodell die Syntax oder die Regeln der Sprache. Dadurch kann es Anweisungen generieren, die wie echte Lösungen aussehen, aber trotzdem nicht funktionieren.

Die Anweisungen des LLM verbessern sich jedoch allmählich. Sobald das Modell Bedeutung erlangt, beginnt es, Anweisungen auszuspucken, die die angeforderten Spezifikationen korrekt umsetzen, wie ein Variety, das zusammenhängende Sätze bildet.

Trennung von Methode und Modell: Eine „weird Welt“

Die Sonde sollte lediglich „in das Gehirn eines LLM eindringen“, wie Jin es beschreibt, aber es bestand die entfernte Möglichkeit, dass sie auch einen Teil der Denkarbeit für das Modell übernahm. Die Forscher wollten sicherstellen, dass ihr Modell die Anweisungen unabhängig von der Sonde verstand, und nicht, dass die Sonde die Bewegungen des Roboters aus dem Verständnis der Syntax des LLM ableitete.

„Stellen Sie sich vor, Sie haben einen Datenhaufen, der den Denkprozess des LM kodiert“, schlägt Jin vor. „Die Sonde ist wie ein Forensiker: Sie geben dem Analysten diesen Datenhaufen und sagen: ‚So bewegt sich der Roboter. Versuchen Sie nun, die Bewegungen des Roboters in dem Datenhaufen zu finden.‘ Der Analyst sagt Ihnen später, dass er weiß, was mit dem Roboter in dem Datenhaufen los ist. Aber was, wenn der Datenhaufen tatsächlich nur die Rohanweisungen kodiert und der Analyst einen cleveren Weg gefunden hat, die Anweisungen zu extrahieren und ihnen entsprechend zu folgen? Dann hat das Sprachmodell nicht wirklich gelernt, was die Anweisungen überhaupt bedeuten.“

Um ihre Rollen voneinander zu trennen, vertauschten die Forscher die Bedeutung der Anweisungen für eine neue Sonde. In dieser „Bizarro-Welt“, wie Jin sie nennt, bedeuteten Anweisungen wie „hoch“ nun „runter“ innerhalb der Anweisungen, die den Roboter über sein Gitter bewegten.

„Wenn die Sonde Anweisungen in Roboterpositionen übersetzt, sollte sie in der Lage sein, die Anweisungen entsprechend der bizarren Bedeutungen ebenso intestine zu übersetzen“, sagt Jin. „Wenn die Sonde jedoch tatsächlich Kodierungen der ursprünglichen Roboterbewegungen im Denkprozess des Sprachmodells findet, sollte sie Schwierigkeiten haben, die bizarren Roboterbewegungen aus dem ursprünglichen Denkprozess zu extrahieren.“

Wie sich herausstellte, wies die neue Sonde Übersetzungsfehler auf und konnte ein Sprachmodell nicht interpretieren, das unterschiedliche Bedeutungen der Anweisungen hatte. Dies bedeutete, dass die ursprüngliche Semantik in das Sprachmodell eingebettet conflict, was darauf hindeutet, dass das LLM unabhängig vom ursprünglichen Prüfklassifizierer verstand, welche Anweisungen benötigt wurden.

„Diese Forschung zielt direkt auf eine zentrale Frage der modernen künstlichen Intelligenz ab: Sind die überraschenden Fähigkeiten großer Sprachmodelle einfach auf statistische Korrelationen im Maßstab zurückzuführen oder entwickeln große Sprachmodelle ein sinnvolles Verständnis der Realität, mit der sie arbeiten sollen? Diese Forschung zeigt, dass das LLM ein internes Modell der simulierten Realität entwickelt, obwohl es nie darauf trainiert wurde, dieses Modell zu entwickeln“, sagt Martin Rinard, MIT-Professor in EECS, CSAIL-Mitglied und Hauptautor des Artikels.

Dieses Experiment untermauerte die Analyse des Groups, dass Sprachmodelle ein tieferes Verständnis von Sprache entwickeln können. Dennoch räumt Jin ein, dass ihr Papier einige Einschränkungen aufweist: Sie verwendeten eine sehr einfache Programmiersprache und ein relativ kleines Modell, um ihre Erkenntnisse zu gewinnen. In einem bevorstehende Arbeitenwerden sie versuchen, eine allgemeinere Einstellung zu verwenden. Jins neueste Forschung beschreibt zwar nicht, wie man das Sprachmodell dazu bringen kann, Bedeutung schneller zu lernen, aber er glaubt, dass zukünftige Arbeiten auf diesen Erkenntnissen aufbauen können, um das Coaching von Sprachmodellen zu verbessern.

„Eine spannende offene Frage ist, ob das LLM tatsächlich sein internes Realitätsmodell verwendet, um über diese Realität nachzudenken, während es das Roboternavigationsproblem löst“, sagt Rinard. „Obwohl unsere Ergebnisse damit übereinstimmen, dass das LLM das Modell auf diese Weise verwendet, sind unsere Experimente nicht darauf ausgelegt, diese nächste Frage zu beantworten.“

„Heutzutage wird viel darüber diskutiert, ob LLMs Sprache tatsächlich ‚verstehen‘ oder ob ihr Erfolg eher auf Methods und Heuristiken zurückzuführen ist, die sich aus dem Aufsaugen großer Textmengen ergeben“, sagt Ellie Pavlick, Assistenzprofessorin für Informatik und Linguistik an der Brown College, die nicht an der Arbeit beteiligt conflict. „Diese Fragen stehen im Mittelpunkt dessen, wie wir KI aufbauen und was wir als inhärente Möglichkeiten oder Einschränkungen unserer Technologie erwarten. Dies ist eine schöne Arbeit, die diese Frage auf kontrollierte Weise untersucht – die Autoren nutzen die Tatsache aus, dass Computercode, wie natürliche Sprache, sowohl Syntax als auch Semantik hat, aber im Gegensatz zu natürlicher Sprache kann die Semantik direkt beobachtet und zu Versuchszwecken manipuliert werden. Das Versuchsdesign ist elegant und ihre Ergebnisse sind optimistisch, was darauf hindeutet, dass LLMs vielleicht etwas Tiefgründigeres darüber lernen können, was Sprache ‚bedeutet‘.“

Die Arbeit von Jin und Rinard wurde teilweise durch Zuschüsse der US-amerikanischen Protection Superior Analysis Tasks Company (DARPA) unterstützt.