Wurde Ihnen schon einmal eine Frage gestellt, auf die Sie nur einen Teil der Antwort wussten? Um eine fundiertere Antwort geben zu können, rufen Sie am besten einen Freund an, der sich besser mit dem Thema auskennt.

Dieser kollaborative Prozess kann auch dazu beitragen, die Genauigkeit großer Sprachmodelle (LLMs) zu verbessern. Dennoch struggle es schwierig, LLMs beizubringen, zu erkennen, wann sie bei einer Antwort mit einem anderen Modell zusammenarbeiten sollten. Anstatt komplexe Formeln oder große Mengen gekennzeichneter Daten zu verwenden, um festzulegen, wo Modelle zusammenarbeiten sollten, haben sich Forscher am Laptop Science and Synthetic Intelligence Laboratory (CSAIL) des MIT einen organischeren Ansatz vorgestellt.

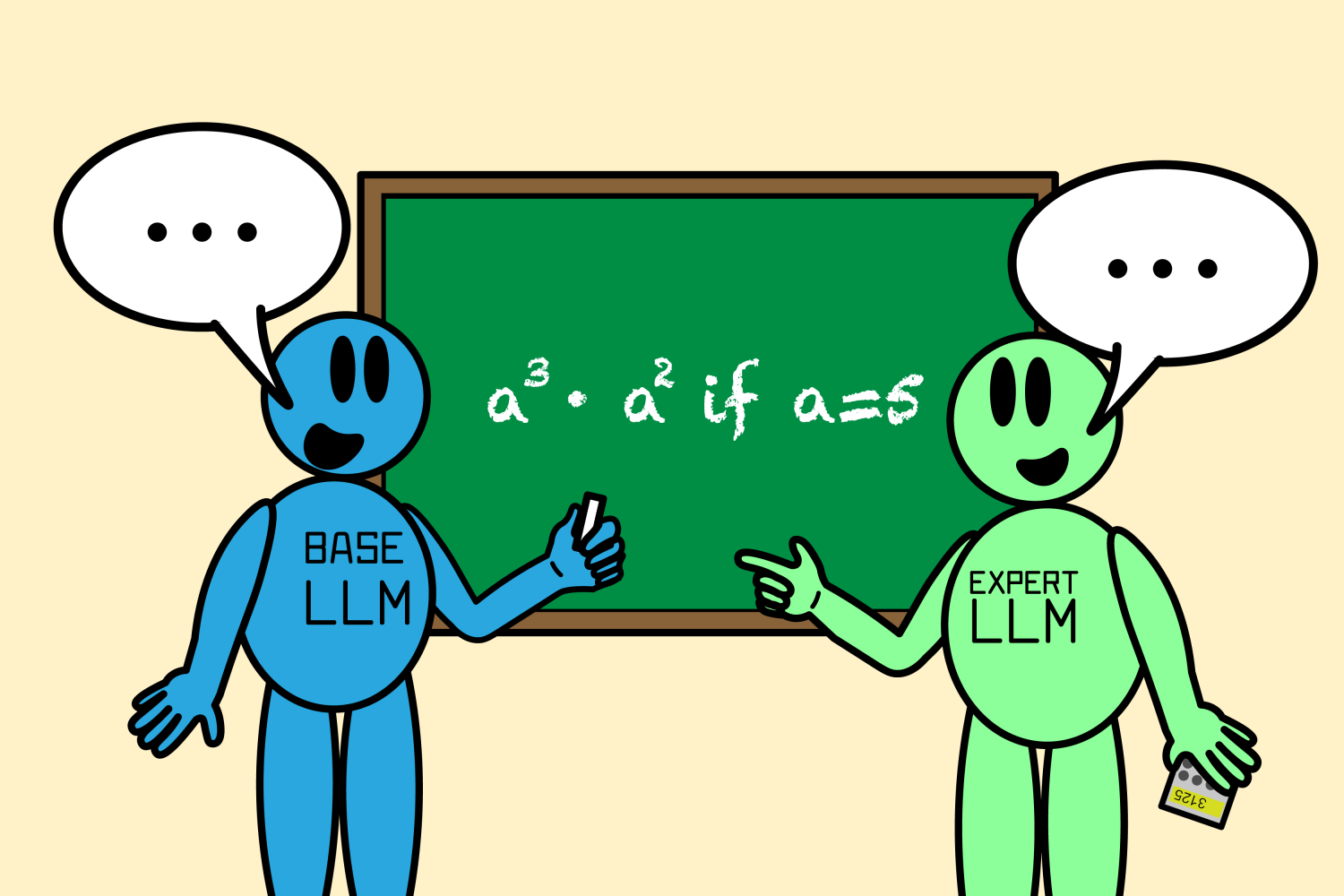

Ihr neuer Algorithmus namens „Co-LLM“ kann ein allgemeines Foundation-LLM mit einem spezialisierteren Modell koppeln und die Zusammenarbeit zwischen beiden unterstützen. Während ersteres eine Antwort formuliert, überprüft Co-LLM jedes Wort (oder Token) in seiner Antwort, um zu sehen, wo es auf eine genauere Antwort des Expertenmodells zurückgreifen kann. Dieser Prozess führt zu genaueren Antworten auf Dinge wie medizinische Eingabeaufforderungen und Mathematik- und Denkprobleme. Da das Expertenmodell nicht bei jeder Iteration benötigt wird, führt dies auch zu einer effizienteren Antwortgenerierung.

Um zu entscheiden, wann ein Basismodell die Hilfe eines Expertenmodells benötigt, trainiert das Framework mithilfe von maschinellem Lernen eine „Swap-Variable“ oder ein Software, das die Kompetenz jedes Wortes in den Antworten der beiden LLMs angeben kann. Der Swap ist wie ein Projektmanager, der Bereiche findet, in denen er einen Spezialisten hinzuziehen sollte. Wenn Sie Co-LLM beispielsweise bitten, einige Beispiele ausgestorbener Bärenarten zu nennen, würden zwei Modelle gemeinsam Antworten entwerfen. Das allgemeine LLM beginnt mit der Zusammenstellung einer Antwort, wobei die Swap-Variable an den Stellen eingreift, an denen sie ein besseres Token vom Expertenmodell einfügen kann, beispielsweise durch Hinzufügen des Jahres, in dem die Bärenart ausgestorben ist.

„Mit Co-LLM trainieren wir im Wesentlichen einen Allzweck-LLM, um bei Bedarf ein Expertenmodell anzurufen“, sagt Shannon Shen, eine MIT-Doktorandin in Elektrotechnik und Informatik und CSAIL-Mitglied, die Hauptautorin eines neues Papier über den Ansatz. „Wir verwenden domänenspezifische Daten, um dem Basismodell die Fachkenntnisse seines Gegenstücks in Bereichen wie biomedizinischen Aufgaben und mathematischen und logisch denkenden Fragen beizubringen. Dieser Prozess findet automatisch die Teile der Daten, die für das Basismodell schwer zu generieren sind, und weist das Basismodell dann an, zum Experten-LLM zu wechseln, der mit Daten aus einem ähnlichen Bereich vortrainiert wurde. Das allgemeine Modell stellt die ‚Gerüst‘-Generierung bereit, und wenn es das spezialisierte LLM aufruft, fordert es den Experten auf, die gewünschten Token zu generieren. Unsere Ergebnisse zeigen, dass die LLMs Muster der Zusammenarbeit organisch lernen, ähnlich wie Menschen erkennen, wann sie einen Experten auffordern müssen, um die Lücken zu füllen.“

Eine Kombination aus Flexibilität und Sachlichkeit

Stellen Sie sich vor, Sie würden einen allgemeinen LLM bitten, die Inhaltsstoffe eines bestimmten verschreibungspflichtigen Medikaments zu benennen. Die Antwort könnte falsch sein und erfordert die Experience eines spezialisierten Modells.

Um die Flexibilität des Co-LLM zu demonstrieren, nutzten die Forscher Daten wie die BioASQ medizinisches Ziel ist es, einen Foundation-LLM mit Experten-LLMs in verschiedenen Bereichen zu kombinieren, wie zum Beispiel Meditron-Modellder mit unmarkierten medizinischen Daten vortrainiert ist. Dadurch konnte der Algorithmus dabei helfen, Anfragen zu beantworten, die ein biomedizinischer Experte typischerweise erhält, wie etwa die Benennung der Mechanismen, die eine bestimmte Krankheit verursachen.

Wenn Sie beispielsweise einen einfachen LLM allein bitten, die Inhaltsstoffe eines bestimmten verschreibungspflichtigen Medikaments zu nennen, kann es sein, dass er eine falsche Antwort gibt. Mit der zusätzlichen Experience eines Modells, das auf biomedizinische Daten spezialisiert ist, erhalten Sie eine genauere Antwort. Co-LLM weist die Benutzer auch darauf hin, wo sie ihre Antworten noch einmal überprüfen können.

Ein weiteres Beispiel für die Leistungssteigerung von Co-LLM: Bei der Aufgabe, ein mathematisches Downside wie „a3 · a2 wenn a=5“ zu lösen, berechnete das allgemeine Modell die Antwort fälschlicherweise mit 125. Als Co-LLM das Modell trainierte, mehr mit einem großen mathematischen LLM namens Lemmagemeinsam kamen sie zu dem Schluss, dass die richtige Lösung 3.125 struggle.

Co-LLM lieferte genauere Antworten als fein abgestimmte einfache LLMs und unabgestimmte spezialisierte Modelle, die unabhängig voneinander arbeiten. Co-LLM kann zwei Modelle, die unterschiedlich trainiert wurden, dazu bringen, zusammenzuarbeiten, während andere effektive LLM-Kollaborationsansätze, wie z. B. „Proxy-Tuning,„müssen alle ihre Komponentenmodelle auf ähnliche Weise trainiert werden. Darüber hinaus erfordert diese Foundation, dass jedes Modell gleichzeitig verwendet wird, um die Antwort zu erzeugen, während der Algorithmus des MIT einfach sein Expertenmodell für bestimmte Token aktiviert, was zu einer effizienteren Generierung führt.

Wann Sie den Experten fragen sollten

Der Algorithmus der MIT-Forscher zeigt, dass eine genauere Nachahmung menschlicher Teamarbeit die Genauigkeit bei der Zusammenarbeit mehrerer LLMs erhöhen kann. Um die sachliche Präzision weiter zu erhöhen, könnte das Staff auf menschliche Selbstkorrektur zurückgreifen: Sie erwägen einen robusteren Aufschubansatz, der zurückverfolgen kann, wenn das Expertenmodell keine korrekte Antwort gibt. Dieses Improve würde es Co-LLM ermöglichen, den Kurs zu korrigieren, sodass der Algorithmus dennoch eine zufriedenstellende Antwort geben kann.

Das Staff möchte das Expertenmodell auch aktualisieren (indem nur das Basismodell trainiert wird), wenn neue Informationen verfügbar sind, und die Antworten so aktuell wie möglich halten. Dadurch könnte Co-LLM die aktuellsten Informationen mit starker Argumentationskraft kombinieren. Schließlich könnte das Modell bei Unternehmensdokumenten helfen, indem es die neuesten Informationen nutzt, um sie entsprechend zu aktualisieren. Co-LLM könnte auch kleine, personal Modelle trainieren, mit einem leistungsstärkeren LLM zusammenzuarbeiten, um Dokumente zu verbessern, die auf dem Server verbleiben müssen.

„Co-LLM stellt einen interessanten Ansatz dar, um zu lernen, zwischen zwei Modellen zu wählen, um Effizienz und Leistung zu verbessern“, sagt Colin Raffel, außerordentlicher Professor an der Universität Toronto und stellvertretender Forschungsleiter am Vector Institute, der nicht an der Forschung beteiligt struggle. „Da Routing-Entscheidungen auf Token-Ebene getroffen werden, bietet Co-LLM eine granulare Möglichkeit, schwierige Generierungsschritte auf ein leistungsfähigeres Modell zu verschieben. Die einzigartige Kombination von Routing auf Modell-Token-Ebene bietet außerdem ein hohes Maß an Flexibilität, das ähnlichen Methoden fehlt. Co-LLM trägt zu einem wichtigen Forschungsgebiet bei, das darauf abzielt, Ökosysteme spezialisierter Modelle zu entwickeln, um teure monolithische KI-Systeme zu übertreffen.“

Shen schrieb das Papier zusammen mit vier weiteren CSAIL-Mitgliedern: dem Doktoranden Hunter Lang (Abschluss 2017, MEng 2018), dem ehemaligen Postdoc und Apple AI/ML-Forscher Bailin Wang, dem MIT-Assistenzprofessor für Elektrotechnik und Informatik Yoon Kim und dem Professor und Jameel Clinic-Mitglied David Sontag (Abschluss 2010), die beide Teil des MIT-IBM Watson AI Lab sind. Ihre Forschung wurde teilweise von der Nationwide Science Basis, dem Nationwide Protection Science and Engineering Graduate (NDSEG) Fellowship, dem MIT-IBM Watson AI Lab und Amazon unterstützt. Ihre Arbeit wurde auf der Jahrestagung der Affiliation for Computational Linguistics vorgestellt.