Bild vom Autor

Große Sprachmodelle oder LLMs haben sich als treibender Katalysator in der Verarbeitung natürlicher Sprache herausgestellt. Ihre Anwendungsfälle reichen von Chatbots und virtuellen Assistenten bis hin zur Inhaltserstellung und Übersetzungsdiensten. Sie sind jedoch zu einem der am schnellsten wachsenden Bereiche in der Technologiewelt geworden – und wir können sie überall finden.

Mit dem wachsenden Bedarf an leistungsfähigeren Sprachmodellen steigt auch der Bedarf an effektiven Optimierungstechniken.

Es ergeben sich jedoch viele natürliche Fragen:

Wie können sie ihr Wissen verbessern?

Wie können sie ihre allgemeine Leistung verbessern?

Wie lassen sich diese Modelle vergrößern?

Die aufschlussreiche Präsentation mit dem Titel „Eine Übersicht über Techniken zur Maximierung der LLM-Leistung“ von John Allard und Colin Jarvis von OpenAI DevDay versuchte, diese Fragen zu beantworten. Wenn Sie die Veranstaltung verpasst haben, können Sie den Vortrag auf YouTube.

Diese Präsentation bot einen hervorragenden Überblick über verschiedene Techniken und bewährte Methoden zur Verbesserung der Leistung Ihrer LLM-Anwendungen. Dieser Artikel soll die besten Techniken zur Verbesserung der Leistung und Skalierbarkeit unserer KI-gestützten Lösungen zusammenfassen.

Die Grundlagen verstehen

LLMs sind hochentwickelte Algorithmen, die darauf ausgelegt sind, zusammenhängende und kontextbezogen passende Texte zu verstehen, zu analysieren und zu produzieren. Dies erreichen sie durch umfangreiches Coaching anhand riesiger Mengen linguistischer Daten zu unterschiedlichsten Themen, Dialekten und Stilen. So können sie verstehen, wie die menschliche Sprache funktioniert.

Bei der Integration dieser Modelle in komplexe Anwendungen müssen jedoch einige wichtige Herausforderungen berücksichtigt werden:

Zentrale Herausforderungen bei der Optimierung von LLMs

- Genauigkeit der LLMs: Sicherstellen, dass die LLM-Ausgabe genaue und zuverlässige Informationen ohne Halluzinationen enthält.

- Ressourcenverbrauch: LLMs erfordern erhebliche Rechenressourcen, darunter GPU-Leistung, Speicher und eine große Infrastruktur.

- Latenz: Echtzeitanwendungen erfordern eine geringe Latenz, was angesichts der Größe und Komplexität von LLMs eine Herausforderung darstellen kann.

- Skalierbarkeit: Bei steigenden Benutzeranforderungen muss unbedingt sichergestellt werden, dass das Modell eine erhöhte Final ohne Leistungseinbußen bewältigen kann.

Strategien für eine bessere Leistung

Die erste Frage lautet: „Wie können wir ihr Wissen verbessern?“

Das Erstellen einer teilweise funktionsfähigen LLM-Demo ist relativ einfach, aber die Verfeinerung für die Produktion erfordert iterative Verbesserungen. LLMs benötigen möglicherweise Hilfe bei Aufgaben, die fundierte Kenntnisse über bestimmte Daten, Systeme und Prozesse oder präzises Verhalten erfordern.

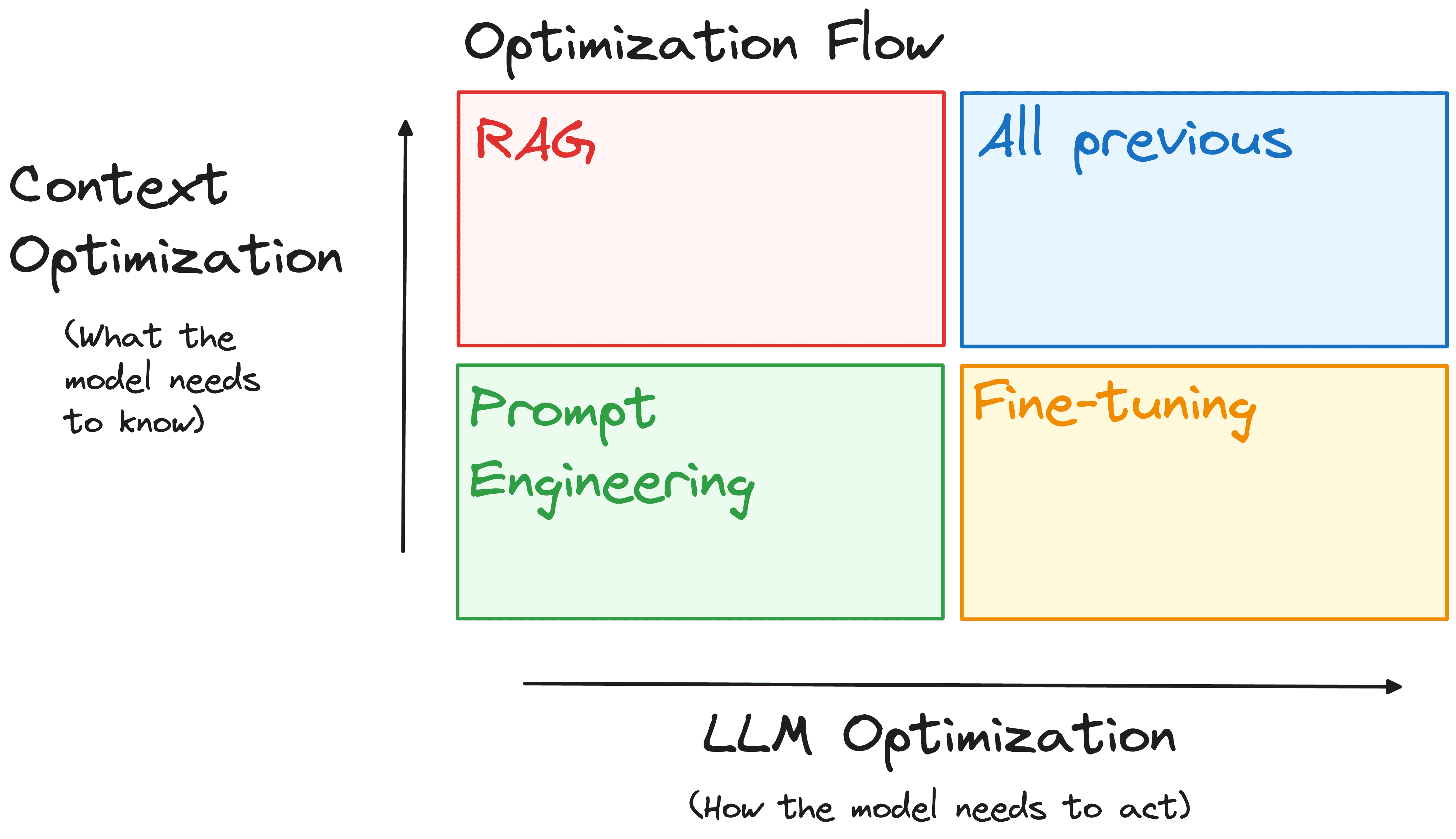

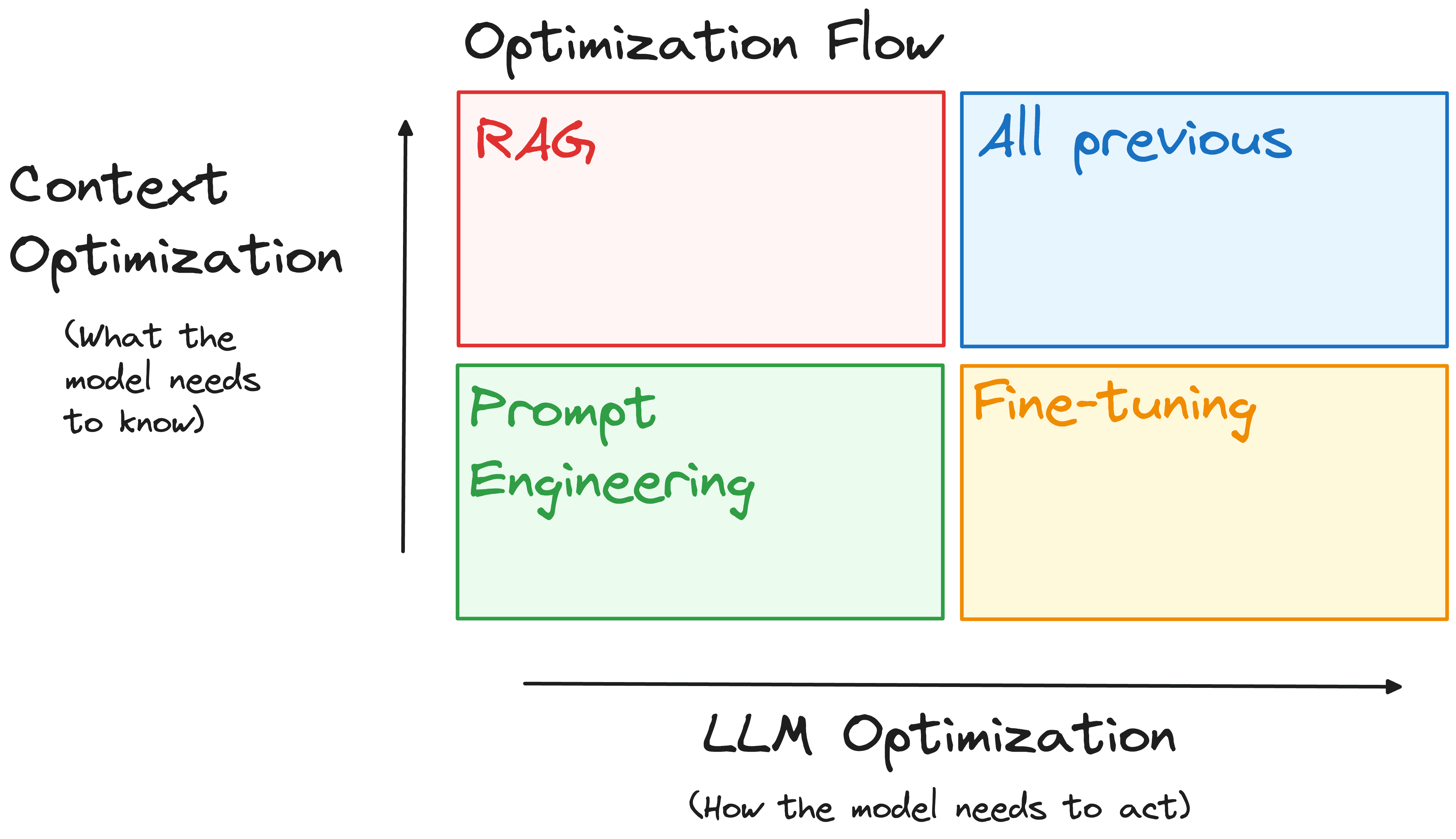

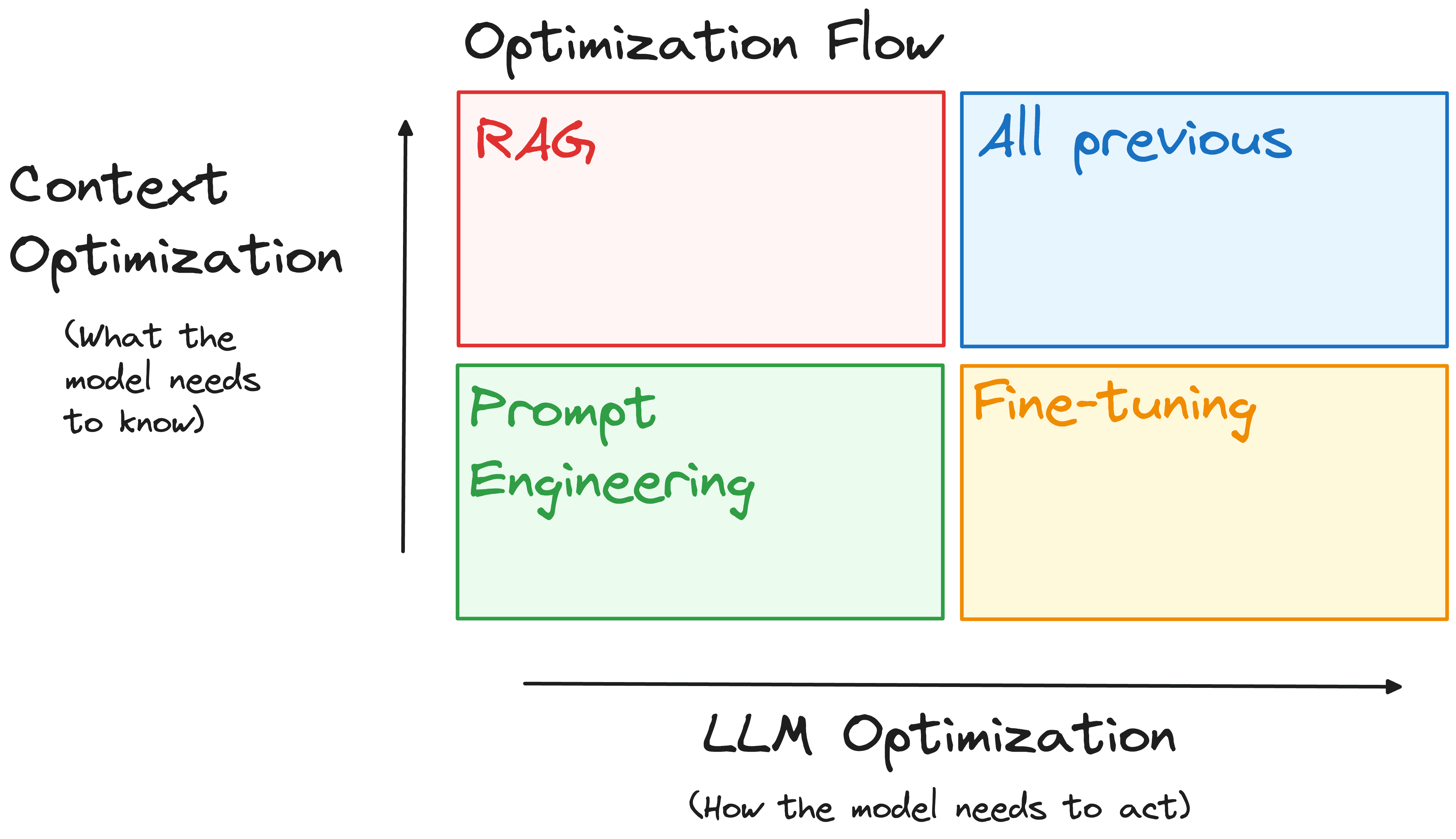

Um dieses Drawback zu lösen, verwenden die Groups Immediate Engineering, Retrieval Augmentation und Superb-Tuning. Ein häufiger Fehler ist die Annahme, dass dieser Prozess linear ist und in einer bestimmten Reihenfolge durchgeführt werden muss. Stattdessen ist es effektiver, ihn je nach Artwork der Probleme auf zwei Achsen anzugehen:

- Kontextoptimierung: Sind die Probleme darauf zurückzuführen, dass dem Modell der Zugriff auf die richtigen Informationen oder Kenntnisse fehlt?

- LLM-Optimierung: Generiert das Modell nicht die richtige Ausgabe, weil es beispielsweise ungenau ist oder nicht den gewünschten Stil oder das gewünschte Format einhält?

Bild vom Autor

Zur Bewältigung dieser Herausforderungen können drei grundlegende Instruments eingesetzt werden, von denen jedes eine einzigartige Rolle im Optimierungsprozess spielt:

Immediate Engineering

Passen Sie die Eingabeaufforderungen an, um die Antworten des Modells zu steuern. Beispielsweise können Sie die Eingabeaufforderungen eines Kundenservice-Bots verfeinern, um sicherzustellen, dass er stets hilfreiche und höfliche Antworten liefert.

Retrieval-Augmented Technology (RAG)

Verbessern des Kontextverständnisses des Modells durch externe Daten. Beispielsweise die Integration eines medizinischen Chatbots in eine Datenbank mit den neuesten Forschungsarbeiten, um genaue und aktuelle medizinische Beratung bereitzustellen.

Feinabstimmung

Modifizierung des Basismodells, um es besser an bestimmte Aufgaben anzupassen. So wie man ein Instrument zur Analyse juristischer Dokumente mithilfe eines Datensatzes juristischer Texte optimiert, um die Genauigkeit bei der Zusammenfassung juristischer Dokumente zu verbessern.

Der Prozess ist hochgradig iterativ und nicht jede Technik ist für Ihr spezifisches Drawback geeignet. Viele Techniken sind jedoch additiv. Wenn Sie eine Lösung finden, die funktioniert, können Sie sie mit anderen Leistungsverbesserungen kombinieren, um optimale Ergebnisse zu erzielen.

Strategien für eine optimierte Efficiency

Die zweite Frage lautet: „Wie kann ihre allgemeine Leistung verbessert werden?“

Neben einem genauen Modell ist ein zweiter wichtiger Punkt die Inferenzzeit. Inferenz ist der Prozess, bei dem ein trainiertes Sprachmodell wie GPT-3 Antworten auf Eingabeaufforderungen oder Fragen in realen Anwendungen (wie einem Chatbot) generiert.

Dies ist eine kritische Part, in der Modelle auf die Probe gestellt werden und Vorhersagen und Antworten in praktischen Szenarien generieren. Bei großen LLMs wie GPT-3 sind die Rechenanforderungen enorm, was eine Optimierung während der Inferenz unerlässlich macht.

Betrachten Sie ein Modell wie GPT-3, das 175 Milliarden Parameter hat, was 700 GB Float32-Daten entspricht. Diese Größe erfordert zusammen mit den Aktivierungsanforderungen viel RAM. Aus diesem Grund würde das Ausführen von GPT-3 ohne Optimierung eine umfangreiche Einrichtung erfordern.

Mit einigen Techniken lässt sich der Ressourcenbedarf zur Ausführung solcher Anwendungen reduzieren:

Modellbeschneidung

Dabei werden nicht wesentliche Parameter entfernt, sodass nur die für die Leistung entscheidenden Parameter übrig bleiben. Dadurch kann die Größe des Modells drastisch reduziert werden, ohne dass die Genauigkeit wesentlich beeinträchtigt wird.

Das bedeutet eine deutliche Reduzierung des Rechenaufwands bei gleichbleibender Genauigkeit. Einfach zu implementierender Pruning-Code ist im folgenden GitHub zu finden.

Quantisierung

Es handelt sich um eine Modellkomprimierungstechnik, die die Gewichte eines LLM von hochpräzisen Variablen in solche mit geringerer Genauigkeit umwandelt. Das bedeutet, dass wir die 32-Bit-Gleitkommazahlen auf speichereffizientere Formate mit geringerer Genauigkeit wie 16-Bit oder 8-Bit reduzieren können. Dadurch kann der Speicherbedarf drastisch reduziert und die Inferenzgeschwindigkeit verbessert werden.

LLMs können mithilfe von HuggingFace und Bitsandbytes problemlos quantisiert geladen werden. Dadurch können wir LLMs mit Ressourcen ausführen und optimieren, die weniger Strom verbrauchen.

from transformers import AutoModelForSequenceClassification, AutoTokenizer

import bitsandbytes as bnb

# Quantize the mannequin utilizing bitsandbytes

quantized_model = bnb.nn.quantization.Quantize(

mannequin,

quantization_dtype=bnb.nn.quantization.quantization_dtype.int8

)

Destillation

Dabei handelt es sich um den Prozess des Trainierens eines kleineren Modells (Pupil), um die Leistung eines größeren Modells (auch als Lehrer bezeichnet) nachzuahmen. Bei diesem Prozess wird das Studentenmodell trainiert, um die Vorhersagen des Lehrers nachzuahmen, wobei eine Kombination aus den Ausgabe-Logits des Lehrers und den wahren Beschriftungen verwendet wird. Auf diese Weise können wir mit einem Bruchteil des Ressourcenbedarfs eine ähnliche Leistung erzielen.

Die Idee besteht darin, das Wissen größerer Modelle auf kleinere mit einfacherer Architektur zu übertragen. Eines der bekanntesten Beispiele ist Distilbert.

Dieses Modell ist das Ergebnis der Nachahmung der Leistung von Bert. Es ist eine kleinere Model von BERT, die 97 % seiner Sprachverständnisfähigkeiten beibehält, dabei aber 60 % schneller und 40 % kleiner ist.

Techniken zur Skalierbarkeit

Die dritte Frage lautet: „Wie können diese Modelle skaliert werden?“

Dieser Schritt ist oft entscheidend. Ein Betriebssystem kann sich ganz anders verhalten, wenn es von einer Handvoll Benutzern verwendet wird, als wenn es für eine intensive Nutzung hochskaliert wird. Hier sind einige Techniken, um diese Herausforderung zu bewältigen:

Lastverteilung

Dieser Ansatz verteilt eingehende Anfragen effizient und sorgt für eine optimale Nutzung der Rechenressourcen und eine dynamische Reaktion auf Nachfrageschwankungen. Um beispielsweise einen weit verbreiteten Dienst wie ChatGPT in verschiedenen Ländern anzubieten, ist es besser, mehrere Instanzen desselben Modells bereitzustellen.

Zu den effektiven Techniken zum Lastenausgleich zählen:

Horizontale Skalierung: Fügen Sie weitere Modellinstanzen hinzu, um die erhöhte Final zu bewältigen. Verwenden Sie Container-Orchestrierungsplattformen wie Kubernetes, um diese Instanzen über verschiedene Knoten hinweg zu verwalten.

Vertikale Skalierung: Aktualisieren Sie vorhandene Maschinenressourcen wie CPU und Speicher.

Sharding

Beim Modell-Sharding werden Segmente eines Modells auf mehrere Geräte oder Knoten verteilt, was eine parallele Verarbeitung ermöglicht und die Latenzzeit deutlich reduziert. Absolutely Sharded Knowledge Parallelism (FSDP) bietet den entscheidenden Vorteil, dass eine vielfältige {Hardware} wie GPUs, TPUs und andere spezialisierte Geräte in mehreren Clustern genutzt werden können.

Diese Flexibilität ermöglicht es Organisationen und Einzelpersonen, ihre Hardwareressourcen entsprechend ihren spezifischen Anforderungen und ihrem Price range zu optimieren.

Zwischenspeicherung

Die Implementierung eines Caching-Mechanismus reduziert die Belastung Ihres LLM durch die Speicherung häufig abgerufener Ergebnisse, was besonders für Anwendungen mit sich wiederholenden Abfragen von Vorteil ist. Durch das Zwischenspeichern dieser häufigen Abfragen können Rechenressourcen erheblich gespart werden, da dieselben Anfragen nicht mehr wiederholt verarbeitet werden müssen.

Darüber hinaus kann die Stapelverarbeitung durch die Gruppierung ähnlicher Aufgaben die Ressourcennutzung optimieren.

Abschluss

Für diejenigen, die Anwendungen erstellen, die auf LLMs basieren, sind die hier besprochenen Techniken von entscheidender Bedeutung, um das Potenzial dieser transformativen Technologie zu maximieren. Die Beherrschung und effektive Anwendung von Strategien für eine genauere Ausgabe unseres Modells, die Optimierung seiner Leistung und die Ermöglichung einer Skalierung sind wesentliche Schritte bei der Entwicklung von einem vielversprechenden Prototyp zu einem robusten, produktionsreifen Modell.

Um diese Techniken vollständig zu verstehen, empfehle ich Ihnen dringend, tiefer in die Particulars einzusteigen und in Ihren LLM-Anwendungen mit ihnen zu experimentieren, um optimale Ergebnisse zu erzielen.

Josep Ferrer ist ein Analytikingenieur aus Barcelona. Er hat einen Abschluss in Physikingenieurwesen und arbeitet derzeit im Bereich der Datenwissenschaft, angewandt auf menschliche Mobilität. Er ist ein Teilzeit-Content material-Ersteller mit Schwerpunkt auf Datenwissenschaft und Technologie. Josep schreibt über alles, was mit KI zu tun hat, und befasst sich mit der Anwendung der anhaltenden Explosion in diesem Bereich.