Wissenschaftliche Anwendungen

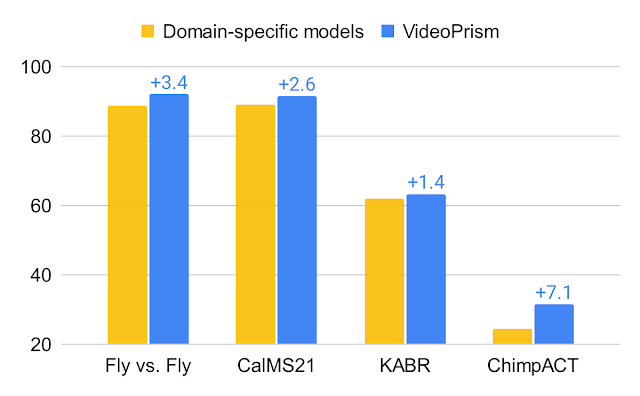

Schließlich testen wir VideoPrism anhand von Datensätzen, die von Wissenschaftlern aus verschiedenen Bereichen verwendet werden, darunter aus Bereichen wie Ethologie, Verhaltensneurowissenschaften und Ökologie. Für die Kommentierung dieser Datensätze ist in der Regel Domänenfachwissen erforderlich. Für die Kommentierung nutzen wir vorhandene wissenschaftliche Datensätze, die von der Neighborhood als Open-Supply-Lösung bereitgestellt werden Fliegen gegen Fliegen, CalMS21, ChimpACTUnd KABR. VideoPrism bietet nicht nur eine außergewöhnlich gute Leistung, sondern übertrifft sogar Modelle, die speziell für diese Aufgaben entwickelt wurden. Dies deutet darauf hin, dass Instruments wie VideoPrism das Potenzial haben, die Artwork und Weise, wie Wissenschaftler Videodaten in verschiedenen Bereichen analysieren, zu verändern.

Abschluss

Mit VideoPrism stellen wir einen leistungsstarken und vielseitigen Video-Encoder vor, der einen neuen Normal für das allgemeine Videoverständnis setzt. Unser Schwerpunkt sowohl auf dem Aufbau eines umfangreichen und vielfältigen Pre-Coaching-Datensatzes als auch auf innovativen Modellierungstechniken wurde durch unsere umfangreichen Auswertungen bestätigt. VideoPrism übertrifft nicht nur kontinuierlich starke Basislösungen, sondern ist durch seine einzigartige Fähigkeit zur Verallgemeinerung auch intestine für die Bewältigung einer Reihe realer Anwendungen geeignet. Aufgrund der möglichen breiten Nutzung sind wir bestrebt, die weitere verantwortungsvolle Forschung in diesem Bereich unter der Anleitung unserer fortzusetzen KI-Prinzipien. Wir hoffen, dass VideoPrism den Weg für zukünftige Durchbrüche an der Schnittstelle von KI und Videoanalyse ebnet und dabei hilft, das Potenzial von ViFMs in Bereichen wie wissenschaftliche Entdeckung, Bildung und Gesundheitswesen auszuschöpfen.

Danksagungen

Dieser Blogbeitrag wurde im Namen aller VideoPrism-Autoren erstellt: Lengthy Zhao, Nitesh B. Gundavarapu, Liangzhe Yuan, Hao Zhou, Shen Yan, Jennifer J. Solar, Luke Friedman, Rui Qian, Tobias Weyand, Yue Zhao, Rachel Hornung, Florian Schroff, Ming-Hsuan Yang, David A. Ross, Huisheng Wang, Hartwig Adam, Mikhail Sirotenko, Ting Liu und Boqing Gong. Wir danken David Hendon aufrichtig für ihre Bemühungen im Produktmanagement und Alex Siegman, Ramya Ganeshan und Victor Gomes für ihre Bemühungen im Programm- und Ressourcenmanagement. Wir danken außerdem Hassan Akbari, Sherry Ben, Yoni Ben-Meshulam, Chun-Te Chu, Sam Clearwater, Yin Cui, Ilya Figotin, Anja Hauth, Sergey Ioffe, Xuhui Jia, Yeqing Li, Lu Jiang, Zu Kim, Dan Kondratyuk und Invoice Mark, Arsha Nagrani, Caroline Pantofaru, Sushant Prakash, Cordelia Schmid, Bryan Seybold, Mojtaba Seydhosseini, Amanda Sadler, Rif A. Saurous, Rachel Stigler, Paul Voigtlaender, Pingmei Xu, Chaochao Yan, Xuan Yang und Yukun Zhu für die Diskussionen, Unterstützung und Suggestions, die wesentlich zu dieser Arbeit beigetragen haben. Wir danken Jay Yagnik, Rahul Sukthankar und Tomas Izo für ihre begeisterte Unterstützung dieses Projekts. Abschließend danken wir Tom Small, Jennifer J. Solar, Hao Zhou, Nitesh B. Gundavarapu, Luke Friedman und Mikhail Sirotenko für die enorme Hilfe bei der Erstellung dieses Blogbeitrags.