NVIDIA NIM steigert die Produktivität der Entwickler, indem es eine standardisierte Möglichkeit bietet, generative KI in Anwendungen einzubetten.

Was ist NVIDIA NIM?

NVIDIA NIM (NVIDIA Inference Microservices) ist eine Plattform, die die Bereitstellung und Integration generativer KI-Modelle verbessern soll. Sie bietet einen standardisierten Ansatz für die Einbettung generativer KI in verschiedene Anwendungen, wodurch die Produktivität der Entwickler deutlich gesteigert und Infrastrukturinvestitionen optimiert werden.

Funktionen von NVIDIA NIM

Zu den wichtigsten Funktionen und Fähigkeiten von NVIDIA NIM gehören:

- Optimierte Bereitstellung: NVIDIA NIM-Container werden mit vorinstallierter wichtiger Software program wie NVIDIA CUDA, NVIDIA Triton Inference Server und NVIDIA TensorRT-LLM geliefert und ermöglichen so eine effiziente GPU-beschleunigte Inferenz.

- Unterstützung für mehrere Modelle: Die Plattform unterstützt eine breite Palette von KI-Modellen, darunter Databricks DBRX, Googles Gemma, Meta Llama 3, Microsoft Phi-3 und Mistral Giant, und macht sie als Endpunkte auf ai.nvidia.com zugänglich.

- Integration mit beliebten Plattformen: NVIDIA NIM kann in Plattformen wie Hugging Face integriert werden, sodass Entwickler mithilfe von NVIDIA-gestützten Inferenzendpunkten problemlos auf Modelle zugreifen und diese ausführen können.

- Umfassende Ökosystemunterstützung: Es wird von zahlreichen Plattformanbietern (Canonical, Purple Hat, Nutanix, VMware) unterstützt und in die wichtigsten Cloud-Plattformen (Amazon Net Providers, Google Cloud, Azure, Oracle Cloud Infrastructure) integriert.

- Branchenweite Akzeptanz: Führende Unternehmen verschiedener Branchen wie Foxconn, Pegatron, Amdocs und ServiceNow nutzen NVIDIA NIM für Anwendungen wie KI-Fabriken, Good Cities, Elektrofahrzeuge, Kundenabrechnung und multimodale KI-Modelle.

- Entwicklerzugriff: Mitglieder des NVIDIA-Entwicklerprogramms können für Forschung, Entwicklung und Checks kostenlos auf NIM zugreifen und so Experimente und Innovationen bei KI-Anwendungen ermöglichen.

Quick 200 Technologiepartner, darunter Cadence, Cloudera, Cohesity, DataStax, NetApp, Scale AI und Synopsys, integrieren NVIDIA NIM, um generative KI-Bereitstellungen zu beschleunigen, die auf bestimmte Anwendungen wie Copiloten, Codierassistenten und digitale menschliche Avatare zugeschnitten sind.. Zusätzlich, Hugging Face führt NVIDIA NIM ein, beginnend mit Meta Llama 3.

Jensen Huang, Gründer und CEO von NVIDIA, betonte die Zugänglichkeit und Bedeutung von NVIDIA NIM und sagte: „Jedes Unternehmen möchte generative KI in seine Betriebsabläufe integrieren, aber nicht alle verfügen über ein Workforce engagierter KI-Forscher.“ NVIDIA NIM ermöglicht es nahezu jedem Unternehmen, generative KI zu nutzen..

Unternehmen können KI-Anwendungen mit NVIDIA NIM über die NVIDIA AI Enterprise-Softwareplattform implementieren.Ab nächsten Monat Mitglieder des NVIDIA Developer Program haben kostenlosen Zugriff auf NVIDIA NIM für Forschung, Entwicklung und Checks auf der von ihnen gewählten Infrastruktur..

NVIDIA NIM-Container sind darauf ausgelegt, die Modellbereitstellung für GPU-beschleunigte Inferenz zu optimieren und sind mit NVIDIA CUDA-Software program, NVIDIA Triton Inference Server und NVIDIA TensorRT-LLM-Software program ausgestattet.. Über 40 Modelle, wie Databricks DBRX, Googles Gemma, Meta Llama 3, Microsoft Phi-3 und Mistral Giant, sind als NIM-Endpunkte auf ai.nvidia.com zugänglich..

Durch das Über die Hugging Face AI-Plattform können Entwickler problemlos auf NVIDIA NIM-Mikroservices für Meta Llama 3-Modelle zugreifen. Diese Integration ermöglicht es ihnen, Führen Sie Llama 3 NIM effizient aus, indem Sie Hugging Face Inference Endpoints verwenden, die von NVIDIA GPUs unterstützt werden..

Zahlreiche Plattformanbieter, darunter Canonical, Purple Hat, Nutanix und VMware, unterstützen NVIDIA NIM sowohl auf Open-Supply-KServe- als auch auf Unternehmenslösungen. KI-Anwendungsunternehmen wie Hippocratic AI, Glean, Kinetica und Redis sind Nutzung von NIM zur Förderung generativer KI-Inferenz. Führende KI-Instruments und MLOps-Associate wie Amazon SageMaker, Microsoft Azure AI, Dataiku, DataRobot und andere, haben NIM in ihre Plattformen integriert, wodurch Entwickler domänenspezifische generative KI-Anwendungen mit optimierter Inferenz erstellen und bereitstellen können.

Holen Sie sich Ihr kostenloses NVIDIA Recreation Cross Jetzt Angebot

Globale Systemintegratoren und Service-Supply-Associate, darunter Accenture, Deloitte, Infosys, Latentview, Quantiphi, SoftServe, TCS und Wipro, haben Fachwissen im Bereich NIM entwickelt, um Unternehmen bei der schnellen Entwicklung und Implementierung von KI-Strategien für die Produktion zu unterstützen. Unternehmen können NIM-fähige Anwendungen auf NVIDIA-zertifizierten Systemen von Herstellern wie ausführen Cisco, Dell Applied sciences, Hewlett-Packard Enterprise, Lenovo und Supermicro, sowie auf Servern von ASRock Rack, ASUS, GIGABYTE, Ingrasys, Inventec, Pegatron, QCT, Wistron und WiwynnDarüber hinaus sind NIM-Mikroservices in die wichtigsten Cloud-Plattformen integriert, darunter Amazon Net Providers, Google Cloud, Azurblauund Oracle Cloud Infrastructure.

Führende Unternehmen nutzen NIM für vielfältige Anwendungen in verschiedenen Branchen. Foxconn verwendet NIM für domänenspezifische LLMs in KI-Fabriken, Good Cities und Elektrofahrzeugen. Pegatron setzt NIM für das Projekt TaME ein, um die lokale LLM-Entwicklung für verschiedene Branchen voranzutreiben. Amdocs verwendet NIM für ein LLM zur Kundenabrechnung, wodurch Kosten und Latenz deutlich reduziert und gleichzeitig die Genauigkeit verbessert werden. Service jetzt integriert NIM-Mikroservices in sein multimodales Now AI-Modell und ermöglicht Kunden so eine schnelle und skalierbare LLM-Entwicklung und -Bereitstellung.

Wie kann ich NVIDIA NIM ausprobieren?

Die Verwendung von NVIDIA NIM zum Bereitstellen und Experimentieren mit generativen KI-Modellen ist unkompliziert. Hier ist eine Schritt-für-Schritt-Anleitung, die Ihnen den Einstieg erleichtert:

- Besuchen Sie die NVIDIA NIM-Web site:

- Entdecken Sie:

- Auf der Homepage finden Sie die Choice „Jetzt testen“. Klicken Sie auf diese Schaltfläche, um zu beginnen.

- Wählen Sie Ihr Modell:

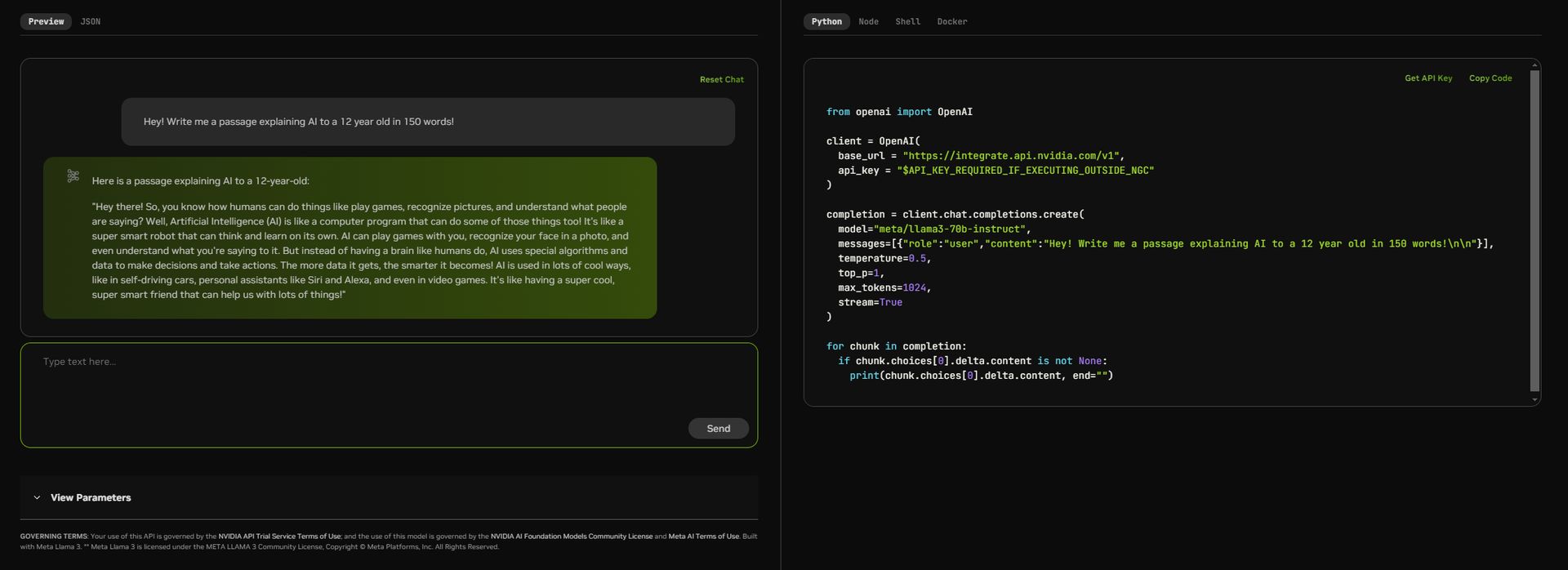

- Sie werden auf eine Seite weitergeleitet, auf der verschiedene Modelle vorgestellt werden. Wählen Sie für dieses Beispiel das Modell „llama3-70b-instruct“ von Meta aus. Dieses Modell ist für Aufgaben zur Sprachgenerierung konzipiert.

- Bereitstellen des Modells:

- Sobald Sie das Modell ausgewählt haben, wird eine Schnittstelle mit Optionen zum Bereitstellen des Modells angezeigt. Klicken Sie auf „Überall ausführen“, um fortzufahren.

- Verwenden des Inferenzendpunkts:

- Nach der Bereitstellung haben Sie Zugriff auf die Hugging Face Inference Endpoints, die von NVIDIA-GPUs unterstützt werden. So können Sie das Modell effizient ausführen.

- Geben Sie Ihre Eingabeaufforderung ein:

- In der Benutzeroberfläche finden Sie ein Textfeld, in das Sie Ihre Eingabeaufforderung eingeben können. Sie können beispielsweise Folgendes eingeben: „Hey! Schreiben Sie mir einen Textual content, in dem Sie einem 12-Jährigen KI in 150 Wörtern erklären!“

- Führen Sie die Eingabeaufforderung aus:

- Klicken Sie auf die Schaltfläche „Senden“, um die Eingabeaufforderung auszuführen. Das Modell generiert eine Antwort basierend auf Ihrer Eingabe.

- Anzeigen der Ausgabe:

- Die generierte Antwort wird im Ausgabebereich angezeigt. Sie können den vom Modell generierten Textual content überprüfen und bei Bedarf verwenden.

- Entdecken Sie weitere Funktionen:

- NVIDIA NIM ermöglicht Ihnen außerdem, Parameter zu optimieren und den JSON-Code für eine erweiterte Nutzung anzuzeigen. Erkunden Sie diese Optionen, um die Ausgabe weiter anzupassen.

- Kostenloser Zugang für Entwickler:

- Wenn Sie Entwickler sind, können Sie kostenlos auf NVIDIA NIM-Mikroservices für Forschung, Entwicklung und Checks zugreifen, indem Sie sich über das NVIDIA-Entwicklerprogramm registrieren.

Beispielinteraktion

Hier ist ein Beispiel für die Verwendung des Modells:

- Immediate: „Hey! Schreib mir einen Textual content, in dem du einem 12-Jährigen KI in 150 Wörtern erklärst!“

- Antwort: „Hallo! Wissen Sie, dass Menschen Dinge wie Spiele spielen, Bilder erkennen und verstehen können, was andere sagen? Künstliche Intelligenz (KI) ist wie ein Computerprogramm, das einige dieser Dinge auch kann! Sie ist wie ein superintelligenter Roboter, der selbstständig denken und lernen kann. KI kann mit Ihnen Spiele spielen, Ihr Gesicht auf einem Foto erkennen und sogar verstehen, was Sie zu ihr sagen. Aber anstatt ein Gehirn wie Menschen zu haben, verwendet KI spezielle Algorithmen und Daten, um Entscheidungen zu treffen und Maßnahmen zu ergreifen. Je mehr Daten sie erhält, desto intelligenter wird sie! KI wird auf viele coole Arten eingesetzt, beispielsweise in selbstfahrenden Autos, persönlichen Assistenten wie Siri und Alexa und sogar in Videospielen. Es ist, als hätten wir einen supercoolen, superintelligenten Freund, der uns bei vielen Dingen helfen kann!“

Bildnachweis: Kerem Gülen/Mitten auf der Reise