Müde von der endlosen Debatte darüber, welcher KI -Codierungsassistent „der Beste“ ist? Was ist, wenn das Geheimnis kein perfektes Werkzeug findet, sondern eine Symphonie von ihnen beherrscht? Vergessen Sie den einheitlichen Ansatz. In der Zukunft der Codierung geht es nicht um Loyalität. Es geht darum, eine vielfältige Toolbox zu nutzen, die jedes Instrument für eine bestimmte Aufgabe abgestimmt ist.

Dies ist der Code nach der Karteiung, in der Codezeilen nicht mehr kostbar sind, sondern ein verfügbares Rohstoff. In einer Welt, in der Sie 1.000 Codezeilen generieren können, um einen einzelnen Fehler zu finden und ihn dann zu löschen, haben sich die Spielregeln grundlegend geändert.

„Wir schreiben nicht mehr nur Code; wir orchestrieren Intelligenz.“

In a letzter Beitrag auf xAndrej Karpathy, eine führende Stimme in der KI -Welt, teilte einen tiefen Blick auf seine sich entwickelnde Beziehung zu Großsprachmodellen (LLMs) im Codierungs -Workflow. Seine Perspektive spiegelt eine breitere Verschiebung wider: Entwickler bewegen sich nun, um einen LLM -Workflow zu erstellen – ein geschichteter System von Werkzeugen und Praktiken, das sich an Kontext, Aufgabe und persönlichen Stil anpasst.

Was folgt, ist ein tiefes Eintauchen in Karpathys vielschichtiger Ansatz zur LLM-unterstützten Codierung, eine Erforschung der realen Implikationen für Entwickler auf allen Ebenen und eine Reihe von umsetzbaren Erkenntnissen, mit denen Sie Ihren eigenen optimalen KI-Codierungsstapel herstellen können.

KI-betriebener Codierungsstapel: Ein mehrschichtiger Ansatz zur Produktivität

Die Landschaft von Ai-unterstützte Codierung ist riesig und sich ständig weiterentwickelt. Andrej Karpathy hat kürzlich seinen persönlichen Workflow geteilt und einen differenzierten, vielschichtigen Ansatz zur Nutzung verschiedener KI-Instruments enthüllt. Anstatt sich auf eine einzelne perfekte Lösung zu verlassen, navigiert er fachmännisch einen Stapel von Werkzeugen, die jeweils eigene Stärken und Schwächen haben. Es geht nicht nur darum, AI zu verwenden. Es geht darum, seine unterschiedlichen Formen zu verstehen und sie strategisch anzuwenden.

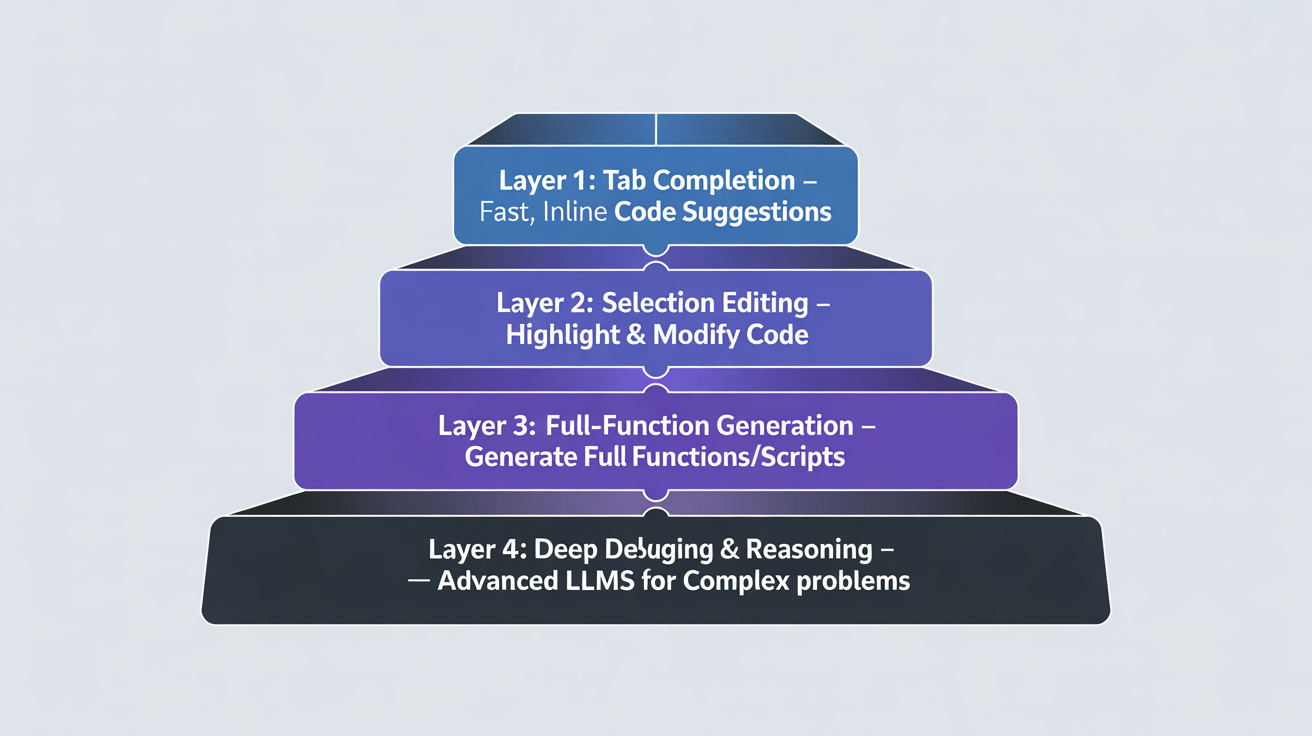

Der LLM -Workflow von Karpathy für Entwickler beinhaltet die folgenden Schichten:

Lassen Sie uns diesen leistungsstarken, unkonventionellen Workflow Lay für Layer aufschlüsseln und sehen, wie Sie eine ähnliche Denkweise annehmen können, um Ihre eigene Produktivität zu beenden.

Ebene 1: Registerkarte Vervollständigung

Im Kern des Workflows von Karpathy steht eine einfache Aufgabe – Registerkartenabschluss. Er schätzt, dass es etwa 75% seiner KI -Unterstützung ausmacht. Warum? Weil es der effizienteste Weg ist, mit dem Modell zu kommunizieren. Das Schreiben einiger Code- oder Kommentarezeilen ist eine Möglichkeit mit hoher Bandbreite, eine Aufgabe anzugeben. Sie versuchen nicht, eine komplexe Funktion in einer Textaufforderung zu beschreiben. Sie zeigen einfach, was Sie wollen, am richtigen Ort, zur richtigen Zeit.

Hier geht es nicht darum, die ganze Funktion für Sie zu schreiben. Es geht um einen kollaborativen, hin und her. Sie geben die Absicht an, und die KI liefert die schnellen, kontextbewussten Vorschläge. Dieser Workflow ist schnell, niedrig und ledig und hält Sie auf dem Fahrersitz. Es ist das Äquivalent eines Co-Pilots, der Ihre Sätze beendet, nicht eines, das die Steuerelemente übernimmt. Dafür verlässt sich Karpathy darauf Cursorein KI-angetanter Code-Editor.

- Warum funktioniert es: Es minimiert den „Kommunikationsaufwand“. Textanforderungen können ausführlich sein und unter Mehrdeutigkeit leiden. Code ist direkt.

- Beispiel: Sie geben Def calculate_ ein und die KI schlägt sofort vor, Berechnung_total_price (Elemente, Tax_rate) :. Sie leiten den Prozess mit minimaler Anstrengung.

Da selbst die besten Modelle nervig werden können, wird vorgeschlagen, die Funktion ein- und auszuschalten. Auf diese Weise kann man die Kontrolle behalten und unerwünschte Vorschläge vermeiden.

Schicht 2: Hervorheben und Modifizieren

Der nächste Schritt in der Komplexität ist ein gezielter Ansatz: Hervorhebung eines bestimmten Codeblocks und der Befragung einer Änderung. Dies ist ein erheblicher Sprung von der einfachen Registerkarte. Sie fragen nicht nur nach einer neuen Linie. Sie bitten die KI, die Logik eines vorhandenen Blocks zu verstehen und ihn zu verwandeln.

Dies ist eine leistungsstarke Technik zum Refactoring und Optimieren: ein wesentlicher Bestandteil eines LLM -Workflows für Entwickler. Müssen Sie eine Multi-Linie für Schleife in ein prägnantes Listenverständnis umwandeln? Markieren Sie den Code und fordern Sie die KI auf. Möchten Sie einer Funktion Fehlerbehandlung hinzufügen? Markieren Sie und fragen Sie. Dieser Workflow eignet sich perfekt für Mikrooptimierungen und fokussierte Verbesserungen, ohne die gesamte Funktion von Grund auf neu zu schreiben.

- Warum es funktioniert: Es bietet einen klaren, begrenzten Kontext. Die KI erraten nicht, was Sie von einer breiten Eingabeaufforderung wollen. Es funktioniert innerhalb der expliziten Grenzen, die Sie zur Verfügung gestellt haben.

- Beispiel: Sie heben einen Block verschachtelter If-Then-Else-Aussagen hervor und fordern Sie auf: „Konvertieren Sie dies in ein saubereres, lesbareres Format.“ Die KI könnte eine Swap -Anweisung oder eine Reihe von logischen und/oder Operationen vorschlagen.

Schicht 3: Assistenten von Seite an Seite (z. B. Claude Code, Codex)

Wenn die anstehende Aufgabe zu groß ist, um einen einfachen Spotlight-and-Modify zu machen, kommt die nächste Schicht von Karpathys Stack ins Spiel: Ein leistungsstärkerer Assistent wie Claude -Code oder Kodex nebenbei. Diese Instruments dienen dazu, größere, umfangreichere Codebrocken zu generieren, die in einer Eingabeaufforderung noch relativ einfach zu angegeben sind.

Hier wird der „YOLO-Modus“ (You-Solely-Dwell-As soon as) verlockend, aber auch riskant. Karpathy merkt an, dass diese Modelle off-Observe gehen, unerwünschte Komplexität einführen oder einfach nur dumme Dinge tun können. Der Schlüssel ist nicht, im Yolo -Modus zu laufen. Seien Sie bereit, ESC häufig zu treffen. Hier geht es darum, die KI als Quick-Dracting-Device zu verwenden, nicht als perfekte, Palms-Off-Lösung. Sie müssen noch der Herausgeber und die endgültige Autorität sein.

Die Verwendung dieser Aspect-by-Aspect-Assistenten bringt seine eigenen Vor- und Nachteile.

Die Profis:

- Geschwindigkeit: Generiert schnell große Mengen an Code. Dies ist eine huge Zeitspanne für Boilerplate, sich wiederholende Aufgaben oder Code, die Sie nie anders schreiben würden.

- „Vibe-Coding“: Unschätzbar, wenn Sie in einer unbekannten Sprache oder einem Bereich arbeiten (z. B. Rost oder SQL). Die KI kann die Lücke in Ihrem Wissen überbrücken und es Ihnen ermöglichen, sich auf die Logik zu konzentrieren.

- Kurzlebiger Code: Dies ist das Herzstück der „Code nach dem Shortage-Ära“. Benötigen Sie eine 1000-Zeilen-Visualisierung, um ein einzelnes Drawback zu debuggen? Die KI kann es in Minuten erstellen. Sie verwenden es, Sie finden den Fehler, Sie löschen ihn. Keine Zeit verloren.

Die Nachteile:

- „Schlechter Geschmack“: Karpathy stellt fest, dass diesen Modellen oft ein Gefühl des „Codegeschmacks“ fehlt. Sie können übermäßig defensiv sein (zu viele Versuche/Fangen), Überkomplikationsabstraktionen oder doppelte Code überkomplizieren, anstatt Helferfunktionen zu erstellen. Ein endgültiger „Aufräumarbeiten“ ist quick immer notwendig.

- Arme Lehrer: Der Versuch, sie dazu zu bringen, Code zu erklären, während sie schreiben, ist oft eine frustrierende Erfahrung. Sie sind für die Technology gebaut, nicht für die Pädagogik.

- Überbinnend: Sie neigen dazu, ausreichend, wenn ein Einzeiler ausreichen würde, verschachtelte, wenn es sich um E-Else-Konstrukte handelt. Dies ist ein direktes Ergebnis ihrer Trainingsdaten und des Mangels an menschlicher Instinct.

Schicht 4: Die letzte Grenze

Wenn alle anderen Instruments versagen GPT-5 Professional. Dies ist die nukleare Possibility, die den härtesten und unlösbarsten Problemen vorbehalten ist. Dieses Device ist nicht zum Schreiben von Codeausschnitten oder Boilerplate. Es ist für eine tiefe, komplexe Problemlösung.

Im Kontext eines LLM -Workflows für Entwickler repräsentiert diese Schicht die Oberseite des Stapels – der Punkt, an dem die Rohmodellkraft strategisch und nicht routinemäßig angewendet wird. Hier kommen subtile Insektenjagd, tiefe Forschung und komplexe Argumentation ins Spiel. Karpathy beschreibt Fälle, in denen er, seine Registerkartenvervollständigung und sein Nebenseitigkeitsassistent zehn Minuten lang auf einem Fehler stecken, aber GPT-5 Professional, angesichts des gesamten Kontextes, kann zehn Minuten graben und ein wirklich subtiles, verstecktes Drawback finden.

Warum ist es der letzte Ausweg?

GPT-5 Professional und Fashions, die in der Liga sind, sind großartig, aber sie haben ihre eigenen Herausforderungen, von denen einige sind:

- Latenz: Es ist langsamer. Sie können es nicht für eine schnelle Echtzeit-Codierung verwenden. Sie müssen auf seine tiefe, umfassende Analyse warten.

- Umfang: Seine Kraft liegt in seiner Fähigkeit, einen massiven Kontext zu verstehen. Es kann „alle Arten von esoterischen Dokumenten und Papieren ausgraben“, was ein Einblick bietet, mit dem einfachere Modelle nicht übereinstimmen können.

- Strategischer Gebrauch: Dies ist kein täglicher Fahrer. Es ist eine strategische Waffe für ansonsten unmögliche Aufgaben, wie komplexe architektonische Reinigungsvorschläge oder eine vollständige Literaturübersicht zu einem bestimmten Codierungsansatz.

Der Workflow von Karpathy ist eine Meisterklasse in der strategischen Instrument. Es geht nicht darum, das perfekte Werkzeug zu finden, sondern darum, ein zusammenhängendes, vielschichtiges System zu erstellen. Jedes Device spielt eine bestimmte Rolle, eine bestimmte Zeit und einen bestimmten Zweck.

- Registerkarte Abschluss für Aufgaben mit hoher Bandbreite, im Second.

- Hervorhebung für fokussierte Refactoring und schnelle Modifikationen.

- Aspect-by-Aspect-Assistenten zur Erzeugung größerer Codebrocken und der Erkundung unbekannter Gebiets.

- Ein leistungsstarkes Modell auf dem neuesten Stand der Technik, um die wirklich unlösbaren Probleme zu debuggen und tiefe Forschung durchzuführen.

Dies ist die Zukunft der Arbeit für Führungskräfte, Studenten und Fachkräfte. Die Ära des einzelnen Toolhelden ist vorbei. Hier erwähnt Karpathy eindeutig eine neue Artwork von „Angst“, die sich mit vielen Entwicklern auseinandersetzt. Dies ist das Angst, nicht an der Grenze zu sein.

Es ist actual, aber die Lösung ist nicht, das nächste große Ding zu verfolgen. Die Lösung besteht darin, das Ökosystem zu verstehen, zu lernen, die Vor- und Nachteile verschiedener Werkzeuge zu „nähen“ und ein Orchesterdirigent zu werden, nicht nur zum einzigen Musiker.

Abschluss

Ihre Fähigkeit, in dieser neuen Ära zu gedeihen, wird nicht an den Codezeilen gemessen, die Sie schreiben, sondern an der Komplexität der Probleme, die Sie lösen, und die Geschwindigkeit, mit der Sie es tun. KI ist ein Werkzeug, aber Ihre menschliche Instinct, Ihr schmeckender Geschmack und Ihr strategisches Denken sind die geheimen Waffen. Es geht nicht darum, ein perfektes Werkzeug für alles zu finden. Es geht darum, die Anforderungen jeder Aufgabe zu verstehen. Für Entwickler bedeutet dies, einen LLM -Workflow aufzubauen, der ihre Fähigkeiten ergänzt: Erkennen Sie Ihren Komfort mit unterschiedlichen Instruments und das Erstellen eines Methods, das für Sie funktioniert. Karpathy hat seinen eigenen Workflow geteilt, aber Sie müssen einen testen, sich anpassen und an Ihrem einzigartigen Stil und Ihren einzigartigen Zielen übereinstimmen.

Sind Sie bereit, das perfekte Werkzeug nicht mehr zu verfolgen und den perfekten Workflow zu erstellen?

Melden Sie sich an, um weiter zu lesen und Experten-Kuratinhalte zu genießen.