Frage:

MoE-Modelle enthalten weitaus mehr Parameter als Transformers, können jedoch bei der Inferenz schneller ausgeführt werden. Wie ist das möglich?

Unterschied zwischen Transformers und Combination of Specialists (MoE)

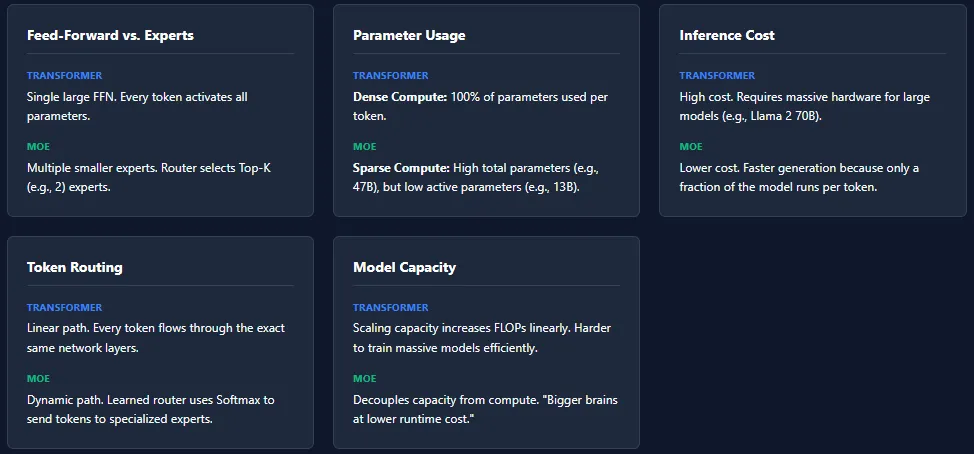

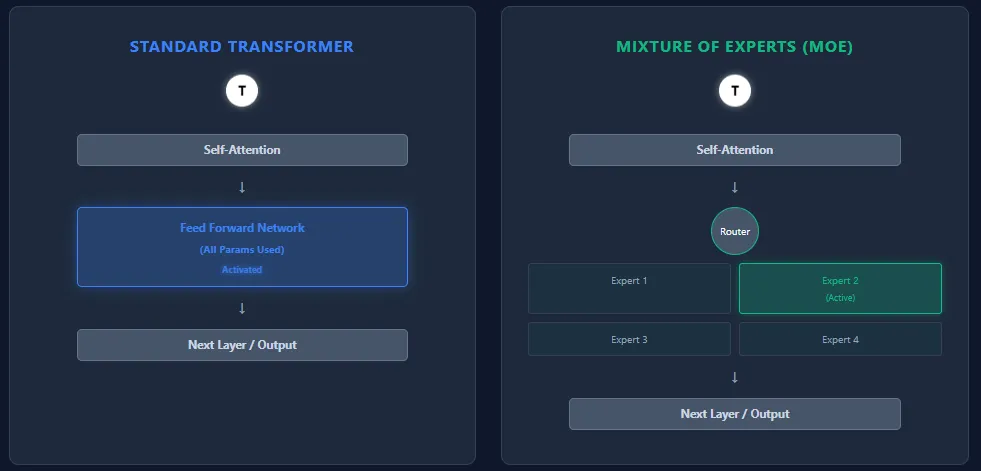

Transformers- und Combination of Specialists (MoE)-Modelle haben die gleiche Spine-Architektur – Selbstaufmerksamkeitsschichten, gefolgt von Feedforward-Schichten –, unterscheiden sich jedoch grundlegend in der Artwork und Weise, wie sie Parameter verwenden und berechnen.

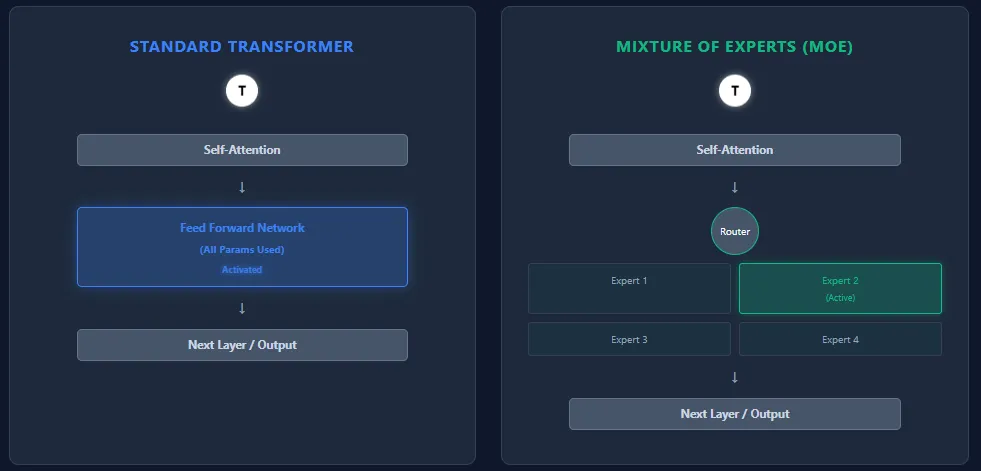

Feed-Ahead-Netzwerk vs. Experten

- Transformator: Jeder Block enthält ein einzelnes großes Feed-Ahead-Netzwerk (FFN). Jeder Token durchläuft dieses FFN und aktiviert alle Parameter während der Inferenz.

- MoE: Ersetzt das FFN durch mehrere kleinere Feed-Ahead-Netzwerke, sogenannte Experten. Ein Routing-Netzwerk wählt nur wenige Experten (High-Okay) professional Token aus, sodass nur ein kleiner Bruchteil der Gesamtparameter aktiv ist.

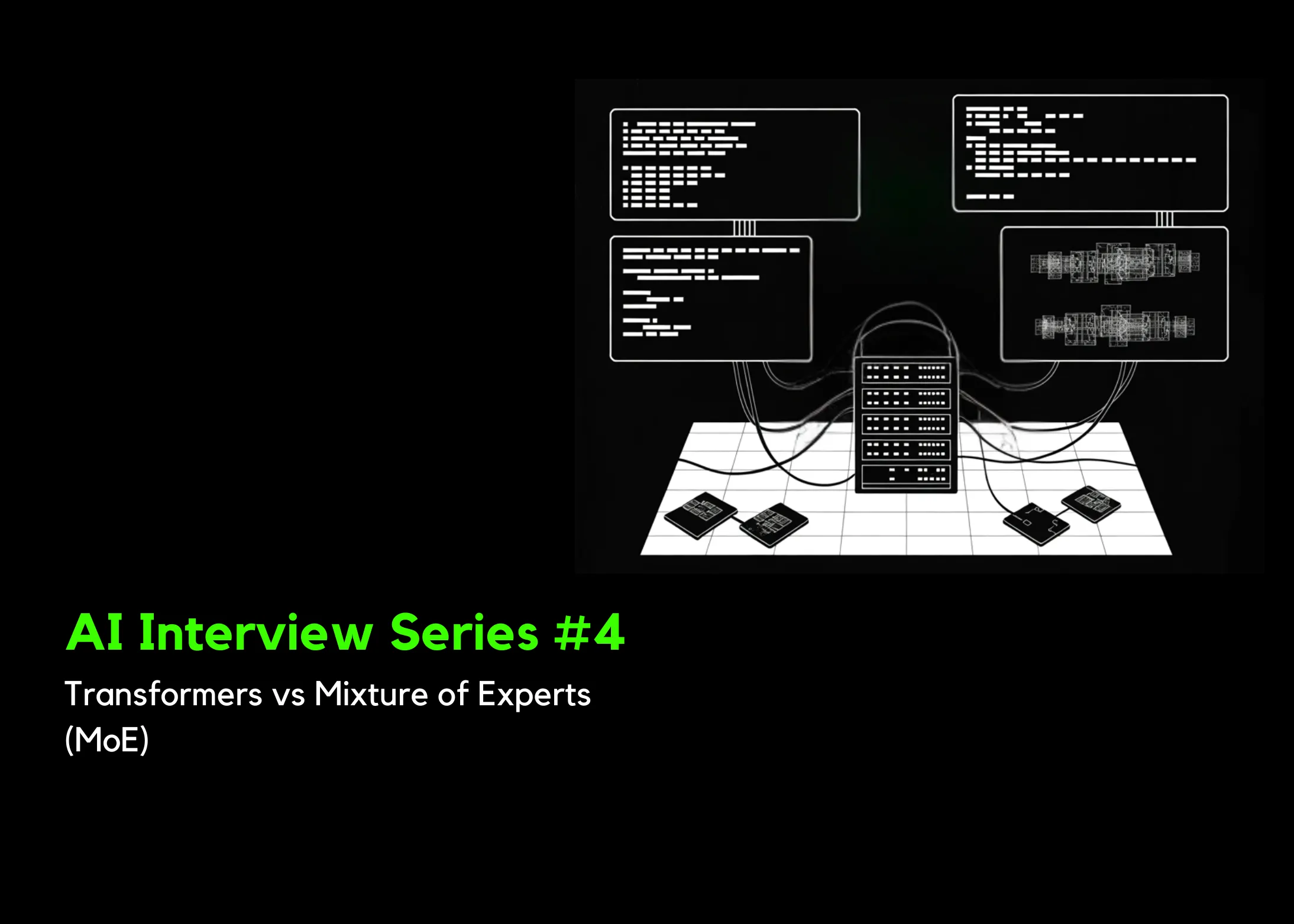

Parameterverwendung

- Transformator: Alle Parameter über alle Schichten hinweg werden für jedes Token → Dense Compute verwendet.

- MoE: Verfügt über mehr Gesamtparameter, aktiviert aber nur einen kleinen Teil professional Token → spärliche Berechnung. Beispiel: Mixtral 8×7B hat insgesamt 46,7B Parameter, verwendet aber nur ~13B professional Token.

Inferenzkosten

- Transformator: Hohe Inferenzkosten aufgrund der vollständigen Parameteraktivierung. Die Skalierung auf Modelle wie GPT-4 oder Llama 2 70B erfordert leistungsstarke {Hardware}.

- MoE: Niedrigere Inferenzkosten, da nur Okay Experten professional Schicht aktiv sind. Dies macht den Betrieb von MoE-Modellen schneller und kostengünstiger, insbesondere im großen Maßstab.

Token-Routing

- Transformator: Kein Routing. Jeder Token folgt dem exakt gleichen Weg durch alle Schichten.

- MoE: Ein erlernter Router weist Experten basierend auf Softmax-Scores Token zu. Verschiedene Token wählen unterschiedliche Experten aus. Verschiedene Ebenen können unterschiedliche Experten aktivieren, was die Spezialisierung und Modellkapazität erhöht.

Modellkapazität

- Transformator: Um die Kapazität zu skalieren, besteht die einzige Möglichkeit darin, weitere Schichten hinzuzufügen oder das FFN zu erweitern – beides erhöht die FLOPs erheblich.

- MoE: Kann die Gesamtparameter massiv skalieren, ohne die Rechenleistung professional Token zu erhöhen. Dies ermöglicht „größere Gehirne bei geringeren Laufzeitkosten“.

Während MoE-Architekturen eine enorme Kapazität bei geringeren Inferenzkosten bieten, bringen sie mehrere Herausforderungen für die Schulung mit sich. Das häufigste Drawback ist der Zusammenbruch von Experten, bei dem der Router wiederholt dieselben Experten auswählt und andere nicht ausreichend geschult sind.

Ein Lastungleichgewicht ist eine weitere Herausforderung – einige Experten erhalten möglicherweise weit mehr Token als andere, was zu ungleichmäßigem Lernen führt. Um dieses Drawback anzugehen, stützen sich MoE-Modelle auf Techniken wie Rauscheinspeisung beim Routing, High-Okay-Maskierung und Expertenkapazitätsgrenzen.

Diese Mechanismen stellen sicher, dass alle Experten aktiv und ausgeglichen bleiben, machen aber auch das Coaching von MoE-Systemen im Vergleich zu Customary-Transformern komplexer.