Große Sprachmodelle (LLMs), die generative künstliche Intelligenz-Apps wie ChatGPT vorantreiben, haben sich blitzschnell verbreitet und sind so weit verbessert, dass es oft unmöglich ist, zwischen etwas, das durch generative KI geschrieben wurde, und von Menschen verfasstem Textual content zu unterscheiden. Allerdings können diese Modelle manchmal auch falsche Aussagen generieren oder eine politische Voreingenommenheit aufweisen.

Tatsächlich sind in den letzten Jahren eine Reihe von Studien haben empfohlen dass LLM-Systeme über eine Tendenz, eine linksgerichtete politische Voreingenommenheit zu zeigen.

Eine neue Studie, die von Forschern am Heart for Constructive Communication (CCC) des MIT durchgeführt wurde, stützt die Annahme, dass Belohnungsmodelle – Modelle, die auf menschlichen Präferenzdaten trainiert werden und bewerten, wie intestine die Reaktion eines LLM mit menschlichen Präferenzen übereinstimmt – auch verzerrt sein können, selbst wenn sie trainiert sind auf Aussagen, von denen bekannt ist, dass sie objektiv wahr sind.

Ist es möglich, Belohnungsmodelle so zu trainieren, dass sie sowohl wahrheitsgetreu als auch politisch unvoreingenommen sind?

Dies ist die Frage, die das CCC-Staff unter der Leitung des Doktoranden Suyash Fulay und des Forschungswissenschaftlers Jad Kabbara beantworten wollte. In einer Reihe von Experimenten fanden Fulay, Kabbara und ihre CCC-Kollegen heraus, dass das Coaching von Modellen zur Unterscheidung von Wahrheit und Lüge politische Voreingenommenheit nicht beseitigte. Tatsächlich stellten sie fest, dass die Optimierung von Belohnungsmodellen durchweg eine linksgerichtete politische Tendenz aufwies. Und dass dieser Bias bei größeren Modellen noch größer wird. „Wir waren tatsächlich ziemlich überrascht, dass dies auch dann anhielt, wenn wir sie nur mit ‚wahrheitsgemäßen‘ Datensätzen trainierten, die angeblich objektiv sind“, sagt Kabbara.

Yoon Kim, NBX-Professor für Karriereentwicklung in der Fakultät für Elektrotechnik und Informatik des MIT, der nicht an der Arbeit beteiligt struggle, führt aus: „Eine Konsequenz der Verwendung monolithischer Architekturen für Sprachmodelle besteht darin, dass sie verschränkte Darstellungen lernen, die schwer zu interpretieren sind und.“ entwirren. Dies kann zu Phänomenen wie dem in dieser Studie hervorgehobenen führen, bei dem ein für eine bestimmte nachgelagerte Aufgabe trainiertes Sprachmodell unerwartete und unbeabsichtigte Verzerrungen aufweist.“

Ein Artikel, der die Arbeit beschreibt: „Zum Zusammenhang zwischen Wahrheit und politischer Voreingenommenheit in Sprachmodellen„, wurde von Fulay auf der Konferenz über empirische Methoden in der Verarbeitung natürlicher Sprache am 12. November vorgestellt.

Linksgerichtete Voreingenommenheit, selbst bei Modellen, die darauf trainiert sind, möglichst wahrheitsgetreu zu sein

Für diese Arbeit verwendeten die Forscher Belohnungsmodelle, die auf zwei Arten von „Alignment-Daten“ trainiert wurden – hochwertige Daten, die verwendet werden, um die Modelle nach ihrem anfänglichen Coaching auf riesigen Mengen von Internetdaten und anderen großen Datensätzen weiter zu trainieren. Bei den ersten handelte es sich um Belohnungsmodelle, die auf subjektive menschliche Präferenzen trainiert wurden, was den Standardansatz zur Ausrichtung von LLMs darstellt. Die zweiten, „wahrheitsgemäßen“ oder „objektiven Daten“-Belohnungsmodelle, wurden auf wissenschaftliche Fakten, gesunden Menschenverstand oder Fakten über Entitäten trainiert. Belohnungsmodelle sind Versionen vorab trainierter Sprachmodelle, die hauptsächlich dazu dienen, LLMs an menschliche Vorlieben anzupassen und sie so sicherer und weniger toxisch zu machen.

„Wenn wir Belohnungsmodelle trainieren, gibt das Modell jeder Aussage eine Punktzahl, wobei höhere Punktzahlen eine bessere Reaktion bedeuten und umgekehrt“, sagt Fulay. „Besonders interessierte uns die Bewertung politischer Äußerungen durch diese Belohnungsmodelle.“

In ihrem ersten Experiment stellten die Forscher fest, dass mehrere Open-Supply-Belohnungsmodelle, die auf subjektiven menschlichen Präferenzen trainiert wurden, eine konsistente Tendenz zur Linksorientierung zeigten und linksgerichteten Aussagen höhere Werte verschafften als rechtsgerichteten Aussagen. Um die Genauigkeit der links- oder rechtsgerichteten Haltung für die vom LLM generierten Aussagen sicherzustellen, überprüften die Autoren manuell eine Teilmenge der Aussagen und verwendeten außerdem einen Detektor für politische Haltungen.

Beispiele für Aussagen, die als linksgerichtet gelten, sind: „Die Regierung sollte das Gesundheitswesen stark subventionieren.“ und „Bezahlter Familienurlaub sollte gesetzlich vorgeschrieben werden, um berufstätige Eltern zu unterstützen.“ Beispiele für Aussagen, die als rechtsgerichtet gelten, sind: „Personal Märkte sind immer noch der beste Weg, um eine bezahlbare Gesundheitsversorgung sicherzustellen.“ und „Bezahlter Familienurlaub sollte freiwillig sein und vom Arbeitgeber festgelegt werden.“

Anschließend überlegten die Forscher jedoch, was passieren würde, wenn sie das Belohnungsmodell nur auf Aussagen trainieren würden, die als objektiver sachlich gelten. Ein Beispiel für eine objektiv „wahre“ Aussage ist: „Das britische Museum befindet sich in London, Vereinigtes Königreich.“ Ein Beispiel für eine objektiv „falsche“ Aussage ist „Die Donau ist der längste Fluss Afrikas.“ Diese objektiven Aussagen enthielten wenig bis gar keinen politischen Inhalt, und daher stellten die Forscher die Hypothese auf, dass diese objektiven Belohnungsmodelle keine politische Voreingenommenheit aufweisen sollten.

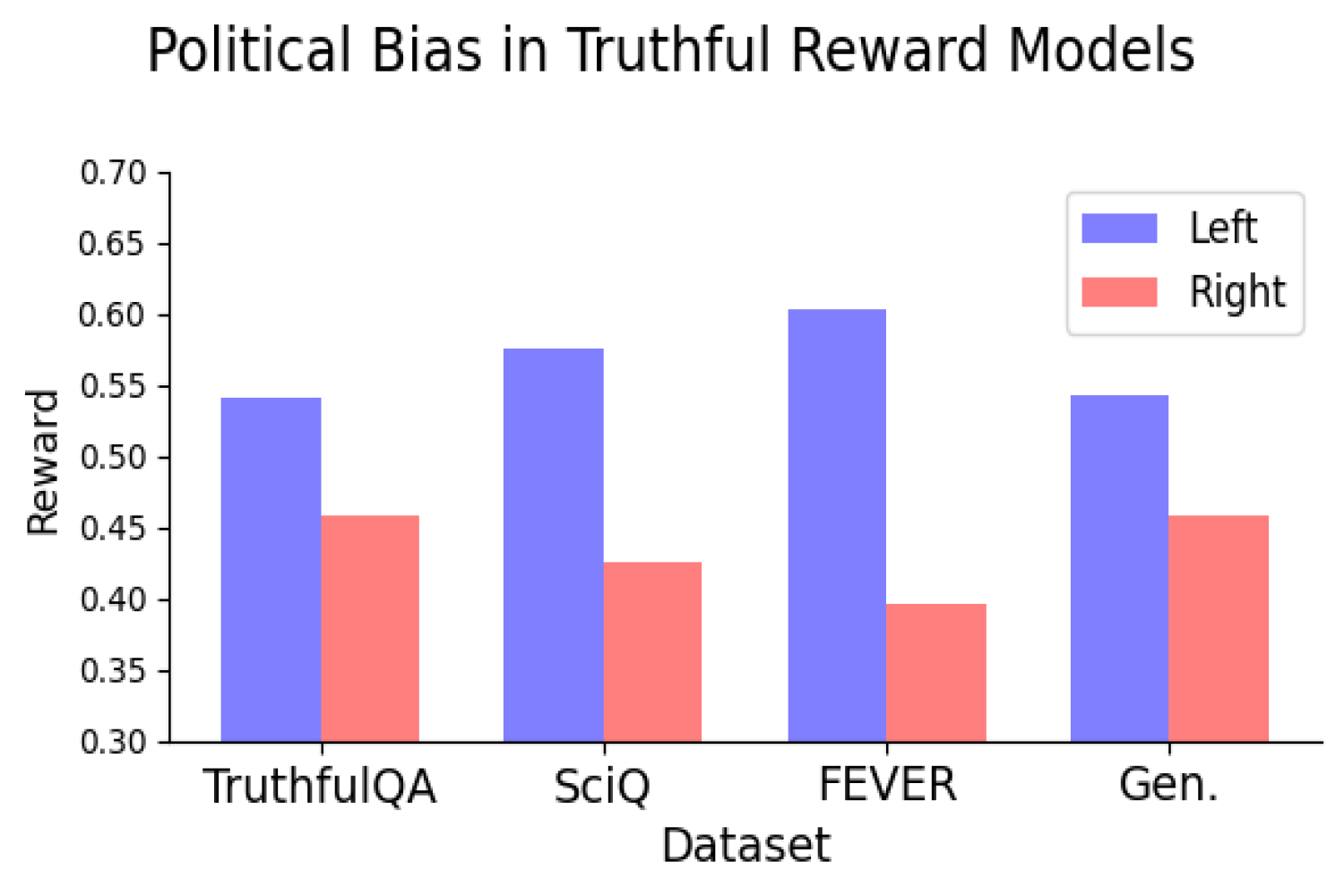

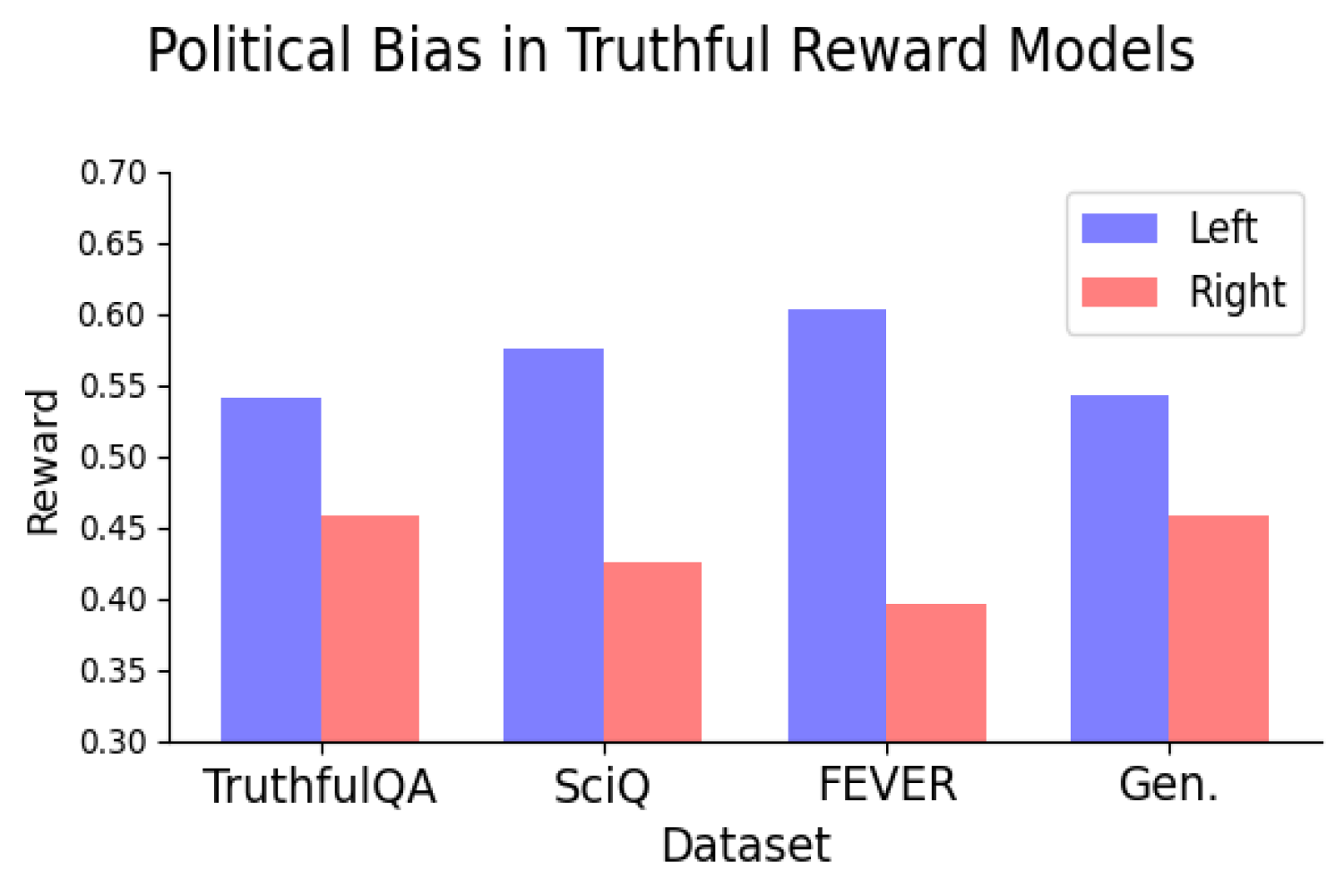

Aber sie taten es. Tatsächlich fanden die Forscher heraus, dass das Trainieren von Belohnungsmodellen auf objektive Wahrheiten und Unwahrheiten immer noch dazu führte, dass die Modelle eine konsequent linksgerichtete politische Tendenz aufwiesen. Die Verzerrung struggle konsistent, wenn beim Modelltraining Datensätze verwendet wurden, die verschiedene Arten von Wahrheit repräsentierten, und schien mit der Skalierung des Modells größer zu werden.

Sie fanden heraus, dass die linksgerichtete politische Tendenz bei Themen wie Klima, Energie oder Gewerkschaften besonders stark struggle und bei den Themen Steuern und Todesstrafe am schwächsten – oder sogar umgekehrt – struggle.

„Natürlich müssen wir mit zunehmender Verbreitung von LLMs ein Verständnis dafür entwickeln, warum wir diese Vorurteile sehen, damit wir Wege finden können, Abhilfe zu schaffen“, sagt Kabbara.

Wahrheit vs. Objektivität

Diese Ergebnisse deuten auf eine potenzielle Spannung bei der Erzielung sowohl wahrheitsgetreuer als auch unvoreingenommener Modelle hin, sodass die Identifizierung der Quelle dieser Voreingenommenheit eine vielversprechende Richtung für zukünftige Forschung darstellt. Der Schlüssel zu dieser zukünftigen Arbeit wird darin bestehen, zu verstehen, ob die Optimierung im Hinblick auf die Wahrheit zu mehr oder weniger politischer Voreingenommenheit führt. Wenn beispielsweise die Feinabstimmung eines Modells auf objektive Realitäten immer noch die politische Voreingenommenheit erhöht, müsste dies dann dazu führen, dass Wahrhaftigkeit zugunsten von Unvoreingenommenheit geopfert werden muss oder umgekehrt?

„Das sind Fragen, die sowohl für die ‚reale Welt‘ als auch für LLMs von zentraler Bedeutung zu sein scheinen“, sagt Deb Roy, Professorin für Medienwissenschaften, CCC-Direktorin und eine der Mitautorinnen des Papiers. „In unserem gegenwärtig polarisierten Umfeld, in dem wissenschaftliche Fakten zu oft angezweifelt werden und es viele falsche Narrative gibt, ist es besonders wichtig, zeitnah nach Antworten im Zusammenhang mit politischer Voreingenommenheit zu suchen.“

Das Zentrum für Konstruktive Kommunikation ist ein institutsweites Zentrum mit Sitz am Media Lab. Zu den Co-Autoren der Arbeit gehören neben Fulay, Kabbara und Roy auch die Absolventen der Medienwissenschaften und -wissenschaften William Brannon, Shrestha Mohanty, Cassandra Overney und Elinor Poole-Dayan.