Das Warten ist vorbei: Grok 3 API ist raus und es schüttelt bereits die Welt der KI mit seiner “aufbeängstigend clever„Argumentation, Echtzeit-Webfunktionen und erstklassige Leistung bei Codierung und STEM-Benchmarks. Egal, ob Sie Entwickler, Forscher oder KI-Fanatic sind, ist jetzt der perfekte Zeitpunkt, um auf die GROK 3-API zuzugreifen und erkunden Sie, was es kann. In diesem Weblog erfahren Sie, wie Sie auf GROK 3 -API zugreifen, Ihre Anmeldeinformationen sicher authentifizieren und mit Python eine Verbindung zu GROK 3 -API herstellen. Wir werden auch praktische Anwendungsfälle durchgehen, von der GROK 3 -API -Integration in Ihre Workflows bis hin zur Verwendung von GROK 3 -API für Datenab Abruf und erweiterte Argumentationsaufgaben.

Schlüsselmerkmale von GROK 3

GROK 3 führt mehrere bahnbrechende Funktionen ein, die seine Leistung und Anwendbarkeit in verschiedenen Bereichen verbessern:

- Erweiterte Argumentationsmodi: GROK 3 bietet spezielle Argumentationsmodi an, einschließlich „Denken“ für schrittweise Problemlösungen und „Large Mind“ für die Bekämpfung komplexer Aufgaben. Diese Modi ermöglichen es dem Modell, Informationen tiefer zu verarbeiten und genaue Antworten zu liefern.

- DeepSearch -Funktionalität: Das Modell enthält DeepSearch, einen KI -Agenten, der das Web und X (ehemals Twitter) in Echtzeit scannt, um umfassende Berichte zu bestimmten Themen zu generieren. Diese Funktion stellt sicher, dass die Antworten von GROK 3 aktuell und intestine informiert sind.

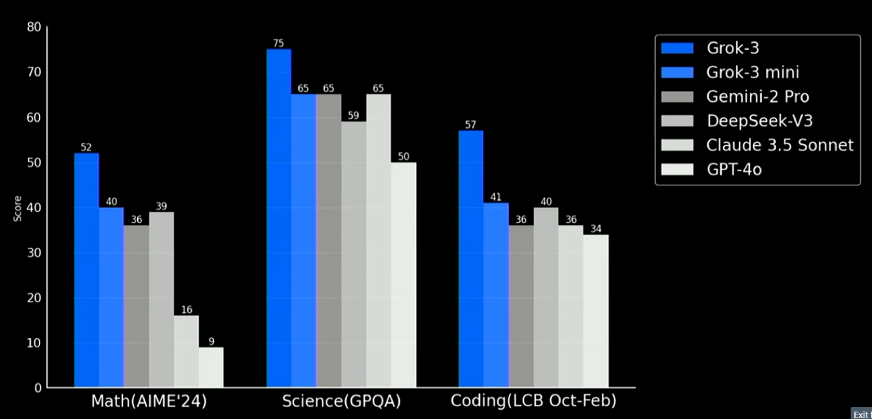

- Verbesserte Leistungsbenchmarks: GROK 3 hat eine außergewöhnliche Leistung gezeigt und 93,3% für die 2025 American Invitational Arithmetic Examination (AIMe) bewertet und eine ELO -Punktzahl von 1402 in der Chatbot -Area erzielt, was auf die Dominanz in den STEM -Feldern hinweist.

- Echtzeitdatenintegration: Im Gegensatz zu statischen KI-Modellen integriert GROK 3 Echtzeitdaten aus den Net- und X-Posts, um sicherzustellen, dass die Antworten aktuell und related sind.

- Multimodal cEigenschaften: Das Modell kann Textual content, Bilder und Code generieren und generieren und seine Anwendbarkeit über verschiedene Domänen hinweg erweitern.

Diese Merkmale Place GROK 3 als signifikanter Fortschritt in KI -Sprachmodellen. Es bietet verbesserte Argumentation, Echtzeitdatenverarbeitung und ein breites Spektrum von Funktionen, um den verschiedenen Benutzeranforderungen gerecht zu werden.

Lesen Sie auch: 5 Grok 3 Eingabeaufforderungen, die Ihre Arbeit erleichtern können

Preis- und Modellspezifikationen

XAI hat mehrere Varianten der GROK-3-Modellreihe eingeführt. Jedes für unterschiedliche Leistungsniveaus und Kosteneffizienz. Diese Modelle richten sich an Entwickler, Forscher und Organisationen, abhängig von ihren Rechen- und Argumentationsanforderungen.

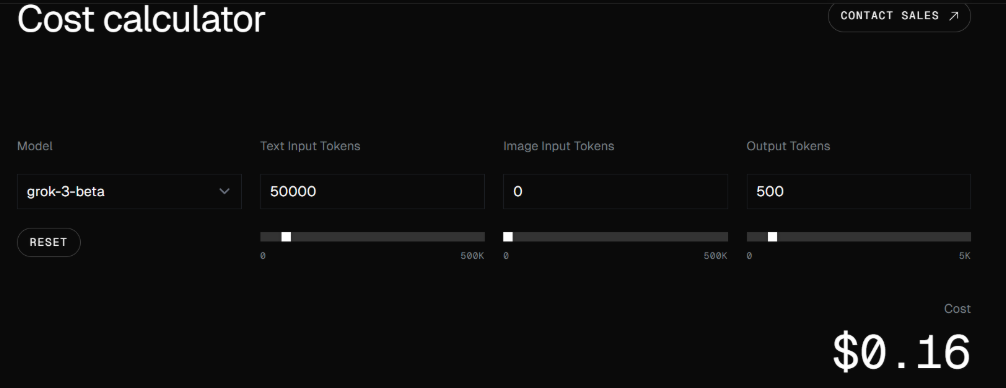

Professional -Tipp: Verwenden Sie den Kostenrechner von XAI, bevor Sie die API anrufen

Bevor Sie mehrere API-Anrufe tätigen, bietet XAI für jedes ihrer Modelle einen tremendous praktischen Kostenrechner an, einschließlich GROK-3-Beta, GROK-3-Spast-Beta und den Mini-Varianten.

Sie können es direkt finden https://x.ai/api (Scrollen Sie einfach ein bisschen nach unten).

Sie können anpassen:

- Texteingangs -Token

- Bildeingangs -Token

- Ausgangstoken

Dieses Software bietet Ihnen einen Echtzeit-Kostenschätzung, sodass Sie Ihre Nutzung effizient planen und eine unerwartete Abrechnung vermeiden können. Beispiel $ 0,16 (Wie im vorherigen Screenshot zu sehen).

Good Dev Tipp: Verwenden Sie diesen Taschenrechner häufig, um Ihre API -Strategie zu optimieren, insbesondere bei Skalieren oder Umgang mit großen Nutzlasten.

Wie kann ich auf die API zugreifen?

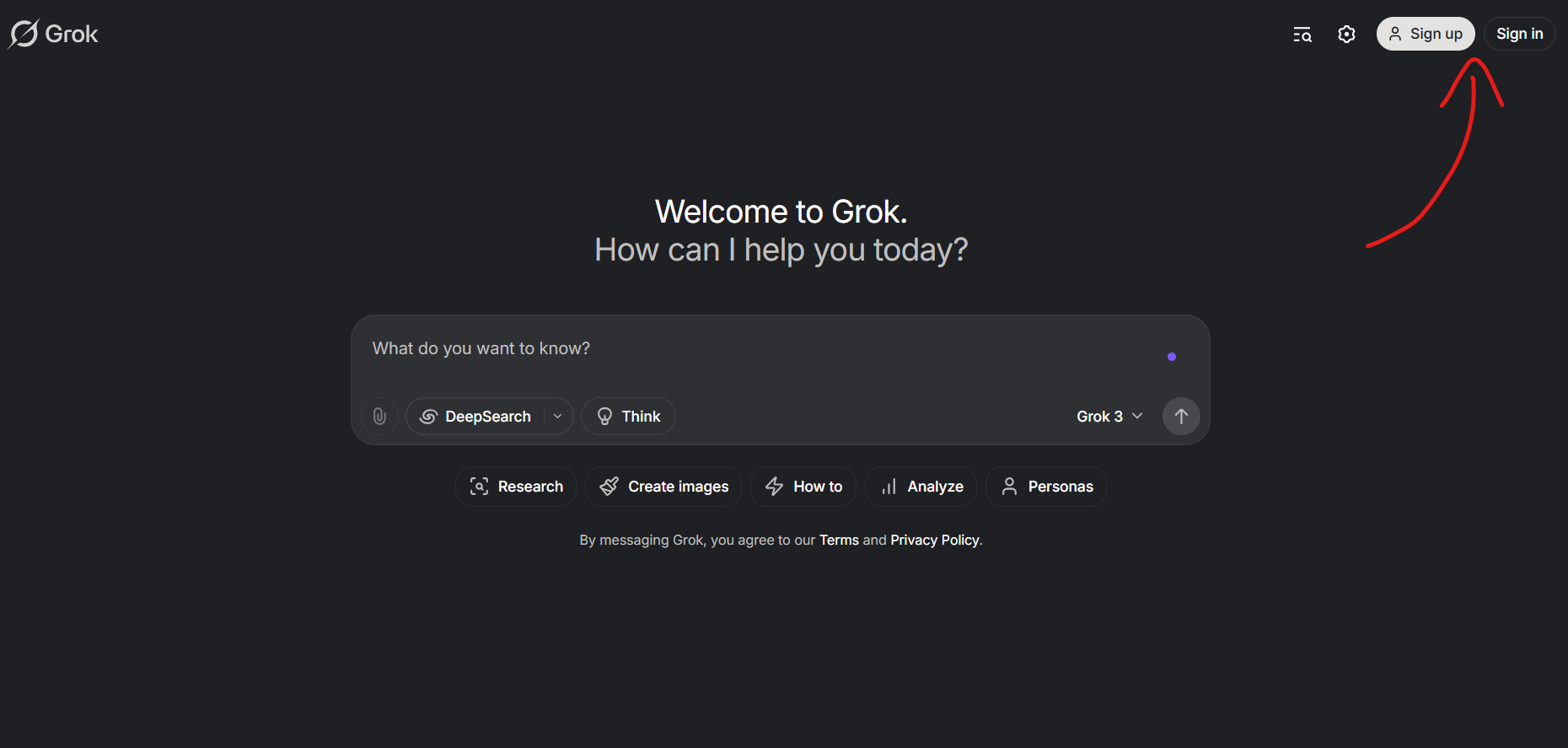

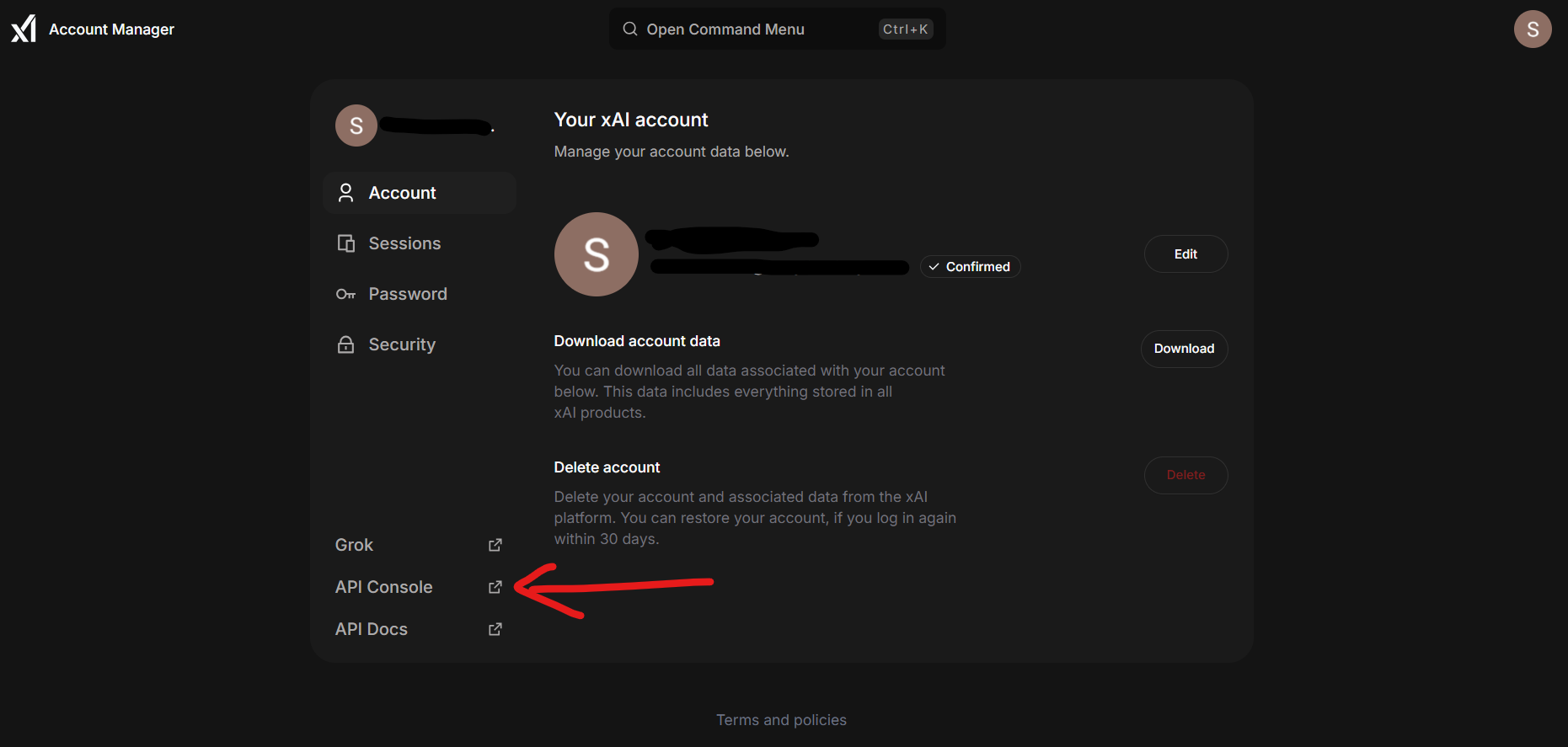

1. Besuch grok.com und melden Sie sich mit Ihren Kontoanmeldeinformationen an.

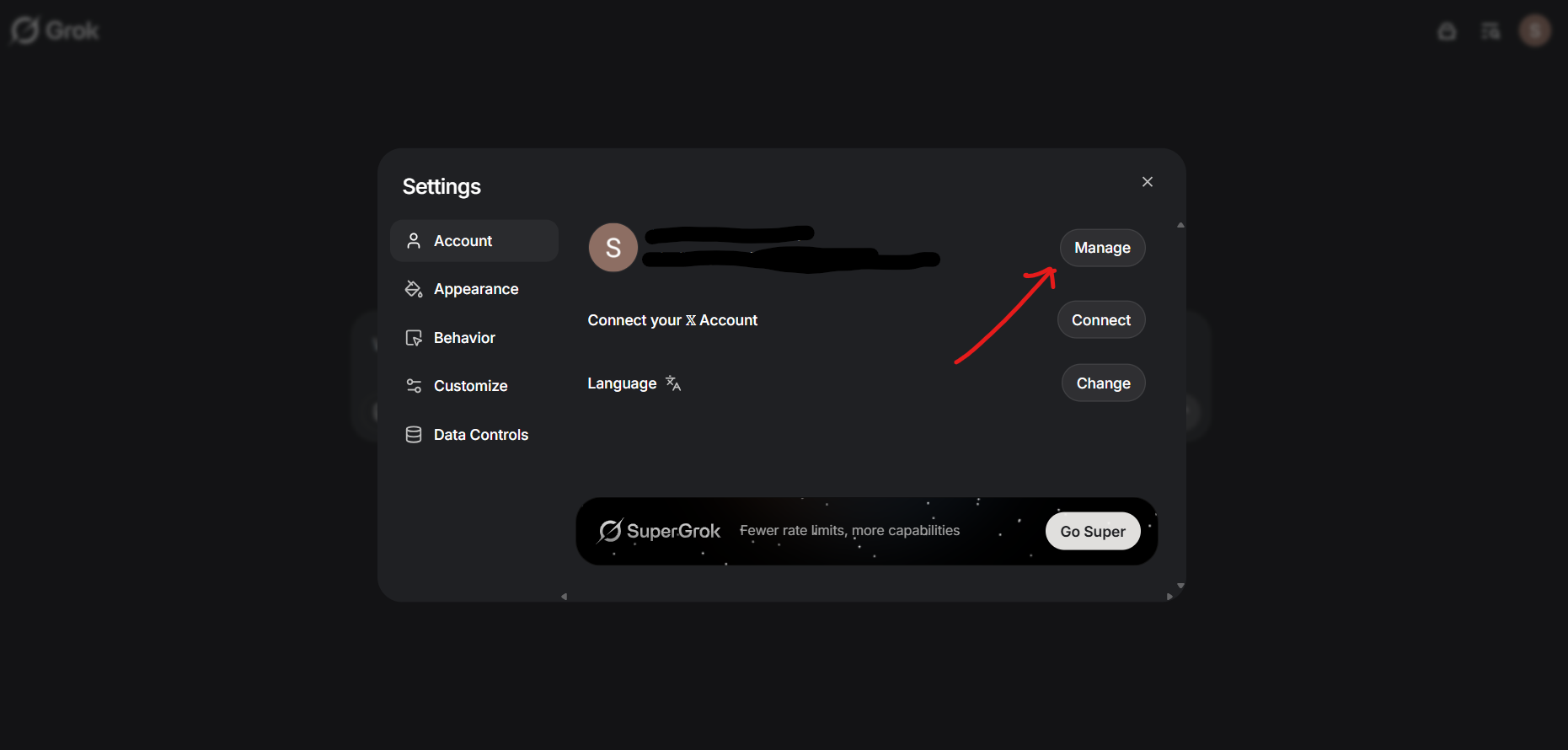

2. Klicken Sie in der oberen rechten Ecke auf Ihr Profil-Avatar, wählen Sie Einstellungenund dann auswählen Verwalten. Sie werden auf die XAI -Kontenseite umgeleitet.

3. Navigieren Sie auf der XAI -Accounts -Seite zu der API -Konsole.

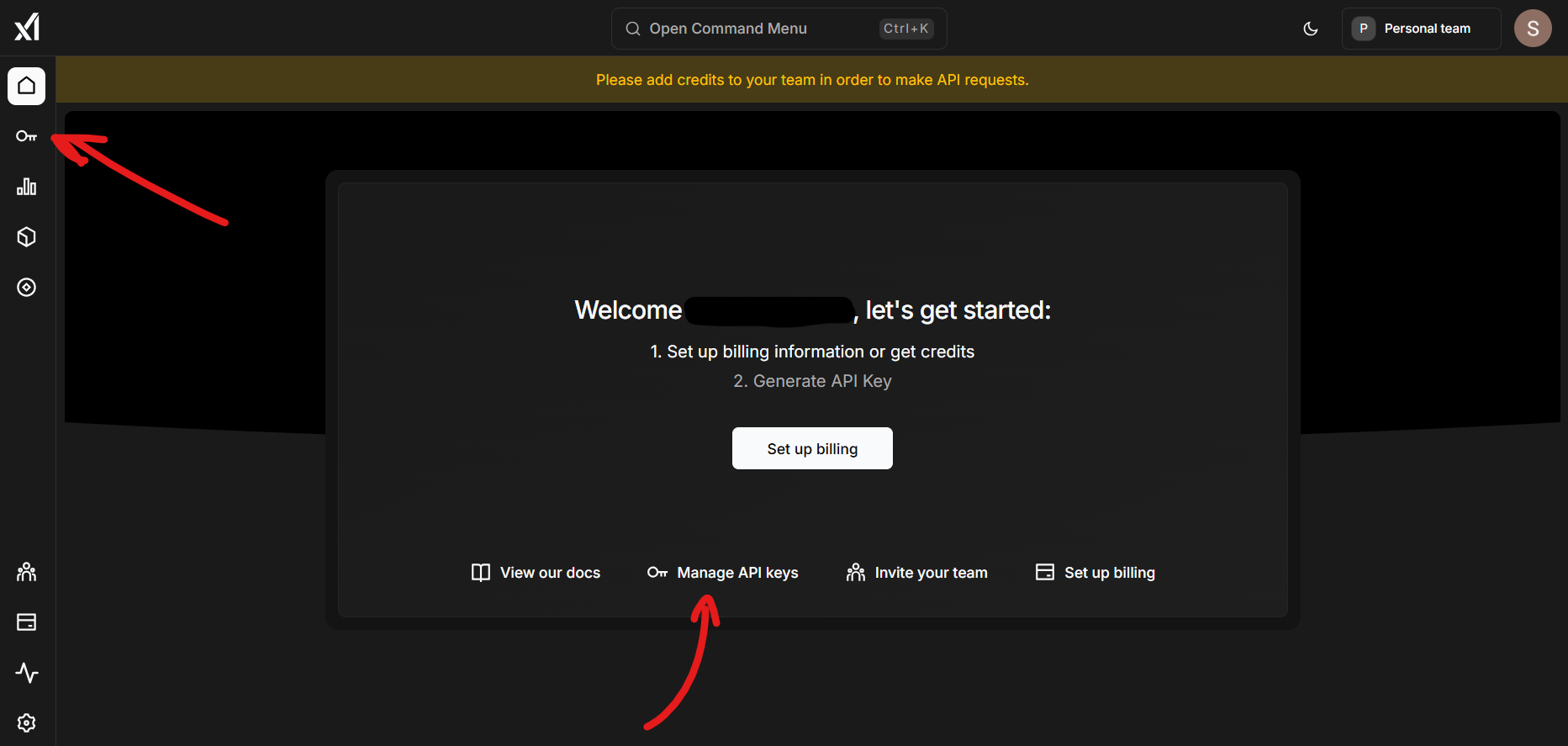

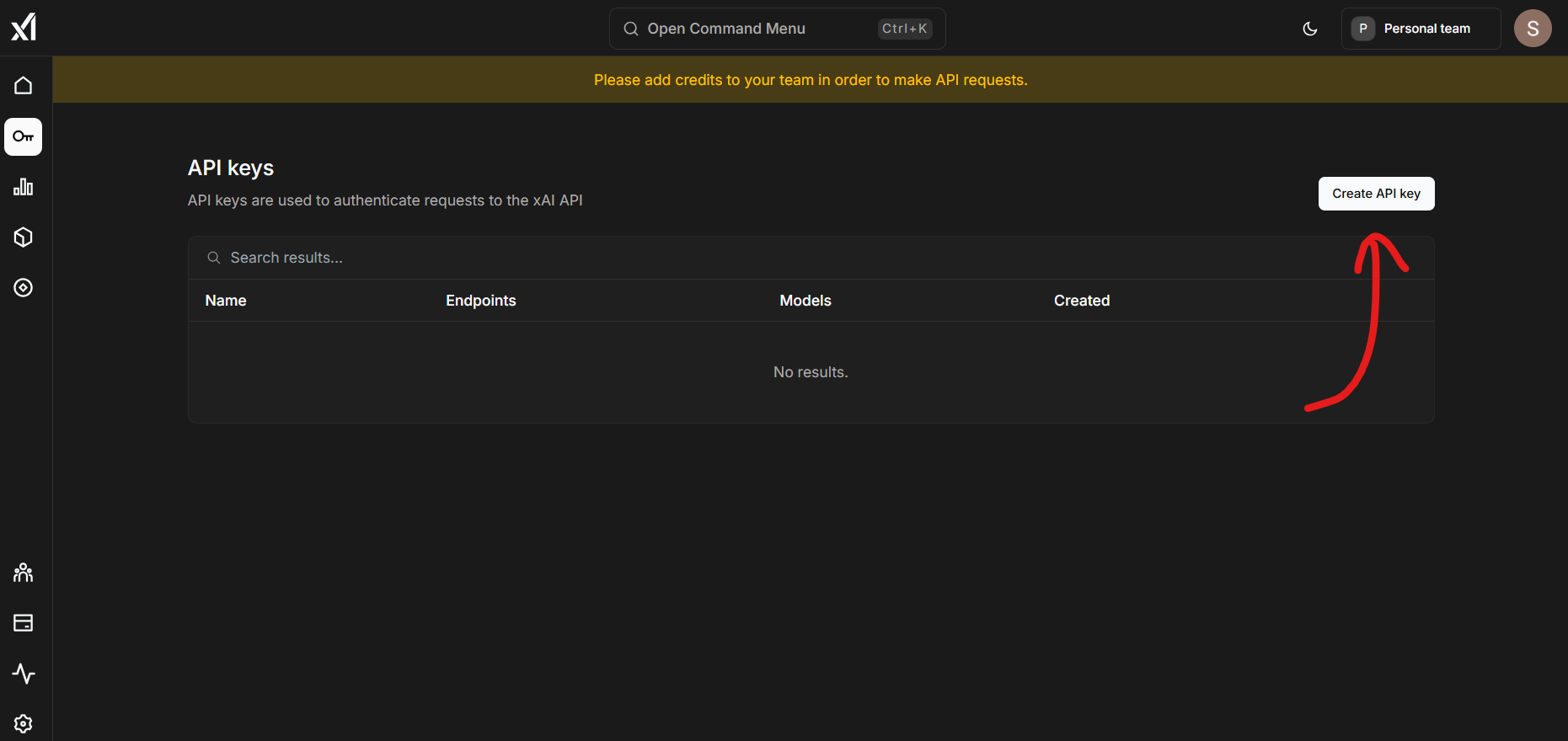

4. Klicken Sie in der linken Seitenleiste der API-Konsole auf das Schlüsselsymbol, um Ihre GROK-API-Style anzuzeigen und zu kopieren.

Voila, da hast du deinen API -Schlüssel! Stellen Sie sicher, dass Sie es sorgfältig und sicher aufbewahren.

Implementierung von Grok 3

Grundlegende Implementierungen

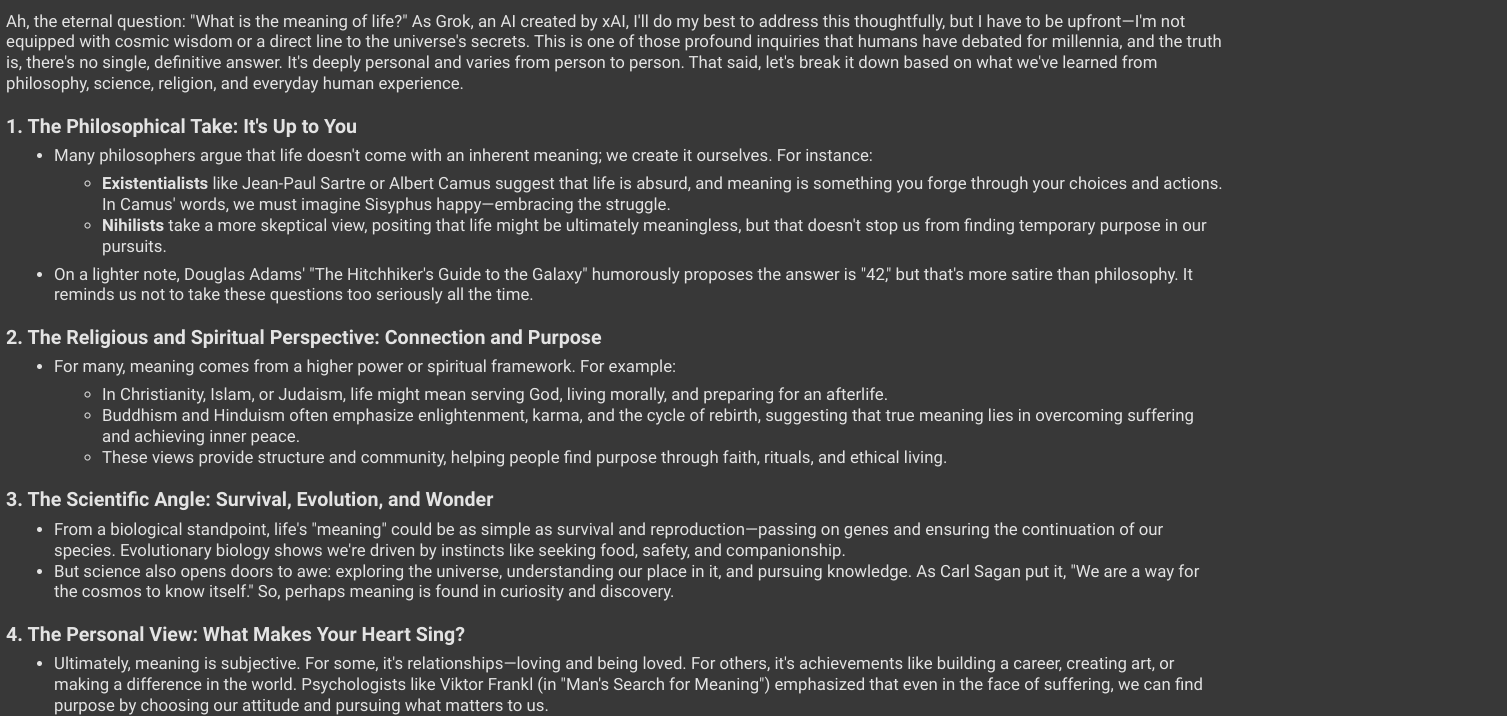

Versuchen wir zu überprüfen, ob unser GROK 3 -Modell mit diesem Code -Snippet reagieren kann, das in der Dokumentation von GROK XAI enthalten ist.

!pip set up openai

import os

os.environ('GROK_API_KEY') = "xai-..." # your individual api key

from IPython.show import Markdown

from openai import OpenAI

shopper = OpenAI(

api_key=os.getenv("GROK_API_KEY"),

base_url="https://api.x.ai/v1",

)

completion = shopper.chat.completions.create(

mannequin="grok-3-mini-beta",

messages=(

{"position": "person", "content material": "What's the that means of life?"}

)

)

Markdown(completion.decisions(0).message.content material)Ausgabe:

Testen wir nun das GROK 3-Modell für:-

- Codegenerierung

- Argumentationsfähigkeiten

- Komplexe Anwendungsfälle

- Wissenschaftliches Forschungsverständnis

Fühlen Sie sich frei, andere GROK 3-Varianten (z. B. GROK-3-Beta, GROK-3-Spast-Beta) auszutauschen, oder stellen Sie Ihre Eingabeaufforderungen an. Vergleichen Sie dann die Ausgänge direkt in Ihrem Pocket book oder Skript.

Für die folgenden Implementierungen werden wir nutzen

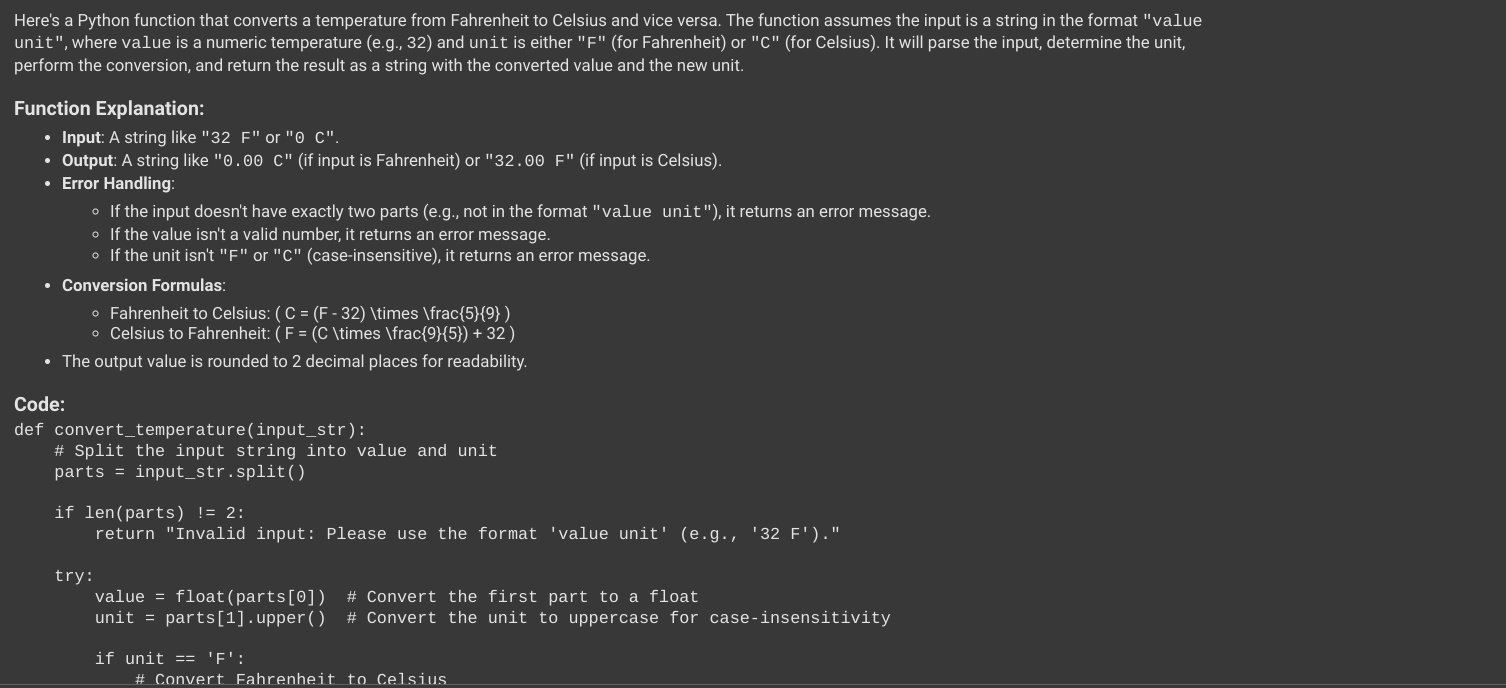

Codegenerierung

1. Verwenden wir das GROK 3 -Modell, um Code zum Konvertieren der Fahrenheit in die Skala von Celsius zu generieren und umgekehrt.

immediate = """

Write a Python perform that converts a temperature from Fahrenheit to Celsius and vice versa.

The perform ought to take an enter, decide the kind (Fahrenheit or Celsius), and return the transformed temperature.

"""

shopper = OpenAI(

api_key=os.getenv("GROK_API_KEY"),

base_url="https://api.x.ai/v1",

)

response = shopper.chat.completions.create(

mannequin="grok-3-mini-beta",

messages=(

{

"position": "person",

"content material": immediate

}

)

)

# Output the generated Python code

print(response.decisions(0).message.content material)

Markdown(response.decisions(0).message.content material)Ausgabe:

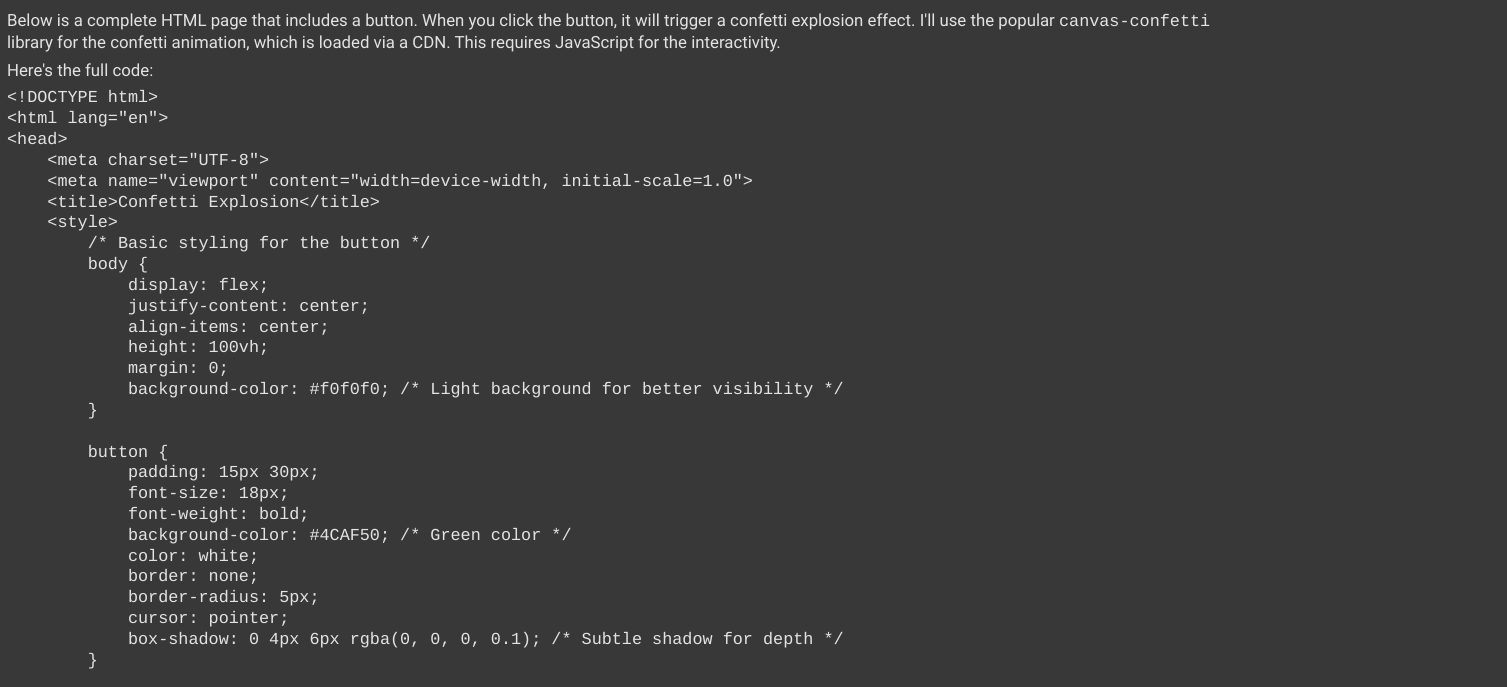

2. Lassen Sie uns das GROK 3 -Modell mit einer Schaltfläche generieren, die beim Klicken die Seite mit Konfetti duschen sollte.

immediate = """Create an HTML web page with a button that explodes confetti whenever you click on it.

You need to use CSS & JS as nicely."""

shopper = OpenAI(

api_key=os.getenv("GROK_API_KEY"),

base_url="https://api.x.ai/v1",

)

response = shopper.chat.completions.create(

mannequin="grok-3-mini-beta",

messages=(

{

"position": "person",

"content material": immediate

}

)

)

# Output the generated Python code

print(response.decisions(0).message.content material)

Markdown(response.decisions(0).message.content material)Ausgabe:

Um die Funktionalität dieses Codes zu testen, werde ich verwenden Codepen Um den HTML -Code zu testen.

So sieht es aus:

Lesen Sie auch: Grok 3 gegen Deepseek R1: Was ist besser?

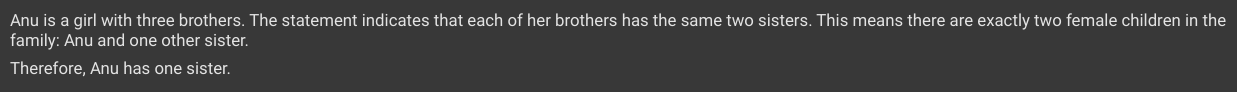

Argumentationsfähigkeiten

1. Versuchen wir das Testen des GROK 3 -Modells mit dieser allgemeinen Frage der Anerkennung

immediate = """Anu is a woman. She has three brothers. Every of her brothers has the identical two sisters.

What number of sisters does Anu have?"""

shopper = OpenAI(

api_key=os.getenv("GROK_API_KEY"),

base_url="https://api.x.ai/v1",

)

response = shopper.chat.completions.create(

mannequin="grok-3-mini-beta",

messages=(

{

"position": "person",

"content material": immediate

}

)

)

# Output the generated Python code

print(response.decisions(0).message.content material)

Markdown(response.decisions(0).message.content material)Ausgabe:

Die Antwort wurde verifiziert, korrekt zu sein.

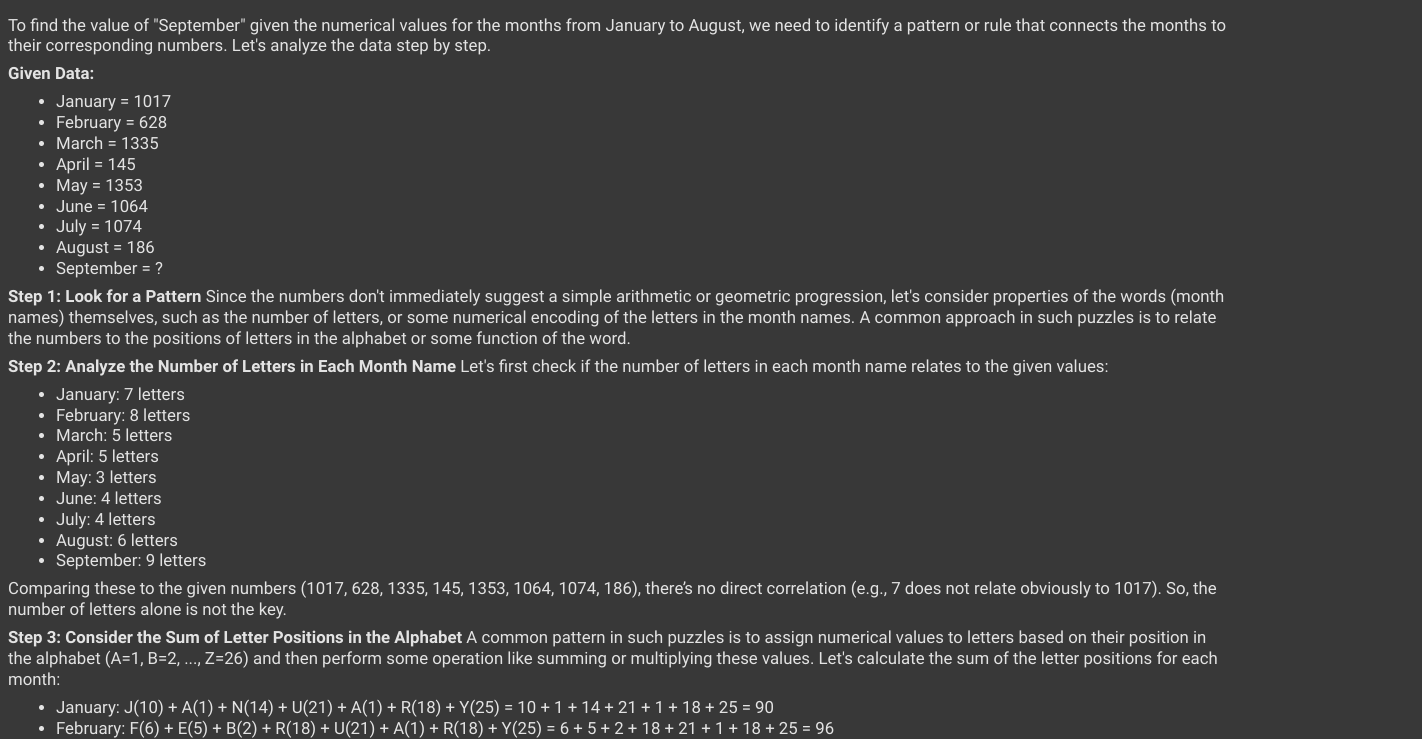

2. Lassen Sie uns die Mustererkennungsfunktionen von GROK 3 testen, indem wir dieses Datum basierende Musterproblem bereitstellen

immediate = """January = 1017, February = 628, March = 1335, April = 145, Could = 1353, June = 1064,

July = 1074, August = 186, September = ? Think twice earlier than answering additionally present the steps"""

shopper = OpenAI(

api_key=os.getenv("GROK_API_KEY"),

base_url="https://api.x.ai/v1",

)

response = shopper.chat.completions.create(

mannequin="grok-3-beta",

messages=(

{

"position": "person",

"content material": immediate

}

)

)

# Output the generated Python code

print(response.decisions(0).message.content material)

Markdown(response.decisions(0).message.content material)Ausgabe:

Sowohl Grok-Beta als auch Grok-Beta-Mini sind fehlgeschlagen

Die Antwort sollte 1999 sein.

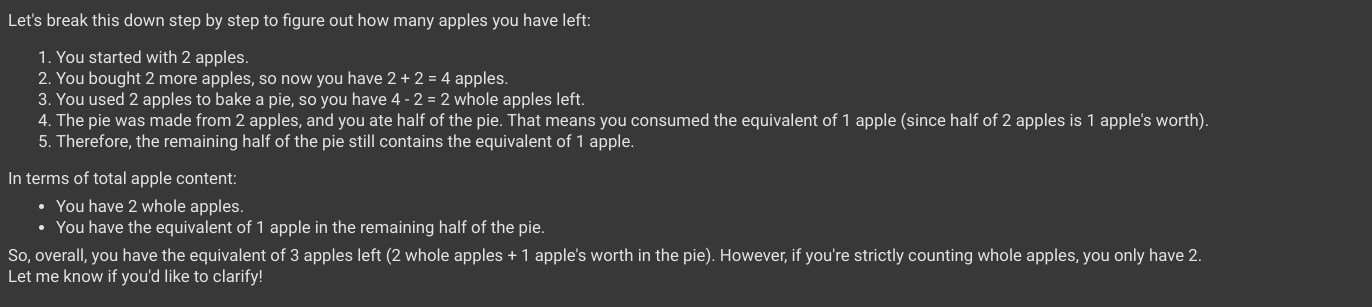

3. Testen wir die einfachen mathematischen Argumentationsfunktionen des GROK 3 -Modells mit dieser Frage

/cod

immediate = """I've two apples, then I purchase two extra. I bake a pie with two of the apples.

After consuming half of the pie, what number of apples do I've left?"""

shopper = OpenAI(

api_key=os.getenv("GROK_API_KEY"),

base_url="https://api.x.ai/v1",

)

response = shopper.chat.completions.create(

mannequin="grok-3-mini-beta",

messages=(

{

"position": "person",

"content material": immediate

}

)

)

# Output the generated Python code

print(response.decisions(0).message.content material)

Markdown(response.decisions(0).message.content material)Ausgabe:

Die Antwort wurde verifiziert, korrekt zu sein.

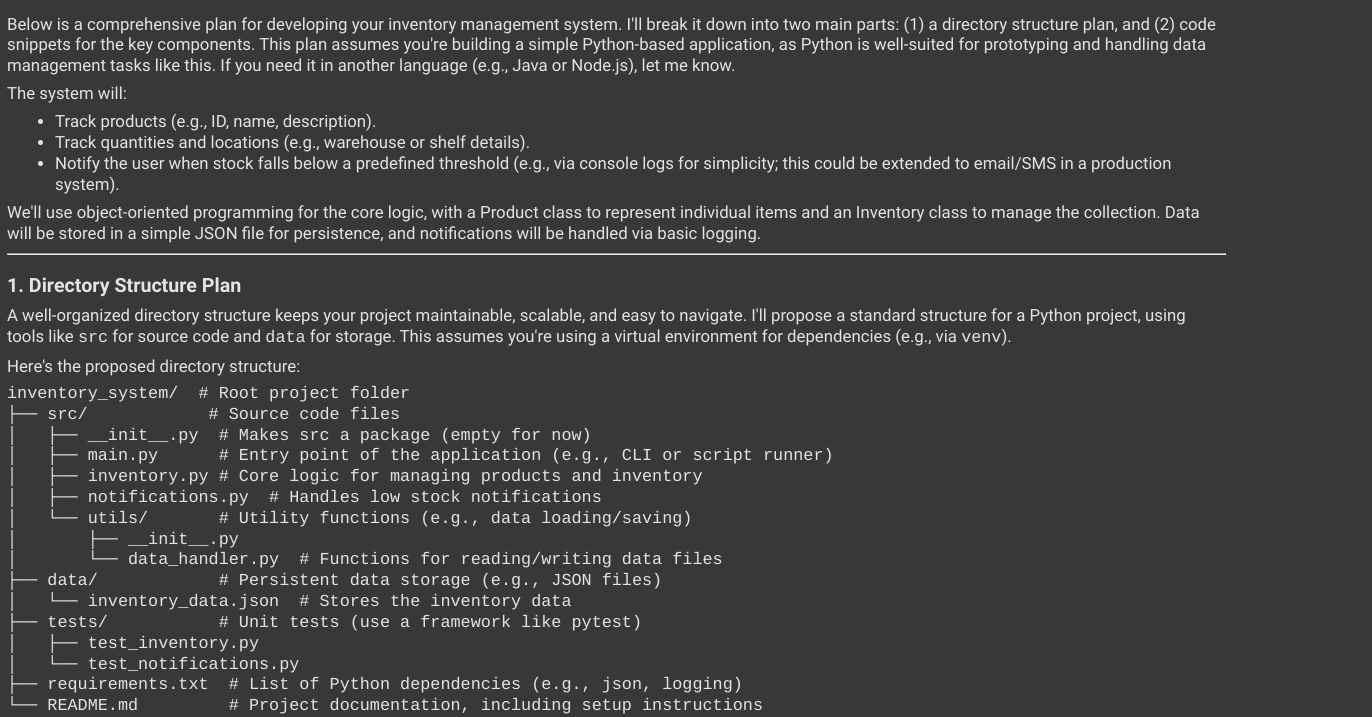

Komplexe Verwendung

Bitten wir das GROK 3-Modell, uns einen vollwertigen Plan für die Projektstruktur und die jeweiligen Code-Snippets zur Verfügung zu stellen, die den jeweiligen Dateien entsprechend hinzugefügt werden müssen.

immediate = """

I need to develop a listing administration system that tracks merchandise, portions,

and areas. It ought to notify the person when inventory is low. Create a plan for the

listing construction and supply code snippets for the important thing elements.

"""

shopper = OpenAI(

api_key=os.getenv("GROK_API_KEY"),

base_url="https://api.x.ai/v1",

)

response = shopper.chat.completions.create(

mannequin="grok-3-mini-beta",

messages=(

{

"position": "person",

"content material": immediate

}

)

)

# Output the generated Python code

print(response.decisions(0).message.content material)

Markdown(response.decisions(0).message.content material)Ausgabe:

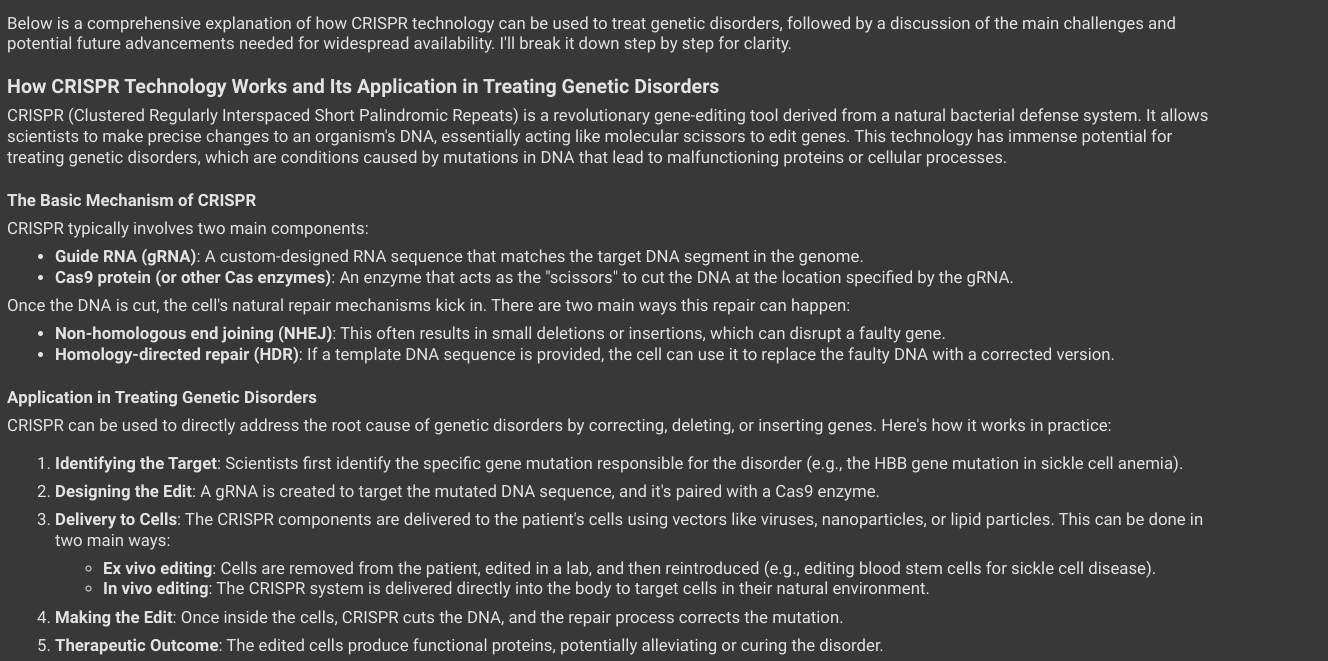

Wissenschaftliches Forschungsverständnis

Dabei werden wir das domänenbasierte Verständnis des GROK 3-Modells testen und wie es die Frage versteht und bestimmte wissenschaftliche Forschungsthemen ausgeht.

immediate = """

Clarify how CRISPR expertise can be utilized to deal with genetic problems. What are the

principal challenges, and what future developments is perhaps essential to make it extensively

accessible?

"""

shopper = OpenAI(

api_key=os.getenv("GROK_API_KEY"),

base_url="https://api.x.ai/v1",

)

response = shopper.chat.completions.create(

mannequin="grok-3-mini-beta",

messages=(

{

"position": "person",

"content material": immediate

}

)

)

# Output the generated Python code

print(response.decisions(0).message.content material)

Markdown(response.decisions(0).message.content material)Ausgabe:

Meine Meinung

Codierungsfähigkeiten

Ich fand die Codegenerierung von Grok 3 eindrucksvoll genau. Es übertrifft leichtere Modelle wie GPT-4O, Deepseek-R1 usw. usw. bei typischen algorithmischen Aufgaben, obwohl ich es auf noch komplexere Szenarien empfehlen würde, bevor ich abschließt.

Argumentationsfähigkeiten

GROK 3 zeigt ein starkes mathematisches Denken und kann zuverlässig mehrstufige Probleme lösen. Ich bemerkte jedoch einige Ausrutscher in Muster-Foundation-Argumentation, wie z.

Komplex Nutzungskasen Und Wissenschaftlich Verständnis

Bei der Aufgabe, eine Projektstruktur zu skizzieren, lieferte GROK 3 einen intestine organisierten Plan mit Kesselplattencode -Snippets. Das Wissen über CRISPR -Anwendungen beeindruckte mich, da es einen detaillierten Überblick gab, der ein tiefes wissenschaftliches Verständnis zeigte.

Grok 3 zeichnet sich bei Ausarbeitung aus und präsentiert seine Antworten klar und ausführlich. Es fühlt sich wie ein wichtiger Schritt nach vorne in LLM -Argumentation an, aber wie immer sollten wir seine Ausgänge gegen Ihre Benchmarks validieren.

Abschluss

GROK 3 ist ein großer Meilenstein bei der Entwicklung von Modellen mit großer Menschen. Von seinen „gruseligen“ Argumentationsmodi und Actual -Time -Deearch -Fähigkeiten bis hin zu seinen multimodalen Unterstützung und branchenführenden Benchmarks hat XAI ein Toolkit geliefert, das so vielseitig wie leistungsfähig ist. Wenn Sie diesem Leitfaden folgen, haben Sie gelernt, wie man:

- Sichern Sie Ihren GROK 3 -API -Schlüssel und bewahren Sie ihn sicher auf

- Schätzen Sie die Kosten im Voraus mit dem gebauten Taschenrechner von XAI.

- Sprühen Sie die grundlegenden Chat -Abschlüsse in Minuten an

- Setzen Sie GROK 3 durch seine Schritte über die Codegenerierung, logische Rätsel, komplexe Workflows und wissenschaftliche Abfragen.

- Messen Sie seine Stärken ein und identifizieren Sie Bereiche für weitere Stressentests

Egal, ob Sie ein Entwickler sind, der den nächsten großen Chatbot baut, ein Forscher, der eine KI -gesteuerte Analyse erforscht, oder einfach ein Fanatic LlmsGROK 3 bietet eine überzeugende Kombination aus Tiefe, Geschwindigkeit und Relevanz der realen Welt.

Denken Sie beim Integrieren von GROK 3 in Ihre Projekte daran, seine Ausgaben gegen Ihre Area -Benchmarks zu validieren, Ihre Token -Nutzung zu optimieren und Ihre Ergebnisse mit der Neighborhood zu teilen. Blissful Codierung

Melden Sie sich an, um weiter zu lesen und Experten-Kuratinhalte zu genießen.