Wenn Sie nicht aufpassen, verbringen Sie die meiste Zeit mit Berechnungen, die nicht funktionieren.

So setzen wir es ein der Artikel zum Bayesschen Workflow:

Ein wichtiges Zwischenziel ist die Fähigkeit, schnell scheitern beim Anpassen schlechter Modelle. Dies kann als Abkürzung betrachtet werden, die es vermeidet, viel Zeit für (nahezu) perfekte Inferenz für ein schlechtes Modell aufzuwenden. Es gibt eine umfangreiche Literatur zu Näherungsalgorithmen, um das gewünschte Modell schnell anzupassen, aber wenig zu Algorithmen, die darauf ausgelegt sind, so wenig Zeit wie möglich mit den Modellen zu verschwenden, die wir letztendlich aufgeben werden. Wir glauben, dass es wichtig ist, Methoden anhand dieses Kriteriums zu bewerten, insbesondere weil ungeeignete und schlecht passende Modelle oft schwieriger anzupassen sein können.

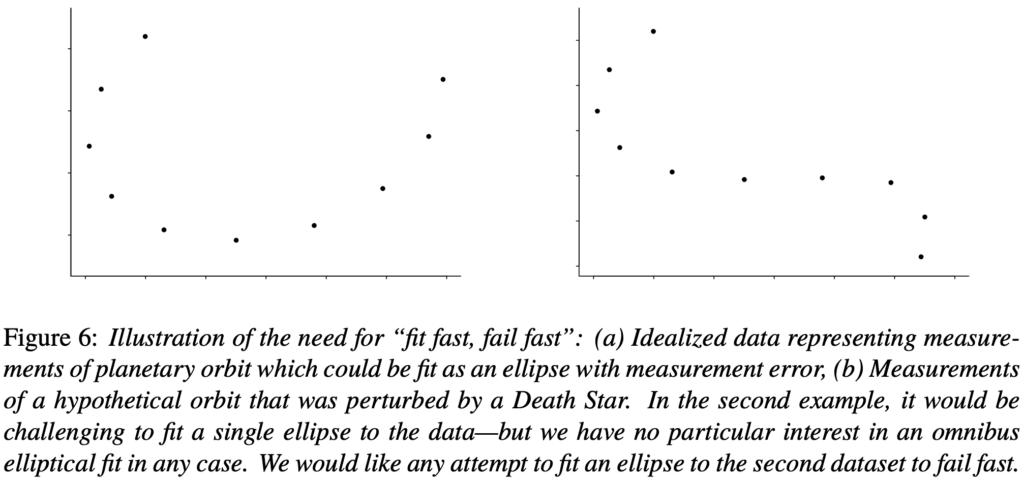

Nehmen wir als einfaches, idealisiertes Beispiel an, Sie sind ein Astronom vor mehreren Jahrhunderten, der Ellipsen an eine Planetenumlaufbahn anpasst, basierend auf 10 fehlerhaft gemessenen Datenpunkten. Abbildung 6a zeigt die Artwork von Daten, die auftreten können, und praktisch jeder Algorithmus wird einigermaßen intestine passen. Sie könnten beispielsweise verschiedene Sätze von fünf Punkten nehmen und die exakte Ellipse an jeden anpassen und dann den Durchschnitt dieser Anpassungen nehmen. Oder Sie könnten eine Ellipse an die ersten fünf Punkte anpassen, sie dann leicht stören, um sie an den sechsten Punkt anzupassen, diese dann leicht stören, um sie an den siebten anzupassen, und so weiter. Oder Sie könnten eine Artwork Algorithmus mit kleinsten Quadraten implementieren.

Nehmen wir nun an, ein Todesstern kommt vorbei und verändert die Umlaufbahn – in diesem Fall wählen wir absichtlich ein unrealistisches Beispiel, um eine große Diskrepanz zwischen Modell und Daten zu erzeugen –, sodass Ihre 10 Datenpunkte wie in Abbildung 6b aussehen. In diesem Fall wird es viel schwieriger sein, Konvergenz zu erreichen. Wenn Sie mit der Ellipsenanpassung an die ersten fünf Punkte beginnen, wird es schwierig sein, eine Reihe kleiner Störungen zu berücksichtigen, mit denen die Kurve an die späteren Punkte in der Reihe angepasst werden kann. Aber mehr noch: Selbst wenn Sie eine Kleinstquadrate-Lösung finden könnten, würde jede Ellipse schlecht zu den Daten passen. Es ist einfach ein ungeeignetes Modell. Wenn Sie eine Ellipse an diese Daten anpassen, sollten Sie wollen, dass die Anpassung schnell fehlschlägt, damit Sie schnell zu etwas Vernünftigerem übergehen können.

Dieses Beispiel weist in extremer Kind ein gemeinsames Muster schwieriger statistischer Berechnungen auf: Die Anpassung an unterschiedliche Datenteilmengen führt zu sehr unterschiedlichen Parameterschätzungen.

Aus dem „Fail Quick“-Prinzip ergeben sich drei Empfehlungen:

1. Erkennen Sie, wenn Ihre Berechnung fehlschlägt. Führen Sie sie nicht einfach blind aus.

2. Wenn die Berechnung fehlschlägt, versuchen Sie nicht, sie mit roher Gewalt zu erzwingen, indem Sie sie über Nacht laufen lassen, die maximale Baumtiefe auf 20 setzen oder was auch immer. Verwenden Sie stattdessen die Anpassung eines einfacheren Modells als Ausgangspunkt und versuchen Sie herauszufinden, was schief läuft. In einigen Einstellungen können Sie auch versuchen, verschiedene Modelle an verschiedene Teilmengen der Daten anzupassen.

3. Wenn Sie dies auf Systemebene betrachten, richten Sie Ihren Workflow so ein, dass Fehler so schnell wie möglich angezeigt werden. Das ist nicht so einfach, wie es klingt! Daran arbeiten wir. Mein Traum ist es, dies alles in einem verallgemeinerter Erwartungsausbreitungsrahmendie die rechnerische Idee von Föderiertes Lernen mit statistischen Ideen der Mehrebenenmodellierung.