Egal, ob Sie das Geräusch Ihres defekten Automotors beschreiben oder wie die Katze Ihres Nachbarn miauen, die Nachahmung von Geräuschen mit Ihrer Stimme kann eine hilfreiche Möglichkeit sein, ein Konzept zu vermitteln, wenn Worte nicht ausreichen.

Stimmliche Nachahmung ist das klangliche Äquivalent dazu, schnell ein Bild zu kritzeln, um etwas zu vermitteln, was Sie gesehen haben – mit der Ausnahme, dass Sie statt eines Bleistifts ein Bild zu illustrieren, Ihren Stimmapparat nutzen, um einen Ton auszudrücken. Das magazine schwierig erscheinen, aber es ist etwas, was wir alle intuitiv tun: Um es selbst zu erleben, versuchen Sie, mit Ihrer Stimme den Klang einer Krankenwagensirene, einer Krähe oder des Läutens einer Glocke nachzuahmen.

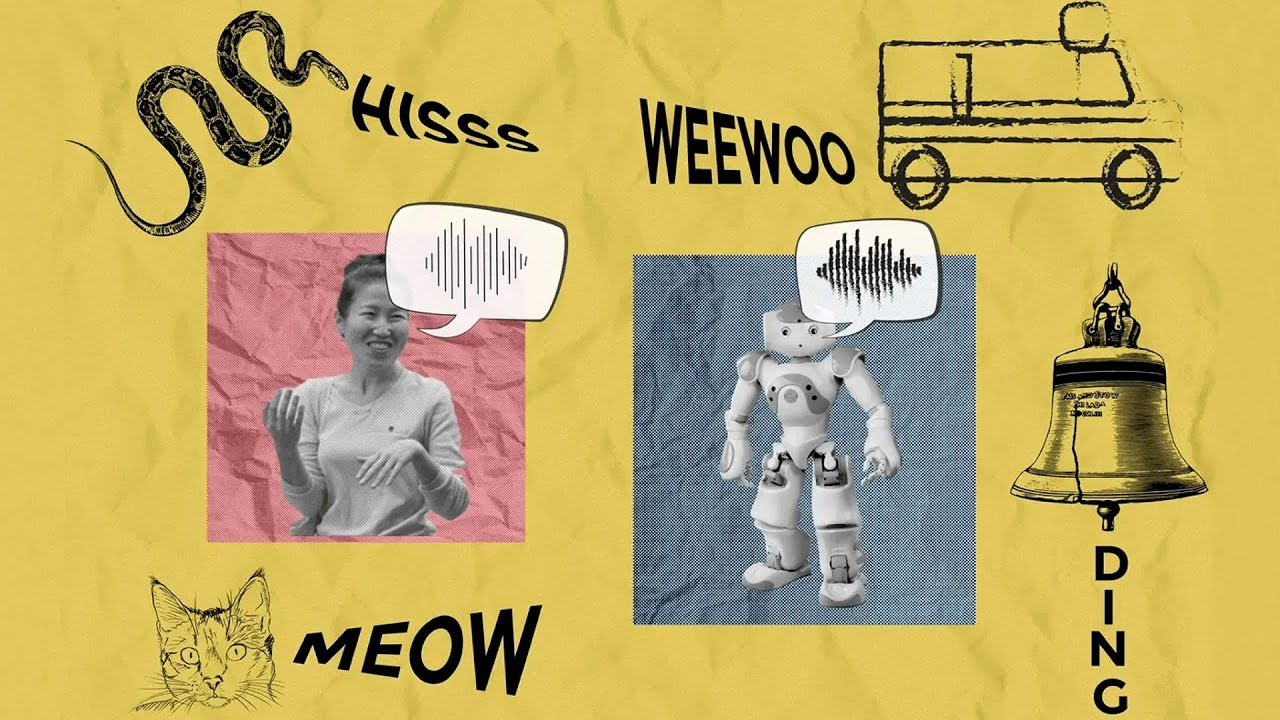

Inspiriert von der Kognitionswissenschaft, wie wir kommunizieren, haben Forscher des MIT Pc Science and Synthetic Intelligence Laboratory (CSAIL) ein KI-System entwickelt, das ohne Coaching und ohne jemals zuvor einen menschlichen Stimmeindruck „gehört“ zu haben, menschenähnliche Stimmimitationen erzeugen kann .

Um dies zu erreichen, haben die Forscher ihr System so konstruiert, dass es Geräusche ähnlich wie wir erzeugt und interpretiert. Sie begannen mit der Konstruktion eines Modells des menschlichen Stimmapparats, das simuliert, wie Vibrationen des Kehlkopfes durch Kehle, Zunge und Lippen geformt werden. Dann nutzten sie einen kognitiv inspirierten KI-Algorithmus, um dieses Modell des Stimmapparats zu steuern und es zu Imitationen zu veranlassen, wobei sie die kontextspezifischen Wege berücksichtigten, die Menschen wählen, um Geräusche zu kommunizieren.

Das Modell kann effektiv viele Geräusche aus der Welt aufnehmen und eine menschenähnliche Nachahmung davon erzeugen – darunter Geräusche wie das Rascheln von Blättern, das Zischen einer Schlange und die Sirene eines herannahenden Krankenwagens. Ihr Modell kann auch umgekehrt ausgeführt werden, um reale Geräusche aus menschlichen Stimmimitationen zu erraten, ähnlich wie einige Pc-Imaginative and prescient-Systeme auf der Grundlage von Skizzen hochwertige Bilder abrufen können. Beispielsweise kann das Modell das Geräusch eines Menschen, der das „Miauen“ einer Katze nachahmt, korrekt von ihrem „Zischen“ unterscheiden.

In Zukunft könnte dieses Modell möglicherweise zu intuitiveren „imitationsbasierten“ Schnittstellen für Sounddesigner, menschenähnlicheren KI-Charakteren in der virtuellen Realität und sogar Methoden führen, die Schülern beim Erlernen neuer Sprachen helfen.

Die Co-Hauptautoren – die MIT CSAIL-Doktoranden Kartik Chandra SM ’23 und Karima Ma sowie der Bachelor-Forscher Matthew Caren – stellen fest, dass Computergrafikforscher seit langem erkannt haben, dass Realismus selten das ultimative Ziel des visuellen Ausdrucks ist. Beispielsweise kann ein abstraktes Gemälde oder die Kreidezeichnung eines Kindes genauso ausdrucksstark sein wie ein Foto.

„In den letzten Jahrzehnten haben Fortschritte bei Skizzieralgorithmen zu neuen Werkzeugen für Künstler, Fortschritten bei KI und Pc Imaginative and prescient und sogar zu einem tieferen Verständnis der menschlichen Kognition geführt“, bemerkt Chandra. „So wie eine Skizze eine abstrakte, nicht-fotorealistische Darstellung eines Bildes ist, erfasst unsere Methode das Abstrakte, nicht-Phono–realistische Artwork und Weise, wie Menschen die Geräusche ausdrücken, die sie hören. Dadurch lernen wir den Prozess der auditiven Abstraktion kennen.“

„Ziel dieses Projekts conflict es, die stimmliche Nachahmung zu verstehen und rechnerisch zu modellieren, was wir als eine Artwork auditives Äquivalent zum Skizzieren im visuellen Bereich betrachten“, sagt Caren.

Die Kunst der Nachahmung, in drei Teilen

Das Group entwickelte drei zunehmend nuanciertere Versionen des Modells, um es mit menschlichen Stimmimitationen zu vergleichen. Zunächst erstellten sie ein Basismodell, das lediglich darauf abzielte, Imitationen zu erzeugen, die den Geräuschen der realen Welt so ähnlich wie möglich waren – aber dieses Modell passte nicht sehr intestine zum menschlichen Verhalten.

Anschließend entwarfen die Forscher ein zweites „kommunikatives“ Modell. Laut Caren berücksichtigt dieses Modell, was für einen Hörer an einem Klang charakteristisch ist. Sie würden zum Beispiel wahrscheinlich das Geräusch eines Motorboots nachahmen, indem Sie das Rumpeln seines Motors nachahmen, da dies sein markantestes Hörmerkmal ist, auch wenn es nicht der lauteste Aspekt des Geräuschs ist (im Vergleich zum Beispiel zum Plätschern des Wassers). Dieses zweite Modell führte zu Nachahmungen, die besser waren als das Basismodell, aber das Group wollte es noch weiter verbessern.

Um ihre Methode noch einen Schritt weiterzuführen, fügten die Forscher dem Modell eine letzte Argumentationsebene hinzu. „Gesangsimitationen können je nach Aufwand unterschiedlich klingen. Es kostet Zeit und Energie, Töne zu erzeugen, die absolut präzise sind“, sagt Chandra. Das vollständige Modell der Forscher berücksichtigt dies, indem es versucht, Äußerungen zu vermeiden, die sehr schnell, laut oder hoch oder tief sind und die Menschen in einem Gespräch weniger wahrscheinlich verwenden. Das Ergebnis: menschenähnlichere Imitationen, die vielen Entscheidungen, die Menschen bei der Nachahmung derselben Geräusche treffen, weitgehend entsprechen.

Nach der Erstellung dieses Modells führte das Group ein Verhaltensexperiment durch, um zu sehen, ob die von der KI oder vom Menschen erzeugten Stimmimitationen von menschlichen Richtern als besser wahrgenommen wurden. Bemerkenswert ist, dass die Teilnehmer des Experiments das KI-Modell im Allgemeinen in 25 Prozent der Fälle bevorzugten, und sogar 75 Prozent für eine Nachahmung eines Motorboots und 50 Prozent für eine Nachahmung eines Gewehrschusses.

Auf dem Weg zu einer ausdrucksstärkeren Klangtechnologie

Caren, die sich leidenschaftlich für Technologie für Musik und Kunst interessiert, stellt sich vor, dass dieses Modell Künstlern dabei helfen könnte, Klänge besser an Computersysteme zu übermitteln und Filmemachern und anderen Erstellern von Inhalten dabei zu helfen, KI-Klänge zu erzeugen, die nuancierter auf einen bestimmten Kontext abgestimmt sind. Es könnte einem Musiker auch ermöglichen, schnell eine Klangdatenbank zu durchsuchen, indem er ein Geräusch nachahmt, das beispielsweise in einer Textaufforderung schwer zu beschreiben ist.

In der Zwischenzeit untersuchen Caren, Chandra und Ma die Auswirkungen ihres Modells auf andere Bereiche, darunter die Entwicklung der Sprache, die Artwork und Weise, wie Kleinkinder sprechen lernen, und sogar das Nachahmungsverhalten von Vögeln wie Papageien und Singvögeln.

Das Group hat noch viel Arbeit mit der aktuellen Model seines Modells zu tun: Es hat Probleme mit einigen Konsonanten wie „z“, was zu ungenauen Eindrücken einiger Geräusche wie dem Summen von Bienen führte. Sie können auch noch nicht nachahmen, wie Menschen Sprache, Musik oder Geräusche nachahmen, die in verschiedenen Sprachen unterschiedlich nachgeahmt werden, beispielsweise einen Herzschlag.

Der Linguistikprofessor der Stanford College, Robert Hawkins, sagt, dass die Sprache voller Lautmalerei und Wörtern ist, die die Dinge, die sie beschreiben, nachahmen, aber nicht vollständig reproduzieren, wie zum Beispiel das „Miau“-Geräusch, das dem Geräusch von Katzen nur sehr ungenau ähnelt. „Die Prozesse, die uns vom Klang einer echten Katze zu einem Wort wie ‚Miau‘ führen, verraten viel über das komplexe Zusammenspiel von Physiologie, sozialem Denken und Kommunikation in der Evolution der Sprache“, sagt Hawkins, der nicht beteiligt conflict in der CSAIL-Forschung. „Dieses Modell stellt einen spannenden Schritt zur Formalisierung und Prüfung von Theorien dieser Prozesse dar und zeigt, dass sowohl physische Einschränkungen durch den menschlichen Stimmapparat als auch sozialer Druck durch die Kommunikation erforderlich sind, um die Verbreitung stimmlicher Imitationen zu erklären.“

Caren, Chandra und Ma haben das Papier zusammen mit zwei anderen CSAIL-Mitgliedern geschrieben: Jonathan Ragan-Kelley, außerordentlicher Professor der Fakultät für Elektrotechnik und Informatik am MIT, und Joshua Tenenbaum, Professor für Gehirn- und Kognitionswissenschaften am MIT und Zentrum für Gehirne, Köpfe und Maschinen Mitglied. Ihre Arbeit wurde teilweise von der Hertz Basis und der Nationwide Science Basis unterstützt. Es wurde Anfang Dezember auf der SIGGRAPH Asia vorgestellt.