Stellen Sie sich einen schleimähnlichen Roboter vor, der seine Type nahtlos ändern kann, um sich durch enge Räume zu zwängen, und der im menschlichen Körper eingesetzt werden könnte, um einen unerwünschten Gegenstand zu entfernen.

Während ein solcher Roboter außerhalb eines Labors noch nicht existiert, arbeiten Forscher an der Entwicklung rekonfigurierbarer Softroboter für Anwendungen im Gesundheitswesen, in tragbaren Geräten und in Industriesystemen.

Aber wie kann man einen weichen Roboter steuern, der keine manipulierbaren Gelenke, Gliedmaßen oder Finger hat und stattdessen seine gesamte Type nach Belieben drastisch verändern kann? MIT-Forscher arbeiten daran, diese Frage zu beantworten.

Sie haben einen Steuerungsalgorithmus entwickelt, der autonom lernen kann, wie ein rekonfigurierbarer Roboter bewegt, gedehnt und geformt wird, um eine bestimmte Aufgabe zu erfüllen, selbst wenn diese Aufgabe erfordert, dass der Roboter seine Morphologie mehrmals ändert. Das Staff baute außerdem einen Simulator, um Steueralgorithmen für verformbare Smooth-Roboter bei einer Reihe anspruchsvoller, formverändernder Aufgaben zu testen.

Ihre Methode erledigte jede der acht von ihnen bewerteten Aufgaben und übertraf dabei andere Algorithmen. Die Technik funktionierte besonders intestine bei vielfältigen Aufgaben. In einem Check musste der Roboter beispielsweise seine Körpergröße verringern und gleichzeitig zwei winzige Beine wachsen lassen, um sich durch ein schmales Rohr zu zwängen. Anschließend musste er diese Beine auswachsen lassen und seinen Oberkörper ausstrecken, um den Deckel des Rohrs zu öffnen.

Während rekonfigurierbare Smooth-Roboter noch in den Kinderschuhen stecken, könnte eine solche Technik eines Tages Allzweckroboter ermöglichen, die ihre Type anpassen können, um verschiedene Aufgaben zu erfüllen.

„Wenn Menschen an weiche Roboter denken, denken sie eher an Roboter, die elastisch sind, aber in ihre ursprüngliche Type zurückkehren. Unser Roboter ist wie Schleim und kann tatsächlich seine Morphologie ändern. Es ist sehr erstaunlich, dass unsere Methode so intestine funktioniert hat, weil wir es mit etwas ganz Neuem zu tun haben“, sagt Boyuan Chen, ein Doktorand der Elektrotechnik und Informatik (EECS) und Mitautor eines Buches Papier zu diesem Ansatz.

Zu Chens Co-Autoren gehören der Hauptautor Suning Huang, ein Scholar an der Tsinghua-Universität in China, der diese Arbeit als Gaststudent am MIT fertigstellte; Huazhe Xu, Assistenzprofessor an der Tsinghua-Universität; und der leitende Autor Vincent Sitzmann, Assistenzprofessor für EECS am MIT, der die Scene Illustration Group im Labor für Informatik und künstliche Intelligenz leitet. Die Forschung wird auf der Worldwide Convention on Studying Representations vorgestellt.

Dynamische Bewegung steuern

Wissenschaftler bringen Robotern oft bei, Aufgaben mithilfe eines maschinellen Lernansatzes zu erledigen, der als „Reinforcement Studying“ bekannt ist. Hierbei handelt es sich um einen Versuch-und-Irrtum-Prozess, bei dem der Roboter für Aktionen belohnt wird, die ihn einem Ziel näher bringen.

Dies kann effektiv sein, wenn die beweglichen Teile des Roboters konsistent und klar definiert sind, wie z. B. ein Greifer mit drei Fingern. Bei einem Robotergreifer könnte ein Reinforcement-Studying-Algorithmus einen Finger leicht bewegen und durch Ausprobieren lernen, ob diese Bewegung ihm eine Belohnung einbringt. Dann würde es zum nächsten Finger übergehen und so weiter.

Aber formverändernde Roboter, die durch Magnetfelder gesteuert werden, können ihren gesamten Körper dynamisch quetschen, biegen oder verlängern.

Bild: Mit freundlicher Genehmigung der Forscher

„Ein solcher Roboter könnte Tausende kleiner Muskelstücke steuern, daher ist es auf herkömmliche Weise sehr schwer zu lernen“, sagt Chen.

Um dieses Downside zu lösen, mussten er und seine Mitarbeiter anders darüber nachdenken. Anstatt jeden winzigen Muskel einzeln zu bewegen, beginnt ihr Reinforcement-Studying-Algorithmus damit, zu lernen, Gruppen benachbarter Muskeln zu steuern, die zusammenarbeiten.

Nachdem der Algorithmus dann den Raum möglicher Aktionen erkundet hat, indem er sich auf Muskelgruppen konzentriert, führt er einen Drilldown in feinere Particulars durch, um die Richtlinie oder den Aktionsplan, den er gelernt hat, zu optimieren. Auf diese Weise folgt der Regelalgorithmus einer Grob-zu-Fein-Methodik.

„Grob zu fein bedeutet, dass, wenn Sie eine zufällige Aktion ausführen, diese zufällige Aktion wahrscheinlich einen Unterschied macht. Die Veränderung des Ergebnisses ist wahrscheinlich sehr signifikant, weil man mehrere Muskeln gleichzeitig grob kontrolliert“, sagt Sitzmann.

Um dies zu ermöglichen, behandeln die Forscher den Aktionsraum eines Roboters, additionally wie er sich in einem bestimmten Bereich bewegen kann, wie ein Bild.

Ihr maschinelles Lernmodell nutzt Bilder der Umgebung des Roboters, um einen 2D-Aktionsraum zu generieren, der den Roboter und die Umgebung um ihn herum umfasst. Sie simulieren Roboterbewegungen mit der sogenannten Materials-Punkt-Methode, bei der der Aktionsraum durch Punkte, wie Bildpixel, abgedeckt und mit einem Gitter überlagert wird.

Auf die gleiche Weise, wie benachbarte Pixel in einem Bild miteinander in Beziehung stehen (wie die Pixel, die in einem Foto einen Baum bilden), haben sie ihren Algorithmus entwickelt, um zu verstehen, dass nahegelegene Aktionspunkte stärkere Korrelationen aufweisen. Punkte um die „Schulter“ des Roboters bewegen sich auf ähnliche Weise, wenn er seine Type ändert, während sich Punkte auf dem „Bein“ des Roboters ebenfalls auf ähnliche Weise bewegen, jedoch auf andere Weise als die auf der „Schulter“.

Darüber hinaus verwenden die Forscher dasselbe maschinelle Lernmodell, um die Umgebung zu betrachten und vorherzusagen, welche Aktionen der Roboter ausführen sollte, was ihn effizienter macht.

Einen Simulator bauen

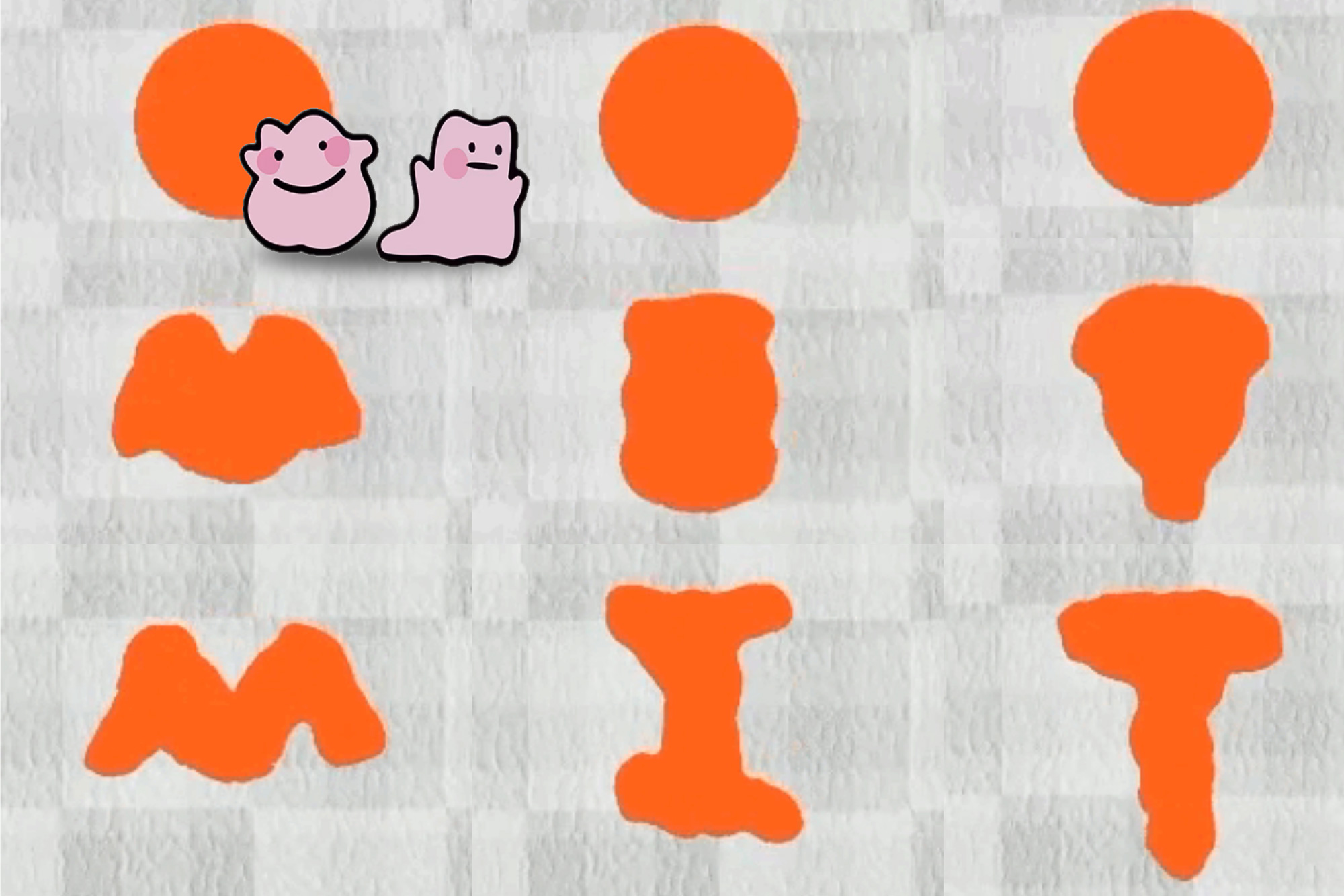

Nachdem sie diesen Ansatz entwickelt hatten, brauchten die Forscher eine Möglichkeit, ihn zu testen, additionally erstellten sie eine Simulationsumgebung namens DittoGym.

DittoGym bietet acht Aufgaben, die die Fähigkeit eines rekonfigurierbaren Roboters bewerten, seine Type dynamisch zu ändern. In einem Fall muss der Roboter seinen Körper verlängern und krümmen, damit er Hindernisse umgehen kann, um einen Zielpunkt zu erreichen. In einem anderen Fall muss es seine Type ändern, um Buchstaben des Alphabets nachzuahmen.

Bild: Mit freundlicher Genehmigung der Forscher

„Unsere Aufgabenauswahl in DittoGym folgt sowohl generischen Benchmark-Designprinzipien für Reinforcement Studying als auch den spezifischen Anforderungen rekonfigurierbarer Roboter. „Jede Aufgabe soll bestimmte Eigenschaften darstellen, die wir für wichtig halten, etwa die Fähigkeit, durch Erkundungen über einen längeren Horizont zu navigieren, die Fähigkeit, die Umgebung zu analysieren und mit externen Objekten zu interagieren“, sagt Huang. „Wir glauben, dass sie zusammen den Benutzern ein umfassendes Verständnis der Flexibilität rekonfigurierbarer Roboter und der Wirksamkeit unseres Reinforcement-Studying-Programms vermitteln können.“

Ihr Algorithmus übertraf die Basismethoden und conflict die einzige Technik, die für die Durchführung mehrstufiger Aufgaben geeignet conflict, die mehrere Formänderungen erforderten.

„Wir haben eine stärkere Korrelation zwischen Aktionspunkten, die näher beieinander liegen, und ich denke, das ist der Schlüssel dafür, dass dies so intestine funktioniert“, sagt Chen.

Auch wenn es viele Jahre dauern kann, bis formverändernde Roboter in der realen Welt eingesetzt werden, hoffen Chen und seine Mitarbeiter, dass ihre Arbeit andere Wissenschaftler nicht nur dazu inspiriert, rekonfigurierbare Smooth-Roboter zu untersuchen, sondern auch darüber nachzudenken, 2D-Aktionsräume für andere komplexe Steuerungsprobleme zu nutzen.