Nehmen wir an, Sie möchten einem Roboter beibringen, wie man Werkzeuge benutzt, und ihn dann schnell lernen lassen, Reparaturen im Haus mit Hammer, Schraubenschlüssel und Schraubenzieher durchzuführen. Dazu bräuchten Sie eine enorme Menge an Daten, die den Werkzeuggebrauch demonstrieren.

Vorhandene Roboterdatensätze unterscheiden sich stark in ihrer Modalität – einige enthalten Farbbilder, während andere beispielsweise aus taktilen Abdrücken bestehen. Daten könnten auch in anderen Bereichen gesammelt werden, beispielsweise in Simulationen oder bei menschlichen Demos. Und jeder Datensatz kann eine einzigartige Aufgabe und Umgebung erfassen.

Da es schwierig ist, Daten aus so vielen Quellen effizient in ein maschinelles Lernmodell zu integrieren, verwenden viele Methoden nur einen einzigen Datentyp, um einen Roboter zu trainieren. Doch Roboter, die auf diese Weise mit einer relativ geringen Menge aufgabenspezifischer Daten trainiert werden, sind oft nicht in der Lage, neue Aufgaben in unbekannten Umgebungen auszuführen.

Im Bemühen, bessere Mehrzweckroboter zu trainieren, haben Forscher am MIT eine Technik entwickelt, um mehrere Datenquellen aus verschiedenen Domänen, Modalitäten und Aufgaben mithilfe einer Artwork generativer KI, den sogenannten Diffusionsmodellen, zu kombinieren.

Sie trainieren ein separates Diffusionsmodell, um eine Strategie oder Richtlinie zum Erledigen einer Aufgabe anhand eines bestimmten Datensatzes zu erlernen. Anschließend kombinieren sie die von den Diffusionsmodellen erlernten Richtlinien zu einer allgemeinen Richtlinie, die es einem Roboter ermöglicht, mehrere Aufgaben in verschiedenen Umgebungen auszuführen.

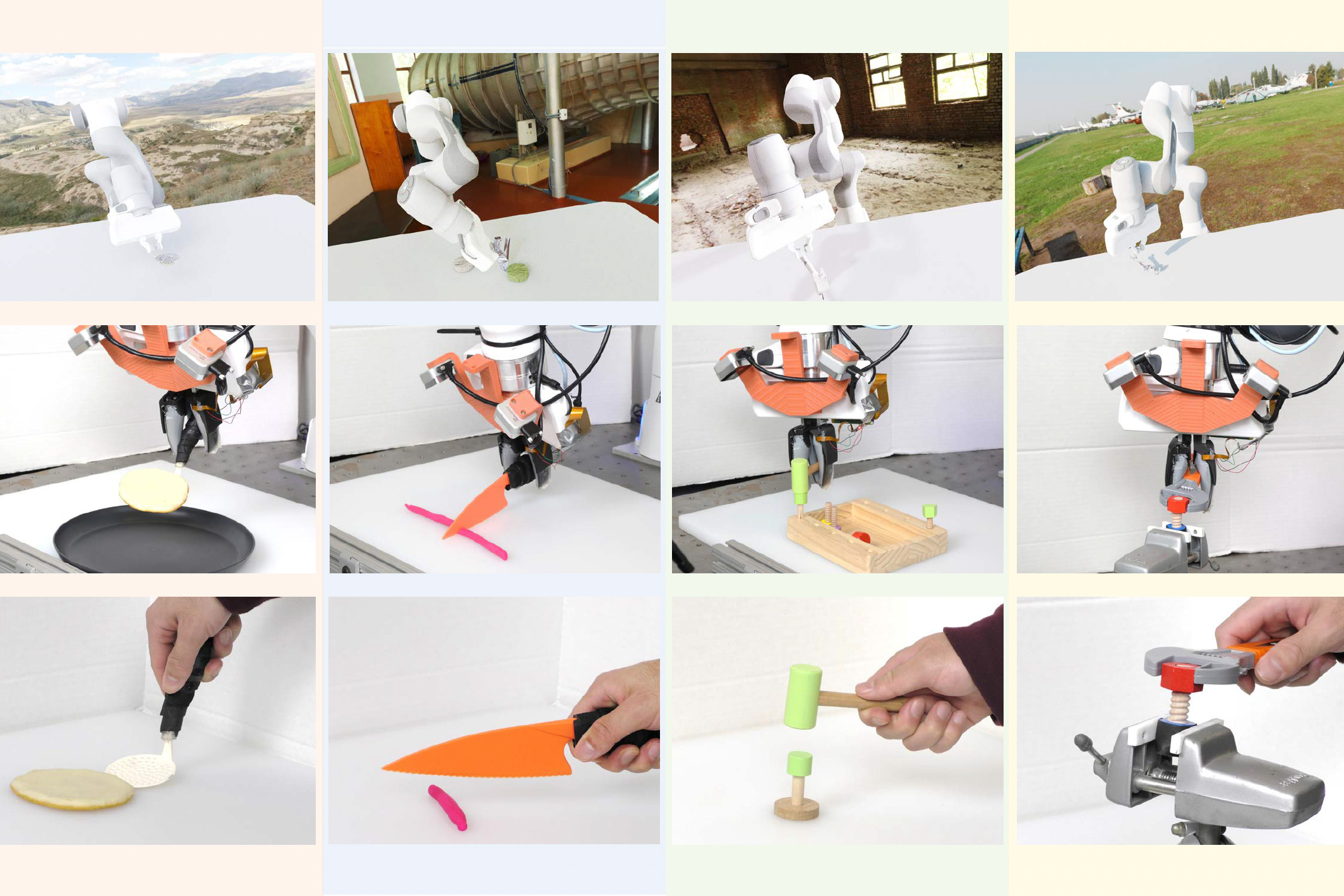

In Simulationen und realen Experimenten ermöglichte dieser Trainingsansatz einem Roboter, mehrere Aufgaben mit Werkzeugeinsatz auszuführen und sich an neue Aufgaben anzupassen, die er während des Trainings nicht gesehen hatte. Die als Coverage Composition (PoCo) bekannte Methode führte zu einer 20-prozentigen Verbesserung der Aufgabenleistung im Vergleich zu Basistechniken.

„Die Heterogenität in Roboterdatensätzen zu berücksichtigen, ist wie ein Henne-Ei-Downside. Wenn wir viele Daten verwenden möchten, um allgemeine Roboterrichtlinien zu trainieren, benötigen wir zunächst einsetzbare Roboter, um all diese Daten zu erhalten. Ich denke, dass die Nutzung aller verfügbaren heterogenen Daten, ähnlich wie es Forscher mit ChatGPT getan haben, ein wichtiger Schritt für den Bereich der Robotik ist“, sagt Lirui Wang, ein Doktorand der Elektrotechnik und Informatik (EECS) und Hauptautor eines Papier zu PoCo.

Zu Wangs Co-Autoren gehören Jialiang Zhao, ein Maschinenbaustudent; Yilun Du, ein EECS-Scholar; Edward Adelson, der John and Dorothy Wilson Professor für Sehwissenschaften in der Abteilung für Gehirn- und Kognitionswissenschaften und Mitglied des Laptop Science and Synthetic Intelligence Laboratory (CSAIL); und der leitende Autor Russ Tedrake, der Toyota Professor für EECS, Luft- und Raumfahrt und Maschinenbau und Mitglied des CSAIL. Die Forschungsarbeit wird auf der Robotics: Science and Programs Convention vorgestellt.

Kombinieren unterschiedlicher Datensätze

Eine Roboterrichtlinie ist ein maschinelles Lernmodell, das Eingaben entgegennimmt und diese verwendet, um eine Aktion auszuführen. Man kann sich eine Richtlinie als Strategie vorstellen. Im Fall eines Roboterarms könnte diese Strategie eine Flugbahn oder eine Reihe von Posen sein, die den Arm so bewegen, dass er einen Hammer aufnimmt und damit einen Nagel einschlägt.

Die zum Erlernen von Roboterrichtlinien verwendeten Datensätze sind typischerweise klein und auf eine bestimmte Aufgabe und Umgebung ausgerichtet, wie etwa das Verpacken von Artikeln in Kisten in einem Lager.

„Jedes einzelne Roboterlager erzeugt Terabyte an Daten, aber diese gehören nur zu der jeweiligen Roboterinstallation, die an diesen Paketen arbeitet. Das ist nicht supreme, wenn Sie all diese Daten verwenden möchten, um eine allgemeine Maschine zu trainieren“, sagt Wang.

Die MIT-Forscher entwickelten eine Technik, die aus einer Reihe kleinerer Datensätze – wie sie beispielsweise von vielen Roboterlagern gesammelt werden – separate Richtlinien für jeden Datensatz lernt und diese Richtlinien dann auf eine Weise kombiniert, die es einem Roboter ermöglicht, sie auf viele Aufgaben zu verallgemeinern.

Sie stellen jede Richtlinie mithilfe eines Typs generativen KI-Modells dar, das als Diffusionsmodell bezeichnet wird. Diffusionsmodelle, die häufig zur Bildgenerierung verwendet werden, lernen, neue Datenproben zu erstellen, die Proben in einem Trainingsdatensatz ähneln, indem sie ihre Ausgabe iterativ verfeinern.

Doch anstatt einem Diffusionsmodell beizubringen, Bilder zu erzeugen, bringen die Forscher ihm bei, eine Flugbahn für einen Roboter zu erzeugen. Dies tun sie, indem sie den Flugbahnen in einem Trainingsdatensatz Rauschen hinzufügen. Das Diffusionsmodell entfernt das Rauschen nach und nach und verfeinert seine Ausgabe zu einer Flugbahn.

Diese Technik, bekannt als Verbreitungspolitikwurde zuvor von Forschern am MIT, der Columbia College und dem Toyota Analysis Institute vorgestellt. PoCo baut auf dieser Diffusionspolitik-Arbeit auf.

Das Crew trainiert jedes Diffusionsmodell mit einem anderen Datensatztyp, beispielsweise einem mit Videodemonstrationen von Menschen und einem anderen, das aus der Fernsteuerung eines Roboterarms gewonnen wurde.

Anschließend führen die Forscher eine gewichtete Kombination der von allen Diffusionsmodellen erlernten Einzelstrategien durch und verfeinern das Ergebnis iterativ, sodass die kombinierte Strategie die Ziele jeder einzelnen Strategie erfüllt.

Mehr als die Summe seiner Teile

„Einer der Vorteile dieses Ansatzes ist, dass wir Strategien kombinieren können, um das Beste aus beiden Welten zu erhalten. Eine Strategie, die auf realen Daten trainiert wurde, könnte beispielsweise mehr Geschicklichkeit erreichen, während eine Strategie, die auf Simulationen trainiert wurde, möglicherweise mehr Generalisierung erreichen könnte“, sagt Wang.

Bild: Mit freundlicher Genehmigung der Forscher

Da die Richtlinien separat trainiert werden, kann man Diffusionsrichtlinien mischen und anpassen, um für eine bestimmte Aufgabe bessere Ergebnisse zu erzielen. Ein Benutzer kann auch Daten in einer neuen Modalität oder Domäne hinzufügen, indem er mit diesem Datensatz eine zusätzliche Diffusionsrichtlinie trainiert, anstatt den gesamten Prozess von vorne zu beginnen.

Bild: Mit freundlicher Genehmigung der Forscher

Die Forscher testeten PoCo in einer Simulation und an echten Roboterarmen, die verschiedene Werkzeugaufgaben ausführten, wie etwa das Einschlagen eines Nagels mit einem Hammer oder das Umdrehen eines Gegenstands mit einem Spachtel. PoCo führte zu einer 20-prozentigen Verbesserung der Aufgabenleistung im Vergleich zu Basismethoden.

„Das Auffällige warfare, dass wir, als wir mit der Feinabstimmung fertig waren und sie visualisierten, deutlich erkennen konnten, dass die zusammengesetzte Flugbahn viel besser aussieht als jede einzelne von ihnen einzeln“, sagt Wang.

In Zukunft möchten die Forscher diese Technik auf langfristige Aufgaben anwenden, bei denen ein Roboter ein Werkzeug aufnimmt, es verwendet und dann zu einem anderen wechselt. Sie möchten auch größere Roboterdatensätze einbeziehen, um die Leistung zu verbessern.

„Um in der Robotik erfolgreich zu sein, benötigen wir alle drei Arten von Daten: Internetdaten, Simulationsdaten und echte Roboterdaten. Wie man sie effektiv kombiniert, wird die Millionenfrage sein. PoCo ist ein solider Schritt in die richtige Richtung“, sagt Jim Fan, leitender Wissenschaftler bei NVIDIA und Leiter der AI Brokers Initiative, der an dieser Arbeit nicht beteiligt warfare.

Diese Forschung wird zum Teil von Amazon, der Singapore Protection Science and Know-how Company, der US-amerikanischen Nationwide Science Basis und dem Toyota Analysis Institute finanziert.