Im aktuellen KI-Zeitgeist erfreuen sich Sequenzmodelle aufgrund ihrer Fähigkeit, Daten zu analysieren und vorherzusagen, was als nächstes zu tun ist, immer größerer Beliebtheit. Beispielsweise haben Sie wahrscheinlich Modelle zur Vorhersage des nächsten Tokens wie ChatGPT verwendet, die jedes Wort (Token) in einer Sequenz antizipieren, um Antworten auf Benutzeranfragen zu bilden. Es gibt auch Vollsequenz-Diffusionsmodelle wie Sora, die Wörter in schillernde, realistische Bilder umwandeln, indem sie eine ganze Videosequenz sukzessive „entrauschen“.

Forscher des Laptop Science and Synthetic Intelligence Laboratory (CSAIL) des MIT haben eine einfache Änderung des Diffusionstrainingsschemas vorgeschlagen, die diese Sequenzentrauschung erheblich flexibler macht.

Bei der Anwendung auf Bereiche wie Laptop Imaginative and prescient und Robotik weisen die Subsequent-Token- und Full-Sequence-Diffusionsmodelle Leistungskompromisse auf. Subsequent-Token-Modelle können Sequenzen unterschiedlicher Länge ausspucken. Allerdings erzeugen sie diese Generationen, ohne sich der wünschenswerten Zustände in der fernen Zukunft bewusst zu sein – wie etwa die Steuerung ihrer Sequenzgenerierung auf ein bestimmtes Ziel, das 10 Token entfernt ist – und erfordern daher zusätzliche Mechanismen für eine langfristige (langfristige) Planung. Diffusionsmodelle können solche zukunftsbedingten Stichproben durchführen, ihnen fehlt jedoch die Fähigkeit von Subsequent-Token-Modellen, Sequenzen variabler Länge zu erzeugen.

Forscher von CSAIL möchten die Stärken beider Modelle kombinieren und haben daher eine Sequenzmodell-Trainingstechnik namens „Diffusion Forcing“ entwickelt. Der Title stammt von „Instructor Forcing“, dem herkömmlichen Trainingsschema, das die vollständige Sequenzgenerierung in die kleineren, einfacheren Schritte der nächsten Token-Generierung aufteilt (ähnlich wie ein guter Lehrer ein komplexes Konzept vereinfacht).

Beim Diffusion Forcing wurden Gemeinsamkeiten zwischen Diffusionsmodellen und Instructor Forcing festgestellt: Beide verwenden Trainingsschemata, bei denen maskierte (verrauschte) Token aus unmaskierten Token vorhergesagt werden. Im Fall von Diffusionsmodellen fügen sie den Daten nach und nach Rauschen hinzu, was als fraktionierte Maskierung angesehen werden kann. Die Diffusion Forcing-Methode der MIT-Forscher trainiert neuronale Netze, um eine Sammlung von Token zu bereinigen, wobei in jedem einzelne unterschiedliche Mengen an Rauschen entfernt werden, während gleichzeitig die nächsten paar Token vorhergesagt werden. Das Ergebnis: ein flexibles, zuverlässiges Sequenzmodell, das zu qualitativ hochwertigeren künstlichen Movies und einer präziseren Entscheidungsfindung für Roboter und KI-Agenten führte.

Durch die Sortierung verrauschter Daten und die zuverlässige Vorhersage der nächsten Schritte einer Aufgabe kann Diffusion Forcing einem Roboter dabei helfen, visuelle Ablenkungen zu ignorieren und Manipulationsaufgaben auszuführen. Es kann außerdem stabile und konsistente Videosequenzen erzeugen und sogar einen KI-Agenten durch digitale Labyrinthe führen. Diese Methode könnte es Haushalts- und Fabrikrobotern möglicherweise ermöglichen, neue Aufgaben zu übernehmen und die KI-generierte Unterhaltung zu verbessern.

„Sequenzmodelle zielen darauf ab, auf der bekannten Vergangenheit zu basieren und die unbekannte Zukunft vorherzusagen, eine Artwork binäre Maskierung. Allerdings muss die Maskierung nicht binär sein“, sagt Boyuan Chen, Hauptautor, MIT-Doktorand für Elektrotechnik und Informatik (EECS) und CSAIL-Mitglied. „Mit Diffusion Forcing fügen wir jedem Token unterschiedliche Rauschpegel hinzu, was effektiv als eine Artwork fraktionierte Maskierung dient. Zum Testzeitpunkt kann unser System eine Sammlung von Token „demaskieren“ und in naher Zukunft eine Sequenz mit einem geringeren Geräuschpegel verbreiten. Es weiß, worauf es in seinen Daten vertrauen kann, um Eingaben außerhalb der Verteilung zu überwinden.“

In mehreren Experimenten gelang es Diffusion Forcing, irreführende Daten zu ignorieren, um Aufgaben auszuführen und gleichzeitig zukünftige Aktionen zu antizipieren.

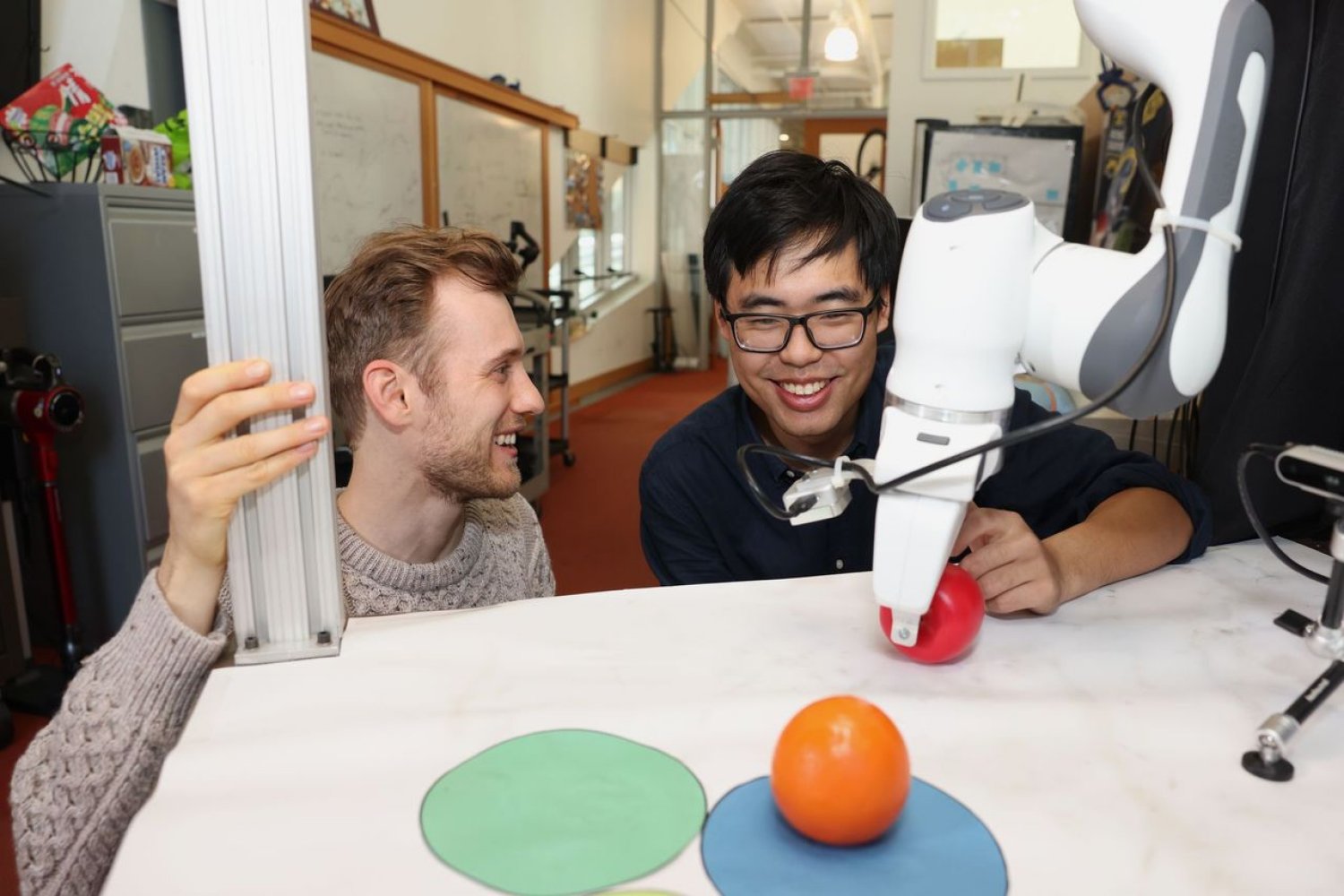

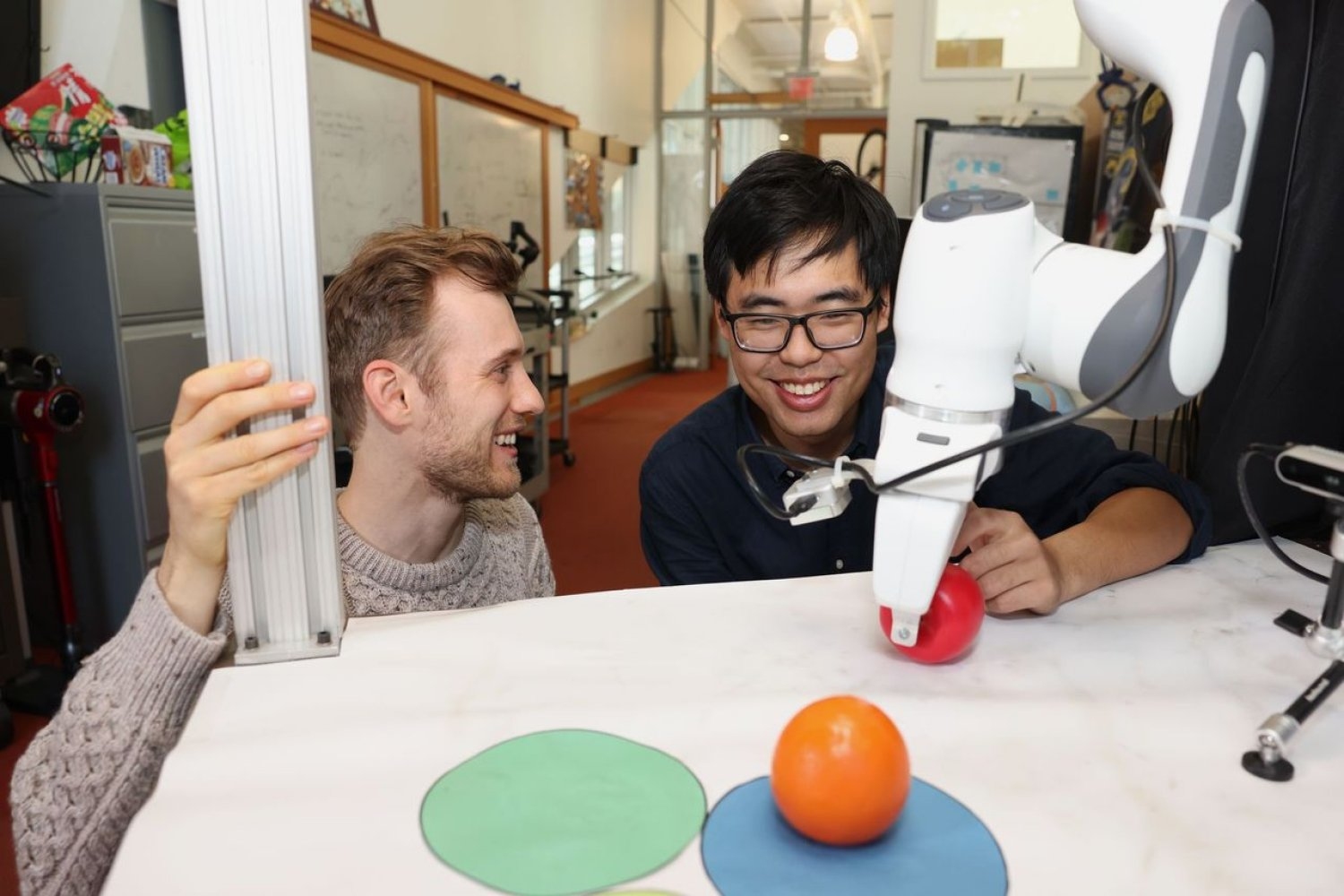

Bei der Implementierung in einen Roboterarm half es beispielsweise dabei, zwei Spielzeugfrüchte auf drei kreisförmigen Matten auszutauschen, ein minimales Beispiel für eine Familie von Langzeitaufgaben, die Erinnerungen erfordern. Die Forscher trainierten den Roboter, indem sie ihn in der virtuellen Realität aus der Ferne steuerten (oder teleoperierten). Der Roboter ist darauf trainiert, die Bewegungen des Benutzers über seine Kamera nachzuahmen. Obwohl es von zufälligen Positionen ausging und Ablenkungen wie eine Einkaufstüte sah, die die Markierungen blockierten, platzierte es die Objekte an ihren Zielpunkten.

Um Movies zu erstellen, trainierten sie Diffusion Forcing mit dem Gameplay von „Minecraft“ und farbenfrohen digitalen Umgebungen, die in Google erstellt wurden DeepMind Lab-Simulator. Bei Verwendung eines einzelnen Filmbilds erzeugte die Methode stabilere Movies mit höherer Auflösung als vergleichbare Basislinien wie ein Sora-ähnliches Vollsequenz-Diffusionsmodell und ChatGPT-ähnliche Subsequent-Token-Modelle. Diese Ansätze erzeugten Movies, die inkonsistent wirkten, wobei letztere manchmal keine funktionierenden Movies über nur 72 Frames hinaus generierten.

Diffusion Forcing generiert nicht nur ausgefallene Movies, sondern kann auch als Bewegungsplaner dienen, der auf gewünschte Ergebnisse oder Belohnungen abzielt. Dank seiner Flexibilität kann Diffusion Forcing auf einzigartige Weise Pläne mit unterschiedlichem Horizont erstellen, eine Baumsuche durchführen und die Instinct berücksichtigen, dass die ferne Zukunft unsicherer ist als die nahe Zukunft. Bei der Aufgabe, ein 2D-Labyrinth zu lösen, übertraf Diffusion Forcing sechs Basislinien, indem es schnellere Pläne generierte, die zum Zielort führten, was darauf hindeutet, dass es in Zukunft ein effektiver Planer für Roboter sein könnte.

In jeder Demo fungierte Diffusion Forcing als vollständiges Sequenzmodell, als Subsequent-Token-Vorhersagemodell oder als beides. Laut Chen könnte dieser vielseitige Ansatz möglicherweise als leistungsstarkes Rückgrat für ein „Weltmodell“ dienen, ein KI-System, das die Dynamik der Welt durch Coaching auf Milliarden von Internetvideos simulieren kann. Dies würde es Robotern ermöglichen, neuartige Aufgaben auszuführen, indem sie sich anhand ihrer Umgebung vorstellen, was sie tun müssen. Wenn Sie beispielsweise einen Roboter bitten würden, eine Tür zu öffnen, ohne dass er darin geschult wurde, könnte das Modell ein Video produzieren, das der Maschine zeigt, wie es geht.

Das Crew versucht derzeit, seine Methode auf größere Datensätze und die neuesten Transformatormodelle auszuweiten, um die Leistung zu verbessern. Sie beabsichtigen, ihre Arbeit zu erweitern, um ein ChatGPT-ähnliches Robotergehirn zu entwickeln, das Robotern hilft, Aufgaben in neuen Umgebungen ohne menschliches Zutun auszuführen.

„Mit Diffusion Forcing machen wir einen Schritt, um Videoerzeugung und Robotik näher zusammenzubringen“, sagt der leitende Autor Vincent Sitzmann, Assistenzprofessor am MIT und Mitglied von CSAIL, wo er die Gruppe „Scene Illustration“ leitet. „Am Ende hoffen wir, dass wir das gesamte in Movies im Web gespeicherte Wissen nutzen können, um Robotern die Hilfe im Alltag zu ermöglichen. Es bleiben noch viele weitere spannende Forschungsherausforderungen, wie zum Beispiel die Frage, wie Roboter lernen können, Menschen nachzuahmen, indem sie sie beobachten, selbst wenn ihr eigener Körper sich so sehr von unserem unterscheidet!“

Chen und Sitzmann haben das Papier gemeinsam mit Diego Martí Monsó, dem jüngsten MIT-Gastforscher, und CSAIL-Mitgliedern verfasst: Yilun Du, ein EECS-Doktorand; Max Simchowitz, ehemaliger Postdoc und künftiger Assistenzprofessor an der Carnegie Mellon College; und Russ Tedrake, Toyota-Professor für EECS, Luft- und Raumfahrt sowie Maschinenbau am MIT, Vizepräsident für Robotikforschung am Toyota Analysis Institute und CSAIL-Mitglied. Ihre Arbeit wurde teilweise von der US Nationwide Science Basis, der Singapore Defence Science and Know-how Company, Intelligence Superior Analysis Tasks Exercise über das US-Innenministerium und dem Amazon Science Hub unterstützt. Sie werden ihre Forschung im Dezember bei NeurIPS vorstellen.