Mark Hamilton, ein MIT-Doktorand in Elektrotechnik und Informatik und Mitglied des Pc Science and Synthetic Intelligence Laboratory (CSAIL) des MIT, möchte mithilfe von Maschinen verstehen, wie Tiere kommunizieren. Zu diesem Zweck wollte er zunächst ein System entwickeln, das die menschliche Sprache „von Grund auf“ erlernen kann.

„Komischerweise kam der entscheidende Second der Inspiration aus dem Movie ‚Die Reise der Pinguine‘. Es gibt eine Szene, in der ein Pinguin beim Überqueren des Eises hinfällt und beim Aufstehen ein kleines, mühsames Stöhnen ausstößt. Wenn man sich das ansieht, ist es quick offensichtlich, dass dieses Stöhnen ein vierbuchstabiges Wort darstellt. Das struggle der Second, in dem wir dachten, vielleicht müssen wir Audio und Video verwenden, um Sprache zu lernen“, sagt Hamilton. „Gibt es eine Möglichkeit, einen Algorithmus den ganzen Tag fernsehen zu lassen und anhand dessen herauszufinden, wovon wir sprechen?“

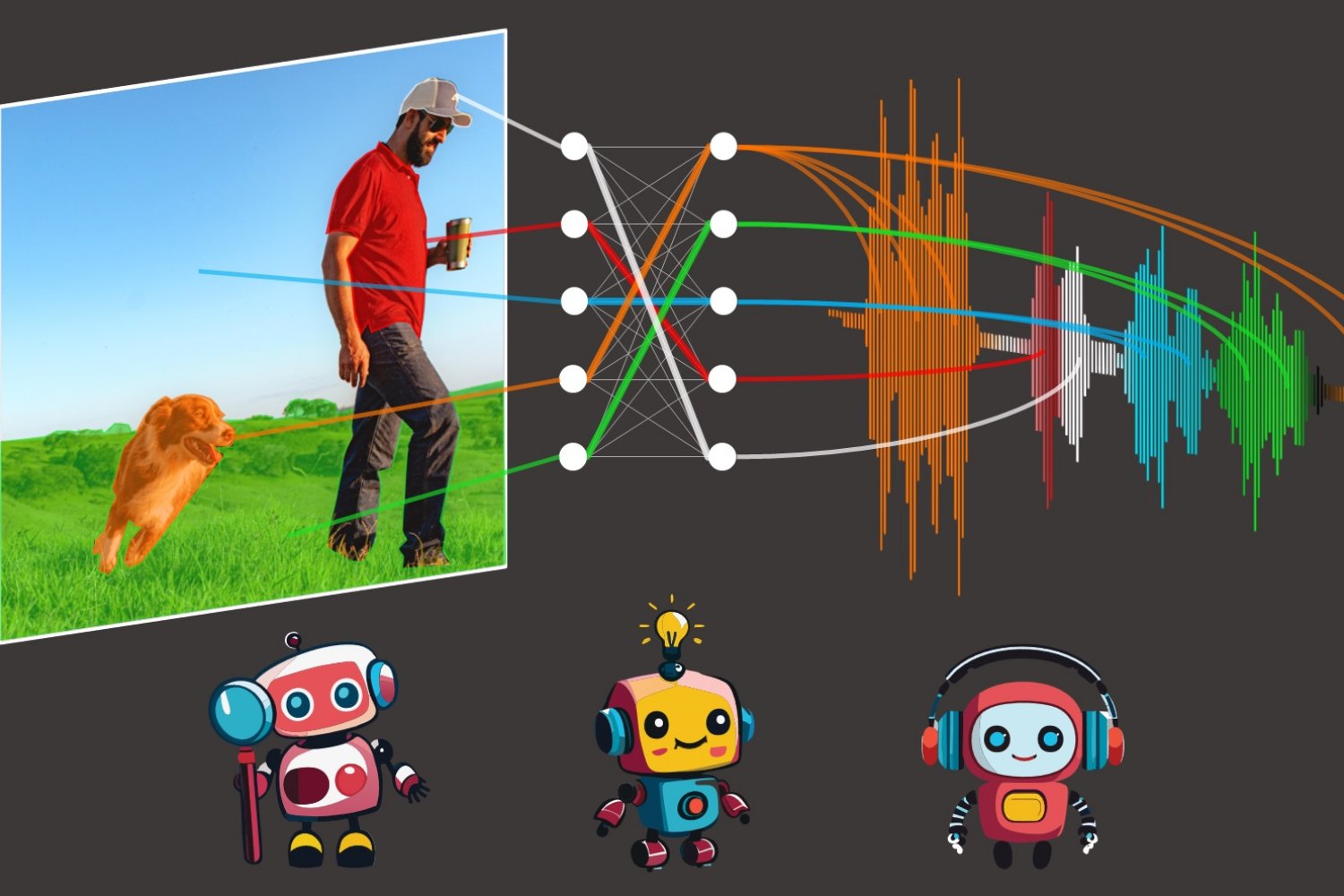

„Unser Modell ‚DenseAV‘ zielt darauf ab, Sprache zu lernen, indem es vorhersagt, was es sieht, und umgekehrt. Wenn Sie beispielsweise jemanden sagen hören ‚Backen Sie den Kuchen bei 350‘, sehen Sie wahrscheinlich einen Kuchen oder einen Ofen. Um bei diesem Audio-Video-Matching-Spiel in Millionen von Movies erfolgreich zu sein, muss das Modell lernen, worüber die Leute sprechen“, sagt Hamilton.

Nachdem sie DenseAV mit diesem Zuordnungsspiel trainiert hatten, untersuchten Hamilton und seine Kollegen, nach welchen Pixeln das Modell suchte, wenn es einen Ton hörte. Wenn beispielsweise jemand „Hund“ sagt, beginnt der Algorithmus sofort, im Videostream nach Hunden zu suchen. Indem man sieht, welche Pixel vom Algorithmus ausgewählt werden, kann man herausfinden, was der Algorithmus denkt, was ein Wort bedeutet.

Interessanterweise läuft ein ähnlicher Suchvorgang ab, wenn DenseAV einem Hundegebell zuhört: Es sucht im Videostream nach einem Hund. „Das hat unser Interesse geweckt. Wir wollten sehen, ob der Algorithmus den Unterschied zwischen dem Wort ‚Hund‘ und dem Bellen eines Hundes kennt“, sagt Hamilton. Das Crew untersuchte dies, indem es DenseAV ein „zweiseitiges Gehirn“ gab. Interessanterweise stellten sie fest, dass sich eine Seite von DenseAVs Gehirn natürlich auf Sprache, wie das Wort „Hund“, konzentrierte und die andere Seite auf Geräusche wie Bellen. Dies zeigte, dass DenseAV nicht nur die Bedeutung von Wörtern und die Place von Geräuschen lernte, sondern auch lernte, zwischen diesen Arten von kreuzmodalen Verbindungen zu unterscheiden, und das alles ohne menschliches Eingreifen oder Kenntnisse der geschriebenen Sprache.

Ein Anwendungszweig ist das Lernen aus der riesigen Menge an Movies, die täglich im Web veröffentlicht werden: „Wir wollen Systeme, die aus riesigen Mengen an Videoinhalten lernen können, etwa Lehrvideos“, sagt Hamilton. „Eine weitere spannende Anwendung ist das Verstehen neuer Sprachen, wie etwa der Kommunikation von Delfinen oder Walen, für die es keine schriftliche Kommunikationsform gibt. Wir hoffen, dass DenseAV uns helfen kann, diese Sprachen zu verstehen, die sich menschlicher Übersetzungsbemühungen von Anfang an entzogen haben. Schließlich hoffen wir, dass diese Methode verwendet werden kann, um Muster zwischen anderen Signalpaaren zu entdecken, etwa zwischen seismischen Geräuschen der Erde und ihrer Geologie.“

Das Crew stand vor einer gewaltigen Herausforderung: das Erlernen von Sprache ohne Texteingabe. Ihr Ziel struggle es, die Bedeutung von Sprache von Grund auf neu zu entdecken und dabei vorab trainierte Sprachmodelle zu vermeiden. Dieser Ansatz ist davon inspiriert, wie Kinder lernen, Sprache zu verstehen, indem sie ihre Umgebung beobachten und ihr zuhören.

Um dieses Kunststück zu erreichen, verwendet DenseAV zwei Hauptkomponenten, um Audio- und visuelle Daten getrennt zu verarbeiten. Diese Trennung macht es dem Algorithmus unmöglich zu schummeln, indem er die visuelle Seite die Audiodaten betrachten lässt und umgekehrt. Der Algorithmus wird gezwungen, Objekte zu erkennen und erstellt detaillierte und aussagekräftige Merkmale sowohl für Audio- als auch für visuelle Signale. DenseAV lernt, indem es Paare von Audio- und visuellen Signalen vergleicht, um herauszufinden, welche Signale übereinstimmen und welche nicht. Diese Methode, kontrastives Lernen genannt, erfordert keine beschrifteten Beispiele und ermöglicht es DenseAV, die wichtigen prädiktiven Muster der Sprache selbst herauszufinden.

Ein wesentlicher Unterschied zwischen DenseAV und früheren Algorithmen besteht darin, dass sich frühere Arbeiten auf ein einziges Konzept der Ähnlichkeit zwischen Ton und Bild konzentrierten. Ein ganzer Audioclip, etwa wenn jemand sagt: „Der Hund saß im Gras“, wurde mit einem ganzen Bild eines Hundes abgeglichen. Dadurch konnten frühere Methoden keine feinkörnigen Particulars erkennen, wie etwa die Verbindung zwischen dem Wort „Gras“ und dem Gras unter dem Hund. Der Algorithmus des Groups sucht und aggregiert alle möglichen Übereinstimmungen zwischen einem Audioclip und den Pixeln eines Bildes. Dies verbesserte nicht nur die Leistung, sondern ermöglichte dem Crew auch die präzise Lokalisierung von Tönen, was früheren Algorithmen nicht möglich struggle. „Herkömmliche Methoden verwenden ein einziges Klassentoken, aber unser Ansatz vergleicht jedes Pixel und jede Sekunde des Tons. Diese feinkörnige Methode ermöglicht es DenseAV, detailliertere Verbindungen für eine bessere Lokalisierung herzustellen“, sagt Hamilton.

Die Forscher trainierten DenseAV mit AudioSet, das 2 Millionen YouTube-Movies enthält. Sie erstellten auch neue Datensätze, um zu testen, wie intestine das Modell Töne und Bilder verknüpfen kann. In diesen Exams übertraf DenseAV andere Topmodelle bei Aufgaben wie der Identifizierung von Objekten anhand ihrer Namen und Töne und bewies damit seine Wirksamkeit. „Frühere Datensätze unterstützten nur grobe Bewertungen, additionally erstellten wir einen Datensatz mit semantischen Segmentierungsdatensätzen. Dies hilft bei pixelgenauen Anmerkungen für eine präzise Bewertung der Leistung unseres Modells. Wir können den Algorithmus mit bestimmten Tönen oder Bildern auffordern und diese detaillierten Lokalisierungen erhalten“, sagt Hamilton.

Aufgrund der enormen Datenmenge dauerte die Fertigstellung des Projekts etwa ein Jahr. Das Crew sagt, dass der Übergang zu einer großen Transformer-Architektur eine Herausforderung darstellte, da diese Modelle leicht feinkörnige Particulars übersehen können. Das Modell dazu zu bringen, sich auf diese Particulars zu konzentrieren, struggle eine erhebliche Hürde.

Mit Blick auf die Zukunft möchte das Crew Systeme entwickeln, die aus riesigen Mengen reiner Video- oder Audiodaten lernen können. Dies ist für neue Bereiche von entscheidender Bedeutung, in denen es viele dieser Modi gibt, aber nicht zusammen. Sie möchten dies auch mithilfe größerer Backbones skalieren und möglicherweise Wissen aus Sprachmodellen integrieren, um die Leistung zu verbessern.

„Das Erkennen und Segmentieren visueller Objekte in Bildern sowie von Umgebungsgeräuschen und gesprochenen Wörtern in Audioaufnahmen sind jeweils für sich genommen schwierige Probleme. In der Vergangenheit haben sich Forscher auf teure, von Menschen erstellte Anmerkungen verlassen, um maschinelle Lernmodelle für diese Aufgaben zu trainieren“, sagt David Harwath, Assistenzprofessor für Informatik an der College of Texas in Austin, der nicht an der Arbeit beteiligt struggle. „DenseAV macht bedeutende Fortschritte bei der Entwicklung von Methoden, die lernen können, diese Aufgaben gleichzeitig zu lösen, indem sie die Welt einfach durch Sehen und Hören beobachten – basierend auf der Erkenntnis, dass die Dinge, die wir sehen und mit denen wir interagieren, oft Geräusche erzeugen und wir auch gesprochene Sprache verwenden, um über sie zu sprechen. Dieses Modell macht auch keine Annahmen über die spezifische Sprache, die gesprochen wird, und könnte daher im Prinzip aus Daten in jeder Sprache lernen. Es wäre spannend zu sehen, was DenseAV lernen könnte, wenn es auf Tausende oder Millionen Stunden Videodaten in einer Vielzahl von Sprachen skaliert würde.“

Weitere Autoren auf einer Papier mit Beschreibung der Arbeit sind Andrew Zisserman, Professor für Pc Imaginative and prescient Engineering an der Universität Oxford; John R. Hershey, Google AI Notion-Forscher; und William T. Freeman, Professor für Elektrotechnik und Informatik am MIT und leitender Forscher am CSAIL. Ihre Forschung wurde teilweise von der US Nationwide Science Basis, einer Royal Society Analysis Professur und einem EPSRC Programme Grant Visible AI unterstützt. Diese Arbeit wird diesen Monat auf der IEEE/CVF Pc Imaginative and prescient and Sample Recognition Convention vorgestellt.