Versuchen Sie, von jedem einzelnen Nordamerika ein Foto zu machen rund 11.000 Baumarten, und Sie haben nur einen Bruchteil der Millionen Fotos in Naturbilddatensätzen. Diese riesigen Sammlungen von Schnappschüssen – von Schmetterlinge Zu Buckelwale – sind ein großartiges Forschungsinstrument für Ökologen, da sie Beweise für das einzigartige Verhalten von Organismen, seltene Bedingungen, Migrationsmuster und Reaktionen auf Umweltverschmutzung und andere Formen des Klimawandels liefern.

Naturbilddatensätze sind zwar umfassend, aber noch nicht so nützlich, wie sie sein könnten. Es ist zeitaufwändig, diese Datenbanken zu durchsuchen und die Bilder abzurufen, die für Ihre Hypothese am relevantesten sind. Mit einem automatisierten Forschungsassistenten sind Sie besser dran – oder vielleicht mit Systemen der künstlichen Intelligenz, die als multimodale Imaginative and prescient-Language-Fashions (VLMs) bezeichnet werden. Sie sind sowohl mit Texten als auch mit Bildern vertraut, was es ihnen erleichtert, feinere Particulars zu erkennen, wie zum Beispiel die spezifischen Bäume im Hintergrund eines Fotos.

Doch wie intestine können VLMs Naturforscher bei der Bildgewinnung unterstützen? Ein Crew des Laptop Science and Synthetic Intelligence Laboratory (CSAIL) des MIT, des College Faculty London, von iNaturalist und anderswo hat einen Leistungstest entwickelt, um das herauszufinden. Die Aufgabe jedes VLM besteht darin, die relevantesten Ergebnisse im „INQUIRE“-Datensatz des Groups zu lokalisieren und neu zu organisieren, der aus 5 Millionen Wildtierbildern und 250 Suchaufforderungen von Ökologen und anderen Biodiversitätsexperten besteht.

Auf der Suche nach diesem besonderen Frosch

Bei diesen Auswertungen stellten die Forscher fest, dass größere, fortschrittlichere VLMs, die auf weitaus mehr Daten trainiert werden, den Forschern manchmal die gewünschten Ergebnisse liefern können. Bei einfachen Abfragen zu visuellen Inhalten, etwa der Identifizierung von Trümmern auf einem Riff, schnitten die Modelle einigermaßen intestine ab, bei Abfragen, die Expertenwissen erforderten, etwa der Identifizierung spezifischer biologischer Bedingungen oder Verhaltensweisen, hatten sie jedoch erhebliche Probleme. VLMs entdeckten zum Beispiel relativ leicht Exemplare von Quallen am Strand, hatten aber Probleme mit eher technischen Eingabeaufforderungen wie „Axanthismus bei einem grünen Frosch“, einem Zustand, der ihre Fähigkeit, ihre Haut gelb zu färben, einschränkt.

Ihre Ergebnisse deuten darauf hin, dass die Modelle viel mehr domänenspezifische Trainingsdaten benötigen, um schwierige Abfragen zu verarbeiten. MIT-Doktorand Edward Vendrow, ein CSAIL-Accomplice, der die Arbeit am Datensatz in einem neuen Jahr mitleitete Papierglaubt, dass die VLMs eines Tages großartige Forschungsassistenten sein könnten, wenn sie sich mit informativeren Daten vertraut machen. „Wir wollen Abrufsysteme aufbauen, die genau die Ergebnisse finden, die Wissenschaftler bei der Überwachung der Artenvielfalt und der Analyse des Klimawandels suchen“, sagt Vendrow. „Multimodale Modelle verstehen komplexere wissenschaftliche Sprache noch nicht ganz, aber wir glauben, dass INQUIRE ein wichtiger Maßstab sein wird, um zu verfolgen, wie sie sich beim Verständnis wissenschaftlicher Terminologie verbessern und letztendlich Forschern dabei helfen, automatisch genau die Bilder zu finden, die sie benötigen.“

Die Experimente des Groups zeigten, dass größere Modelle aufgrund ihrer umfangreichen Trainingsdaten tendenziell sowohl für einfachere als auch komplexere Suchvorgänge effektiver waren. Sie verwendeten zunächst den INQUIRE-Datensatz, um zu testen, ob VLMs einen Pool von 5 Millionen Bildern auf die 100 relevantesten Ergebnisse eingrenzen können (auch als „Rating“ bekannt). Für einfache Suchanfragen wie „ein Riff mit künstlichen Strukturen und Trümmern“ werden relativ große Modelle wie „SigLIP” passende Bilder gefunden, während kleinere CLIP-Modelle Schwierigkeiten hatten. Laut Vendrow beginnen größere VLMs „erst langsam nützlich zu sein“, wenn es um das Rating schwierigerer Abfragen geht.

Vendrow und seine Kollegen bewerteten außerdem, wie intestine multimodale Modelle diese 100 Ergebnisse neu einordnen und neu organisieren konnten, welche Bilder für eine Suche am relevantesten waren. In diesen Exams hatten selbst große LLMs, die auf stärker kuratierten Daten trainiert wurden, wie GPT-4o, Probleme: Der Präzisionswert betrug nur 59,6 Prozent, der höchste Wert, der von jedem Modell erreicht wurde.

Die Forscher stellten diese Ergebnisse Anfang des Monats auf der Convention on Neural Info Processing Techniques (NeurIPS) vor.

Anfragen für INQUIRE

Der INQUIRE-Datensatz enthält Suchanfragen, die auf Gesprächen mit Ökologen, Biologen, Ozeanographen und anderen Experten über die Arten von Bildern basieren, nach denen sie suchen würden, einschließlich der einzigartigen physischen Bedingungen und Verhaltensweisen der Tiere. Ein Crew von Annotatoren verbrachte dann 180 Stunden damit, den iNaturalist-Datensatz mit diesen Eingabeaufforderungen zu durchsuchen und sorgfältig etwa 200.000 Ergebnisse zu durchsuchen, um 33.000 Übereinstimmungen zu kennzeichnen, die zu den Eingabeaufforderungen passten.

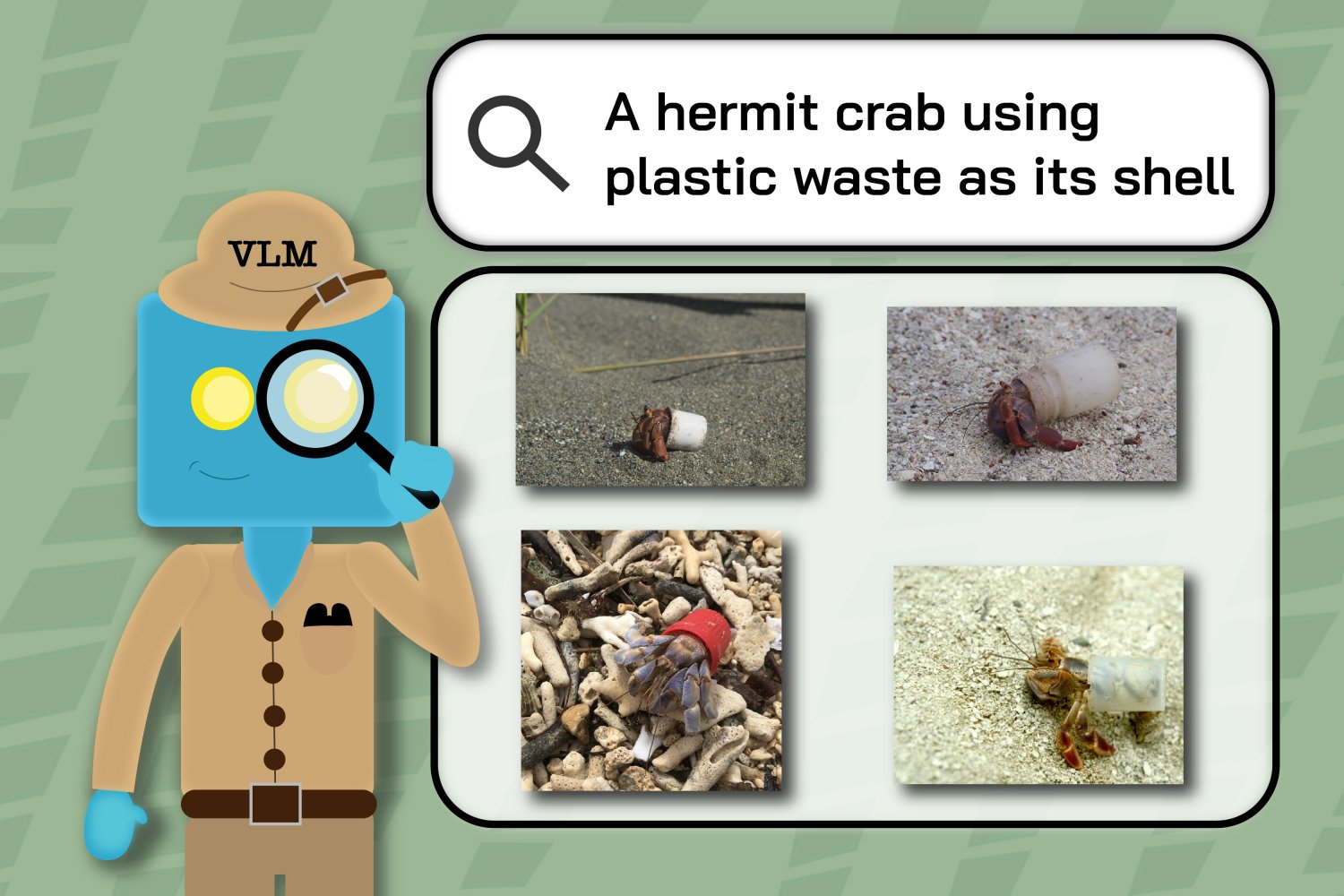

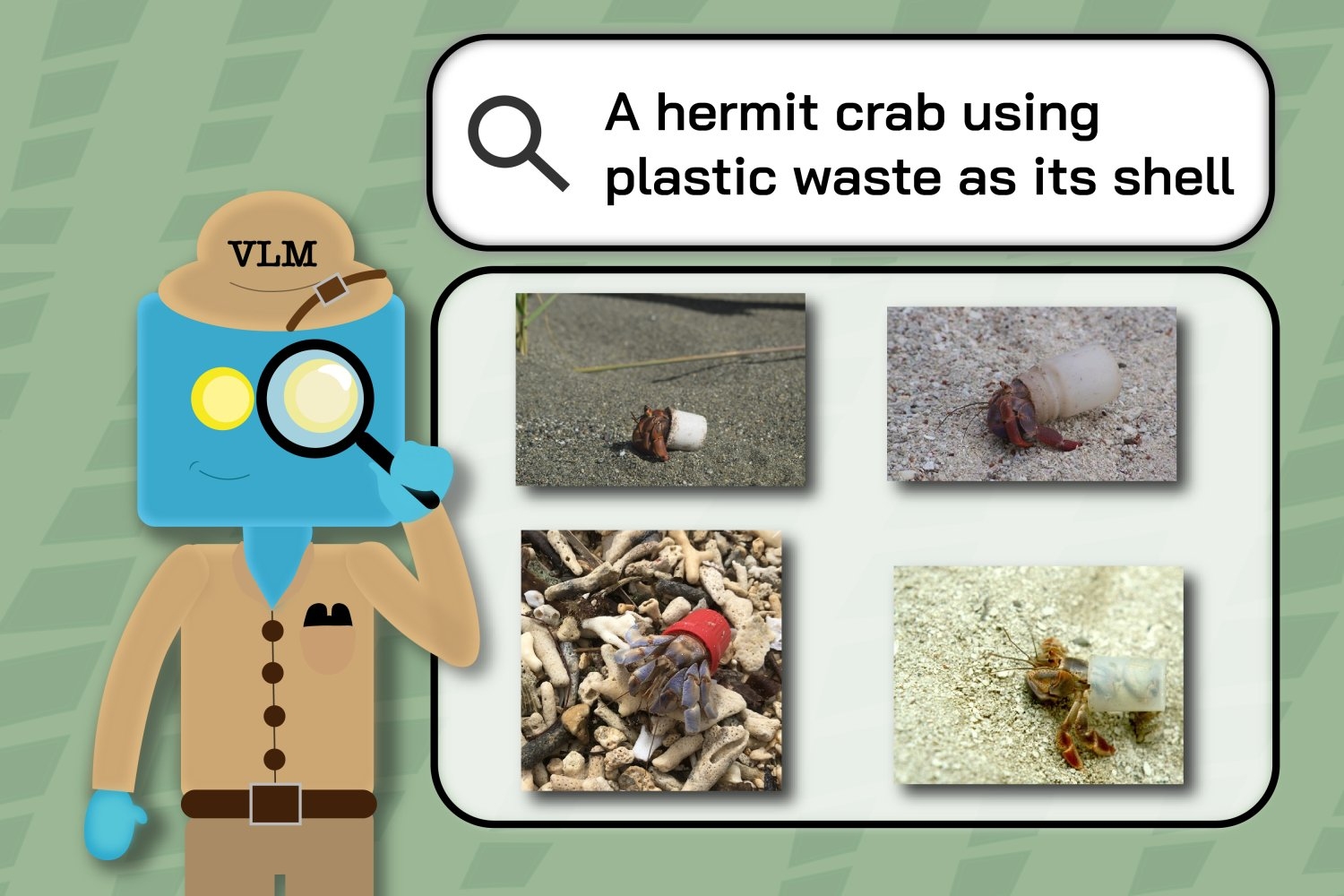

Beispielsweise nutzten die Annotatoren Abfragen wie „Ein Einsiedlerkrebs, der Plastikmüll als Schale nutzt“ und „Ein kalifornischer Kondor mit der grünen ‚26‘“, um die Teilmengen des größeren Bilddatensatzes zu identifizieren, die diese spezifischen, seltenen Ereignisse darstellen.

Anschließend verwendeten die Forscher dieselben Suchanfragen, um zu sehen, wie intestine VLMs iNaturalist-Bilder abrufen konnten. Die Beschriftungen der Annotatoren wurden sichtbar, als die Modelle Schwierigkeiten hatten, die Schlüsselwörter der Wissenschaftler zu verstehen, da ihre Ergebnisse Bilder enthielten, die zuvor als für die Suche irrelevant markiert worden waren. Beispielsweise enthielten die VLM-Ergebnisse für „Mammutbäume mit Feuernarben“ manchmal Bilder von Bäumen ohne Markierungen.

„Dabei handelt es sich um eine sorgfältige Kuratierung von Daten, wobei der Schwerpunkt auf der Erfassung realer Beispiele wissenschaftlicher Untersuchungen in allen Forschungsbereichen der Ökologie und Umweltwissenschaften liegt“, sagt Sara Beery, Homer A. Burnell Profession Improvement Assistant Professor am MIT, CSAIL-Hauptforscherin und Co -leitender Autor des Werkes. „Es hat sich als entscheidend erwiesen, unser Verständnis der aktuellen Fähigkeiten von VLMs in diesen potenziell einflussreichen wissenschaftlichen Umgebungen zu erweitern. Es wurden auch Lücken in der aktuellen Forschung aufgezeigt, an deren Behebung wir jetzt arbeiten können, insbesondere bei komplexen kompositorischen Fragen, technischer Terminologie und den feinkörnigen, subtilen Unterschieden, die Kategorien abgrenzen, die für unsere Mitarbeiter von Interesse sind.“

„Unsere Ergebnisse deuten darauf hin, dass einige Sehmodelle bereits präzise genug sind, um Wildtierwissenschaftlern beim Abrufen einiger Bilder zu helfen, aber viele Aufgaben sind selbst für die größten und leistungsstärksten Modelle immer noch zu schwierig“, sagt Vendrow. „Obwohl sich INQUIRE auf die Überwachung von Ökologie und Biodiversität konzentriert, bedeutet die große Vielfalt seiner Abfragen, dass VLMs, die bei INQUIRE intestine abschneiden, wahrscheinlich bei der Analyse großer Bildsammlungen in anderen beobachtungsintensiven Bereichen hervorragende Ergebnisse erzielen werden.“

Neugierige wollen sehen

Um ihr Projekt weiterzuführen, arbeiten die Forscher mit iNaturalist zusammen, um ein Abfragesystem zu entwickeln, das Wissenschaftlern und anderen Neugierigen dabei helfen soll, die Bilder zu finden, die sie tatsächlich sehen möchten. Ihre Arbeit Demo ermöglicht Benutzern das Filtern von Suchen nach Arten und ermöglicht so eine schnellere Entdeckung relevanter Ergebnisse, wie beispielsweise der verschiedenen Augenfarben von Katzen. Vendrow und der Co-Hauptautor Omiros Pantazis, der kürzlich am College Faculty London promoviert hat, wollen außerdem das Reranking-System verbessern, indem sie aktuelle Modelle erweitern, um bessere Ergebnisse zu liefern.

Justin Kitzes, außerordentlicher Professor an der College of Pittsburgh, hebt die Fähigkeit von INQUIRE hervor, Sekundärdaten aufzudecken. „Biodiversitätsdatensätze werden schnell zu groß, als dass sie von einzelnen Wissenschaftlern überprüft werden könnten“, sagt Kitzes, der nicht an der Forschung beteiligt battle. „Dieser Artikel lenkt die Aufmerksamkeit auf ein schwieriges und ungelöstes Downside, nämlich wie man solche Daten effektiv mit Fragen durchsuchen kann, die über die bloße Frage „Wer ist hier?“ hinausgehen und stattdessen nach individuellen Merkmalen, Verhalten und Arteninteraktionen fragen. Die Fähigkeit, diese komplexeren Phänomene in Bilddaten zur Biodiversität effizient und genau aufzudecken, wird für die Grundlagenforschung und die realen Auswirkungen auf Ökologie und Naturschutz von entscheidender Bedeutung sein.“

Vendrow, Pantazis und Beery haben das Papier zusammen mit dem iNaturalist-Softwareentwickler Alexander Shepard, den Professoren des College Faculty London, Gabriel Brostow und Kate Jones, dem außerordentlichen Professor und Co-Senior-Autor der College of Edinburgh, Oisin Mac Aodha, und dem Assistenzprofessor der College of Amherst, Grant Van, verfasst Horn, der als Co-Senior-Autor fungierte. Ihre Arbeit wurde teilweise vom Generative AI Laboratory der College of Edinburgh, der US Nationwide Science Basis/Pure Sciences and Engineering Analysis Council of Canada International Centre on AI and Biodiversity Change, einem Forschungsstipendium der Royal Society und dem Biome unterstützt Gesundheitsprojekt, finanziert vom World Wildlife Fund Großbritannien.