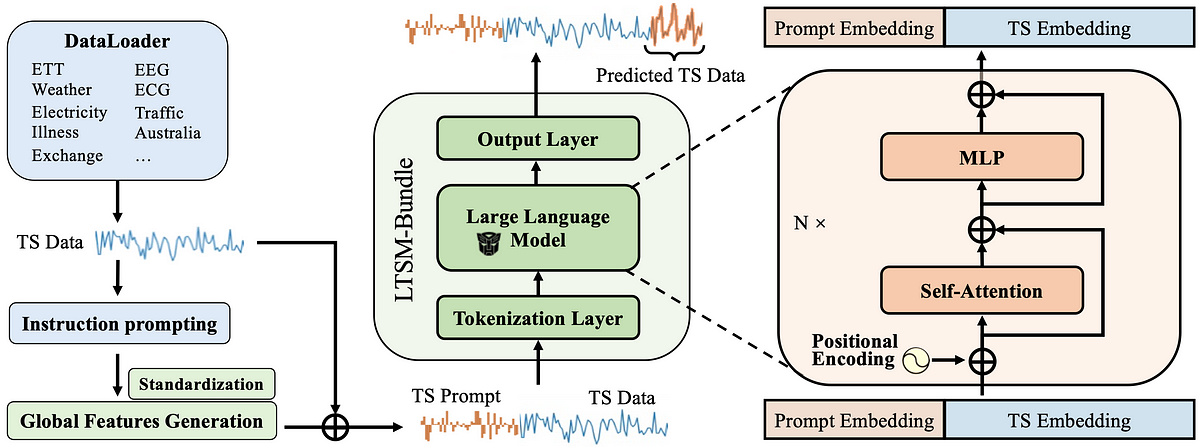

6. Durch die Bündelung all dieser Erkenntnisse entsteht ein LTSM-Modell (LTSM-Bundle), das alle bestehenden Methoden übertrifft, die LLM für Zeitreihen und transformerbasierte Zeitreihenprognosemodelle neu programmieren.

Programmieren Sie ein LTSM selbst neu!

Willst du versuchen, dein eigenes LTSM neu zu programmieren? Hier ist das Tutorial für das LTSM-Bundle: https://github.com/daochenzha/ltsm/blob/fundamental/tutorial/README.md

Schritt 1: Erstellen Sie eine virtuelle Umgebung. Klonen und installieren Sie die Anforderungen und das Repository.

conda create -n ltsm python=3.8.0

conda activate ltsm

git clone git@github.com:daochenzha/ltsm.git

cd ltsm

pip3 set up -e .

pip3 set up -r necessities.txt

Schritt 2: Bereiten Sie Ihren Datensatz vor. Stellen Sie sicher, dass Ihr lokaler Datenordner wie folgt aussieht:

- ltsm/

- datasets/

DATA_1.csv/

DATA_2.csv/

DATA_3.csv/

...

Schritt 3: Generieren der Zeitreiheneingabeaufforderungen aus Trainings-, Validierungs- und Testdatensätzen

python3 prompt_generate_split.py

Schritt 4: Suchen Sie die generierten Zeitreihen-Eingabeaufforderungen im Ordner „./prompt_data_split“. Führen Sie dann den folgenden Befehl aus, um die Eingabeaufforderungen abzuschließen:

# normalizing the prompts

python3 prompt_normalization_split.py --mode match#export the prompts to the "./prompt_data_normalize_split" folder

python3 prompt_normalization_split.py --mode remodel

Letzter Schritt: Trainieren Sie Ihr eigenes LTSM mit Time Collection Immediate und Linear Tokenization auf gpt2-medium.

python3 main_ltsm.py

--model LTSM

--model_name_or_path gpt2-medium

--train_epochs 500

--batch_size 10

--pred_len 96

--data_path "DATA_1.csv DATA_2.csv"

--test_data_path_list "DATA_3.csv"

--prompt_data_path "prompt_bank/prompt_data_normalize_split"

--freeze 0

--learning_rate 1e-3

--downsample_rate 20

--output_dir (Your_Output_Path)

Weitere Einzelheiten finden Sie in unserem Dokument und im GitHub-Repo:

Papier: https://arxiv.org/pdf/2406.14045

Code: https://github.com/daochenzha/ltsm/

Referenz:

(1) Liu, Pengfei, et al. „Vorab trainieren, auffordern und vorhersagen: Eine systematische Untersuchung von Eingabeaufforderungsmethoden in der Verarbeitung natürlicher Sprache.“ ACM Computing-Umfragen 55.9 (2023): 1–35.

(2) Liu, Xiao, et al. „Selbstüberwachtes Lernen: Generativ oder kontrastiv.“ IEEE-Transaktionen zu Wissens- und Datentechnik 35.1 (2021): 857–876.

(3) Ansari, Abdul Fatir, et al. „Chronos: Die Sprache der Zeitreihen lernen.“ arXiv-Vorabdruck arXiv:2403.07815 (2024).