Wenn es um künstliche Intelligenz geht, kann der Schein trügen. Das Geheimnis um die Funktionsweise großer Sprachmodelle (LLMs) rührt von ihrer enormen Größe, ihren komplexen Trainingsmethoden, ihrem schwer vorhersehbaren Verhalten und ihrer schwer fassbaren Interpretierbarkeit her.

Forscher des Pc Science and Synthetic Intelligence Laboratory (CSAIL) des MIT haben kürzlich unter die sprichwörtliche Lupe geschaut, um zu untersuchen, wie LL.M. bei Variationen verschiedener Aufgaben abschneiden. Dabei kamen faszinierende Erkenntnisse über das Zusammenspiel zwischen Gedächtnis- und Denkfähigkeiten ans Licht. Es stellte sich heraus, dass ihre Denkfähigkeiten oft überschätzt werden.

Die Studie verglich „Standardaufgaben“, additionally die üblichen Aufgaben, für die ein Modell trainiert und getestet wird, mit „kontrafaktischen Szenarien“, additionally hypothetischen Situationen, die von den Standardbedingungen abweichen – mit denen Modelle wie GPT-4 und Claude normalerweise zurechtkommen. Die Forscher entwickelten einige Exams außerhalb der Komfortzonen der Modelle, indem sie bestehende Aufgaben optimierten, anstatt völlig neue zu erstellen. Sie verwendeten eine Vielzahl von Datensätzen und Benchmarks, die speziell auf verschiedene Aspekte der Fähigkeiten der Modelle zugeschnitten waren, beispielsweise für Arithmetik, Schach, Codeauswertung, Beantwortung logischer Fragen usw.

Wenn Benutzer mit Sprachmodellen interagieren, erfolgt jede Arithmetik normalerweise in der Foundation 10, der den Modellen vertrauten Zahlenbasis. Wenn wir jedoch beobachten, dass sie in der Foundation 10 intestine abschneiden, könnte uns dies den falschen Eindruck vermitteln, dass sie über starke Kompetenzen im Addieren verfügen. Wenn sie wirklich über gute Additionsfähigkeiten verfügen, würde man logischerweise eine zuverlässig hohe Leistung in allen Zahlenbasen erwarten, ähnlich wie bei Taschenrechnern oder Computern. Tatsächlich hat die Forschung gezeigt, dass diese Modelle nicht so sturdy sind, wie viele zunächst denken. Ihre hohe Leistung ist auf gängige Aufgabenvarianten beschränkt und leidet unter einem konsistenten und starken Leistungsabfall in den ungewohnten kontrafaktischen Szenarien, was auf einen Mangel an verallgemeinerbaren Additionsfähigkeiten hindeutet.

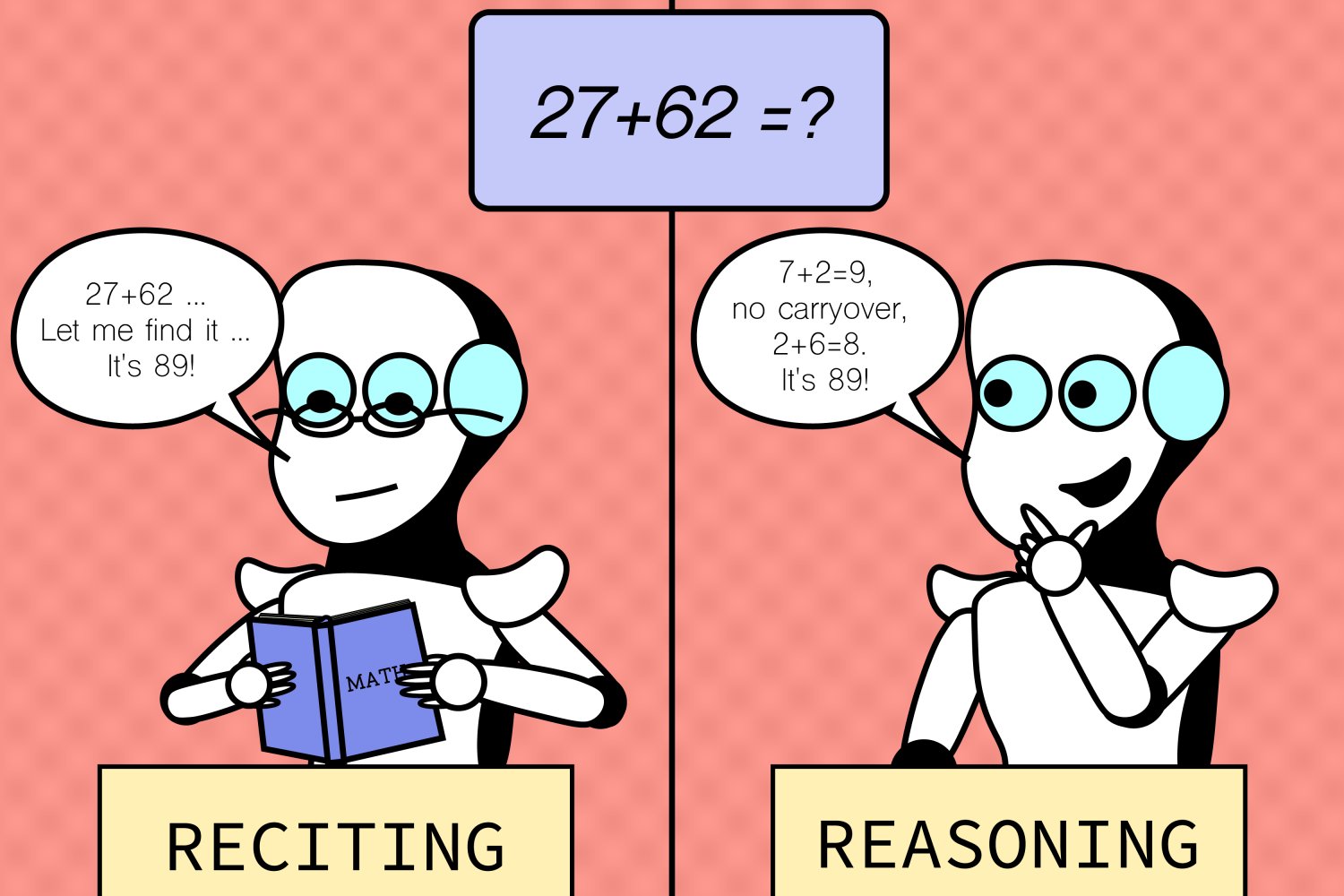

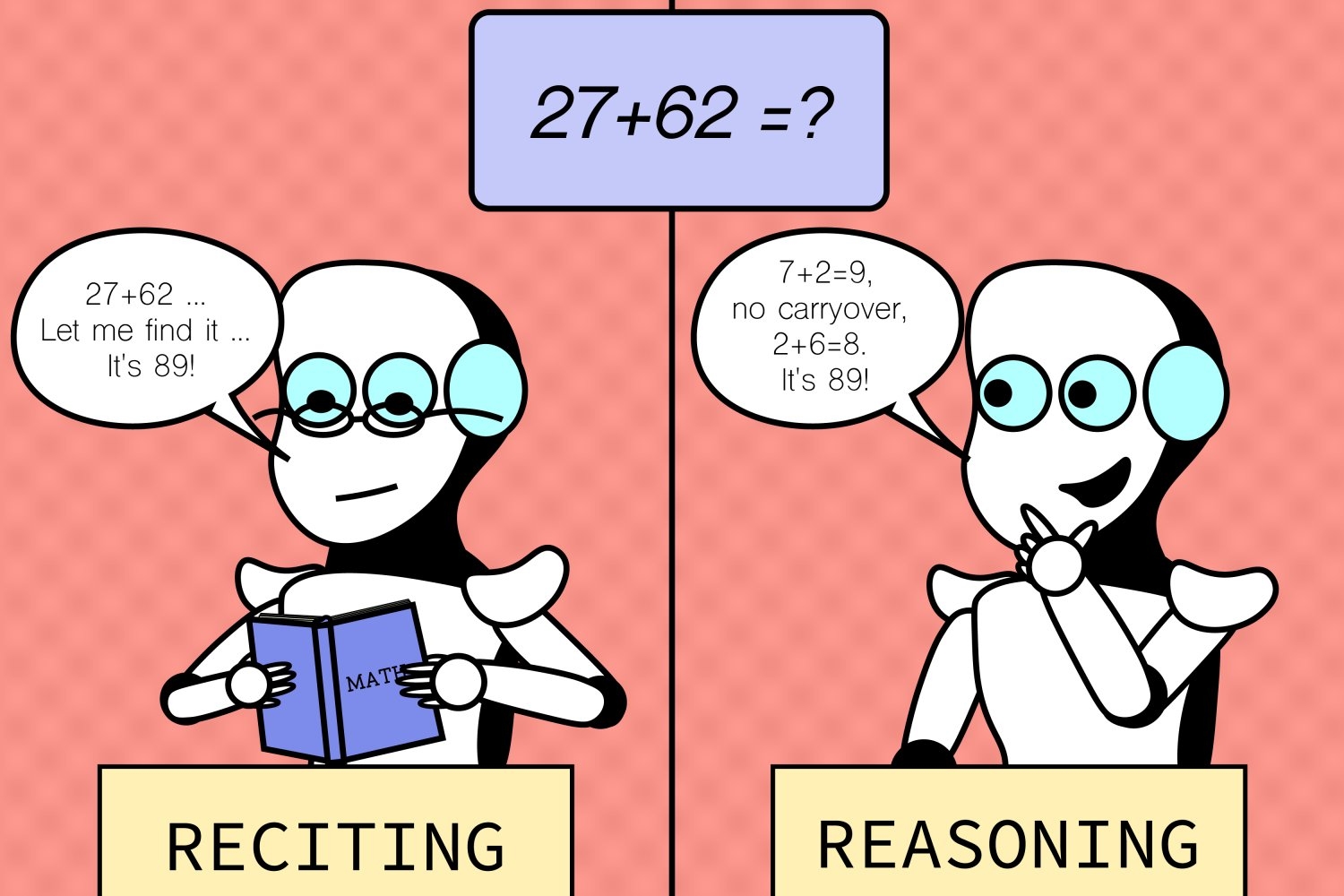

Das Muster galt auch für viele andere Aufgaben, wie das Greifen musikalischer Akkorde, räumliches Vorstellungsvermögen und sogar Schachaufgaben, bei denen die Startpositionen der Figuren leicht verändert wurden. Während von menschlichen Spielern erwartet wird, dass sie in veränderten Szenarien (mit genügend Zeit) immer noch die Rechtmäßigkeit von Zügen bestimmen können, hatten die Modelle Schwierigkeiten und konnten nicht besser abschneiden als durch zufälliges Raten, was bedeutet, dass sie nur begrenzt in der Lage sind, auf unbekannte Situationen zu verallgemeinern. Und ein Großteil ihrer Leistung bei den Standardaufgaben ist wahrscheinlich nicht auf allgemeine Aufgabenfähigkeiten zurückzuführen, sondern auf Überanpassung an oder direktes Auswendiglernen dessen, was sie in ihren Trainingsdaten gesehen haben.

„Wir haben einen faszinierenden Aspekt großer Sprachmodelle entdeckt: Sie sind in vertrauten Szenarien hervorragend, quick wie ein ausgetretener Pfad, haben aber Probleme, wenn das Terrain unbekannt wird. Diese Erkenntnis ist entscheidend, da wir versuchen, die Anpassungsfähigkeit dieser Modelle zu verbessern und ihren Anwendungshorizont zu erweitern“, sagt Zhaofeng Wu, ein MIT-Doktorand in Elektrotechnik und Informatik, CSAIL-Mitglied und Hauptautor eines neuen Papier über die Forschung. „Da KI in unserer Gesellschaft immer allgegenwärtiger wird, muss sie zuverlässig mit unterschiedlichen Szenarien umgehen können, ob vertraut oder nicht. Wir hoffen, dass diese Erkenntnisse eines Tages in die Entwicklung zukünftiger LLMs mit verbesserter Robustheit einfließen werden.“

Trotz der gewonnenen Erkenntnisse gibt es natürlich auch Einschränkungen. Der Fokus der Studie auf bestimmte Aufgaben und Einstellungen erfasste nicht die gesamte Bandbreite an Herausforderungen, denen die Modelle in realen Anwendungen begegnen könnten, was auf die Notwendigkeit vielfältigerer Testumgebungen hindeutet. Zukünftige Arbeiten könnten eine Ausweitung des Aufgabenspektrums und kontrafaktischer Bedingungen beinhalten, um weitere potenzielle Schwachstellen aufzudecken. Dies könnte bedeuten, komplexere und weniger gängige Szenarien zu untersuchen. Das Group möchte auch die Interpretierbarkeit verbessern, indem es Methoden entwickelt, um die Gründe hinter den Entscheidungsprozessen der Modelle besser zu verstehen.

„Mit der Skalierung von Sprachmodellen wird das Verstehen ihrer Trainingsdaten selbst für offene Modelle, ganz zu schweigen von proprietären, immer schwieriger“, sagt Hao Peng, Assistenzprofessor an der College of Illinois in Urbana-Champaign. „Die Group ist weiterhin verwirrt, ob diese Modelle tatsächlich auf unvorhergesehene Aufgaben verallgemeinert werden können oder ob sie scheinbar durch das Auswendiglernen der Trainingsdaten erfolgreich sind. Dieses Papier macht wichtige Fortschritte bei der Beantwortung dieser Frage. Es erstellt eine Reihe sorgfältig konzipierter kontrafaktischer Bewertungen und bietet neue Einblicke in die Fähigkeiten modernster LLMs. Es zeigt, dass ihre Fähigkeit, unvorhergesehene Aufgaben zu lösen, möglicherweise weitaus eingeschränkter ist als von vielen erwartet. Es hat das Potenzial, zukünftige Forschungen zur Identifizierung der Fehlermodi heutiger Modelle und zur Entwicklung besserer Modelle anzuregen.“

Weitere Autoren sind Najoung Kim, Assistenzprofessor an der Boston College und Gastforscher bei Google, und sieben CSAIL-Mitglieder: die Doktoranden der Elektrotechnik und Informatik (EECS) des MIT Linlu Qiu, Alexis Ross, Ekin Akyürek SM ’21 und Boyuan Chen, der ehemalige Postdoc und Apple AI/ML-Forscher Bailin Wang sowie die EECS-Assistenzprofessoren Jacob Andreas und Yoon Kim.

Die Studie des Groups wurde teilweise vom MIT–IBM Watson AI Lab, dem MIT Quest for Intelligence und der Nationwide Science Basis unterstützt. Das Group präsentierte die Arbeit letzten Monat beim nordamerikanischen Kapitel der Affiliation for Computational Linguistics (NAACL).