Die Lama 4-Modelsfamilie von Meta regiert derzeit die immer wieder hergestellte Welt der KI. Diese Modelle revolutionieren, wie wir intelligente Systeme mit ihren nativen multimodalen Funktionen aufbauen. Wann Lama 4 Kombiniert mit Autogen, ermöglicht es das volle Potenzial, dynamische, reaktionsschnelle und robuste AI -Wirkstoffe aufzubauen. Durch Nutzung der Integration zwischen Lama 4 und AutogenEntwickler können progressive KI -Agenten schaffen, die die effiziente Argumente, Zusammenarbeit und Anpassung anpassen und sich anpassen können. In diesem Artikel lernen wir, wie Sie KI -Agenten mit Lama 4 und Autogen für bestimmte Anwendungen bauen.

Warum sollten wir in Betracht ziehen, Lama 4 zu verwenden?

Die Lama 4 Mannequin-Familie, einschließlich Scout- und Maverick-Varianten, stellt einen signifikanten Sprung nach vorne in der Open-Supply-KI-Technologie dar. Diese Modelle bieten mehrere wichtige Vorteile:

- Multimodale Intelligenz: LLAMA 4 verfügt über native multimodale Funktionen, die verschiedene Arten von Enter in eine einheitliche Architektur integrieren. Dies ermöglicht komplexere Argumentation über verschiedene Medientypen hinweg.

- Große Kontextlänge: Es unterstützt bis zu 10 Millionen Token und erweitert sich Lama 3‚S 128K Grenze. Es ermöglicht den Umgang mit außergewöhnlich langen Kontexten. Dies ermöglicht erweiterte Anwendungen wie eine umfassende Multi-Dokument-Analyse, eine umfassende Personalisierung basierend auf dem Benutzerverlauf und die Navigation großer Codebasen.

- Effiziente Leistung: Lama 4 verwendet eine Mischung aus Expertenarchitektur, die nur bestimmte Teile des Modells für jeden verarbeiteten Token aktiviert. Dieser Ansatz macht die Modelle hocheffizient. LAMA 4 Maverick zum Beispiel verwendet während des Betriebs nur 17 Milliarden seiner insgesamt 400 Milliarden Parameter. Dadurch kann es auf einem einzelnen H100 -DGX -Host ausgeführt werden.

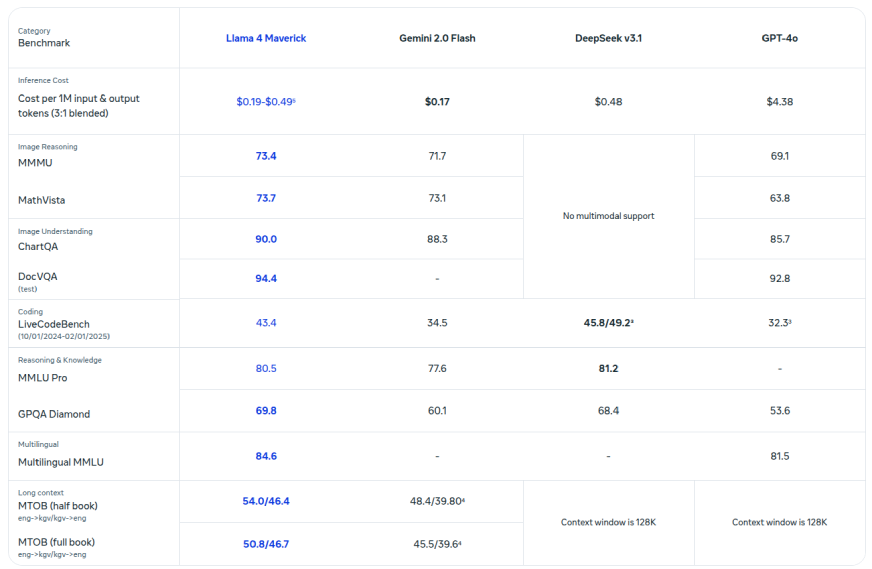

- Überlegene Leistung und Fähigkeiten: Benchmark-Assessments zeigt, dass Lama 4 Maverick vergleichbare Modelle wie GPT-4O und Gemini 2.0 über Codierung, Argumentation, mehrsprachige Funktionen und Bildverständnisse übertreffen.

- Open Supply und zugänglich: Meta macht Modelle zum Obtain zur Verfügung. Dies fördert offene Innovationen und ermöglicht es Entwicklern, die Technologie über verschiedene Anwendungen und Plattformen hinweg anzupassen und bereitzustellen.

Lesen Sie auch: Deepseek v3 vs. llama 4: Auswahl des richtigen KI -Modells für Sie

Lama 4 Benchmark -Leistung

Um zu verstehen, wie intestine dieses Modell ist, finden Sie hier einen Vergleich von Lama 4 mit anderen Topmodellen für verschiedene Commonplace -Benchmarks.

Lesen Sie auch: LAMA 4 gegen GPT-4O: Was ist besser für Lumpen?

Bauen eines KI -Agenten mit Lama 4

In diesem Abschnitt werde ich Sie durch den Prozess des Aufbaus von aufgabenspezifischen Wirkstoffen mit Lama 4 und Autogen führen. Wir erstellen ein Multi-Agent-System, das die Kundenanforderungen für einen Job analysiert, Freiberufler für den jeweiligen Job basierend auf seiner Erfahrung und Particulars findet und dann benutzerdefinierte Jobvorschläge für den Benutzer generiert. Additionally fangen wir an.

Lesen Sie auch: Praktische Anleitung zum Aufbau von Chatbots mit Multi-Agent-Chatbots mit Autogen

Schritt 0: Einrichten der Umgebung

Vor dem Bau des Agenten werden wir zunächst die erforderlichen Voraussetzungen abdecken und die Umgebung einrichten.

Voraussetzungen

Zugriff auf die API

Wir werden die gemeinsame API hier verwenden, um auf das Lama 4 -Modell zuzugreifen. Erstellen Sie ein Konto zusammen mit AI und besuchen Sie diese Seite, um Ihren geheimen Schlüssel zu erstellen: https://api.collectively.xyz/

Schritt 1: Einrichten von Bibliotheken und Instruments, um die AI -Agenten zu leiten

Erstens werden wir alle notwendigen Bibliotheken und Instruments importieren, die wir hier benötigen.

import os

import autogen

from IPython.show import show, MarkdownSchritt 2: Aufrufen der API

Um das Lama 4 zu verwenden, müssen wir die gemeinsame API laden. Der folgende Codeblock hilft uns, die APIs zu laden und sie in die Umgebung zu konfigurieren.

with open("together_ai_api.txt") as file:

LLAMA_API_KEY = file.learn().strip()

os.environ("LLAMA_API_KEY") = LLAMA_API_KEYSchritt 3: Erstellen von Agenten und Definieren von Aufgaben

Lassen Sie uns nun die erforderlichen Agenten erstellen und ihre Aufgaben definieren, dh was sie tun werden.

1. Consumer -Eingangsagent

Der Consumer Enter Agent fungiert als primäre Schnittstelle zwischen dem menschlichen Benutzer und dem Agentensystem. Es sammelt Projektdetails wie Kundenanforderungen, Zeitachse und Funds vom Benutzer und übergeben sie an den Scope -Architekten. Es gibt auch Observe-up-Fragen und Antworten weiter und signalisiert die Kündigung, wenn der endgültige Vorschlag akzeptiert wird.

Erwartete Ausgabe:

- Übertragung der Projektbeschreibung des Benutzers und des Freiberuflerprofils (Fähigkeiten, Erfahrung, Zeitschätzung).

- Beendet die Sitzung, sobald ein zufriedenstellender Vorschlag geliefert wird, oder der Benutzer wird sie explizit beenden.

# Agent 1: Handles Human Enter for Consumer Necessities

client_agent = autogen.UserProxyAgent(

identify="Client_Input_Agent",

human_input_mode="ALWAYS", # asks the human for enter

max_consecutive_auto_reply=1, # Solely reply as soon as

is_termination_msg=lambda x: x.get("content material", "").rstrip().endswith("TERMINATE"),

system_message="""You're the main level of contact for the consumer.

Your first job is to offer the preliminary mission particulars acquired from the human consumer (shopper necessities, product particulars, timeline, funds) to the group chat.

After the Scope Architect asks questions, relay the human consumer's solutions about their expertise, expertise, instruments, and time estimate again to the chat.

Reply TERMINATE when the ultimate proposal is generated and passable, or if the consumer needs to cease. In any other case, relay the consumer's enter.

""",

)

2. Scope Architect Agent

Der Scope Architect Agent ist für die ersten Projektdetails des Consumer -Eingabedagers verantwortlich. Danach stellt es spezifische Fragen, um die Fähigkeiten, Werkzeuge, die vergangenen Projekterfahrung des Freiberuflers und die geschätzte Zeit zu sammeln, um die Arbeit zu erledigen. Es wird nicht zur Erzeugung von Vorschlägen selbst fortgesetzt, sondern stellt sicher, dass der gesamte erforderliche Kontext gesammelt wird, bevor er dem nächsten Agenten übergibt.

Erwartete Ausgabe:

- Eine intestine strukturierte Zusammenfassung, die sowohl die Projektanforderungen des Kunden als auch die Fähigkeiten des Freiberuflers kombiniert.

- Löst den Fee -Empfehlungsagenten aus, sobald alle erforderlichen Daten gesammelt und zusammengefasst sind.

# Agent 2: Gathers Consumer's Profile and Estimates

scope_architect_agent = autogen.AssistantAgent(

identify="Scope_Architect",

llm_config=llm_config,

human_input_mode="ALWAYS",

max_consecutive_auto_reply=1, # Solely reply as soon as

is_termination_msg=lambda x: x.get("content material", "").rstrip().endswith("TERMINATE"),

system_message="""You're a Scope Architect. Your function is to know the mission necessities supplied initially after which collect vital particulars *from the Client_Input_Agent (representing the consumer/freelancer)*.

1. Await the preliminary mission particulars from Client_Input_Agent.

2. Upon getting the mission particulars, formulate clear questions for the Client_Input_Agent to ask the human consumer about their:

- Related previous work/tasks and collaborations.

- Key expertise and instruments relevant to this mission.

- Their estimated time to finish the outlined work.

3. Do NOT proceed to proposal era. Await the Client_Input_Agent to offer the consumer's solutions.

4. Upon getting each the shopper necessities AND the consumer's particulars (expertise, expertise, time estimate), summarize this data clearly for the Fee Recommender. Sign that you've all vital data.

""",

)

3. Raten Empfehlungsvertreter

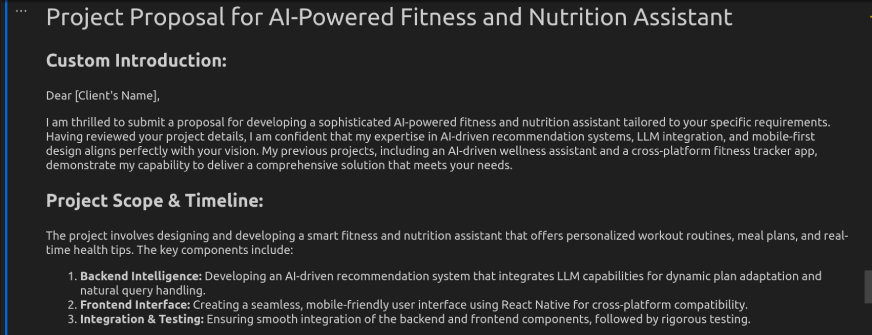

Der Fee Repection Agent verwendet die gesammelten Informationen, um einen detaillierten Projektvorschlag zu generieren. Es wartet auf die vollständige Zusammenfassung des Scope -Architekten. Analysiert anschließend die Particulars des Projektumfangs- und Freiberuflers, um ein professionelles Vorschlagsdokument zu generieren. Dies beinhaltet eine benutzerdefinierte Einführung, eine Zeitleiste, mehrere Preisstufen und einen klaren Aufruf zum Handeln.

Erwartete Ausgabe:

- Professionell formatiertes Projektvorschlagsdokument mit Umfang, Preisgestaltung und nächsten Schritten.

- Die endgültige Ausgabe ist bereit, dem Kunden zur Genehmigung oder weiteren Diskussion geliefert zu werden.

rate_recommender_agent = autogen.AssistantAgent(

identify="Rate_Recommender",

llm_config=llm_config,

max_consecutive_auto_reply=1, # Solely reply as soon as

system_message=f"""

You're a Proposal Generator and Fee Recommender. Your job is to create a structured mission proposal.

Wait till the Scope_Architect shares a abstract containing BOTH the shopper's mission necessities AND the consumer's profile (expertise, expertise, time estimate, previous work if obtainable).

Analyze all acquired information: shopper wants, consumer experience, estimated time, and any prior charge insights.

Generate a well-structured proposal addressed to the shopper, together with the next sections:

Customized Introduction: Professionally introduce the consumer's providers and reference the shopper's firm and mission.

Undertaking Scope & Timeline: Clearly define the deliverables with estimated timelines primarily based on consumer enter.

Prompt Pricing Tiers: Present 1–3 pricing choices (hourly, fastened charge, retainer) with justifications primarily based on scope, consumer expertise, or complexity.

Subsequent Steps (CTA): Suggest scheduling a quick kickoff name to finalize and make clear particulars.

Current ONLY the ultimate formatted proposal. Don't embody further commentary until clarification is requested.""",)4. Consumer Proxy Agent

Dieser Agent fungiert als Einstiegspunkt oder Helfer, um die Interaktion zu starten. Obwohl es bei diesem Fluss keine zentrale Rolle spielt (basierend auf dem angegebenen Code), kann es verwendet werden, um die Aufgaben zu initiieren oder bei Benutzeranwendungen zu unterstützen.

user_proxy = autogen.UserProxyAgent(

identify="user_proxy",

max_consecutive_auto_reply=1,

# is_termination_msg=lambda x: x.get("content material", "").rstrip().endswith("TERMINATE"),

llm_config=llm_config,

system_message="""you're an useful assistant and initate the dialog"""

)Schritt 4: Erstellen des Gruppenmanagers

In diesem Schritt wird der zentrale Koordinator eingerichtet, der Kommunikation und Teamarbeit zwischen allen spezialisierten Agenten verwaltet.

1. Einrichten von Gruppenchat

Der Gruppen -Chat legt eine strukturierte Konversationsumgebung für drei spezialisierte Agenten ein. Dies sind der Consumer -Agent, der SCOPE Architect Agent und der Tarif Repection Agent. Es verwaltet den Gesprächsfluss durch runde Grenzen und die Auswahl der geordneten Lautsprecher.

Schlüsselpunkte:

- Häuser drei spezialisierte Agenten, die auf die Schaffung von Vorschlägen arbeiten

- Vier Runden maximal, um den Fokus aufrechtzuerhalten

- Das Sprechmuster „Round_robin“ sorgt für die geordnete Teilnahme

- Schafft eine kontrollierte Umgebung zum Sammeln von Informationen

# --- Group Chat Setup ---

groupchat = autogen.GroupChat(

brokers=(client_agent, scope_architect_agent, rate_recommender_agent),

messages=(),

max_round=4,

speaker_selection_method="round_robin",

)2. Erstellen des Gruppen -Chat -Managers

Der Gruppen -Chat -Supervisor organisiert die gesamte Konversation und führt die Interaktionen durch eine logische Entwicklung von Projektdetails zur Erzeugung der Vorschläge. Die Systemmeldung enthält Schritt-für-Schritt-Anweisungen für die Interaktionen zwischen Agenten und definiert eindeutige Beendigungsbedingungen.

Schlüsselpunkte:

- Leitet den Gesprächsfluss zwischen allen Agenten

- Hyperlinks zum Gruppen -Chat -Objekt

- Behält eine konsistente LLM -Konfiguration bei

- Enthält detaillierte Prozessanweisungen

- Endet nach Abschluss des Vorschlags oder mit dem Befehl terminate

supervisor = autogen.GroupChatManager(

groupchat=groupchat,

llm_config=llm_config,

# System message for the supervisor guiding the general circulate

system_message="""Handle the dialog circulate between the brokers.

1. Begin with the Client_Input_Agent offering mission particulars.

2. Make sure the Scope_Architect asks the required questions concerning the consumer's background.

3. Make sure the Client_Input_Agent relays the consumer's solutions.

4. Make sure the Rate_Recommender waits for all data earlier than producing the ultimate proposal within the specified format.

The dialog finishes when the ultimate proposal is generated or the Client_Input_Agent says TERMINATE."""

)Schritt 5: Initiieren des Chats

Nachdem wir die Agenten vorhanden haben, lassen Sie uns den kollaborativen Workflow zwischen den Agenten ein. Hierzu senden wir eine klare Anweisungsaufforderung an den GroupChatManager vom user_proxy -Agenten.

Schlüsselpunkte:

- Löst die Konversation mit user_proxy.initiate_chat () aus, die den Gruppenchat startet und die Nachricht an den GroupChatManager sendet.

- Delegierte die Steuerung an den Supervisor, der dann den Schritt-für-Schritt-Fluss unter Verwendung der Spherical-Robin-Methode und deren internen Systemnachrichtenanweisungen zur Koordinierung der Agenten folgt.

# --- Provoke Chat ---

print("Beginning the proposal era course of...")

print("Please present the preliminary shopper and mission particulars when prompted.")

initial_prompt_message = """

Begin the method. First, I want the shopper/mission particulars from the consumer (through Client_Input_Agent).

Then, Scope_Architect ought to ask the consumer (through Client_Input_Agent) about their background.

Lastly, Rate_Recommender ought to generate the proposal.

"""

user_proxy.initiate_chat(

supervisor,

message=initial_prompt_message

)

Schritt 6: Formatieren der Ausgabe

Dieser Code hilft uns, die Ausgabe in einem Markdown (.MD) -Format vorzustellen.

chat_history = supervisor.chat_messages(client_agent) # Or doubtlessly simply supervisor.chat_messages if construction differs barely

# Discover the final message from the Rate_Recommender agent

final_proposal_message = None

for msg in reversed(chat_history):

if msg.get("function") == "assistant" and msg.get("identify") == rate_recommender_agent.identify:

if "Customized Introduction:" in msg.get("content material", ""):

final_proposal_message = msg

break

if final_proposal_message:

final_proposal_string = final_proposal_message.get("content material", "Proposal content material not discovered.")

strive:

show(Markdown(final_proposal_string))

besides NameError:

print("n(Displaying uncooked Markdown textual content as wealthy output is unavailable)n")

print(final_proposal_string)

else:

print("nCould not robotically extract the ultimate proposal from the chat historical past.")

print("Chances are you'll must overview the complete chat historical past above.")Probenausgabe

Abschluss

In diesem Artikel haben wir einen Projektvorschlagsagenten mit Lama 4 und Autogen erstellt. Der Agent sammelte die Kundenanforderungen effektiv, strukturierte den Vorschlag und lieferte ein professionelles Dokument mit klaren Preisgestaltung und Timeline. Autogen landete mit dem Gesprächsfluss, während Lama 4 natürliche, kontextbewusste Reaktionen durchweg sicherstellte. Diese Zusammenarbeit vereinfachte die Kundenkommunikation und bietet Freiberuflern und Beratern eine optimierte Lösung, um die Erzeugung der Vorschläge mit minimaler manueller Eingabe zu automatisieren.

Lama 4 verbesserte die Leistung des Agenten durch den verbesserten Anweisungen, eine bessere Kontextaufbewahrung und effizientes Lernen von wenigen Schüssen. Seine Fähigkeit, die Kohärenz über mehrere Flip-Dialoge hinweg aufrechtzuerhalten, machte den Prozess der Vorschlagsgenerierung intelligenter und reaktionsschneller. Darüber hinaus machten die schnelle Inferenz und die niedrigen Kosten des Modells es für Echtzeitanwendungen geeignet. Zusammen ermöglichen LLAMA 4 und Autogen leistungsstarke Agenten-Workflows, die die Produktivität und Professionalität bei Kunden auf Kundenbetreuung steigern.

Häufig gestellte Fragen

A. LLAMA 4 ist ein hochmodernes Sprachmodell, das für seine Effizienz, Genauigkeit und starke Leistung in Bezug auf Argumentation und Dialoggenerierung von mehreren Drehungen bekannt ist.

A. Autogen ist ein Framework, das den Bau von Workflows mit mehreren Agenten vereinfacht. Es verwaltet Interaktionen und Aufgabenkoordination zwischen verschiedenen KI -Agenten.

A. Ja, die Architektur ist modular. Sie können es für Domänen wie Gesundheitswesen, E-Commerce, Finanzen oder Softwareentwicklung anpassen.

A. Absolut. LLAMA 4 bietet Antworten mit geringer Latenz und kann komplexe Eingabeaufforderungen bearbeiten, was es für interaktive oder Echtzeitanwendungen hervorragend macht.

A. Nicht unbedingt. Mit grundlegendem Python -Wissen und Verständnis von LLMs können Sie ähnliche Agenten -Workflows einrichten und ausführen.

Melden Sie sich an, um weiter zu lesen und Experten-Kuratinhalte zu genießen.