Hast du jemals mit einem gearbeitet? Datenanalyst Wer schläft nie und braucht keine Pause? Oder einer, der sich schneller als „Pivot -Tabelle“ auszeichnen kann? Wenn nicht, halten Sie an Ihrem Platz fest, weil wir gerade das bauen wollen! Heute erstellen wir einen Datenanalyst-AI-Agenten für die Lightning-Quick-Datenanalyse. Mithilfe von OpenAIs Funktionsaufruf kann diese KI -Automatisierung Ihre Fragen in einfachem Englisch interpretieren und die gewünschten Ausgaben in Sekundenschnelle geben.

Wenn alles so eingerichtet ist, wie wir es uns vorstellen, können Sie den Agenten Fragen wie „Was waren unsere Prime -Rating -Produkte im letzten Quartal für eine bestimmte Abteilung?“ Stellen? Oder „zeigen Sie mir die Korrelation zwischen Marketingausgaben und Verkäufen.“ Im Gegenzug erhalten Sie sofortige und genaue Antworten mit raffinierten Diagrammen. Das ist was OpenAI -Funktionsaufrufkombiniert mit OpenAI -Datenanalysefunktionen, können für Sie tun.

Was macht das so aufregend?

Das Drawback, das in der Vergangenheit mit Daten vorhanden conflict, conflict, dass man musste Kennen Sie SQL. Den Denken höherer Ordnung conflict erforderlich, um die Komplexität der analysierten Daten zu verstehen. Oder man musste mehrere Stunden damit verbringen, nur verschiedene Dashboard -Schnittstellen zu durchlaufen. Funktionsaufruf ermöglicht es uns jetzt, den KI -Agenten als translationales Medium zwischen menschlicher Sprache und Datenanweisungen zu erstellen. Denken Sie an einen Übersetzer, der fließend in „Mensch“ und „Datenbank“ spricht!

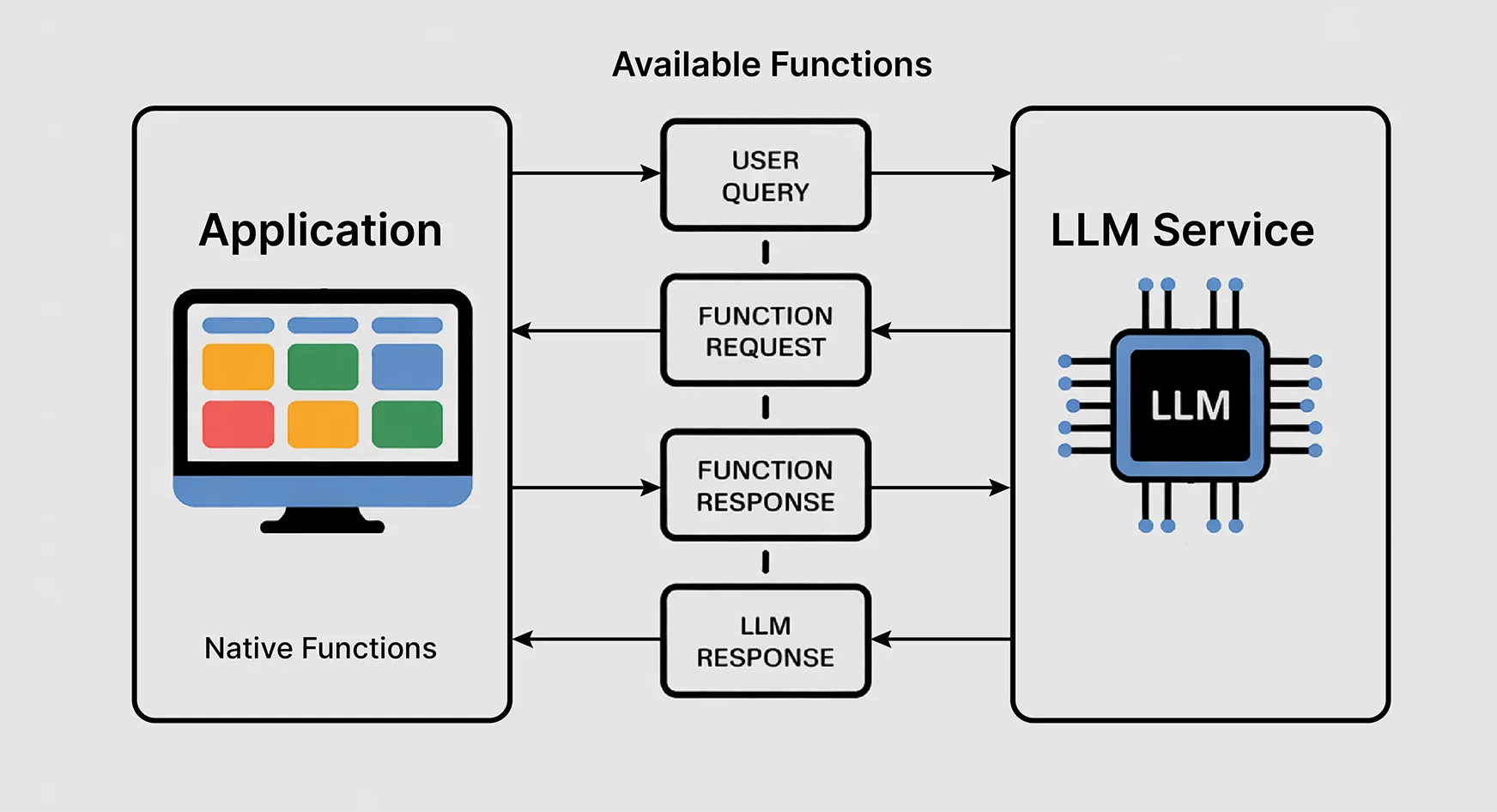

Die Magie geschieht, wenn das OpenAI -Sprachmodell wählt, welche Funktion basierend auf Ihrer Abfrage in der natürlichen Sprache aufgerufen werden muss. Fragen Sie nach Traits, und es würde eine Zeitreihenanalysefunktion aufrufen. Fordern Sie einen Vergleich an, und es wird auf eine statistische Vergleichsfunktion berufen. Die KI ist Ihr Mitarbeiter, der genau die richtigen Instruments für jede Frage kennt.

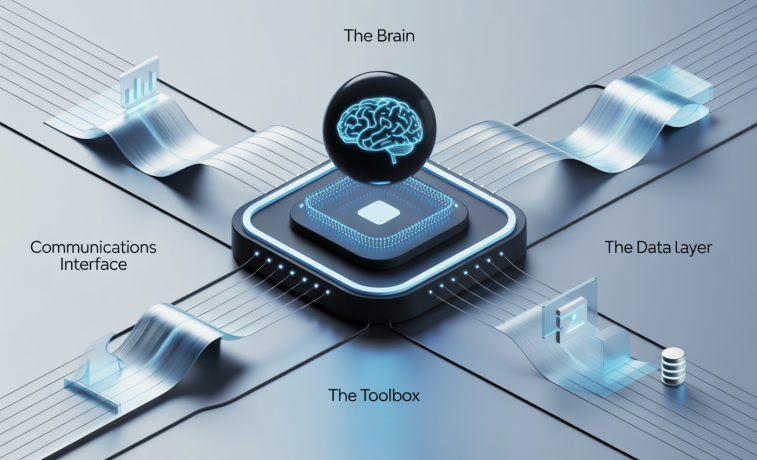

Die Architektur: Wie alles zusammen funktioniert

Unser Information Analyst AI ist ein Ensemble von Hauptkomponenten, die synchronisiert werden. Hier sind alle Komponenten, die zusammenarbeiten:

- Das Gehirn (Openais GPT -Modell): Verarbeitet natürliche Sprachanfragen und entscheidet, welche Funktionen aufrufen sollen. Stellen Sie sich dies als einen erfahrenen Datenanalyst vor, der Geschäftsfragen und die technologischen Implementierungsprobleme versteht.

- Die Toolbox (Funktionsbibliothek): Wir werden eine unabhängige Funktion für jede unterschiedliche Analyse erstellen, von Statistiken bis zu Grafiken. Jedes ist so konzipiert, dass sie eine bestimmte Datenoperation effizient durchführen.

- Die Datenschicht: Dies ist für das Laden, Reinigen und Vorbereiten aller Datensätze verantwortlich. Wir werden mit zahlreichen Datenarten umgehen und sicherstellen, dass unser Agent alle da draußen verfügbaren unordentlichen Daten behandeln kann.

- Kommunikationsschnittstelle: Dies würde sicherstellen, dass der Hin und Her zwischen dem Benutzer, dem KI-Modell und der Funktionsmission effektiv ist und aussagekräftige Ergebnisse erzielt.

Die Schönheit dieser Architektur liegt in ihrer Einfachheit. Schreiben Sie einfach ein paar neue Funktionen und registrieren Sie sie bei der KI. Benötigen Sie eine neue Datenquelle? Schließen Sie einfach einen neuen Datenanschluss ein. Es könnte unendliche Erweiterbarkeit geben, ohne einen menschlichen Datenanalyst erforderlich zu machen!

Einrichten Ihrer Entwicklungsumgebung

Vor etwas anderem müssen wir einen Arbeitsbereich für die von uns angestrebte Datenwissenschaft einrichten. Hier erfahren Sie, wie es geht.

- Notwendige Abhängigkeiten: Sie benötigen das Python -Paket von Openai für den API -Anruf. Sie benötigen auch Pandas für die Datenhandhabung (weil Pandas wie das Schweizer Armee -Messer der Datenwissenschaft ist), Matplotlib und Seeborn für das Auftreten und Numpy für das Knirschen von Zahlen.

- API -Konfiguration: Holen Sie sich Ihren API -Schlüssel von OpenAI. Darüber hinaus werden wir ein gewisses Fehler mit der Fee einschränken, um eine reibungslose Arbeit zu gewährleisten.

- Datenvorbereitungswerkzeuge: Installieren Sie Bibliotheken für CSV-, JSON-, Excel -Dateien, möglicherweise sogar Datenbankverbindungen, wenn Sie sich ehrgeizig fühlen!

Kernfunktionen: Das Herz Ihres KI -Analysten

Wir möchten die grundlegenden Funktionen entwickeln, die unseren verleihen werden AI -Agent Diese sehr analytischen Kräfte:

- Laden und Inspektion: Laden Sie Daten aus verschiedenen Formaten/Quellen und präsentieren auch einen ersten Satz von Eindrücken über Struktur, Datentypen und grundlegende Statistiken. Betrachten Sie diese als die von der KI in vertraute Section mit Ihren Daten.

- Statistische Analyse: Diese Funktionen bieten mathematische Interpretationen von Daten aus grundlegenden deskriptiven Statistiken zu komplexeren Korrelationsanalysen. Sie sind so konzipiert, dass sie Ergebnisse liefern, die in Formaten präsentiert werden, die für die KI -Interpretation und für die Beschreibungen der Benutzerkomponenten geeignet sind.

- Visualisierungen: Diese Funktionen erzeugen Diagramme, Diagramme und Diagramme, wenn die KI die Analyse bestimmt. Es ist sehr wichtig, dass sie flexibel genug sind, um verschiedene Datentypen zu verarbeiten und dennoch von Menschen lesbare Ausgänge zu erzeugen.

- Filterung und Datenumwandlung: Durch diese kann die KI Daten entsprechend der Benutzerabfrage schneiden, würfeln und neu formen.

Die Magie der Funktionsanrufe in Aktion

Hier werden die Dinge wirklich interessant. Wenn Sie additionally eine Frage wie: „Was ist der Pattern in unseren monatlichen Verkäufen?“ Stattdessen wird es Folgendes tun:

- Erstens analysiert es die Frage, um genau zu verstehen, was Sie wollen. Es erkennt Wörter wie „Pattern“ und „monatlich“ an. Anschließend assoziiert sie einige geeignete analytische Methoden.

- Basierend auf diesem Verständnis entscheidet es, welche Funktionen und in welcher Reihenfolge aufrufen sollen. Es kann sich entscheiden, zuerst die Lastdatenfunktion aufzurufen und dann zeitbasierte Filterung, Trendanalyse anzuwenden und schließlich die Visualisierungen zu erstellen.

- Die KI fährt die Funktionen nacheinander aus. Es durchbricht sie mit einigen Datenübergang. Jede Funktion liefert eine strukturierte Ausgabe, auf die die KI verarbeitet und aufgebaut.

- Zusammenfassend lässt sich sagen, dass die KI alle Ausgänge aus mehreren Analysestadien zu einer kohärenten Erklärung kombiniert. Anschließend wird dies mit Erkenntnissen, Visualisierung und Aktionsempfehlungen an den Endbenutzer zurückgegeben.

Praktisches Projekt: Erstellen Sie Ihren Datenanalyst-AI-Agenten

Gehen wir noch einen Schritt weiter und erstellen einen vollständigen Datenanalyst -AI -Agenten, der sich tatsächlich mit realen Geschäftsdaten befasst und umsetzbare Erkenntnisse gibt. Dafür werden wir einen AI-Agenten entwerfen, um E-Commerce-Verkaufsdaten zu analysieren. Der Agent kann Fragen zu Produktleistung, Kundenverhalten, saisonalen Traits und Bereichen beantworten, um den Umsatz zu verbessern.

1. Installieren Sie die erforderlichen Pakete

!pip set up openai pandas matplotlib seaborn numpy plotly2. Importieren Sie Bibliotheken und Setup

import openai

import pandas as pd

import numpy as np

import matplotlib.pyplot as plt

import seaborn as sns

import plotly.categorical as px

import plotly.graph_objects as go

from datetime import datetime, timedelta

import json

import warnings

warnings.filterwarnings('ignore')

# Set your OpenAI API key right here

openai.api_key = "your-openai-api-key-here" # Substitute along with your precise API key

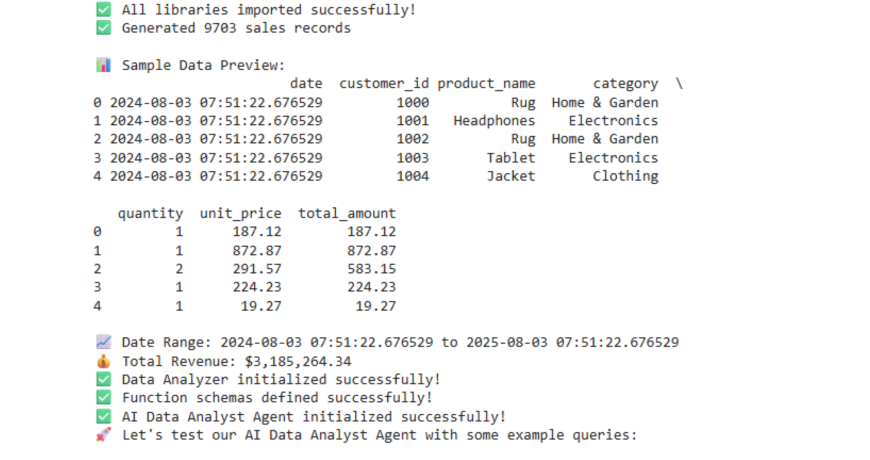

print("✅ All libraries imported efficiently!")3. Generieren Sie Beispiele für E-Commerce-Daten

def generate_sample_data():

"""Generate lifelike e-commerce gross sales information for demonstration"""

np.random.seed(42)

# Product classes and names

classes = ('Electronics', 'Clothes', 'Books', 'Dwelling & Backyard', 'Sports activities')

merchandise = {

'Electronics': ('Smartphone', 'Laptop computer', 'Headphones', 'Pill', 'Good Watch'),

'Clothes': ('T-Shirt', 'Denims', 'Sneakers', 'Jacket', 'Costume'),

'Books': ('Fiction Novel', 'Science E book', 'Cookbook', 'Biography', 'Self-Assist'),

'Dwelling & Backyard': ('Espresso Maker', 'Plant Pot', 'Lamp', 'Pillow', 'Rug'),

'Sports activities': ('Operating Sneakers', 'Yoga Mat', 'Dumbbell', 'Basketball', 'Tennis Racket')

}

# Generate information for the final 12 months

start_date = datetime.now() - timedelta(days=365)

dates = pd.date_range(begin=start_date, finish=datetime.now(), freq='D')

information = ()

customer_id = 1000

for date in dates:

# Simulate seasonal patterns

month = date.month

seasonal_multiplier = 1.2 if month in (11, 12) else (1.1 if month in (6, 7) else 1.0)

# Generate 10-50 orders per day

daily_orders = np.random.poisson(25 * seasonal_multiplier)

for _ in vary(daily_orders):

class = np.random.alternative(classes, p=(0.3, 0.25, 0.15, 0.15, 0.15))

product = np.random.alternative(merchandise(class))

# Value based mostly on class

price_ranges = {

'Electronics': (50, 1000),

'Clothes': (15, 200),

'Books': (10, 50),

'Dwelling & Backyard': (20, 300),

'Sports activities': (25, 250)

}

worth = np.random.uniform(*price_ranges(class))

amount = np.random.alternative((1, 2, 3), p=(0.7, 0.2, 0.1))

information.append({

'date': date,

'customer_id': customer_id,

'product_name': product,

'class': class,

'amount': amount,

'unit_price': spherical(worth, 2),

'total_amount': spherical(worth * amount, 2)

})

customer_id += 1

return pd.DataFrame(information)

# Generate and show pattern information

df = generate_sample_data()

print(f"✅ Generated {len(df)} gross sales data")

print("n📊 Pattern Information Preview:")

print(df.head())

print(f"n📈 Date Vary: {df('date').min()} to {df('date').max()}")

print(f"💰 Complete Income: ${df('total_amount').sum():,.2f}")4. Definieren Sie Analysefunktionen

class DataAnalyzer:

def __init__(self, dataframe):

self.df = dataframe.copy()

self.df('date') = pd.to_datetime(self.df('date'))

def get_revenue_summary(self, interval='month-to-month'):

"""Calculate income abstract by time interval"""

strive:

if interval == 'each day':

grouped = self.df.groupby(self.df('date').dt.date)

elif interval == 'weekly':

grouped = self.df.groupby(self.df('date').dt.isocalendar().week)

elif interval == 'month-to-month':

grouped = self.df.groupby(self.df('date').dt.to_period('M'))

else:

return {"error": "Invalid interval. Use 'each day', 'weekly', or 'month-to-month'"}

revenue_data = grouped('total_amount').sum().reset_index()

revenue_data.columns = ('interval', 'income')

return {

"success": True,

"information": revenue_data.to_dict('data'),

"total_revenue": float(self.df('total_amount').sum()),

"average_revenue": float(revenue_data('income').imply()),

"interval": interval

}

besides Exception as e:

return {"error": str(e)}

def get_top_products(self, restrict=10, metric="income"):

"""Get prime performing merchandise"""

strive:

if metric == 'income':

top_products = self.df.groupby('product_name')('total_amount').sum().sort_values(ascending=False).head(restrict)

elif metric == 'amount':

top_products = self.df.groupby('product_name')('amount').sum().sort_values(ascending=False).head(restrict)

else:

return {"error": "Invalid metric. Use 'income' or 'amount'"}

return {

"success": True,

"information": ({"product": prod, "worth": float(val)} for prod, val in top_products.gadgets()),

"metric": metric,

"restrict": restrict

}

besides Exception as e:

return {"error": str(e)}

def get_category_performance(self):

"""Analyze efficiency by product class"""

strive:

category_stats = self.df.groupby('class').agg({

'total_amount': ('sum', 'imply'),

'amount': 'sum',

'customer_id': 'nunique'

}).spherical(2)

category_stats.columns = ('total_revenue', 'avg_order_value', 'total_quantity', 'unique_customers')

category_stats = category_stats.reset_index()

return {

"success": True,

"information": category_stats.to_dict('data')

}

besides Exception as e:

return {"error": str(e)}

def get_customer_insights(self):

"""Analyze buyer conduct patterns"""

strive:

customer_stats = self.df.groupby('customer_id').agg({

'total_amount': 'sum',

'date': ('min', 'max', 'nunique')

}).spherical(2)

customer_stats.columns = ('total_spent', 'first_purchase', 'last_purchase', 'purchase_frequency')

insights = {

"total_customers": len(customer_stats),

"avg_customer_value": float(customer_stats('total_spent').imply()),

"avg_purchase_frequency": float(customer_stats('purchase_frequency').imply()),

"top_spenders": customer_stats.nlargest(5, 'total_spent')('total_spent').to_dict()

}

return {"success": True, "information": insights}

besides Exception as e:

return {"error": str(e)}

def create_visualization(self, chart_type, data_params):

"""Create varied sorts of visualizations"""

strive:

plt.determine(figsize=(12, 6))

if chart_type == 'revenue_trend':

# Month-to-month income pattern

monthly_data = self.df.groupby(self.df('date').dt.to_period('M'))('total_amount').sum()

plt.plot(vary(len(monthly_data)), monthly_data.values, marker="o", linewidth=2)

plt.title('Month-to-month Income Pattern', fontsize=16, fontweight="daring")

plt.xlabel('Month')

plt.ylabel('Income ($)')

plt.xticks(vary(len(monthly_data)), (str(x) for x in monthly_data.index), rotation=45)

plt.grid(True, alpha=0.3)

elif chart_type == 'category_pie':

# Class income distribution

category_revenue = self.df.groupby('class')('total_amount').sum()

plt.pie(category_revenue.values, labels=category_revenue.index, autopct="%1.1f%%", startangle=90)

plt.title('Income Distribution by Class', fontsize=16, fontweight="daring")

elif chart_type == 'top_products_bar':

# Prime merchandise bar chart

top_products = self.df.groupby('product_name')('total_amount').sum().sort_values(ascending=False).head(10)

plt.barh(vary(len(top_products)), top_products.values)

plt.yticks(vary(len(top_products)), top_products.index)

plt.title('Prime 10 Merchandise by Income', fontsize=16, fontweight="daring")

plt.xlabel('Income ($)')

plt.tight_layout()

plt.present()

return {"success": True, "message": f"Created {chart_type} visualization"}

besides Exception as e:

return {"error": str(e)}

# Initialize analyzer

analyzer = DataAnalyzer(df)

print("✅ Information Analyzer initialized efficiently!")5. Funktionsdefinitionen für OpenAI

def get_revenue_summary(interval='month-to-month'):

"""Get income abstract by time interval (each day, weekly, month-to-month)"""

return analyzer.get_revenue_summary(interval)

def get_top_products(restrict=10, metric="income"):

"""Get prime performing merchandise by income or amount"""

return analyzer.get_top_products(restrict, metric)

def get_category_performance():

"""Analyze efficiency metrics by product class"""

return analyzer.get_category_performance()

def get_customer_insights():

"""Get insights about buyer conduct and patterns"""

return analyzer.get_customer_insights()

def create_visualization(chart_type, data_params=None):

"""Create visualizations (revenue_trend, category_pie, top_products_bar)"""

return analyzer.create_visualization(chart_type, data_params or {})

def get_basic_stats():

"""Get primary statistics in regards to the dataset"""

return {

"success": True,

"information": {

"total_records": len(analyzer.df),

"date_range": {

"begin": str(analyzer.df('date').min().date()),

"finish": str(analyzer.df('date').max().date())

},

"total_revenue": float(analyzer.df('total_amount').sum()),

"unique_products": analyzer.df('product_name').nunique(),

"unique_customers": analyzer.df('customer_id').nunique(),

"classes": analyzer.df('class').distinctive().tolist()

}

}6. OpenAI -Funktionsschemata

features = (

{

"identify": "get_revenue_summary",

"description": "Get income abstract grouped by time interval",

"parameters": {

"kind": "object",

"properties": {

"interval": {

"kind": "string",

"enum": ("each day", "weekly", "month-to-month"),

"description": "Time interval for grouping income information"

}

},

"required": ("interval")

}

},

{

"identify": "get_top_products",

"description": "Get prime performing merchandise by income or amount",

"parameters": {

"kind": "object",

"properties": {

"restrict": {

"kind": "integer",

"description": "Variety of prime merchandise to return (default: 10)"

},

"metric": {

"kind": "string",

"enum": ("income", "amount"),

"description": "Metric to rank merchandise by"

}

},

"required": ("metric")

}

},

{

"identify": "get_category_performance",

"description": "Analyze efficiency metrics by product class together with income, amount, and prospects",

"parameters": {

"kind": "object",

"properties": {}

}

},

{

"identify": "get_customer_insights",

"description": "Get insights about buyer conduct, spending patterns, and buy frequency",

"parameters": {

"kind": "object",

"properties": {}

}

},

{

"identify": "create_visualization",

"description": "Create information visualizations like charts and graphs",

"parameters": {

"kind": "object",

"properties": {

"chart_type": {

"kind": "string",

"enum": ("revenue_trend", "category_pie", "top_products_bar"),

"description": "Sort of chart to create"

},

"data_params": {

"kind": "object",

"description": "Further parameters for the chart"

}

},

"required": ("chart_type")

}

},

{

"identify": "get_basic_stats",

"description": "Get primary statistics and overview of the dataset",

"parameters": {

"kind": "object",

"properties": {}

}

}

)

print("✅ Perform schemas outlined efficiently!")7. Hauptklasse der AI -Agenten

class DataAnalystAI:

def __init__(self, api_key):

self.consumer = openai.OpenAI(api_key=api_key)

self.features = {

"get_revenue_summary": get_revenue_summary,

"get_top_products": get_top_products,

"get_category_performance": get_category_performance,

"get_customer_insights": get_customer_insights,

"create_visualization": create_visualization,

"get_basic_stats": get_basic_stats

}

self.conversation_history = ()

def process_query(self, user_query):

"""Course of consumer question and return AI response with operate calls"""

strive:

# Add consumer message to dialog

messages = (

{

"function": "system",

"content material": """You're a useful information analyst AI assistant. You'll be able to analyze e-commerce gross sales information and create visualizations.

At all times present clear, actionable insights. When displaying numerical information, format it properly with commas for giant numbers.

For those who create visualizations, point out that the chart has been displayed.

Be conversational and clarify your findings in enterprise phrases."""

},

{"function": "consumer", "content material": user_query}

)

# Add dialog historical past

messages = messages(:-1) + self.conversation_history + messages(-1:)

# Name OpenAI API with operate calling

response = self.consumer.chat.completions.create(

mannequin="gpt-3.5-turbo",

messages=messages,

features=features,

function_call="auto",

temperature=0.7

)

message = response.selections(0).message

# Deal with operate calls

if message.function_call:

function_name = message.function_call.identify

function_args = json.masses(message.function_call.arguments)

print(f"🔧 Calling operate: {function_name} with args: {function_args}")

# Execute the operate

function_result = self.features(function_name)(**function_args)

# Get AI's interpretation of the outcomes

messages.append({

"function": "assistant",

"content material": None,

"function_call": {

"identify": function_name,

"arguments": message.function_call.arguments

}

})

messages.append({

"function": "operate",

"identify": function_name,

"content material": json.dumps(function_result)

})

# Get closing response from AI

final_response = self.consumer.chat.completions.create(

mannequin="gpt-3.5-turbo",

messages=messages,

temperature=0.7

)

ai_response = final_response.selections(0).message.content material

# Replace dialog historical past

self.conversation_history.append({"function": "consumer", "content material": user_query})

self.conversation_history.append({"function": "assistant", "content material": ai_response})

return ai_response

else:

# No operate name wanted

ai_response = message.content material

self.conversation_history.append({"function": "consumer", "content material": user_query})

self.conversation_history.append({"function": "assistant", "content material": ai_response})

return ai_response

besides Exception as e:

return f"❌ Error processing question: {str(e)}"

# Initialize the AI agent

ai_agent = DataAnalystAI("your-openai-api-key-here") # Substitute along with your API key

print("✅ AI Information Analyst Agent initialized efficiently!")8. Interaktive Abfrageschnittstelle

def ask_ai(question):

"""Easy interface to ask inquiries to the AI agent"""

print(f"🙋 Query: {question}")

print("🤖 AI Response:")

response = ai_agent.process_query(question)

print(response)

print("n" + "="*80 + "n")

return response

# Cell 9: Instance Queries - Run these to check your agent!

print("🚀 Let's take a look at our AI Information Analyst Agent with some instance queries:n")

# Take a look at primary stats

ask_ai("Give me an outline of our gross sales information")

# Take a look at income evaluation

ask_ai("Present me the month-to-month income pattern")

# Take a look at product evaluation

ask_ai("What are our prime 5 merchandise by income?")

# Take a look at class efficiency

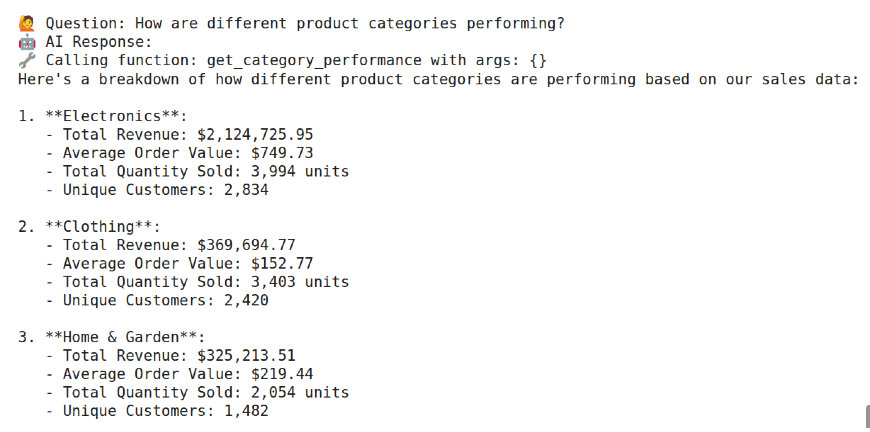

ask_ai("How are totally different product classes performing?")

# Take a look at buyer insights

ask_ai("Inform me about our buyer conduct patterns")

# Take a look at visualization

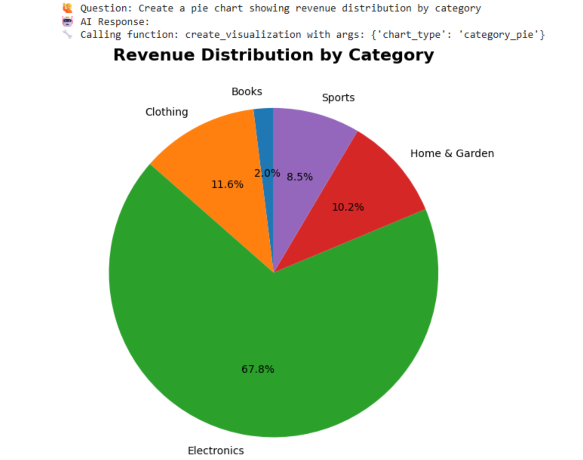

ask_ai("Create a pie chart displaying income distribution by class")

# Take a look at comparative evaluation

ask_ai("Which product class generates the best common order worth?")

print("🎉 All assessments accomplished! Your AI Information Analyst Agent is able to use!")Ausgabe

Fortgeschrittene Techniken und Optimierung

Mit dem vorhandenen Primary -Agenten würde es im Laufe der Zeit mehrere Verbesserungen geben:

- Funktionskettung: Dies sind mehrstufige Analyseschritte, die mit KI verkettet und unterstützt werden. Für viele analytische mehrstufige Arbeitsabläufe würden sonst eine manuelle Koordination erfordern.

- Kontextbewusstsein: Implementieren Sie einen Kontextmanagement für den Agenten, damit er nachverfolgt, welche Analysen bereits durchgeführt wurden und darauf aufbaut. Dies ermöglicht Gespräche, die einem Telefonanruf ziemlich ähnlich sind.

- Leistungsoptimierung: Cache kostspielige Berechnungen, parallel von allen Analysen, die unabhängig durchgeführt werden können. Im Allgemeinen macht es die Funktionsimplementierungen schneller und weniger Speicherintensiv.

- Fehlerbehandlung: Integrieren Sie gründliche Fehler, um die Probleme anmutig zu behandeln. Besonders nützlich bei Datenproblemen, API -Fehlern oder nur unerwarteten Benutzereingaben. Hilft dem Benutzer auch dabei, ein angemessenes Suggestions zu geben.

Anwendungen der realen Welt und Anwendungsfälle

Die Möglichkeiten für Ihren Datenanalyst -AI -Agenten sind praktisch endlos:

- Enterprise Intelligence: Geben Sie regelmäßige Berichte an, aktivieren Sie Self-Service-Analysen für die durchschnittliche Particular person und geben Sie Entscheidungsträgern sofortige Einblicke.

- Marketinganalysen: Überprüfen Sie die Kampagnenleistung Metriken, Kundensegmentierungen und ROI -Berechnungen mit Abfragen mit natürlicher Sprache.

- Finanzanalyse: Überwachen Sie KPIs und Abweichungen und stellen Sie Finanzberichte mit Klartextfragen ein.

- Operationsoptimierung: Überwachen Sie Leistungsdaten und Engpässe und optimieren Sie Prozesse basierend auf datengesteuerten Erkenntnissen.

Abschluss

Der Aufbau eines Datenanalyst -AI -Agenten ist mehr als nur eine technische Übung – es geht darum, die Datenanalyse zu demokratisieren und alle Einblicke zu geben. Sie haben ein Device erstellt, das dazu beitragen könnte, die Interaktion zwischen Personen und Daten zu ändern und Barrieren zu beseitigen, damit Entscheidungen auf der Grundlage von Daten getroffen werden können. Die von Ihnen gelernten Techniken bilden die Grundlage für viele andere KI -Anwendungen.

Funktionsaufruf ist eine vielseitige Idee und kann für alles nützlich sein, von Kundendienstautomatisierung bis hin zu komplizierten Workflow -Orchestrierungen. Denken Sie daran, die besten AIs ersetzen den menschlichen Intellekt nicht: Sie ergänzen ihn. Der Datenanalyst -KI sollte Benutzer ermutigen, bessere Fragen zu ihren Daten zu stellen, sie dazu zu inspirieren, tiefer zu graben und ihre Daten besser zu analysieren und ihnen zu helfen, bessere Entscheidungen zu treffen. Daher geht es nicht darum, alle Antworten zu haben. Es geht darum, einige Antworten zu haben, um alle anderen zu finden.

Melden Sie sich an, um weiter zu lesen und Experten-Kuratinhalte zu genießen.