Das Warten ist vorbei-Openai O3-Mini ist endlich da! OpenAI hat gerade sein jüngstes Argumentationsmodell O3-Mini gestartet und verspricht im Vergleich zu seinen Vorgängern schnellere und genauere Antworten. Das Modell ist ab sofort auf der ChatGPT -Schnittstelle und seinen API -Diensten verfügbar. In diesem Artikel werden wir die wichtigsten Merkmale von O3-Mini behandeln und sehen, wie es sich gegen O1-Mini entwickelt. Deepseek-R1und andere Modelle. Wir werden auch lernen, wie man auf das Modell zugreift und einige praktische Anwendungen ausprobieren. Additionally fangen wir an!

Was ist Openai O3-Mini?

Das O3-Mini ist eine optimierte Model des fortschrittlichsten KI-Modells von OpenA, O3, das sich auf Effizienz und Geschwindigkeit konzentriert. Trotz des kompakten Designs bietet es fortschrittliche Argumentationsfunktionen, sodass es komplexe Probleme aufschlüsseln und wirksame Lösungen bereitstellen kann. Dieses Modell ist besonders geschickt in der Codier- und Argumentationsaufgaben und übertrifft seinen Vorgänger O1-Mini.

Das Modell ist derzeit allen Benutzern von ChatGPT zur Verfügung, obwohl freie Benutzer mit bestimmten Einschränkungen Zugriff haben. In der Zwischenzeit können Chatgpt Plus, Group und Professional-Benutzer O3-Mini für bis zu 150 Nachrichten professional Tag verwenden. Darüber hinaus hat Openai das Modell auch über seine API -Dienste verfügbar gemacht. Der O3-Mini ist auch über den Microsoft Azure OpenAI-Service und den Github Copilot zugänglich.

Schlüsselmerkmale von OpenAI O3-Mini

- Verbesserte Argumentation: Das Modell zeichnet sich in Aufgaben aus, die logisches Denken und Problemlösen erfordern, was es für komplexe Abfragen geeignet ist.

- Verbesserte Codierungsfunktionen: Benchmark-Checks zeigen, dass O3-mini in der Codierungsaufgaben bewundernswert funktioniert und eine höhere Genauigkeit und Effizienz bietet.

- Schnellere Reaktionszeiten: Benutzer erfahren schnellere Interaktionen und verbessern die allgemeine Benutzererfahrung.

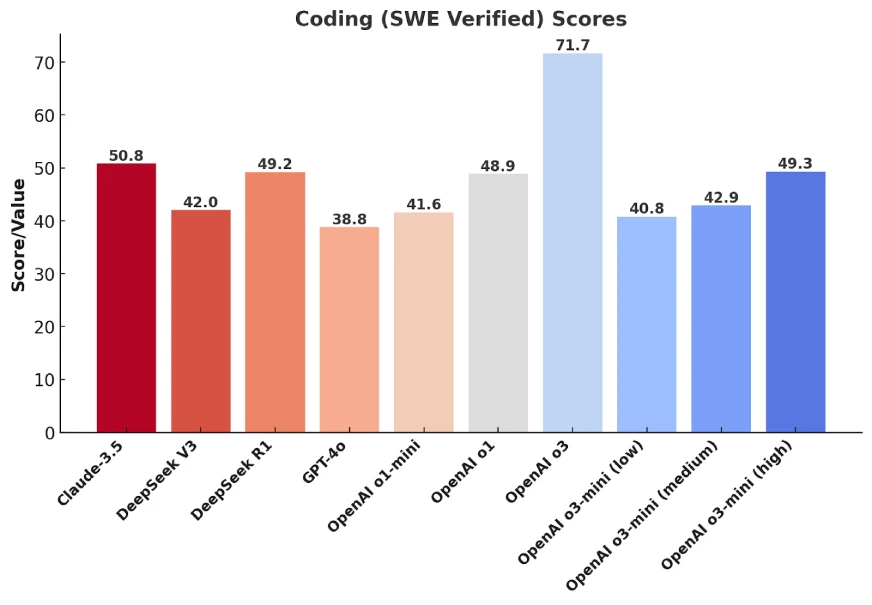

Openai O3-Mini-Benchmark-Vergleiche

Lassen Sie uns nun sehen, wie Openais O3-Mini im Vergleich zu Deepseek-R1, O1, O3-Mini und anderen prominenten Modellen funktioniert.

Openai O3-Mini gegen O1 gegen O1-Mini

Lassen Sie uns zunächst sehen, wo O3-Mini im Vergleich zu seinen Vorgängern steht.

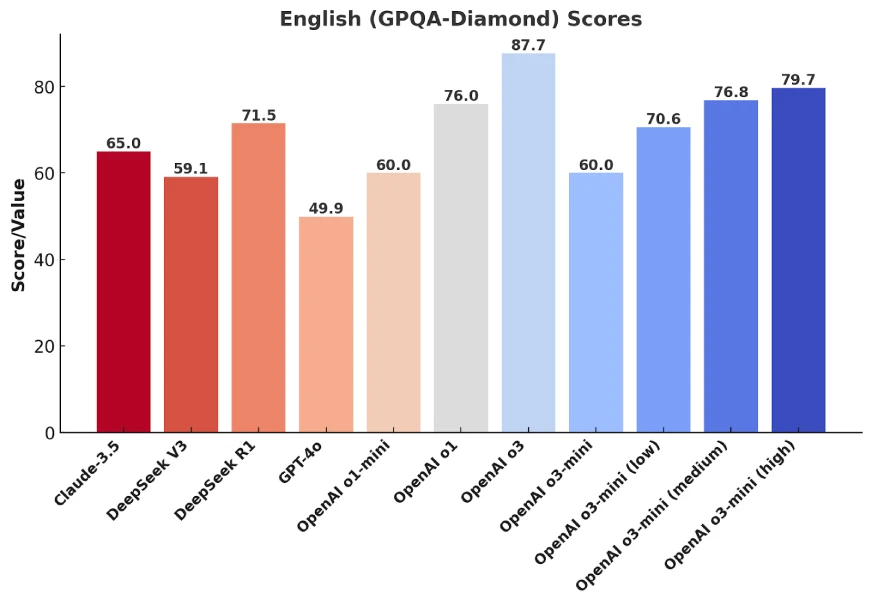

1. Google-Proof-Q & A (GPQA) -Benchmark auf Graduiertenebene

Das O3-Mini (Excessive) zeigt einige Verbesserungen gegenüber seinen Vorgängern, wenn es um englischsprachige Frage geht. Es zeigt derzeit das beste OpenAI -Modell im Verständnis der natürlichen Sprache.

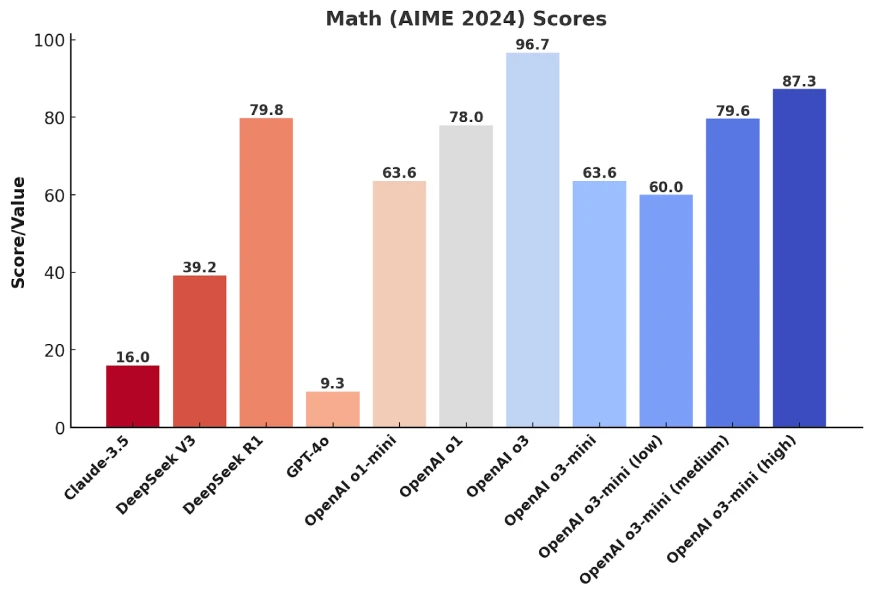

2. American Invitational Arithmetic Examination (Aime) Benchmark

In der Aime-Benchmark spielt der O3-Mini (Medium) quick so intestine wie das O1-Modell. Inzwischen zeigt die O3-Mini (hohe) eine signifikante Verbesserung im Vergleich zu O1. Mit einer Genauigkeit von 87,3percentist es auch die beste Leistung im mathematischen Denken.

3. CODEFORCES ELO -Punktzahl

Die O1-Mini zeigt einen großen Fortschritt bei Codierungsaufgaben. Beim Codeforces-Benchmark-Take a look at übertraf der O3-Mini (niedrig) das O1-Mini und gab dem O1-Modell einen harten Wettbewerb. In der Zwischenzeit zeigten sich die mittleren und hohen Versionen viel besser als die Vorgängermodelle, was OpenAIs O3-Mini zu ihrem bisher besten Codierungsmodell machte.

4. Swee-Bench verifizierte Benchmark

Auch bei der SWE-Benchmark erweist sich O3-Mini als das beste OpenAI-Modell bei der Codierung und erzielte mit seiner hohen Model 49,3% Genauigkeit.

5. Frontiermath

Das O3-Mini-Modell (Excessive) hat erneut bewiesen, dass es sich um die Dominanz bei der mathematischen Problemlösung im FrontierMath-Benchmark-Take a look at handelt. Die Ergebnisse zeigen, dass O3-Mini (hoch) quick doppelt so intestine ist wie seine Vorgänger bei Math.

| Move@1 | Move@4 | Move@8 | |

|---|---|---|---|

| o3-mini (hoch) | 9,2% | 16,6% | 20,0% |

| O1-Mini | 5,8% | 9,9% | 12,8% |

| O1 | 5,5% | 10% | 12,8% |

6. LiveBench -Codierung

In dieser Codierungsherausforderung haben sich alle drei Versionen von O3-Mini erwiesen, um das O1-Modell von Openai in der LCB-Technology zu übertreffen. Die Hochversion battle auch im Code -Abschluss besser als O1.

| Modell | Argumentationsstufe | Durchschnitt | LCB -Technology | Code -Abschluss |

|---|---|---|---|---|

| o3-mini | niedrig | 0,618 | 0,756 | 0,48 |

| o3-mini | Medium | 0,723 | 0,846 | 0,60 |

| o3-mini | hoch | 0,846 | 0,820 | 0,833 |

| O1 | hoch | 0,674 | 0,628 | 0,72 |

7. Allgemeinwissen

Das Testen von OpenAI-Modellen in verschiedenen allgemeinen Wissens-Benchmark-Checks zeigt, dass O3-Mini, insbesondere seine hohe Model, ein überlegenes Modell ist. Während es möglicherweise nur eine leichte Verbesserung gegenüber O1-Mini in Mathematik, Naturwissenschaften und anderen Themen aufweist, sind seine grundlegenden Fragen zur Beantwortung von Fragen und der Argumentation quick doppelt so intestine wie O1-Mini.

| Kategorie | Bewerten | O1-Mini | o3-mini (niedrig) | O3-Mini (Medium) | o3-mini (hoch) |

|---|---|---|---|---|---|

| Allgemein | MMLU (Move@T) | 85.2 | 84.9 | 85,9 | 86,9 |

| Mathe (Move@T) | 90.0 | 95.8 | 97.3 | 97,9 | |

| Mathe | MGSM (Move@T) | 89,9 | 55.1 | 90,8 | 92.0 |

| Tatsache | Simpleqa | 7.6 | 13.0 | 13.4 | 13.8 |

OpenAI O3-Mini gegen Deepseek-R1 und andere Modelle

Vergleichen wir es nun mit den derzeit führenden Modellen wie Claude 3.5, Deepseek-R1 und Deepseek-V3.

1. Google-Proof-Q & A (GPQA) -Benchmark auf Graduiertenebene

Sowohl O3-Mini (mittel) als auch O3-Mini (hoch) sind besser als Deepseek-R1 und Claude-3,5 in detaillierten und sachlichen Fragen.

2. American Invitational Arithmetic Examination (Aime) Benchmark

Während O3-Mini (Medium) in Mathematik einen engen Wettbewerb um Deepseek-R1 verleiht, übertrifft das O3-Mini (hoch) ihn um über 10percentund beweist seine Dominanz in diesem Thema.

3. CODEFORCES ELO -Punktzahl

Wenn es um die Codierung geht, übertreffen sowohl die mittleren als auch die hohen Versionen von O3-Mini Deepseek-R1 und die anderen Modelle. Der ELO-Rating von O3-Mini (Excessive) ist der aktuelle höchste unter allen heute verfügbaren Modellen.

4. Swee-Bench verifizierte Benchmark

Bei der Behandlung realer Software program-Engineering-Probleme steht Claude 3.5 immer noch als das Modell mit der besten Leistung. O3-mini (Excessive) verleiht ihm jedoch einen engen Wettbewerb und überholt sich geringfügig Deepseek-R1.

In all diesen Vergleichen sehen wir, dass das noch kommende O3 -Modell andere übertrifft.

Quellen:

Wie kann ich Openai’s O3-Mini zugreifen?

Es gibt 2 Möglichkeiten, auf O3-Mini zuzugreifen. Der erste ist über ihre Chatbot -Oberfläche mit ChatGPT. Der zweite ist über API. Wir werden Sie im nächsten Abschnitt durch beide Optionen führen.

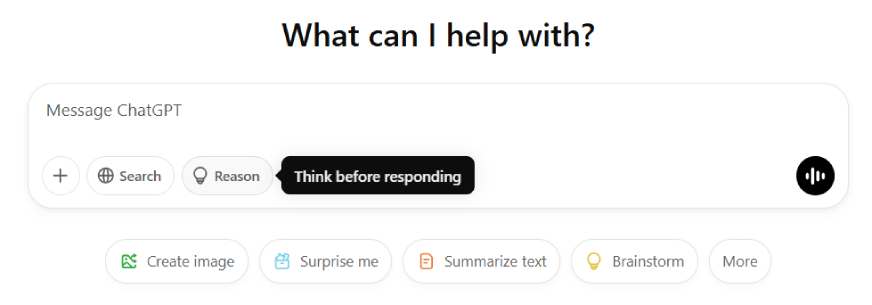

Zugriff auf OpenAI O3-Mini über Chatgpt

Freistufe Benutzer von ChatGPT können das Potenzial von O3-Mini erleben, indem sie „Grund“ unterhalb des Nachrichtenfelds auswählen.

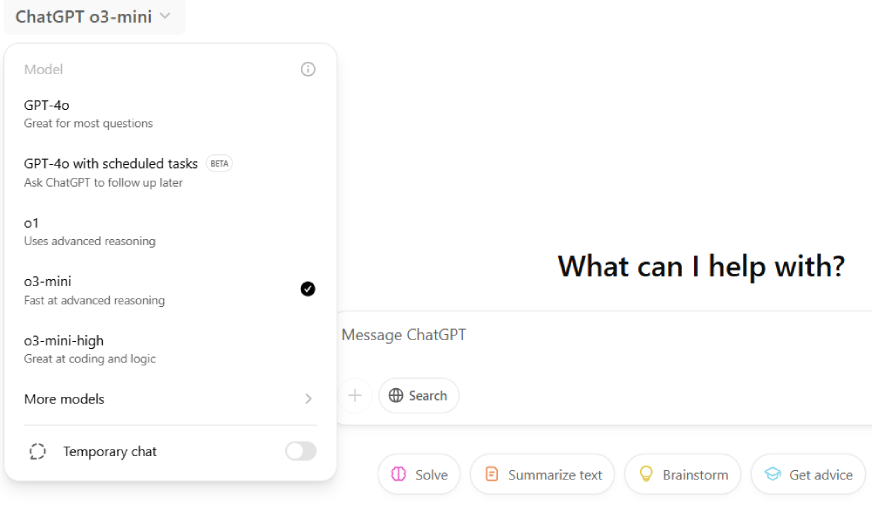

Chatgpt Plus, Group und Professional-Benutzer können direkt „O3-Mini“ oder „O3-Mini-Excessive“ aus der Dropdown-Liste der Modellpicker oben auswählen und mit der Verwendung beginnen.

Wie kann ich über die API von OpenAIs O3-Mini zugreifen?

So können Sie mit ihrer API auf OpenAIs O3-Mini zugreifen.

Schritt 1: Melden Sie sich für den API -Zugriff an

Wenn Sie noch nicht Teil des OpenAI -Beta -Programms sind, müssen Sie den Zugriff durch Besuch anfordern Openais API -Seite. Sobald Sie sich angemeldet haben, müssen Sie möglicherweise auf die Genehmigung warten, um auf die O3-Mini-Modelle zuzugreifen.

Schritt 2: Generieren Sie einen API -Schlüssel

Sobald Sie Zugriff haben, melden Sie sich auf der OpenAI -API -Plattform an und generieren Sie einen API -Schlüssel. Dieser Schlüssel ist für API -Anfragen erforderlich. Um den Schlüssel zu generieren, gehen Sie zu API -Schlüssel und klicken Sie auf „Neue geheime Schlüssel erstellen“. Stellen Sie nach dem Erstellen sicher, dass Sie den Schlüssel kopieren und sicher speichern.

Schritt 3: Installieren Sie das Openai Python SDK

Um mit der O1 -API zu interagieren, müssen Sie das Openai Python SDK installieren. Sie können dies mit dem folgenden Befehl tun:

!pip set up openaiMit diesem Paket können Sie API -Anfragen zum Öffnen von Ihrem Python -Code stellen.

Schritt 4: Initialisieren Sie den OpenAI -Kunden

Nach der Set up des OpenAI SDK müssen Sie den Shopper initialisieren, indem Sie den API -Schlüssel einrichten:

import os

os.environ("OPENAI_API_KEY") = "Enter_api_key"Schritt 5: Führen und überprüfen Sie die Ausgabe

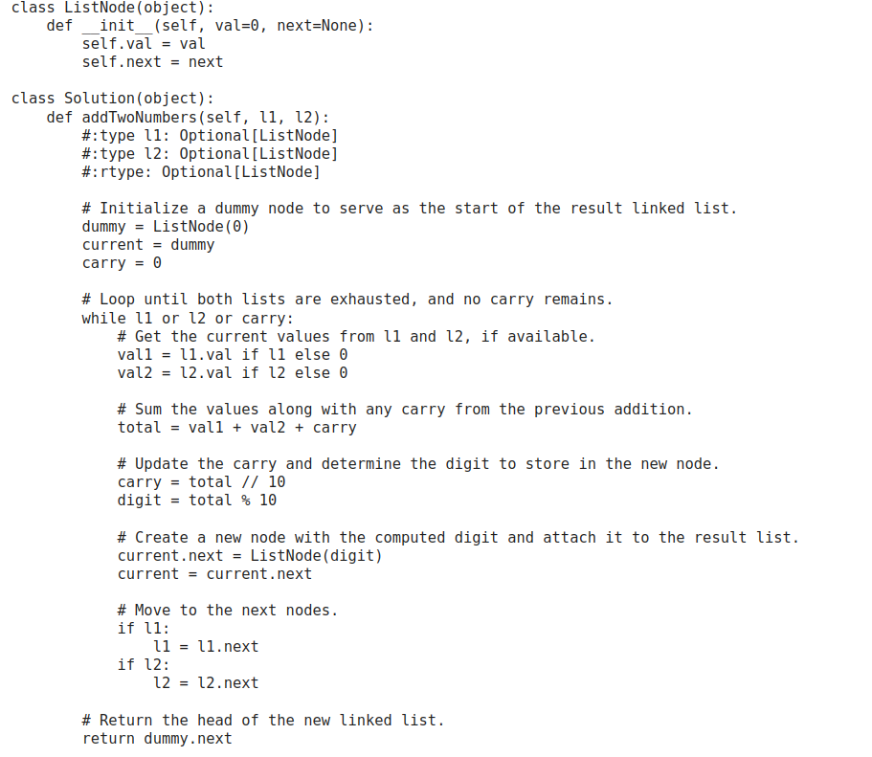

Nachdem wir den OpenAI-Shopper eingerichtet haben, versuchen wir das O3-Mini-Modell zur Lösung Dieses Drawback auf Leetcode.

completion = shopper.chat.completions.create(

mannequin="o3-mini",

messages=(

{"function": "developer", "content material": "You're a useful assistant."},

{

"function": "person",

"content material": """ You're given two non-empty linked lists representing two non-negative integers. The digits are saved in reverse order, and every of their nodes incorporates a single digit. Add the 2 numbers and return the sum as a linked checklist.

You could assume the 2 numbers don't comprise any main zero, besides the quantity 0 itself.

Instance 1:

Enter: l1 = (2,4,3), l2 = (5,6,4)

Output: (7,0,8)

Clarification: 342 + 465 = 807.

Instance 2:

Enter: l1 = (0), l2 = (0)

Output: (0)

Instance 3:

Enter: l1 = (9,9,9,9,9,9,9), l2 = (9,9,9,9)

Output: (8,9,9,9,0,0,0,1)

Constraints:

The variety of nodes in every linked checklist is within the vary (1, 100).

0 <= Node.val <= 9

It's assured that the checklist represents a quantity that doesn't have main zeros.

Output code in python as beneath:

class Answer(object):

def addTwoNumbers(self, l1, l2):

#:kind l1: Non-obligatory(ListNode)

#:kind l2: Non-obligatory(ListNode)

#:rtype: Non-obligatory(ListNode)

"""

}

)

)

print(completion.decisions(0).message.content material)Ausgabe:

Praktische Anwendungen von O3-Mini

Probieren wir nun die O3-Mini aus und testen wir ihre logischen Denken, mathematisches Denken und Codierungsfähigkeiten.

Aufgabe 1: Logisches Denken

Immediate: „Sie haben acht Bälle, von denen einer etwas schwerer ist als die anderen. Sie haben eine Balanceskala, können sie aber nur zweimal verwenden. Wie bestimmen Sie, welcher Ball der schwerste ist? “

Ausgabe:

„Um den schwersten Ball unter den acht zu finden, verwenden nur eine Balanceskala zweimalFolgen Sie dem optimale Wäschestrategie:

Schritt 1: Zuerst Wiegen

- Teilen Sie die 8 Bälle in 3 Gruppen:

- Gruppe a: 3 Bälle

- Gruppe b: 3 Bälle

- Gruppe c: 2 Bälle (beiseite gelegt)

- Ort Gruppe A auf der linken Pfanne Und Gruppe B auf der rechten Pfanne des Gleichgewichts.

Schritt 2: Analysieren Sie das erste Gewichtsergebnis

- Wenn eine Seite schwerer ist:

- Die schwerere Seite enthält die schwerster Ball.

- Jetzt hast du 3 Bälle zum Testen Im nächsten Schritt.

- Wenn die Skala ausgeglichen ist:

- Der schwerste Ball gehört zu den 2 Bälle in Gruppe C.

- Wechseln Sie zu Schritt 3.

Schritt 3: Zweites Wiegen

- Wenn der schwerste Ball in einem Satz von ist 3 Bälle (ab Schritt 2):

- Wählen Zwei Bälle aus diesem Set und legen Sie eine auf jede Pfanne.

- Wenn eine Seite schwerer ist → Das ist der schwerste Ball.

- Wenn die Skala ausgeglichen ist → die Der dritte Ball (nicht gewogen) ist der schwerste.

- Wenn der schwerste Ball in ist Gruppe C (2 Bälle):

- Wiegen Sie die beiden Bälle gegeneinander.

- Je schwerer die Antwort ist.

Abschluss

Diese Methode garantiert, dass Sie den schwersten Ball genau identifizieren zwei Wiegen. ““

Aufgabe 2: mathematisches Denken

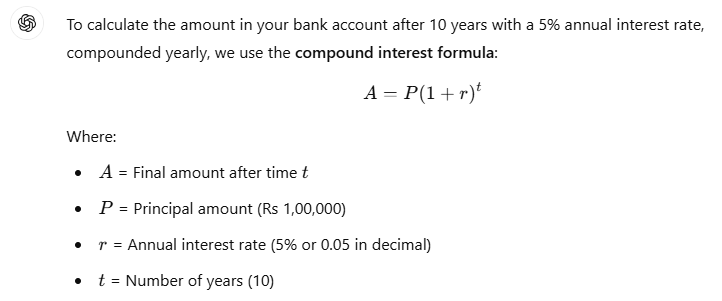

Immediate: „Wenn ich Rs 1 Lakh in ein Bankkonto investiere, das einen jährlichen Zinssatz von 5% anbietet, wird jährlich zusammengesetzt. Wie viel habe ich nach 10 Jahren auf dem Konto? Berechnen Sie eine schrittweise Berechnung. “

Ausgabe:

Aufgabe 3: Codierung

Immediate: „Sie erhalten einen Datensatz mit 1 Million Zeilen und müssen ihn effizient reinigen und vorbereiten. Schreiben Sie ein Python-Skript mit Dask oder Multiprocessing, um fehlende Werte zu verarbeiten, numerische Merkmale zu normalisieren und eine HOT-Codierung auf kategoriale Spalten anzuwenden. Erklären Sie, warum Ihr Ansatz effizienter ist als Pandas allein zu verwenden. “

import dask.dataframe as dd

from dask_ml.preprocessing import StandardScaler

import pandas as pd

import dask.multiprocessing

def preprocess_data(file_path):

"""

Effectively preprocesses a big dataset utilizing Dask.

Steps:

- Load information in parallel

- Deal with lacking values

- Normalize numerical options

- One-hot encode categorical columns

"""

# Load dataset utilizing Dask

df = dd.read_csv(file_path)

# Fill lacking values

df = df.fillna(df.imply())

# Determine numerical and categorical columns

numerical_cols = df.select_dtypes(embody=('float64', 'int64')).columns

categorical_cols = df.select_dtypes(embody=('object')).columns

# Normalize numerical options

scaler = StandardScaler()

df(numerical_cols) = scaler.fit_transform(df(numerical_cols))

# One-hot encode categorical columns

df = dd.get_dummies(df, columns=categorical_cols)

# Compute the ultimate lead to parallel

df = df.compute(scheduler="multiprocessing")

return df

# Instance utilization

# processed_df = preprocess_data("large_dataset.csv")

# processed_df.to_csv("cleaned_data.csv", index=False)

"""

Why this strategy is environment friendly:

1. **Dask for Parallel Processing:** In contrast to pandas, which hundreds information into reminiscence, Dask processes giant datasets in parallel utilizing process scheduling, making it reminiscence environment friendly.

2. **Lazy Analysis:** Dask hundreds solely the required chunks of knowledge, stopping reminiscence overload.

3. **Multiprocessing Scheduler:** Makes use of a number of cores to hurry up computation, outperforming pandas in large-scale information operations.

"""Lesen Sie auch: Deepseek R1 gegen OpenAI O1 gegen Sonnet 3.5: Schlacht der besten LLMs

Abschluss

OpenAIs O3-Mini, die alle Benchmarks brechen, stellt sicherlich einen signifikanten Fortschritt bei der Entwicklung von AI-Modell dar. Es scheint ein gutes Gleichgewicht zwischen Leistung und Effizienz zu bieten. Die verbesserten Argumentations- und Codierungsfunktionen in Verbindung mit schnelleren Reaktionszeiten machen es zu einem der besten und effizientesten Modelle, die wir derzeit haben. Die breite Zugänglichkeit von O3-Mini für alle Benutzer und auch über die API stellt sicher, dass eine breite Palette von Benutzern seine Funktionen nutzen kann.

Probieren Sie es aus und lassen Sie es uns in den Kommentaren wissen, wie intestine Sie denken!

Häufig gestellte Fragen

AA OpenAI O3-Mini ist eine optimierte Model des neuesten Argumentationsmodells von Openai, O3. Es ist für eine schnellere und effizientere Leistung ausgelegt, insbesondere für logische Argumentations- und Codierungsaufgaben. Im Vergleich zu O1-Mini bietet O3-Mini eine verbesserte Genauigkeit, bessere Fähigkeiten zur Problemlösung und höhere Benchmark-Werte.

A. Ja, Freistufe Benutzer von ChatGPT können im Rahmen des „Vernunft“ -Modus auf O3-Mini zugreifen, jedoch mit Einschränkungen. Für eine erweiterte Nutzung erhalten Chatgpt Plus, Group und Professional -Benutzer Zugriff auf bis zu 150 Nachrichten professional Tag.

A. o3-mini (hoch) erreicht die Genauigkeit von 87,3% auf der Aime-Benchmark und sorgt für das beste Leistungsmodell von Openai im mathematischen Denken. Es übertrifft auch Deepseek-R1 in logischen Argumentationstests und zeigt signifikante Verbesserungen gegenüber früheren Modellen.

A. Das Modell hat High-Ergebnisse bei der Codierung von Benchmarks wie Codeforces ELO und SWE-Bench. Die Hochversion von O3-Mini ist das bisher beste Codierungsmodell von Openai und übertrifft O1- und O1-Mini in realen Programmierherausforderungen.

A. OpenAIs O3-Mini übertrifft Deepseek-R1 in mehreren Bereichen, insbesondere in Argumentation, Codierung und mathematischer Problemlösung. Während beide Modelle für die Effizienz optimiert sind, erzielt O3-Mini bei allen wichtigen Benchmarks höhere Punktzahlen.

A. Entwickler können über OpenAIs API und Microsoft Azure OpenAI-Dienst auf O3-Mini zugreifen. Um es zu verwenden, müssen Sie eine API-Style generieren, das OpenAI Python SDK installieren und API-Aufrufe mithilfe der Modellkennung von „O3-Mini“ tätigen.

A. OpenAI wird voraussichtlich O3 veröffentlicht, eine leistungsstärkere Model mit weiteren Verbesserungen in Bezug auf Argumentation, Codierung und Anwendungsbearbeitung in der realen Welt. Basierend auf den aktuellen Benchmarks deutet die starke Leistungsleistung von O3-Mini auf ein noch fähigeres bevorstehenderes Modell hin.