Was macht ein Sprachmodell clever? Geht es darum, das nächste Wort in einem Satz vorherzusagen – oder um die Bewältigung schwieriger Denkaufgaben, die selbst kluge Menschen herausfordern? Heutige Massive Language Fashions (LLMs) erstellen flüssigen Textual content und lösen einfache Probleme, haben jedoch Schwierigkeiten mit Herausforderungen, die sorgfältige Überlegungen erfordern, wie z. B. schwierige Mathematik oder abstrakte Problemlösungen.

Dieses Drawback ergibt sich aus der Artwork und Weise, wie LLMs mit Informationen umgehen. Die meisten Modelle verwenden System-1-ähnliches Denken – schnelle, musterbasierte Reaktionen ähnlich der Instinct. Während es bei vielen Aufgaben funktioniert, schlägt es fehl, wenn Probleme eine logische Begründung sowie das Ausprobieren verschiedener Ansätze und die Überprüfung der Ergebnisse erfordern. Betreten Sie das System-2-Denken – eine menschliche Methode zur Bewältigung schwieriger Herausforderungen: vorsichtig, Schritt für Schritt – oft ist ein Rückschritt erforderlich, um die Schlussfolgerungen zu verbessern.

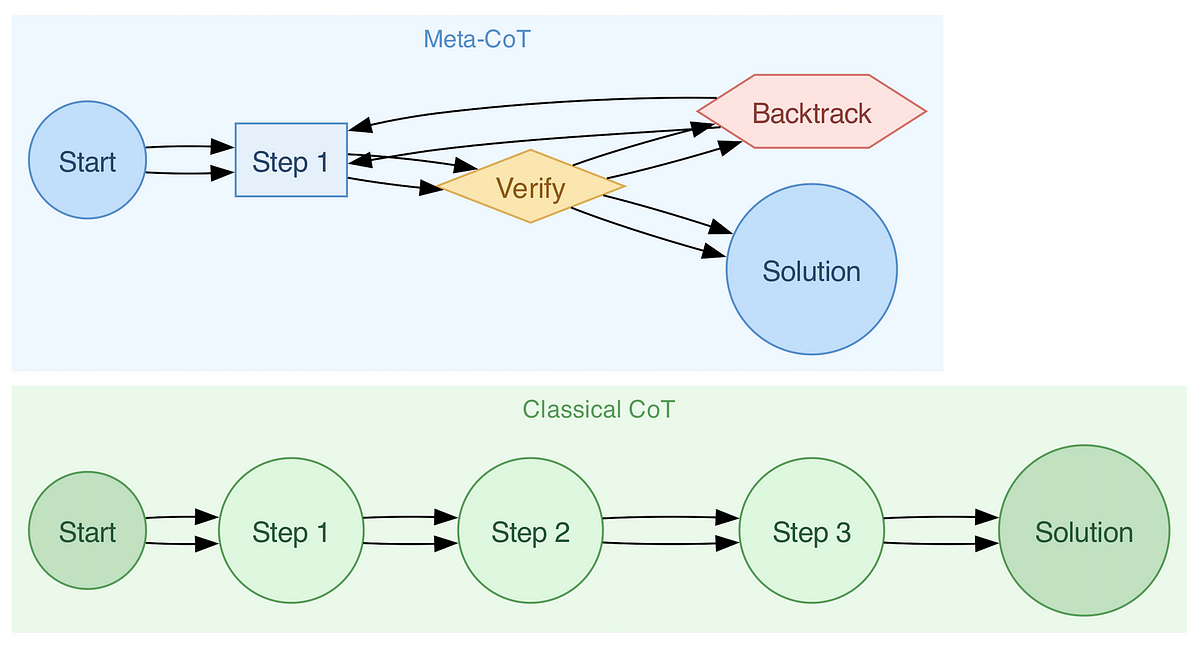

Um diese Lücke zu schließen, führten Forscher Meta Chain-of-Thought (Meta-CoT) ein. Aufbauend auf der beliebten Chain-of-Thought-Methode (CoT) ermöglicht Meta-CoT LLMs, nicht nur die einzelnen Schritte des Denkens, sondern den gesamten Prozess des „Durchdenkens eines Issues“ zu modellieren. Diese Veränderung ähnelt der Artwork und Weise, wie Menschen schwierige Fragen angehen, indem sie sie erforschen, bewerten – und iterativ auf Antworten hinarbeiten.